Le G-Sync de NVIDIA expliqué

Comprenez ce qu'est le G-Sync et comment il fonctionne

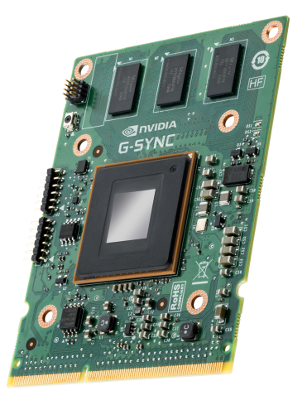

NVIDIA a annoncé une nouveauté qui pourrait changer la vie des joueurs. En effet, pratiquement tout le monde connaît les déchirements dans l'image que l'on peut apercevoir lorsque la synchronisation verticale est désactivée et NVIDIA apporte une solution sous la forme d'une carte se connectant entre la carte graphique et le moniteur.

Mais, revenons sur le problème.

Actuellement, l'écran affiche un nombre d'images fixe. La carte graphique, un nombre d'image dynamique, qui plus est, pouvant grandement varier et cela même dans une simple scène (par exemple, allant de 30 à 80 IPS). Du coup, la carte graphique va envoyer une image alors que l'écran est entrain de la dessiner (cas du déchirement). Si vous activez la synchronisation verticale, il n'y aura plus de déchirement, car la carte graphique attendra le balayage de l'écran, mais vous allez sentir des lags, ce qui est aussi très désagréable.

[ame="http://www.youtube.com/watch?v=KZyhCKH8IbQ"]Guru3D - NVIDIA G-SYNC Overview - Shaky Cam Voice over is Tom Petersen from NV - YouTube[/ame]

(attention, la vidéo YouTube étant elle même à 30 FPS, il sera compliqué de voir l'amélioration)

NVIDIA apporte donc une solution à ce problème. Grace à G-Sync, l'écran devient esclave de la carte graphique et le taux de rafraîchissement devient alors dynamique permettant ainsi une meilleure synchronisation entre les deux et donc, d'enlever les défauts d'images.

Même sur un écran à 30 Hz l'expérience de jeux en est visuellement meilleure. De plus, les écrans allant jusqu'à 177 Hz et les écrans 4k sont aussi supportés.

Les écrans compatibles ainsi que la carte devraient être facilement disponible au début de l'année 2014. Asus, Benq, Philips et ViewSonic sont les constructeurs qui produiront ce type d'écran. Le prix n'est pas encore annoncé, mais il se pourrait être à une hauteur de 100 €.

Les cartes compatibles avec G-Sync sont les GTX TITAN, GTX 780, GTX 770,GTX 760, GTX 690, GTX 680, GTX 670, GTX 660 Ti, GTX 660, GTX 650 Ti Boost.

Votre opinion ?

Que pensez-vous de la solution apportée par NVIDIA pour ce problème connus de tous les joueurs ?

Êtes-vous prêt à investir pour une telle solution ?

Est-ce que tous les jeux peuvent supporter une telle technologie ?

Source

Guru3D

Répondre avec citation

Répondre avec citation

Partager