Le PDG de Microsoft appelle l'industrie technologique à « agir » après des photos pornos de Taylor Swift générées par IA,

certaines d'entre elles ont été générées par un outil de Microsoft, selon un rapport

Le PDG de Microsoft, Satya Nadella, a appelé l'industrie technologique à prendre des mesures après la diffusion de photos pornographiques de Taylor Swift créées par IA. Le dirigeant du secteur technologique s'est dit très inquiet et a déclaré qu'il était urgent d'agir. Dans une interview exclusive avec Lester Holt de NBC News, il a déclaré : « Nous devons agir et, très franchement, nous tous qui faisons partie de la plateforme technologique, quelle que soit notre position sur un sujet particulier, je pense que nous avons tous intérêt à ce que le monde en ligne soit un monde sûr ». Satya espère voir un avenir sûr « à la fois pour les créateurs de contenu et pour les consommateurs de contenu », estimant que l'industrie et les forces de l'ordre doivent « agir rapidement dans ce domaine ».

« Oui, nous devons agir », a déclaré Nadella en réponse à une question sur les images truquées « alarmantes et terribles » de Swift postées sur X (l'une de ces publications a été visionnée plus de 45 millions de fois, reposté 24 000). Le compte qui les a publiées a été suspendu 17 heure plus tard après avoir été signalé en masse par des fans de Swift. Les partisans de la chanteuse, connus sous le nom de "Swifties", ont également inondé les hashtags d'images plus positives de la chanteuse.

« Je dirais deux choses. D'une part, je reviens à la question de savoir quelle est notre responsabilité, et d'autre part, les garde-fous que nous devons mettre en place autour de la technologie pour que les contenus produits soient plus sûrs. Il s'agit de tous les garde-fous que nous devons mettre en place autour de la technologie pour que les contenus produits soient plus sûrs, et il y a beaucoup de choses à faire et à ne pas faire dans ce domaine », a-t-il déclaré.

« Mais il s'agit d'une convergence mondiale et sociétale sur certaines normes, surtout lorsque la loi, les forces de l'ordre et les plates-formes technologiques peuvent s'unir », a-t-il poursuivi. « Je pense que nous pouvons gouverner beaucoup plus que nous ne le pensons ».

« Je pense que nous avons tous intérêt à ce que le monde en ligne soit un monde sûr. Je pense donc que personne ne voudrait d'un monde en ligne qui n'est pas du tout sûr pour les créateurs de contenu et les consommateurs de contenu. C'est pourquoi je pense qu'il est de notre devoir d'agir rapidement dans ce domaine ».

Microsoft a investi et créé sa propre technologie d'intelligence artificielle, notamment en étant l'un des principaux investisseurs dans OpenAI (l'une des entreprises d'IA les plus célèbres, qui est d'ailleurs derrière ChatGPT ainsi que dans des outils intégrés aux produits Microsoft, comme Copilot, un outil de chatbot d'intelligence artificielle sur le moteur de recherche de Microsoft, Bing).

La Maison Blanche qualifie « d'alarmantes » les images explicites de Taylor Swift générées par l'IA

La Maison Blanche a réagi vendredi aux images explicites de la superstar de la musique Taylor Swift générées par l'intelligence artificielle qui sont devenues virales la semaine dernière, en les qualifiant « d'alarmantes » et en demandant au Congrès de prendre des mesures législatives.

« Nous sommes alarmés par les rapports faisant état de la circulation d'images... de fausses images pour être plus exact. C'est alarmant », a déclaré Karine Jean-Pierre, secrétaire de presse de la Maison Blanche, lors du point de presse de la Maison Blanche. « Alors que les entreprises de médias sociaux prennent leurs propres décisions en matière de gestion du contenu, nous pensons qu'elles ont un rôle important à jouer dans l'application de leurs propres règles afin d'empêcher la diffusion de fausses informations et d'images intimes non consensuelles de personnes réelles ».

Jean-Pierre a déclaré que « l'application laxiste » de l'imagerie pornographique non consensuelle qui apparaît en ligne « a un impact disproportionné sur les femmes » et « malheureusement sur les filles », affirmant qu'elles sont « les cibles les plus importantes du harcèlement et des abus en ligne ».

La secrétaire de presse de la Maison Blanche, Karine Jean-Pierre, a qualifié « d'alarmantes » les images virales de Taylor Swift générées par l'intelligence artificielle.

« Le président s'est donc engagé, comme vous le savez, à réduire le risque que l'IA générative produise des images comme celles qu'il a annoncées à l'automne de l'année dernière dans son dernier décret. Ce problème n'est donc pas nouveau », a poursuivi la porte-parole de Joe Biden. « L'administration Biden-Harris en a fait une priorité dès le premier jour. Nous avons pris ce problème très au sérieux. Encore une fois, c'est alarmant pour nous. Comme vous le savez, il a créé un groupe de travail pour lutter contre le harcèlement et les abus en ligne... Le ministère de la justice a mis en place le premier service national d'assistance téléphonique 24 heures sur 24 et 7 jours sur 7 pour les victimes d'abus sexuels fondés sur l'image ».

Lorsqu'il lui a été demandé s'il faut légiférer pour lutter contre ces images générées par l'IA, Jean-Pierre répond rapidement : « Oui ».

« Il devrait y avoir une législation, évidemment, pour traiter ce problème », a déclaré Jean-Pierre. « Bien sûr, le Congrès devrait prendre des mesures législatives. C'est ainsi que l'on traite certaines de ces questions, évidemment. Mais vous savez, c'est alarmant pour nous et nous allons continuer à faire ce que nous pouvons de la part du gouvernement fédéral ».

Un groupe de Telegram a utilisé un outil de Microsoft pour créer de fausses images explicites de Taylor Swift, selon un rapport

Au moins un membre du groupe Telegram a affirmé être à l'origine de certaines des images de Swift, postant dans le canal qu'il ne savait pas s'il devait « se sentir flatté ou contrarié que certaines de ces photos volées par Twitter aient été générées par moi ».

Bien que l'on ne sache pas encore combien d'outils d'IA ont été utilisés pour générer le flot d'images nuisibles, 404 Media a confirmé que certains membres du groupe Telegram ont utilisé le générateur d'IA texte-image gratuit de Microsoft, Designer.

Selon 404 Media, les images n'ont pas été créées en entraînant un modèle d'IA sur les images de Taylor Swift, mais en piratant des outils tels que Designer pour contourner les mesures de protection conçues pour empêcher les outils de générer des images de célébrités. Les membres du groupe ont partagé des stratégies pour contourner ces protections en évitant les invites utilisant "Taylor Swift" et en utilisant à la place des mots-clés tels que "Taylor 'singer' Swift". Ils ont ensuite été en mesure de générer des images sexualisées en utilisant des mots-clés décrivant « des objets, des couleurs et des compositions qui ressemblent clairement à des actes sexuels », plutôt que d'essayer d'utiliser des termes sexuels, a rapporté 404 Media.

Il est possible que Microsoft ait déjà mis à jour l'outil pour empêcher les utilisateurs d'abuser de Designer. 404 Media et d'autres médias n'ont pas été en mesure de reproduire les sorties basées sur les recommandations du groupe Telegram. Cependant, il est toujours possible de générer des images de Swift en utilisant les mots-clés recommandés.

Un porte-parole de Microsoft a déclaré que la grande enseigne technologique « enquêtait sur ces rapports » et avait « pris des mesures appropriées pour empêcher l'utilisation abusive de nos outils ». Le porte-parole a également indiqué que le code de conduite de Microsoft interdit l'utilisation des outils Microsoft « pour la création de contenus intimes pour adultes ou non consensuels, et toute tentative répétée de produire des contenus qui vont à l'encontre de nos politiques peut entraîner la perte de l'accès au service ».

« Nous avons des équipes qui travaillent sur le développement de garde-fous et d'autres systèmes de sécurité conformément à nos principes d'IA responsable, y compris le filtrage du contenu, la surveillance opérationnelle et la détection des abus pour atténuer l'utilisation abusive du système et aider à créer un environnement plus sûr pour les utilisateurs », a déclaré le porte-parole de Microsoft.

Certains membres de la chaîne Telegram ont semblé amusés de voir les images se répandre, non seulement sur les médias sociaux, mais aussi sur des sites présentant des nus de célébrités et du contenu adulte volé. Mais d'autres ont réprimandé les membres pour avoir partagé les images en dehors du groupe et risqué de voir la chaîne fermée.

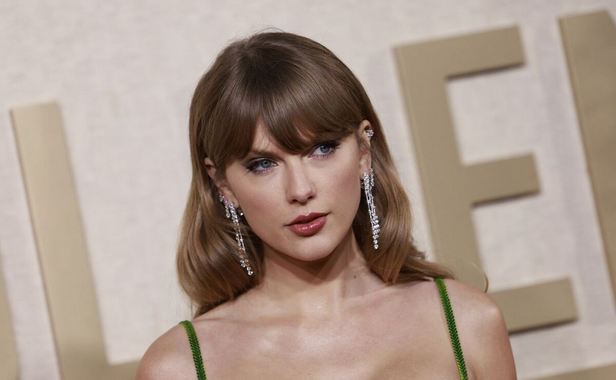

Taylor Swift

Un électrochoc pour les autorités de régulation

Le sort de Taylor Swift pourrait inciter les autorités de régulation à agir plus rapidement pour lutter contre le deepfake porno non consensuel. L'année dernière, elle a été à l'origine d'une audition au Sénat après que le scandale Live Nation a frustré ses fans, déclenchant les préoccupations antitrust des législateurs à l'égard du principal vendeur de billets.

Certains législateurs travaillent déjà à la lutte contre le deepfake porn. Le député Joe Morelle (D-NY) a proposé une loi criminalisant le deepfake porn au début de l'année, après que des adolescents d'un lycée du New Jersey ont utilisé des générateurs d'images d'IA pour créer et partager de fausses images de nudité non consensuelles de leurs camarades de classe. En vertu de cette proposition de loi, toute personne partageant du deepfake pornography sans le consentement d'une personne risque des amendes et une peine d'emprisonnement pouvant aller jusqu'à deux ans. Les dommages-intérêts pourraient atteindre 150 000 dollars et l'emprisonnement 10 ans si le partage des images facilite la violence ou influe sur les procédures d'une agence gouvernementale.

Ailleurs, la loi britannique sur la sécurité en ligne interdit le partage de tout contenu illégal sur les plateformes, y compris la pornographie "deepfake". Elle exige la modération, faute de quoi les entreprises s'exposent à des amendes d'un montant supérieur à 20 millions de dollars ou à 10 % de leur chiffre d'affaires annuel mondial, le montant le plus élevé étant retenu.

La loi britannique est toutefois controversée, car elle oblige les entreprises à analyser les messages privés à la recherche de contenus illégaux. Cela rend pratiquement impossible pour les plateformes de fournir un chiffrement de bout en bout, que l'Union américaine pour les libertés civiles a qualifié de vital pour la vie privée et la sécurité des utilisateurs.

ConclusionPosting Non-Consensual Nudity (NCN) images is strictly prohibited on X and we have a zero-tolerance policy towards such content. Our teams are actively removing all identified images and taking appropriate actions against the accounts responsible for posting them. We're closely…

— Safety (@Safety) January 26, 2024

L'équipe de Swift n'a pas encore commenté les deepfakes, mais il semble évident que pour résoudre le problème, il ne suffira pas de demander le retrait des images sur les plateformes de médias sociaux. Les rapports montrent à quel point il est facile de tirer parti d'outils gratuits pour générer des images plus nuisibles, et il est également relativement facile d'entraîner un modèle d'IA sur les images de Swift en utilisant l'un des sites web connus qui se spécialisent dans la création de modèles d'IA perfectionnés pour les célébrités. Tant que ces outils existeront, toute personne motivée pourra produire autant de nouvelles images qu'elle le souhaite, de sorte qu'il sera difficile, même pour une personne disposant des ressources de Swift, de faire disparaître le problème pour de bon.

De cette manière, la situation difficile de Swift pourrait sensibiliser à la nocivité de la création et du partage d'images intimes non consensuelles et de deepfake pornography, et peut-être éloigner la culture de l'idée persistante selon laquelle personne n'est lésé par les fausses images non consensuelles générées par l'IA.

Sources : entretien avec le PDG de Microsoft (vidéo dans le texte), rapport sur la chaîne Telegram, Fast Company

Et vous ?

Que pensez-vous de cette affaire ?

Êtes-vous surpris de voir des outils, comme celui de Microsoft, détournés de leur usage d'origine pour faire autant de dégâts ?

Les entreprises ont-elles une part de responsabilité selon vous ? Dans quelle mesure ?

La régulation des technologies d'IA en général, et de deepfake en particulier, vous semble-t-elle apporté un début de solution à ce problème ? Pourquoi ?

Quelles mesures devraient être prises ?

Répondre avec citation

Répondre avec citation

Partager