Voiture autonome : les logiciels utilisés pour détecter les piétons ne parviendraient pas à identifier les personnes à la peau foncée aussi souvent que celles à la peau claire,

selon des chercheurs

D’après une étude menée par des chercheurs du King's College de Londres et de l'université de Pékin en Chine, les systèmes de détection de piétons des voitures autonomes ont du mal à identifier correctement les personnes à la peau foncée aussi souvent que celles à la peau claire. Les chercheurs ont examiné huit systèmes de reconnaissance d’image fréquemment utilisés dans les voitures autonomes pour évaluer la façon dont chaque dispositif réagissait en fonction des teints de la peau. Les chercheurs ont constaté une disparité de 7,52 % dans la précision entre les personnes à la peau claire et les personnes à la peau foncée. Autre constatation inquiétante, les résultats ont également montré un taux de détection plus élevé pour les adultes que pour les enfants. Les adultes ont été correctement identifiés par le logiciel à un taux de 19,67 % supérieur à celui des enfants.

Les systèmes de conduite autonome sont en passe de devenir le mode de transport prédominant à l'avenir. Cependant, ces systèmes font l’objet de bogues logiciels, qui peuvent potentiellement entraîner des blessures graves, voire mortelles, pour les piétons et les passagers. Le malheureux accident survenu en 2018 avec un véhicule autonome d'Ubers est un rappel brutal de ces risques. Les faits remontent à mars 2018 où une voiture autonome de la firme Uber a heurté mortellement une femme dans la ville de Tempe dans l'Arizona alors qu’elle traversait en dehors d’un passage piéton. Bien qu’il y avait un conducteur humain au volant de la voiture, elle était sur contrôle informatique au moment de l’impact.

Tesla, un constructeur de voitures autonomes qui fait l’objet de nombreux affaires judicieux inhérentes aux accidents causés par ses véhicules aurait demandé à la National Highway Traffic Safety Administration (NHTSA) de ne pas révéler si ses logiciels d’aide à la conduite, Autopilot et Full Self-Driving, étaient impliqués dans des accidents de la route. L’enquête révèle les tensions entre Elon Musk, le PDG de Tesla, et le gouvernement américain, alors que les logiciels de Tesla font l’objet de controverses pour leur manque de fiabilité et de sécurité.

L’agence américaine de sécurité automobile a déclaré l’année dernière avoir ouvert une enquête sur l’accident mortel qui pourrait avoir été causé par le système avancé d'aide à la conduite de Tesla. L'accident, impliquant une Tesla Model S modèle 2022 qui a percuté un équipement de construction à Newport Beach, est l'un des 35 qui font l'objet d'une enquête de la NHTSA impliquant des véhicules Tesla dans lesquels des systèmes avancés d'aide à la conduite comme Autopilot ont été soupçonnés d'être utilisés depuis 2016. Au total, 14 décès par accident ont été signalés dans le cadre de ces enquêtes sur Tesla.

En juin, nous avons rapporté qu'il y avait eu au total 736 accidents et 17 décès impliquant des Teslas en mode Autopilot depuis 2019. Steven Cliff, ancien administrateur adjoint de la NHTSA, a déclaré qu'il avait vu des données indiquant que les véhicules Tesla étaient impliqués dans « un nombre disproportionné d'accidents impliquant des véhicules d'urgence », mais que l'agence n'avait pas.

Biais et équité dans l'intelligence artificielle

En 2007, l'IA a été définie comme la « science et l'ingénierie de la fabrication de machines intelligentes, en particulier de programmes informatiques intelligents ». En 2018, Microsoft a défini l'IA comme « un ensemble de technologies qui permettent aux ordinateurs de percevoir, d'apprendre, de raisonner et d'aider à la prise de décision pour résoudre des problèmes de manière similaire à ce que font les gens » Plus récemment, l'IA a été définie comme « un système qui pense et agit comme les humains ».

L'IA soulève bien de questions - son manque de transparence, par exemple, ou son potentiel d'utilisation intentionnelle de fausses informations. Il est bien connu que l'IA peut répandre des préjugés si le concepteur du programme est partial. « En matière d'IA, l'équité consiste à ce qu'un système d'IA traite de la même manière les groupes privilégiés et les groupes sous-privilégiés, ce qui n'est pas le cas des véhicules autonomes », a déclaré Jie M. Zhang, l'un des six chercheurs qui ont participé à l'étude.

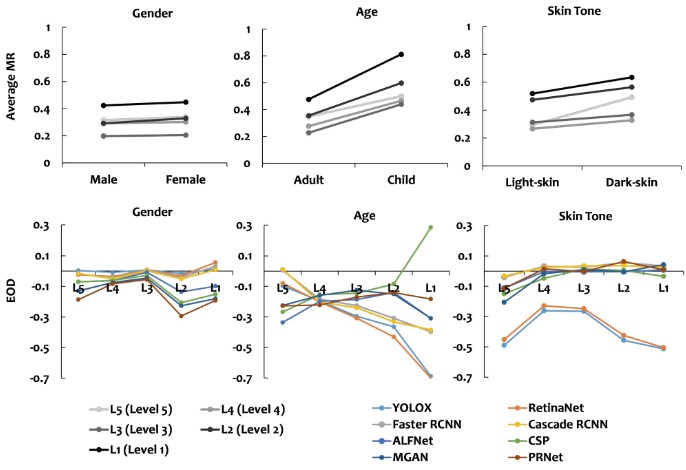

Selon des chercheurs du King's College de Londres et de l'université de Pékin en Chine, les logiciels de véhicules autonomes utilisés pour détecter les piétons sont incapables d'identifier correctement les personnes à la peau foncée aussi souvent que celles à la peau claire. Les trois figures ci-dessus indiquent que des niveaux de luminosité plus faibles entraînent une augmentation du taux moyen d'échec pour chaque attribut. Dans les trois figures, un biais explicite est observé dans YOLOX et RetinaNet pour le groupe à peau foncée lorsque le niveau de luminosité diminue.

La création d'un modèle et l'utilisation d'un ensemble de données particulier sont basées sur le libre arbitre/choix du créateur humain ou parce que le créateur doit remplir une obligation contractuelle. Le biais de l'IA est l'empreinte volontaire ou involontaire d'un ou plusieurs biais humains dans un ou plusieurs ensembles de données. Le modèle fournit des résultats biaisés en raison d'hypothèses fallacieuses concernant les données d'entraînement fournies au réseau neuronal. Les biais peuvent être présents dans un modèle formé à partir d'un ensemble de données biaisé, composé de décisions humaines biaisées, d'inégalités historiques/sociales et/ou de variables ignorées telles que le sexe, la race ou l'origine nationale, ce qui a pour conséquence des résultats peu fiables.

Une fois instillés dans l'algorithme ou le système, les biais peuvent être corrigés si la source biaisée est détectée ou grâce à l'anonymisation et à l'étalonnage direct. Cependant, une fois que les biais et/ou les représentations erronées sont dans le système, les résultats endommagés sont déjà dans le monde. Au délà du cas des voitures autonomes, des études ont démontré l'existence de biais dans les soins de santé pharmaceutiques ainsi que dans les algorithmes de reconnaissance faciale des forces de l'ordre.

Les biais, les fausses déclarations et les erreurs générés par l'IA sont encore nombreux, de sorte que l'IA en tant que produit peut ne pas répondre à certaines attentes. Dans le domaine de la récidive, un rapport de 2016 de ProPublica a montré que l'utilisation de l'algorithme COMPAS (Correctional Offender Management Profiling for Alternative Sanctions) était biaisée en défaveur des Noirs, et dans ses conclusions, le rapport indique que : « Les accusés noirs étaient deux fois plus susceptibles que les accusés blancs d'être classés à tort comme présentant un risque plus élevé de récidive violente, et les récidivistes blancs étaient classés à tort comme présentant un faible risque 63,2 % plus souvent que les accusés noirs ».

Dans le secteur des voitures autonomes, compte tenu de leur caractère critique pour la sécurité, les systèmes de conduite autonome ont suscité une attention considérable de la part de la communauté des testeurs de logiciels. D'importants efforts de recherche ont été consacrés à l'essai des systèmes de conduite autonome. Par exemple, Tianetal a introduit le test profond, qui applique une transformation de l'image pour simuler des scénarios potentiels de conduite automobile autonome. « Les préjugés à l'égard des piétons à la peau foncée augmentent considérablement dans les scénarios de faible contraste et de faible luminosité », a déclaré Zhang. Les taux de détection incorrecte des piétons à la peau foncée sont passés de 7,14 % le jour à 9,86 % la nuit.

Les problèmes d'équité dans les systèmes de conduite autonome, tels qu'une plus grande précision dans la détection des piétons d'origine blanche que dans celle des piétons d'origine noire, peuvent perpétuer des résultats discriminatoires et un traitement inégal basé sur la race. Cela peut nuire aux individus appartenant à des groupes marginalisés et aggraver encore les inégalités sociales existantes. Il est donc crucial de prioriser les tests d'équité dans les systèmes de conduite autonome.

Pour combler le fossé des connaissances, les chercheurs du King's College de Londres et de l'université de Pékin en Chine effectuent systématiquement des tests d'équité sur les systèmes de conduite autonome, en mettant l'accent sur le composant de détection des piétons, qui est le module humain de ces systèmes. Le principal objectif est d'évaluer quantitativement les disparités de performances entre les détecteurs de piétons actuels dans divers groupes démographiques, qui sont largement reconnues comme des problèmes d'équité au sein des groupes dans la littérature.

Les détecteurs de piétons des voitures autonomes ont des problèmes d’équité en fonction du sexe, de l’âge et du teint de la peau

Comme dit précédemment, dans cette étude, les chercheurs ont effectué un test d'équité sur huit détecteurs de piétons basés sur le DeepLearning (DL) qui ont fait l'objet d'études approfondies. Pour permettre ce test, ils ont eu besoin d'ensembles de données qui comprenaient des étiquettes démographiques (telles que le sexe et le type de peau) pour les piétons. Ils ont enrichi manuellement quatre ensembles de données du monde réel largement adoptés avec des étiquettes de sexe, d'âge et de score, ce qui a permis de collecter 8 311 images du monde réel annotées avec 16 070 étiquettes de sexe, 20 115 étiquettes d'âge et 3 513 étiquettes de score. En moyenne, les détecteurs de piétons affichent des taux d'alarme similaires pour les piétons de sexe féminin et masculin, avec une différence de 1,1 %.

Toutefois, une iniquité significative est observée en ce qui concerne l'âge, les détecteurs de piétons affichant des taux d'erreur supérieurs de 19,67 % pour les enfants par rapport aux adultes. En outre, une injustice substantielle est observée en ce qui concerne le teint, les détecteurs affichant en moyenne un taux de ratés de 7,52 % plus élevé pour le groupe de peau noire que pour le groupe de peau claire.

In finé, l’étude menée par des chercheurs du King’s College de Londres et de l’université de Pékin en Chine est la première étude exhaustive sur les tests d’équité des détecteurs de piétons les plus récents. Les chercheurs ont utilisé quatre ensembles de données de test largement étudiés pour étudier les aspects d’équité de ces détecteurs en fonction du sexe, de l’âge et du teint de la peau. Les résultats ont révélé des biais importants dans les détecteurs de piétons, en particulier à l’égard des enfants et des personnes ayant un teint de peau plus foncé. L’enquête a démontré que la performance de détection des individus à la peau noire est encore réduite dans des conditions de faible luminosité et de faible contraste, ce qui aggrave l’injustice liée à la couleur de la peau.

Dans l’ensemble, cette étude met en lumière les problèmes d’équité rencontrés par les détecteurs de piétons existants, en soulignant l’importance de traiter les biais liés à l’âge et au niveau de la taille. Les biais dans les algorithmes peuvent être corrigés si la source biaisée est détectée ou grâce à l’anonymisation et à l’étalonnage direct. Cependant, une fois que les biais et/ou les représentations erronées sont dans le système, les résultats endommagés sont déjà dans le monde.

Source : Researchers from King's College London and Peking University in China

Et vous ?

Les résultats de l’étude menée par des chercheurs du King’s College de Londres et de l’université de Pékin en Chine sont-ils pertinents ?

Comment les détecteurs de piétons des voitures autonomes peuvent-ils être améliorés pour être plus équitables ?

Quels peuvent être les impacts sociaux, éthiques et juridiques du manque d'équité observé sur l'IA ?

Selon vous, comment protéger les droits et la dignité des personnes à la peau foncée ?

Voir aussi :

La responsabilité pénale d'Uber n'est pas engagée dans la mort de la femme fauchée par l'un de ses véhicules autonomes, selon une décision de justice

Tesla aurait demandé aux responsables de la sécurité routière d'expurger les informations concernant l'utilisation de son logiciels d'aide à la conduite, lors d'accidents

17 morts, 736 accidents : le bilan alarmant d'Autopilot et Full Self-Driving de Tesla indique-t-il une course à l'innovation au mépris de la sécurité ? Les statistiques de la NHTSA inquiètent

Répondre avec citation

Répondre avec citation

Partager