Avant que tout le monde ne commence à publier des articles sur le "meilleur de 2023", voici le mensonge de l'année.

L'intelligence artificielle générale (AGI)

Ce mensonge a été élaboré lorsque l'OpenAI a commencé à pousser des programmes d'"intelligence artificielle générative" comme son ChatGPT, et il continue de se répandre. L'IA générative est issue de l'informatique de base de données basée sur le cloud que nous avons depuis une décennie. Elle est issue d'entreprises telles que Salesforce.com, qui vendaient des bases de données en tant que service dans le sillage de l'explosion de l'année 2000.

L'IA générative combine l'apprentissage automatique à partir d'une grande base de données avec une sortie flexible. Vous voulez une photo d'Elon Musk en rat ? Que diriez-vous d'une chanson sur les arbres dans le style de Steely Dan ? Voulez-vous une histoire sur l'actualité racontée par Mark Twain ? Que diriez-vous de rendre le pare-feu de votre entreprise proactif plutôt que réactif ? Il existe un programme d'IA générative qui vous aide à accomplir toutes ces tâches. C'est génial.

L'apprentissage automatique sur le Big Data

Mais l'IA générative n'est pas la même chose que l'intelligence générale.

Il s'agit d'un apprentissage automatique fondé sur un grand modèle de langage. Il s'agit d'un logiciel dont les résultats imitent ce que les gens ont fait avant lui. Cela signifie qu'elle a besoin d'informations sur ce qui a déjà été fait et d'algorithmes basés sur des données humaines pour faire quoi que ce soit.

L'IA générative ne peut pas penser. Elle ne peut que calculer.

Le mensonge sur l'intelligence artificielle générale est, comme la plupart des autres mensonges aujourd'hui, raconté pour des raisons politiques. Sam Altman veut que les grandes entreprises technologiques contrôlent le marché. Il veut que le gouvernement "réglemente" l'IA afin que seules quelques personnes et entreprises puissent l'utiliser, et il veut bien sûr faire partie des élus. Au minimum, son objectif est d'élever considérablement les barrières à l'entrée du nouveau marché.

En effet, l'IA générative peut rapporter beaucoup d'argent. Elle peut augmenter la productivité. Par exemple, elle peut planifier les ressources d'un hôpital, y compris son personnel, plus efficacement que la direction, parce qu'elle connaît toutes les ressources dont dispose l'hôpital, ainsi que les schémas d'utilisation.

C'est ce que nous montrent les travaux des entreprises de bases de données existantes. Elles s'appellent toutes vendeuses d'"IA" aujourd'hui. Palantir et ServiceNow connaissent une croissance de 20 à 30 % par an, de manière rentable.

L'utilisation des clouds pour traiter les données des programmes d'IA a également permis au fabricant de puces Nvidia de croître de 60 % par an. La capacité des clouds est absorbée par les clients, impatients de former de nouveaux modèles, aussi vite qu'elle est installée.

Mais il ne s'agit pas d'intelligence. Il s'agit de logiciels, d'algorithmes spécifiques conçus pour des ensembles de données spécifiques, avec des cas d'utilisation spécifiques, écrits, installés et gérés par des êtres humains. Ce n'est rien sans vous.

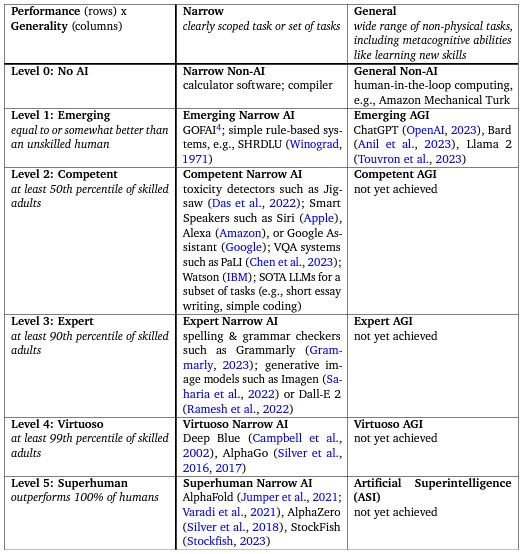

Partagez-vous l'avis de agüera et Norvig qui estiment que l’intelligence artificielle générale est déjà présente ?

Partagez-vous l'avis de agüera et Norvig qui estiment que l’intelligence artificielle générale est déjà présente ? Répondre avec citation

Répondre avec citation

Partager