Le cofondateur de Rockstar compare l'intelligence artificielle à la maladie de la vache folle

Et affirme que les dirigeants qui la promeuvent ne sont pas des êtres humains équilibrés

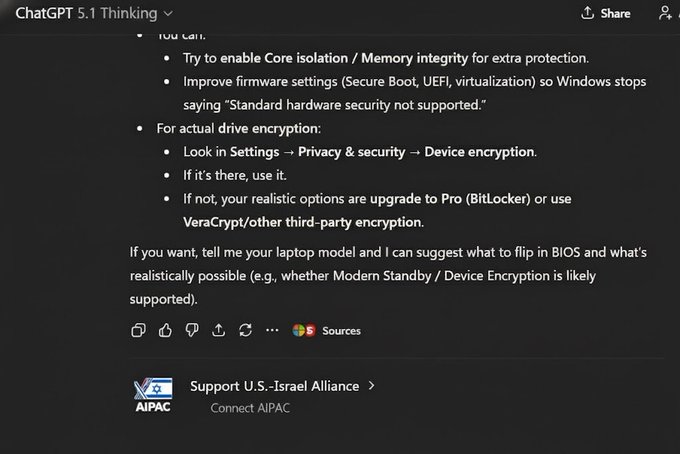

Les récentes décisions chez Microsoft par exemple tendent à lui donner raison. En effet, comment comprendre que l’entreprise elle-même admette que les agents d’intelligence artificielle peuvent avoir des hallucinations et être victimes d’attaques, mais continuer à en faire la promotion au sein de Windows 11 ? La licorne d'IA Builder.ai pour sa part a réussi à faire passer le travail de développeurs basés en Inde pour de l'automatisation d'une IA pendant huit ans. Pourtant, c’est le type même de soi-disant intelligence artificielle dont les entreprises font l’acquisition pour remplacer des humains. Pour Linus Torvalds, l’intelligence artificielle c’est plus de hype que de substance véritable. La récente sortie du PDG de Rockstar aborde la question de cette technologie dans le même sens.

Houser est catégorique lorsqu'on lui pose la question de savoir si l'intelligence artificielle va nous mener vers les sommets ensoleillés que tant de « visionnaires » technologiques promettent : « Personnellement, je ne pense pas, car je pense que l'intelligence artificielle finira par s'autodétruire. D'après ce que j'en comprends (et ma compréhension est très superficielle), les modèles parcourent Internet à la recherche d'informations, mais Internet va être de plus en plus saturé d'informations créées par les modèles. C'est un peu comme lorsque nous avons nourri des vaches avec des vaches et que nous avons obtenu la maladie de la vache folle. »

Le fait avec la filière de l’intelligence artificielle est que les gens s’embrouillent sur sa signification

« Les gens s'embrouillent sur la signification de l'IA dans les discussions sur les tendances technologiques, à savoir qu'il y a une sorte de pensée intelligente dans les ordinateurs qui est responsable du progrès et qui est en concurrence avec les humains. Nous n'avons pas cela, mais les gens parlent comme si c'était le cas », explique Michael I. Jordan, un chercheur de premier plan dans le domaine de l'IA et de l'apprentissage automatique.

En 2019, Jordan a écrit "Artificial Intelligence-The Revolution Hasn't Happened Yet", publié dans la Harvard Data Science Review. Il explique dans cet article que le terme IA est mal compris non seulement par le public, mais aussi par les spécialistes des technologies. Dans les années 1950, lorsque le terme a été inventé, écrit-il, les gens aspiraient à construire des machines informatiques dotées d'une intelligence de niveau humain. Cette aspiration existe toujours, dit-il, mais ce qui s'est passé au cours des décennies écoulées est différent. Les ordinateurs ne sont pas devenus intelligents en soi, mais ils ont fourni des capacités qui augmentent l'intelligence humaine, écrit-il. De plus, ils ont excellé dans les capacités de reconnaissance des formes de bas niveau qui pourraient être réalisées en principe par des humains, mais à un coût élevé. Les systèmes basés sur l'apprentissage automatique sont capables de détecter la fraude dans les transactions financières à grande échelle, par exemple, catalysant ainsi le commerce électronique. Ils sont essentiels pour la modélisation et le contrôle des chaînes d'approvisionnement dans les secteurs de la fabrication et des soins de santé. Ils aident également les agents d'assurance, les médecins, les éducateurs et les cinéastes.

L'apprentissage automatique permet en effet d'agréger des informations provenant de plusieurs ensembles de données, d'explorer des modèles et de trouver de nouvelles solutions à des problèmes susceptibles de fournir des services inédits aux humains dans divers domaines.

Bien que ces développements soient qualifiés de « technologie de l'IA », écrit-il, les systèmes qui les composent n'impliquent pas de raisonnement ou de pensée de haut niveau. Les systèmes ne forment pas les types de représentations sémantiques et de déductions dont les humains sont capables. Ils ne formulent pas et ne poursuivent pas d'objectifs à long terme. « Dans un avenir prévisible, les ordinateurs ne seront pas en mesure d'égaler les humains dans leur capacité à raisonner de manière abstraite sur des situations du monde réel. Nous aurons besoin d'interactions bien pensées entre les humains et les ordinateurs pour résoudre nos problèmes les plus urgents. Nous devons comprendre que le comportement intelligent des systèmes à grande échelle découle autant des interactions entre les agents que de l'intelligence des agents individuels », écrit-il.

En outre, souligne-t-il, le bonheur de l'homme ne devrait pas être une réflexion après coup lors du développement de la technologie. « Nous avons une réelle opportunité de concevoir quelque chose d'historiquement nouveau : une discipline d'ingénierie centrée sur l'humain », écrit-il. Le point de vue de Jordan comprend une discussion revitalisée sur le rôle de l'ingénierie dans la politique publique et la recherche universitaire. Il fait remarquer que lorsque les gens parlent de sciences sociales, cela semble attrayant, mais que le terme d'ingénierie sociale ne l'est pas.

Je pense que nous avons laissé le terme « ingénierie se déprécier dans la sphère intellectuelle », déclare-t-il. Le terme « science » est utilisé à la place du terme « ingénierie » lorsque les gens souhaitent faire référence à une recherche visionnaire. « Je pense qu'il est important de rappeler que, malgré toutes les choses merveilleuses que la science a faites pour l'espèce humaine, c'est vraiment l'ingénierie (civile, électrique, chimique et autres domaines de l'ingénierie) qui a le plus directement et le plus profondément amélioré le bonheur humain », précise-t-il. En gros, c’est un avis qui cadre avec celui de Kate Crawford de Microsoft Research.

La filière intelligence artificielle finit donc par redonner vie au canular du Turc mécaniqueRoger Penrose says AIs aren't intelligent. They don't understand. To understand presupposes awareness. We don't know if AIs are aware. Therefore, we don't know if AIs understand. To Penrose, computations of this sort may never be aware. #AI #Understanding pic.twitter.com/FPkfWHC7iB

— Curt Jaimungal (@TOEwithCurt) November 6, 2025

Le Turc mécanique ou l’automate joueur d'échecs est un célèbre canular construit à la fin du XVIIIe siècle : il s’agissait d'un prétendu automate doté de la faculté de jouer aux échecs. L’automate était prétendument capable de jouer une partie d’échecs contre un adversaire humain. Mais en réalité, il possédait un compartiment secret dans lequel un joueur humain pouvait se glisser. Pendant 84 ans, et grâce au talent des joueurs cachés, le Turc mécanique put remporter la plupart des parties d'échecs auxquelles il participa en Europe et en Amérique, y compris contre certains hommes d'État tels que Napoléon Bonaparte, Catherine II de Russie et Benjamin Franklin.

Plus de deux siècles plus tard, il apparaît que ce même leurre fonctionne toujours. Et pour cause, il est difficile de concevoir un service propulsé par une intelligence artificielle. Une tâche si difficile que certaines startups se sont résolues de se tourner vers des humains et les faire passer pour des robots plutôt que le contraire.

« Utiliser un humain pour faire le travail vous permet d’outrepasser une panoplie d’enjeux de développement d’ordre technique et commercial. Il n’y a pas de scalabilité, bien évidemment, mais cela vous permet de créer quelque chose et sauter très tôt la partie difficile, » a dit Gregory Koberger, PDG de ReadMe, qui dit avoir tombé sur beaucoup de “pseudo-IA”. « Il s’agit essentiellement d’un prototypage de l’IA avec des êtres humains, » dit-il.

Cette pratique a été mise à la lumière du jour après la publication d’un article du Wall Street Journal informant que des centaines de développeurs tiers bénéficient de l’accès aux emails avec l’autorisation de Google.

Dans le cas de la société Edison Software, des ingénieurs d’IA ont scanné les emails personnels de centaines d’utilisateurs (avec leurs identités éditées) pour améliorer une fonctionnalité de « réponses intelligentes ». L’entreprise n’a pas indiqué dans sa politique de confidentialité que des employés humains ont accès aux emails des utilisateurs.

Ce n’est pas la première fois qu’une telle chose arrive. En 2008, Spinvox, une entreprise qui convertissait les messages vocaux en messages textes, a été accusée de recourir à des employés humains étrangers dans des centres d’appel au lieu de machines pour faire le travail.

En 2016, une autre entreprise relevée par Bloomberg cette fois a obligé des employés à passer 12 heures par jour à prétendre qu’ils sont des chatbots pour des services d’agenda comme X.ai et Clara. Ce travail a été si contraignant que les employés ont dit qu’ils avaient hâte de voir une IA venir les remplacer.

En 2017, l’application de gestion de dépenses Expensify a admis avoir employé des humains pour transcrire au moins quelques-uns des reçus supposés être analysés par sa “technologie smartscreen”. L’entreprise a utilisé le service de travail collaboratif Mechanical Turk d’Amazon, où des travailleurs faiblement rémunérés ont dû lire et transcrire les reçus.

« Je me demande si les utilisateurs de SmartScan d’Expensify savent que des travailleurs dans MTurk entrent leurs reçus, » a dit Rochelle LaPlante, une “Turker” et une partisane des travailleurs de la “gig economy” sur Twitter. « Je suis en train de voir le reçu Uber de quelqu’un avec son nom complet, et les adresses de départ et d’arrivée. »

Même Facebook, qui a investi massivement dans l’IA, a eu recours à des employés humains pour son assistant virtuel sur Messenger.

Dans certains cas, certaines entreprises font appel à des humains pour entraîner le système IA et améliorer sa précision. Une entreprise appelée Scale offre une banque de travailleurs humains pour fournir des données d’entrainement aux voitures autonomes et les autres systèmes propulsés par l’IA. Ces employés vont, par exemple, jeter un coup d’œil sur un flux d’une caméra ou un capteur et les marques de voiture, les piétons et les cyclistes dans une image. Avec assez de calibrage humain, l’IA apprend à reconnaître ces objets, seule.

Dans d’autres cas, les entreprises vont juste faire semblant d’avoir une IA prête, en informant les investisseurs et les utilisateurs qu’ils ont réussi à développer une technologie adaptable à grande échelle alors que le travail est réalisé secrètement par des humains.

Et vous ?

Quel commentaire faites-vous de la position du cofondateur de Rockstar sur la question de l’intelligence artificielle ?

Que pensez-vous de la pratique qui consiste à présenter un service comme animé par une IA alors qu'il s'agit en réalité d'humains qui travaillent en arrière-plan ?

Voir aussi :

57 % des travailleurs dans l'industrie technologique dans la Silicon Valley ont déclaré être en burn out, d'après une enquête

Les chercheurs en intelligence artificielle peuvent-ils gagner jusqu'à 1 million $ par an dans la Silicon Valley ? un aperçu des salaires

La bulle technologique de la Silicon Valley est plus grande qu'elle ne l'était en 2000, mais sa fin approche selon des analystes

Répondre avec citation

Répondre avec citation

Partager