google a de nombreux service gratuits qui sont tres bien fait et pour une bonne raisons.

une fois que vous ne pouvez plus vous en passer, il ya une sorte de chantage qui s'installe.

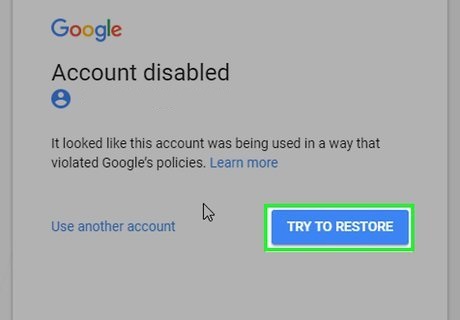

mais au dela de ca, il peut tout vous couper comme ca lui prends. c'est couvert dans les dispositions generales que

vous n'avez pas le choix de signer regulierement pour continuer a utiliser les services en question. (le fameux chantage dont je parlais)

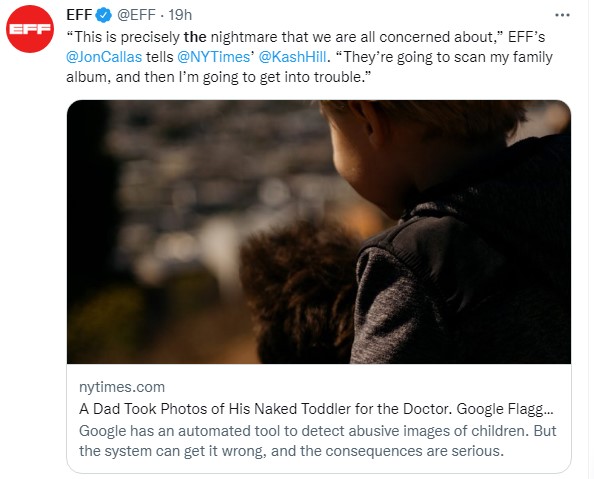

Et comme pour les jeux et apps qui sont supprimés avec un messages abscons sans possibiltié de faire appel par le dev, ni contact de quoi que ce soit,

vous perdez d'un coup l'acces a tous les services google dont vous etes dependant d'une maniere ou d'une autre, donc tout vos mails, votre telephone android, et toute les autres services, comme google ads (que vous ayez des sous ou pas dedssus bien evidemment).

si vous etendez ca aux autres GAFAM, ca peut limite vous couper de la plupart des grand services mainstream d'internet.

Pour eviter ca, il ne faut pas mettre tout ces oeufs dans le meme panier, soit, commencer, a ce passer d'eux quand c'est possible.

Et c'est pas evident, mais necessaire. ce qui lui est arrivé peut vous arriver pour un motif encore plus light..

Répondre avec citation

Répondre avec citation

Que pensez-vous des conclusions des chercheurs ?

Que pensez-vous des conclusions des chercheurs ?

Partager