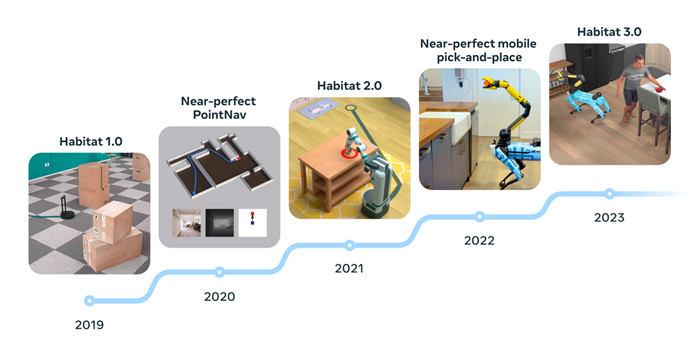

Nous proposons l'IA incarnée (E-AI) comme la prochaine étape fondamentale dans la poursuite de l'intelligence générale artificielle (AGI), en la juxtaposant aux progrès actuels de l'IA, en particulier les grands modèles de langage (LLM). Nous parcourons l'évolution du concept d'incarnation dans divers domaines (philosophie, psychologie, neurosciences et robotique) pour souligner comment l'E-AI se distingue du paradigme classique de l'apprentissage statique. En élargissant la portée de l'E-AI, nous introduisons un cadre théorique basé sur les architectures cognitives, mettant l'accent sur la perception, l'action, la mémoire et l'apprentissage en tant que composantes essentielles d'un agent incarné.

Ce cadre est aligné sur le principe d'inférence active de Friston, offrant ainsi une approche globale du développement de l'E-AI. Malgré les progrès réalisés dans le domaine de l'IA, des défis importants persistent, tels que la formulation d'une nouvelle théorie d'apprentissage de l'IA et l'innovation d'un matériel avancé. Notre discussion établit une ligne directrice fondamentale pour la recherche future en matière d'IA électronique. En soulignant l'importance de créer des agents d'IA électronique capables de communiquer, de collaborer et de coexister avec des humains et d'autres entités intelligentes dans des environnements réels, nous visons à orienter la communauté de l'IA vers la résolution des défis à multiples facettes et à saisir les opportunités qui s'offrent à nous dans la quête de l'AGI.

Conclusion

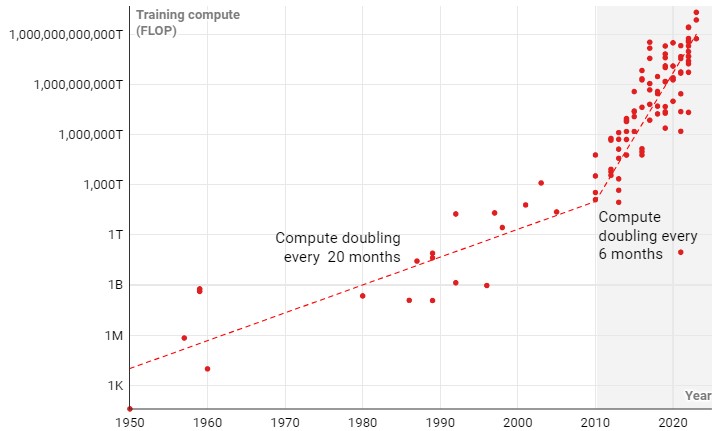

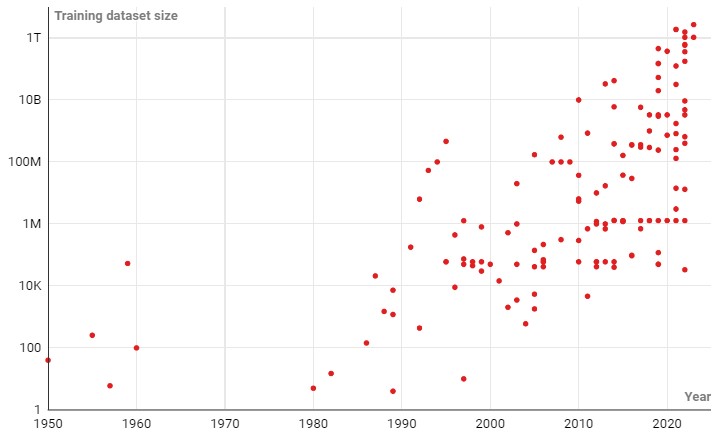

Dans cet article, nous avons articulé le rôle critique que joue l'IA incarnée sur la voie de la réalisation de l'AGI, en la distinguant des méthodologies d'IA dominantes, notamment les LLM. En intégrant des idées provenant d'un large éventail de domaines de recherche, nous avons souligné comment le développement de l'E-AI bénéficient des connaissances existantes, alors que les LLM améliorent le potentiel d'interactions intuitives entre les humains et les entités d'IA émergentes.

Nous avons présenté un cadre théorique complet pour le développement de l'IA électronique, fondé sur les principes des sciences cognitives, mettant en évidence la perception, l'action, la mémoire et l'apprentissage, situant l'IA électronique dans le contexte du cadre d'inférence active de Friston, offrant ainsi une toile de fond théorique très large pour notre discussion. Malgré ces perspectives, le chemin à parcourir est semé d'embûches, notamment la formulation d'une nouvelle théorie de l'apprentissage adaptée à l'IA et la création de solutions matérielles sophistiquées. Ce document vise à servir de feuille de route pour les recherches en cours et à venir sur l'IA électronique, en proposant des orientations qui pourraient conduire à des avancées significatives.

Pensez-vous que cette prédiction est crédible ou pertinente ?

Quel est votre avis sur le sujet ?

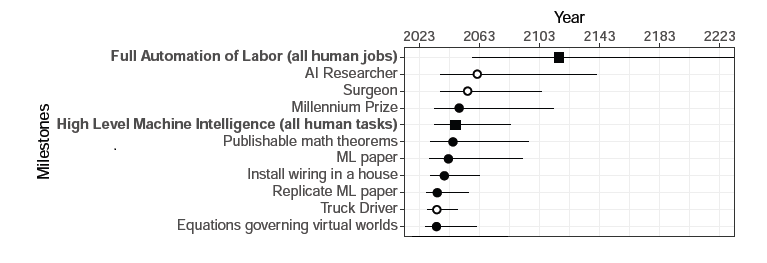

Quand arrivera l'intelligence artificielle supérieure AGI, quand les humains seront totalement remplacés par l'IA, la fin du monde par l'IA : Découvrez toutes les prédictions de 2,778 chercheurs

Les limites de l'intelligence artificielle : pourquoi l'IA ne peut pas surpasser le cerveau humain, selon des chercheurs de l'Université de Sheffield

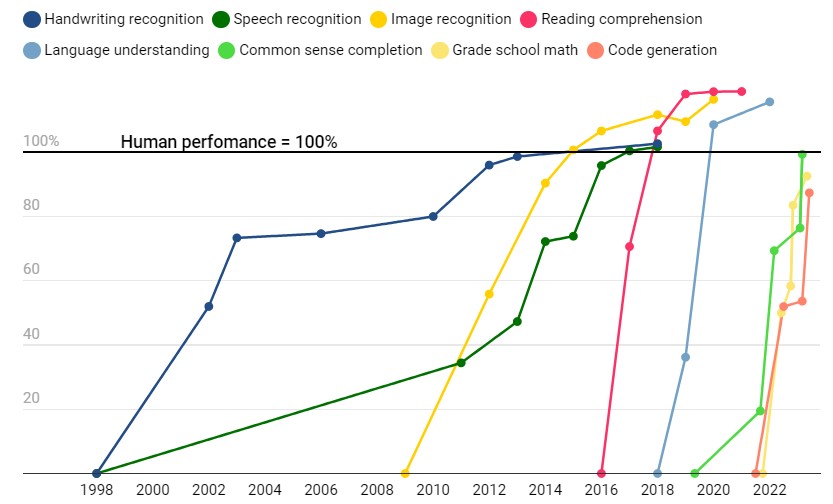

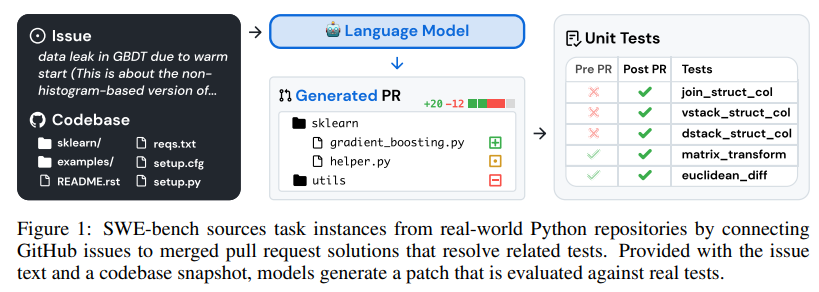

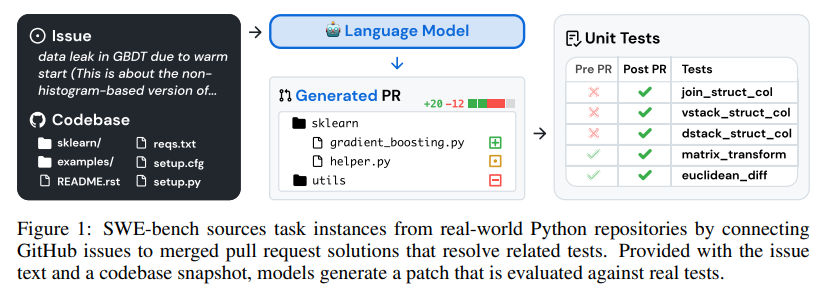

Quelles sont les compétences que l'IA maîtrise mieux que l'homme ? L'IA aurait surpassé l'homme dans la compréhension du langage, mais reste à la traîne dans la génération de code informatique

Répondre avec citation

Répondre avec citation

cela fait 10 ans qu'il y a 1 débat entre ingénieur vs programmeur vs développeur.

cela fait 10 ans qu'il y a 1 débat entre ingénieur vs programmeur vs développeur.

Partager