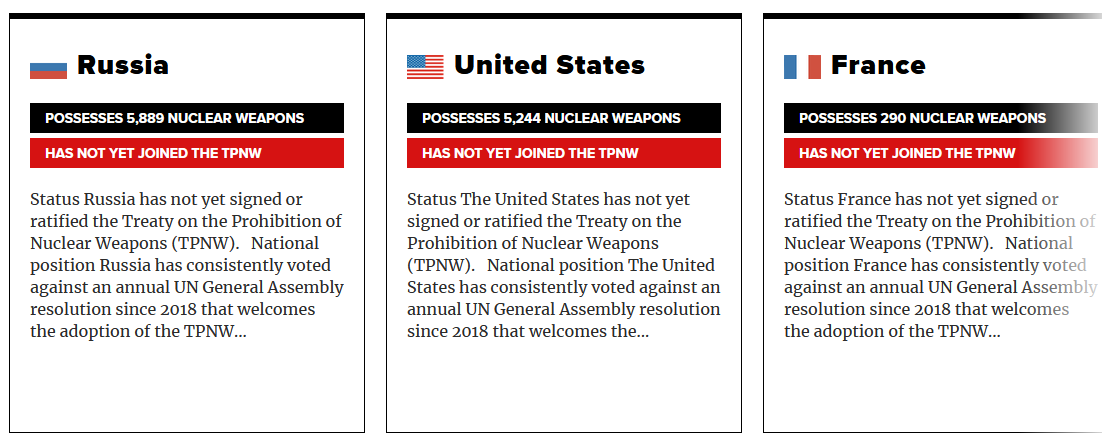

À l'heure actuelle, neuf pays possèdent des armes nucléaires. Il s'agit de

- la Russie

- les États-Unis

- la Chine

- la France

- le Royaume-Uni

- Le Pakistan

- L'Inde

- Israël

- La Corée du Nord

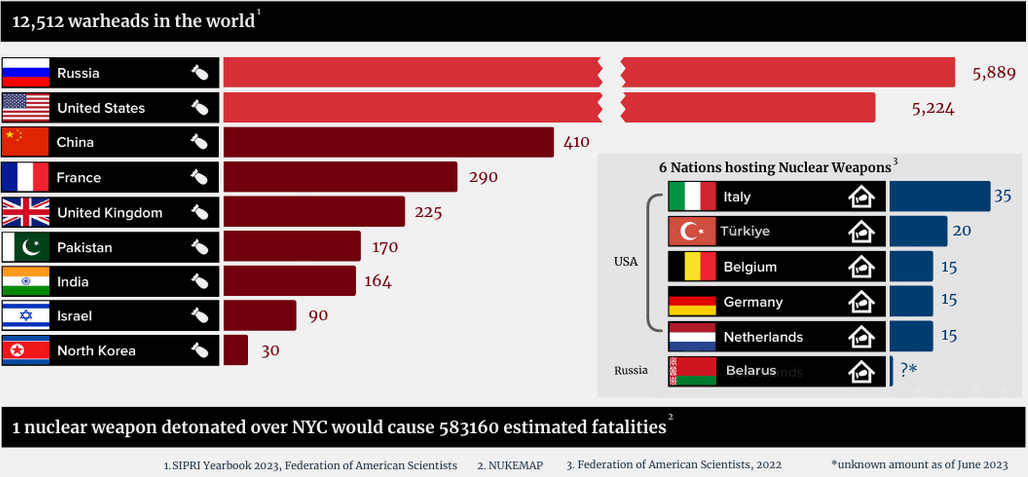

Ensemble, ces États possèdent 12 700 ogives nucléaires, dont 9 400 sont des stocks militaires actifs. Bien qu'il s'agisse d'une baisse significative par rapport aux quelque 70 000 ogives détenues par les États dotés d'armes nucléaires pendant la guerre froide, les arsenaux nucléaires devraient augmenter au cours de la prochaine décennie et les forces d'aujourd'hui sont beaucoup plus performantes.

Qui possède le plus d'armes nucléaires ?

La Russie possède le plus grand nombre d'armes nucléaires confirmées, avec 5 997 têtes nucléaires. Les États-Unis suivent avec 5 428 armes nucléaires, réparties entre les États-Unis et cinq autres pays : Turquie, Italie, Belgique, Allemagne et Pays-Bas. Le nombre total d'ogives nucléaires détenues par ces deux pays représente à lui seul 90 % des armes nucléaires dans le monde.

Le nombre total d'ogives de la Corée du Nord et d'Israël n'est pas confirmé. Toutefois, on estime que la Corée du Nord possède suffisamment de matières fissiles pour développer entre 40 et 50 armes individuelles, tandis qu'Israël possède des matières pour en fabriquer jusqu'à 200, avec un nombre d'ogives estimé à 90.

Que signifie la possession d'armes nucléaires par ces pays ?

Une seule ogive nucléaire pourrait tuer des centaines de milliers de personnes, avec des conséquences humanitaires et environnementales durables et dévastatrices. La détonation d'une seule arme nucléaire au-dessus de New York causerait environ 583 160 morts.

Ensemble, la Russie, les États-Unis, le Royaume-Uni, la France, la Chine, l'Inde, le Pakistan, Israël et la Corée du Nord possèdent un total estimé à environ 13 000 armes nucléaires, dont la plupart sont beaucoup plus puissantes que l'arme nucléaire larguée sur Hiroshima. Trente-deux autres États font également partie du problème, cinq nations hébergeant des armes nucléaires et vingt-sept autres approuvant leur utilisation.

Armes nucléaires tactiques

Une arme nucléaire tactique est une arme qui n'a pas été classée comme « stratégique » dans le cadre des accords de contrôle des armements conclus entre les États-Unis et la Russie. La Federation of American Scientists estime actuellement à 1 912 le nombre d'ogives nucléaires non stratégiques russes et à environ 100 le nombre d'ogives nucléaires non stratégiques américaines déployées dans cinq pays européens. Bien qu'elles soient souvent présentées comme des armes nucléaires « plus petites » ou « à faible rendement », et qu'il soit sous-entendu qu'elles causeraient moins de dégâts, ces ogives peuvent avoir des rendements explosifs allant jusqu'à 300 kilotonnes, soit 20 fois plus que la bombe qui a détruit Hiroshima.

Répondre avec citation

Répondre avec citation

Quel est votre avis sur le sujet ?

Quel est votre avis sur le sujet ?

La ficelle est tellement grosse...

La ficelle est tellement grosse...

Partager