Claude 3 Opus détruit les autres modèles dans les tâches de résumer, livrant le plus fidèle des résumés de livres, suivi par GPT-4 Turbo, selon une étude sur les capacités de résumer des LLM.

Des chercheurs ont classé les capacités de résumer des LLM. Les résultats de l'étude montrent que Claude 3 Opus surpasse de manière significative tous les LLM à source fermée, tandis que le Mixtral à source ouverte est au même niveau que GPT-3.5 Turbo.

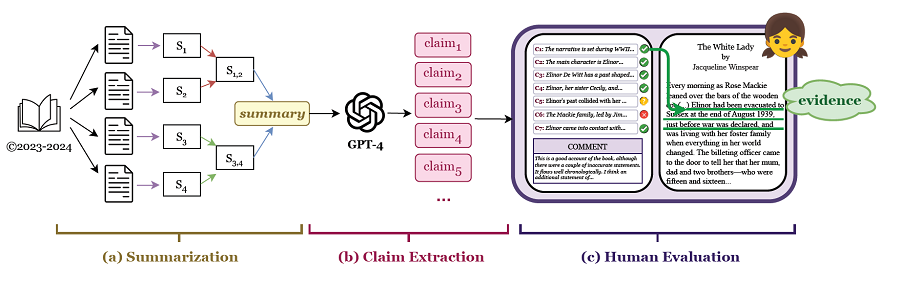

Bien que les grands modèles de langage (LLM) à contexte long puissent techniquement résumer des longs documents (> 100K jetons), la longueur et la complexité des documents ont jusqu'à présent empêché l'évaluation d'aspects dépendants de l'entrée tels que la fidélité. Dans cette étude, les chercheurs ont réalisé la première évaluation humaine à grande échelle de la fidélité et de la sélection du contenu sur des résumés de livres fictifs générés par des LLM.

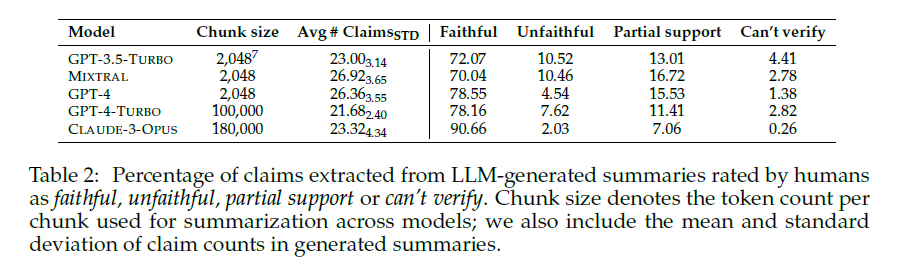

L'étude atténue le problème de la contamination des données en se concentrant sur les résumés de livres publiés en 2023 ou 2024. Les chercheurs ont engagé des annotateurs qui ont lu entièrement chaque livre avant la tâche d'annotation afin de minimiser le coût et la charge cognitive. Ils ont collecté FABLES, un ensemble de données d'annotations sur 3 158 affirmations faites dans les résumés générés par LLM de 26 livres, à un coût de 5 200 dollars, ce qui permet de classer les résumeurs LLM sur la base de la fidélité : CLAUDE-3-OPUS surpasse de manière significative tous les LLM à source fermée, tandis que le MIXTRAL à source ouverte est au même niveau que GPT-3.5-TURBO.

Une analyse des annotations révèle que la plupart des affirmations infidèles se rapportent à des événements et à des états de personnages, et qu'elles nécessitent généralement un raisonnement indirect sur le récit pour être invalidées. Alors que les évaluateurs automatiques basés sur LLM se sont avérés fiables pour la factualité et la cohérence dans d'autres contextes, l'étude met en œuvre plusieurs évaluateurs LLM de fidélité et constate qu'aucun n'est en forte corrélation avec les annotations humaines, en particulier en ce qui concerne la détection des affirmations infidèles. Cette expérience suggère que la détection des affirmations infidèles est une orientation future importante, non seulement pour l'évaluation des résumés, mais aussi comme banc d'essai pour la compréhension des longs contextes.

Enfin, l'étude va au-delà de la fidélité en explorant les erreurs de sélection de contenu dans les résumés de livres : les chercheurs ont développé une typologie d'erreurs d'omission liées à des éléments narratifs cruciaux et identifient également une sur-importance systématique des événements se produisant vers la fin du livre.

Ils publient FABLES pour stimuler la recherche sur l'évaluation des résumés de livres :

Source : "FABLES: Evaluating faithfulness and content selection in book-length summarization"Nous présentons FABLES, la première évaluation humaine à grande échelle de la fidélité et de la sélection du contenu dans le résumé d'un livre. En recrutant des annotateurs qui ont lu des livres récemment publiés pour le plaisir, nous recueillons 3 158 annotations de fidélité au niveau des revendications à partir de résumés générés par LLM de 26 récits. Cela nous permet de classer les résumeurs LLM sur la base de la fidélité, révélant que CLAUDE-3-OPUS est le résumeur de livre le plus fidèle, suivi par GPT-4-TURBO.

Ensuite, nous expérimentons l'utilisation des LLM pour la vérification automatique des revendications. Nos résultats révèlent les limites de la recherche et de la compréhension du contexte long : Les vérificateurs automatiques de LLM ne peuvent pas détecter de manière fiable les affirmations infidèles, même lorsqu'ils sont invités à lire le texte complet du livre. Notre analyse montre que les affirmations infidèles concernent principalement des états et des événements, nécessitant souvent un raisonnement sur des contextes étendus, ce qui les rend compliquées à détecter à la fois pour les humains et les machines. Enfin, nous allons au-delà de la fidélité pour explorer et caractériser les erreurs courantes de sélection du contenu, telles que l'omission d'événements, d'attributs et de personnages clés, ainsi que l'importance excessive accordée au contenu de la fin du livre.

Et vous ?

Pensez-vous que cette étude est crédible ou pertinente ?

Quel est votre avis sur le sujet ?

Voir aussi :

Les résumés d'articles générés par ChatGPT parviennent à duper des scientifiques. Ils ne peuvent pas toujours faire la différence entre les résumés générés par l'IA et les résumés originaux

LLM par taux d'hallucinations : GPT-4 est le modèle de langage IA qui hallucine le moins, d'après une évaluation de Vectara qui suggère que les LLM de Google sont les moins fiables

Les grands modèles de langage (LLM) sont désormais capables d'ignorer des informations non pertinentes grâce à la nouvelle technique "System 2 Attention" (S2A) introduite par Meta

Répondre avec citation

Répondre avec citation

Partager