Anthropic, une startup soutenue par Google, lance la suite de modèles d'IA "Claude 3", le modèle Claude 3 Opus surpassant les modèles concurrents GPT-4 et Gemini 1.0 Ultra.

Anthropic lance la suite de modèles d'ntelligence artificielle "Claude 3". Selon l'entreprise, Claude 3 Opus présente des niveaux de compréhension et de fluidité proches de ceux de l'homme pour des tâches complexes, ce qui le place à la pointe de l'intelligence générale. Ce modèle surpasserait même les modèles rivaux GPT-4 d'OpenAI et Gemini 1.0 Ultra de Google dans divers examens de référence.

Anthropic, une startup soutenue par Google et Amazon, a dévoilé une suite de modèles d'intelligence artificielle connue sous le nom de Claude 3, dernière salve en date dans la compétition quasi incessante de la Silicon Valley pour commercialiser des technologies toujours plus puissantes. Selon la startup, le modèle le plus performant de la famille, Claude 3 Opus, surpasse les modèles rivaux GPT-4 d'OpenAI et Gemini 1.0 Ultra de Google dans divers examens de référence.

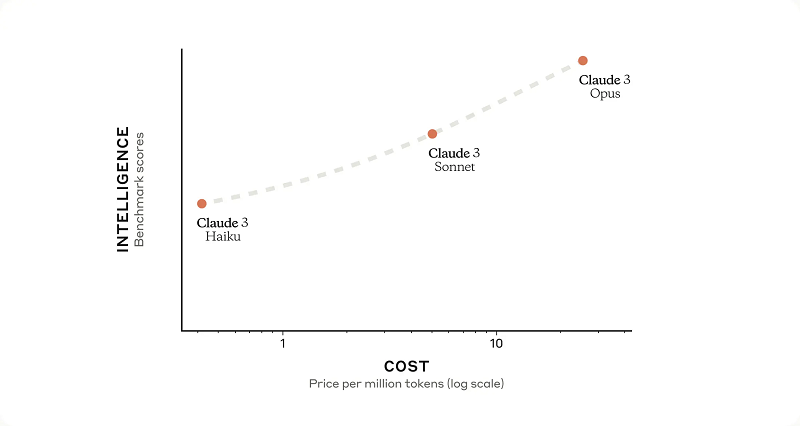

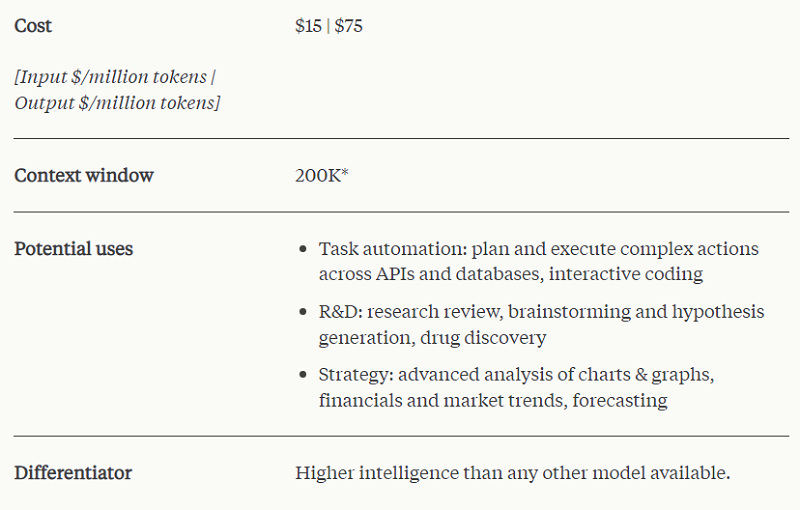

Cette nouvelle, qui fait suite à une myriade d'annonces de concurrents et à la sortie de Claude 2 d'Anthropic en juillet, montre comment les entreprises rivalisent pour se hisser au sommet des classements des performances de l'IA, alors même que les entreprises clientes s'interrogent encore sur la manière d'utiliser une telle technologie. Daniela Amodei, présidente d'Anthropic, a déclaré que les clients opteraient pour Claude 3 Opus, malgré un prix plus élevé, "s'ils avaient besoin des tâches les plus complexes sur le plan cognitif", par exemple pour traiter avec précision une analyse financière compliquée.

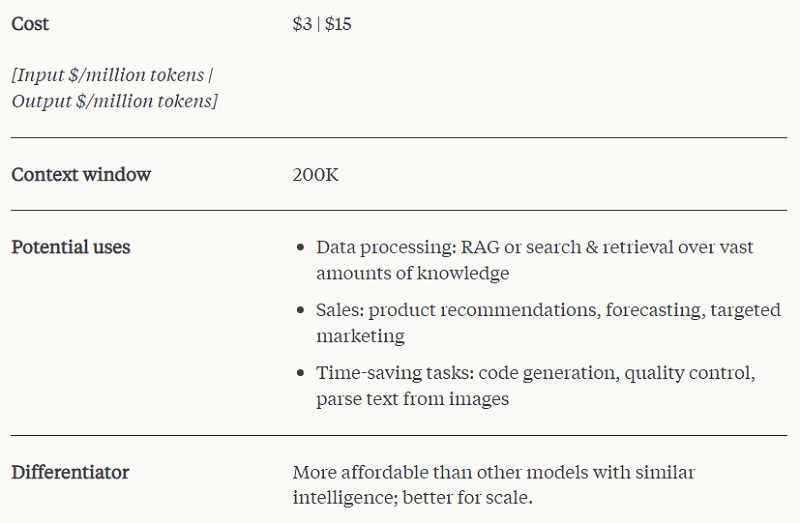

Anthropic a déclaré qu'elle facturerait 15 dollars pour que Claude 3 Opus prenne en compte chaque million de données appelées "tokens", et au moins cinq fois moins pour que ses modèles plus petits traitent la même chose. En revanche, OpenAI facture 10 dollars pour chaque million de jetons entrés dans son modèle GPT-4 Turbo. Anthropic a également déclaré que Claude 3 était sa première suite d'IA "multimodale". Cela signifie que, comme d'autres modèles concurrents, l'IA d'Anthropic peut répondre à des requêtes textuelles et à des images, par exemple en analysant une photo ou un graphique.

Découvrons en détails cette nouvelle génération de Claude !Anthropic :

Aujourd'hui, nous annonçons la famille de modèles Claude 3, qui établit de nouvelles références industrielles dans un large éventail de tâches cognitives. La famille comprend trois modèles de pointe par ordre croissant de capacité : Claude 3 Haiku, Claude 3 Sonnet et Claude 3 Opus. Chaque modèle successif offre des performances de plus en plus puissantes, permettant aux utilisateurs de choisir l'équilibre optimal entre intelligence, vitesse et coût pour leur application spécifique.

Opus et Sonnet sont maintenant disponibles pour être utilisés dans claude.ai et l'API de Claude qui est maintenant disponible dans 159 pays. Haiku sera bientôt disponible.

Un nouveau standard pour l'intelligence

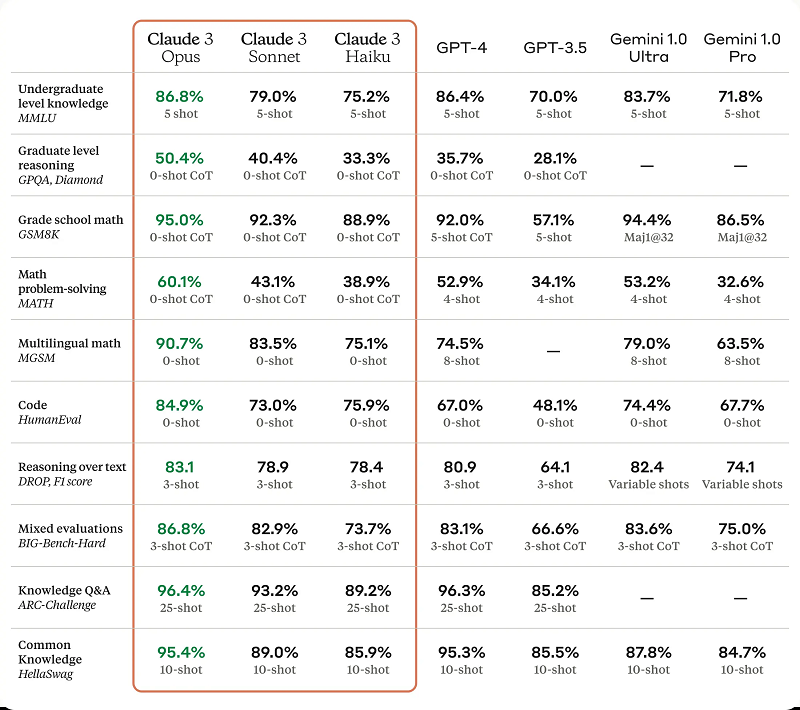

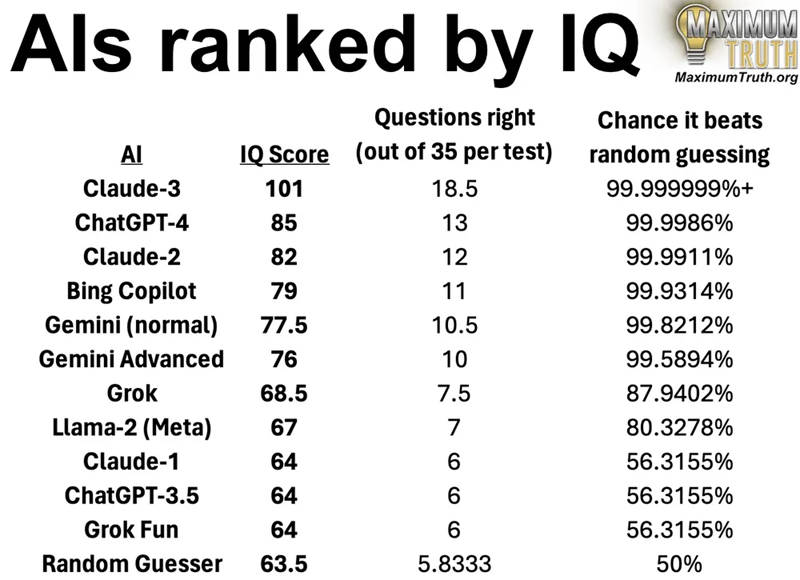

Selon Anthropic, Opus, qui est le modèle le plus intelligent, surpasse ses pairs sur la plupart des critères d'évaluation courants pour les systèmes d'IA, y compris les connaissances d'expert de premier cycle (MMLU), le raisonnement d'expert de deuxième cycle (GPQA), les mathématiques de base (GSM8K), et bien d'autres. Il présente des niveaux de compréhension et de fluidité proches de ceux de l'homme pour des tâches complexes, ce qui le place à la pointe de l'intelligence générale.

Tous les modèles de Claude 3 présentent des capacités accrues en matière d'analyse et de prévision, de création de contenu nuancé, de génération de code et de conversation dans des langues autres que l'anglais, comme l'espagnol, le japonais et le français.

Vous trouverez ci-dessous une comparaison faite par Anthropic des modèles Claude 3 avec d'autres modèles sur plusieurs critères de capacité :

Résultats quasi instantanés

Les modèles de Claude 3 peuvent alimenter des chats en direct avec des clients, des auto-complétions et des tâches d'extraction de données où les réponses doivent être immédiates et en temps réel.

Haiku serait le modèle le plus rapide et le plus rentable du marché dans sa catégorie d'intelligence. Il peut lire un article de recherche dense en informations et en données sur arXiv (~10k tokens) avec des diagrammes et des graphiques en moins de trois secondes. Après le lancement, Anthropic prévoit d'améliorer encore les performances.

Pour la grande majorité des charges de travail, Sonnet est deux fois plus rapide que Claude 2 et Claude 2.1 avec des niveaux d'intelligence plus élevés. Il excelle dans les tâches exigeant des réponses rapides, comme la recherche de connaissances ou l'automatisation des ventes. Opus offre des vitesses similaires à Claude 2 et 2.1, mais avec des niveaux d'intelligence beaucoup plus élevés.

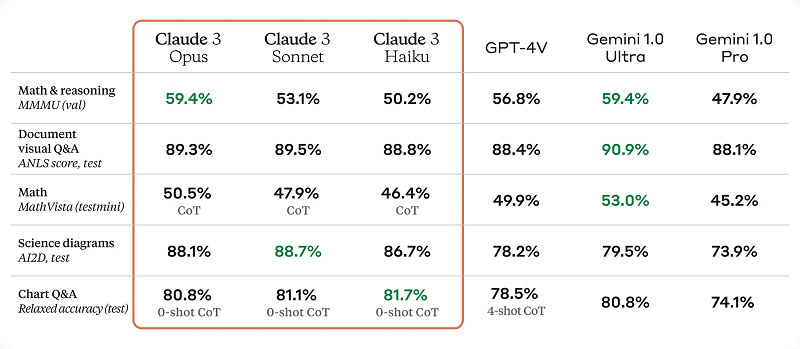

De fortes capacités de vision

Les modèles Claude 3 ont des capacités de vision sophistiquées comparables à celles des autres modèles de pointe. Ils peuvent traiter une large gamme de formats visuels, y compris des photos, des tableaux, des graphiques et des diagrammes techniques.

Anthropic :

Nous sommes particulièrement enthousiastes à l'idée de fournir cette nouvelle modalité à nos entreprises clientes, dont certaines ont jusqu'à 50 % de leurs bases de connaissances encodées dans divers formats tels que des PDF, des organigrammes ou des diapositives de présentation.

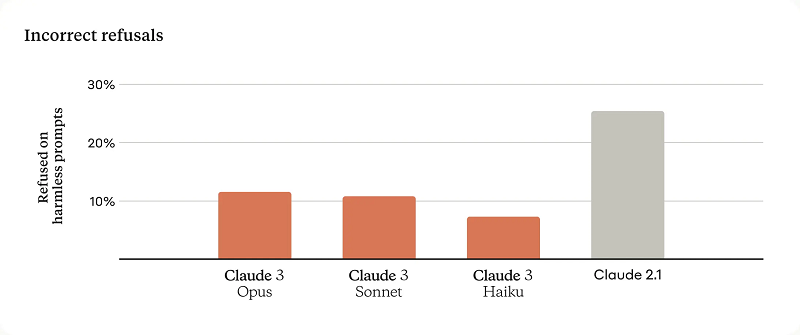

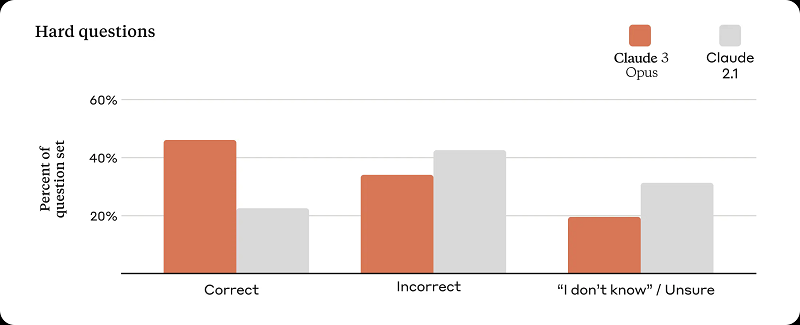

Moins de refus

Les anciens modèles de Claude entraînaient souvent des refus inutiles qui suggéraient un manque de compréhension du contexte. Anthropic aurait fait des progrès significatifs dans ce domaine : Opus, Sonnet et Haiku sont nettement moins susceptibles de refuser de répondre à des questions qui frôlent les garde-fous du système que les générations précédentes de modèles. Comme le montre le graphique ci-dessous, les modèles Claude 3 font preuve d'une compréhension plus nuancée des demandes, reconnaissent les dommages réels et refusent beaucoup moins souvent de répondre à des messages inoffensifs.

Une meilleure précision

Des entreprises de toutes tailles s'appuient sur ces modèles pour servir des clients. Il est donc impératif que les résultats conservent une grande précision à l'échelle.

En plus de produire des réponses plus fiables, Anthropic activerait bientôt les citations dans ses modèles Claude 3 afin qu'ils puissent pointer vers des phrases précises dans des documents de référence pour vérifier leurs réponses.Anthropic :

Pour ce faire, nous utilisons un large éventail de questions factuelles complexes qui ciblent les faiblesses connues des modèles actuels. Nous classons les réponses en réponses correctes, réponses incorrectes (ou hallucinations) et aveux d'incertitude, où le modèle dit qu'il ne connaît pas la réponse au lieu de fournir des informations incorrectes. Par rapport à Claude 2.1, Opus multiplie par deux la précision (ou les réponses correctes) à ces questions ouvertes difficiles, tout en réduisant le nombre de réponses incorrectes.

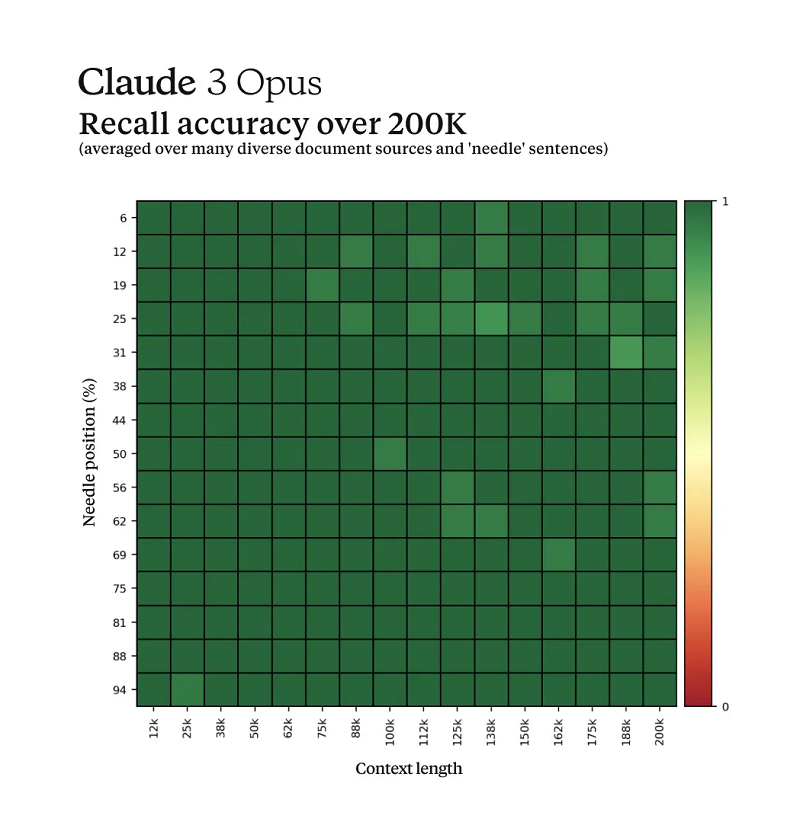

Un long contexte et une mémorisation presque parfaite

La famille de modèles Claude 3 offrira initialement une fenêtre de 200 000 contextes lors de son lancement. Cependant, les trois modèles seraient capables d'accepter des entrées de plus d'un million de jetons et Anthropic pourrait mettre cette option à la disposition de certains clients qui ont besoin d'une puissance de traitement accrue.

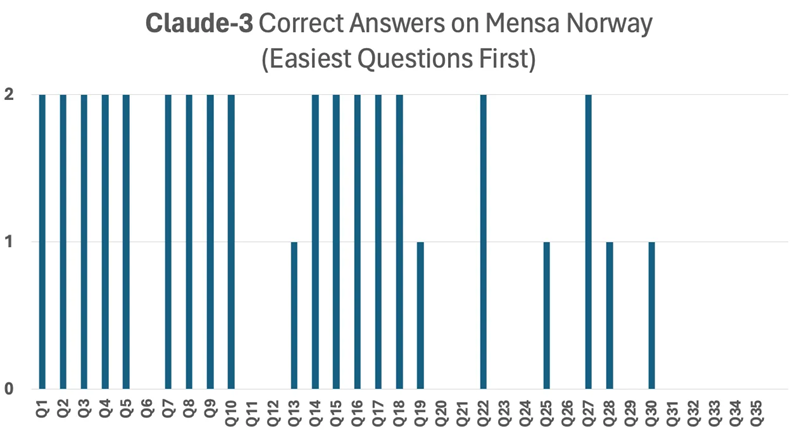

Pour traiter efficacement les longues invites contextuelles, les modèles doivent être dotés de solides capacités de rappel. L'évaluation "Needle In A Haystack" (NIAH) mesure la capacité d'un modèle à rappeler avec précision des informations à partir d'un vaste corpus de données.

Anthropic :

Nous avons amélioré la robustesse de ce benchmark en utilisant l'une des 30 paires aléatoires aiguille/question par invite et en testant sur un corpus diversifié de documents provenant de la communauté. Claude 3 Opus a non seulement atteint un rappel presque parfait, dépassant 99% de précision, mais dans certains cas, il a même identifié les limites de l'évaluation elle-même en reconnaissant que la phrase "aiguille" semblait avoir été insérée artificiellement dans le texte original par un humain.

Une conception responsable

Voici ce que déclare Anthropic sur la conception des modèles Claude 3 :

Plus facile à utiliserAnthropic :

Nous avons développé la famille de modèles Claude 3 pour qu'ils soient aussi dignes de confiance qu'ils sont capables. Nous avons plusieurs équipes spécialisées qui suivent et atténuent un large éventail de risques, allant de la désinformation et du CSAM à l'abus biologique, à l'interférence électorale et aux compétences de réplication autonomes. Nous continuons à développer des méthodes telles que l'IA constitutionnelle qui améliore la sécurité et la transparence de nos modèles, et nous avons ajusté nos modèles pour atténuer les problèmes de protection de la vie privée qui pourraient être soulevés par de nouvelles modalités.

L'élimination des biais dans des modèles de plus en plus sophistiqués est un effort permanent et nous avons fait des progrès avec cette nouvelle version. Comme le montre la carte du modèle, Claude 3 présente moins de biais que nos modèles précédents selon le Bias Benchmark for Question Answering (BBQ). Nous restons déterminés à faire progresser les techniques qui réduisent les biais et favorisent une plus grande neutralité dans nos modèles, en veillant à ce qu'ils ne soient pas biaisés en faveur d'une position partisane particulière.

Bien que la famille de modèles Claude 3 ait progressé sur les mesures clés des connaissances biologiques, des connaissances cybernétiques et de l'autonomie par rapport aux modèles précédents, elle reste au niveau 2 de sécurité de l'IA (ASL-2), conformément à notre politique de mise à l'échelle responsable. Nos évaluations en équipe rouge (réalisées conformément aux engagements de la Maison Blanche et au décret américain de 2023) ont conclu que les modèles présentent un potentiel négligeable de risque catastrophique à l'heure actuelle. Nous continuerons à surveiller attentivement les futurs modèles afin d'évaluer leur proximité avec le seuil ASL-3. De plus amples informations sur la sécurité sont disponibles dans la fiche du modèle Claude 3.

Les modèles Claude 3 seraient plus aptes à suivre des instructions complexes en plusieurs étapes. Selon Anthropic, ils sont particulièrement doués pour respecter les directives relatives à la voix et aux réponses de la marque, et pour développer des expériences de contact avec la clientèle auxquelles les utilisateurs peuvent faire confiance. De plus, les modèles Claude 3 sont plus performants pour produire des résultats structurés dans des formats comme JSON, ce qui simplifie l'utilisation de Claude pour des cas d'utilisation tels que la classification en langage naturel et l'analyse des sentiments.

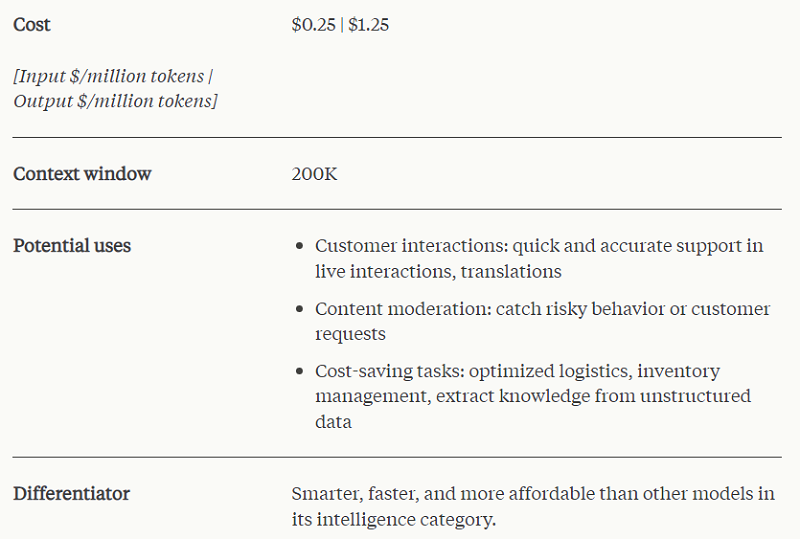

Détails des modèles

Claude 3 Opus est le modèle le plus intelligent, avec les meilleures performances du marché pour les tâches très complexes. Il peut naviguer dans des questions ouvertes et des scénarios invisibles avec une fluidité remarquable et une compréhension semblable à celle d'un être humain. Opus montre les limites extrêmes de ce qui est possible avec l'IA générative.

Claude 3 Sonnet trouve l'équilibre idéal entre l'intelligence et la vitesse, en particulier pour les charges de travail des entreprises. Il offre des performances élevées à un coût inférieur à celui de ses pairs, et est conçu pour une grande endurance dans les déploiements d'IA à grande échelle.

Claude 3 Haiku est le modèle le plus rapide et le plus compact pour une réactivité quasi instantanée. Il répond aux requêtes et demandes simples avec une rapidité inégalée. Les utilisateurs pourront créer des expériences d'IA transparentes qui imitent les interactions humaines.

Disponibilité des modèles

Opus et Sonnet peuvent être déjà utilisés dans l'API d'Anthropic, qui est désormais généralement disponible, ce qui permet aux développeurs de s'inscrire et de commencer à utiliser ces modèles immédiatement. Haiku sera bientôt disponible. Sonnet alimente l'expérience gratuite sur claude.ai, avec Opus disponible pour les abonnés Claude Pro.

Sonnet est également disponible sur Amazon Bedrock et en avant-première privée sur Google Cloud's Vertex AI Model Garden - avec Opus et Haiku bientôt disponibles sur les deux.

Conclusion

Avec l'annonce de la famille de modèles Claude 3, Anthropic veut créer un IA plus intelligente, plus rapide, mais aussi plus sûre !

Source : AnthropicAnthropic :

Nous ne pensons pas que l'intelligence du modèle soit proche de ses limites, et nous prévoyons de publier des mises à jour fréquentes de la famille de modèles Claude 3 au cours des prochains mois. Nous sommes également impatients de lancer une série de fonctionnalités pour améliorer les capacités de nos modèles, en particulier pour les cas d'utilisation en entreprise et les déploiements à grande échelle. Ces nouvelles fonctionnalités incluront l'utilisation d'outils (appel de fonction), le codage interactif (REPL) et des capacités agentiques plus avancées.

Alors que nous repoussons les limites des capacités de l'IA, nous sommes tout aussi déterminés à faire en sorte que nos garde-fous suivent le rythme de ces sauts de performance. Notre hypothèse est qu'être à la frontière du développement de l'IA est le moyen le plus efficace d'orienter sa trajectoire vers des résultats sociétaux positifs.

Nous sommes impatients de voir ce que vous allez créer avec Claude 3 et nous espérons que vous nous ferez part de vos commentaires pour faire de Claude un assistant encore plus utile et un compagnon créatif.

Et vous ?

Quel est votre avis sur cette annonce ?

Pensez-vous que les modèles Claude 3 soient crédibles ou pertinents ?

Voir aussi :

ChatGPT vs. Google Bard vs. Bing Chat vs. Claude : quelle est la meilleure solution d'IA générative ? D'après une étude de SearchEngineLand

Anthropic announce Claude 2.1, alimentant l'expérience de chat claude.ai et offrant des avancées dans les capacités clés pour les entreprises, y compris un contexte de jetons de 200K

Anthropic voudrait lever jusqu'à 5 milliards de dollars en deux ans pour affronter ChatGPT d'OpenAI, prévoyant de développer un outil 10 fois plus puissant que les modèles d'IA actuels

Répondre avec citation

Répondre avec citation

Partager