Meta teste le projet Purple Llama pour les développeurs d'IA afin de tester les risques de sécurité dans les modèles, de renforcer la sécurité et de bloquer les contenus inappropriés.

Meta AI a annoncé le lancement de Purple Llama, une initiative visant à promouvoir le développement et l'utilisation responsables de modèles d'IA générative. Ce projet répond à la popularité croissante des modèles d'IA open-source, avec plus de 100 millions de téléchargements des seuls modèles Llama.

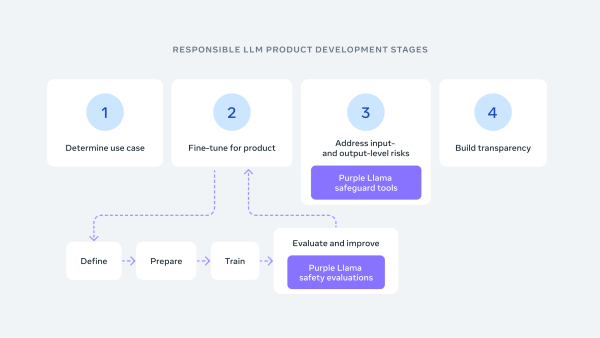

Purple Llama s'inspire du concept de cybersécurité "purple teaming", qui combine des approches offensives et défensives pour atténuer les risques. Il propose des outils et des évaluations dans deux domaines clés : la cybersécurité et les garanties d'entrée et de sortie.

En ce qui concerne le risque de cybersécurité du LLM, il est important de disposer d'un moyen de quantifier le risque de piratage d'un modèle d'IA. Les métriques peuvent y contribuer en fournissant un score qui indique la probabilité d'un piratage réussi. En outre, les développeurs peuvent utiliser des outils pour évaluer la fréquence des suggestions de code non sécurisé. Cela peut les aider à identifier et à corriger les problèmes dans leurs modèles d'IA que les pirates pourraient exploiter.

Il existe des outils de protection contre l'utilisation malveillante des modèles d'IA. Ces outils peuvent aider à empêcher les pirates de voler ou d'utiliser des données pour diffuser des fausses nouvelles. Les organisations peuvent mettre en œuvre ces outils pour protéger leurs modèles d'IA et éviter qu'ils ne soient utilisés à des fins malveillantes.

Qu'est-ce que les mesures de garanties des entrées/sorties ?

Les garanties d'entrée/sortie sont des mesures de sécurité mises en œuvre pour protéger les données contre l'accès, la manipulation ou la divulgation non autorisés au point d'entrée et de sortie d'un système.

Purple Llama travaille actuellement sur plusieurs projets. L'un d'entre eux est Llama Guard, un outil open-source destiné à aider les développeurs à identifier et à éviter de créer des contenus nuisibles. En outre, l'entreprise a créé des directives de filtrage de contenu que les développeurs peuvent suivre pour s'assurer que leurs modèles d'intelligence artificielle ne génèrent pas de contenu préjudiciable.

Meta a révélé son engagement en faveur d'un écosystème ouvert pour le développement de l'IA, ce qui signifie qu'elle souhaite faciliter le développement et l'utilisation de modèles d'IA pour tous. Elle travaille avec plusieurs partenaires sur ce projet, notamment AI Alliance, AMD, Google Cloud, Hugging Face (jetons Meta AI récemment exposés), IBM, Microsoft et NVIDIA.

Purple Llama : Vers une confiance et une sécurité ouvertes dans le nouveau monde de l'IA générative

L'IA générative a suscité une nouvelle vague d'innovation comme jamais vue auparavant. Grâce à elle, on a la possibilité de converser avec des IA conversationnelles, de générer des images réalistes et de résumer avec précision de vastes corpus de documents, le tout à partir de simples invites. Avec plus de 100 millions de téléchargements de modèles Llama à ce jour, une grande partie de cette innovation est alimentée par des modèles ouverts.

La collaboration en matière de sécurité renforcera la confiance dans les développeurs à l'origine de cette nouvelle vague d'innovation et nécessitera des recherches et des contributions supplémentaires sur l'IA responsable. Les personnes qui construisent les systèmes d'IA ne peuvent pas relever les défis de l'IA dans le vide, c'est pourquoi il faut uniformiser les règles du jeu et créer un centre de masse pour la confiance et la sécurité ouvertes.

Avec le lancement de Purple Llama - un projet parapluie qui, au fil du temps, rassemblera des outils et des évaluations pour aider la communauté à construire de manière responsable avec des modèles d'IA générative ouverte. La première version comprendra des outils et des évaluations pour la cybersécurité et les garanties d'entrée/sortie, et d'autres outils seront proposés dans un avenir proche.

Les composants du projet Purple Llama feront l'objet d'une licence permissive, permettant à la fois la recherche et l'utilisation commerciale. Il s'agit d'une étape importante pour favoriser la collaboration entre les communautés et normaliser le développement et l'utilisation d'outils de confiance et de sécurité pour le développement de l'IA générative.

Le premier pas en avant

La cybersécurité et la sécurité prompte du LLM sont des domaines importants pour la sécurité de l'IA générative aujourd'hui. Meta a donné la priorité à ces considérations dans son produit.

Cybersécurité

Meta partage ce qu'il pense être le premier ensemble d'évaluations de sécurité en matière de cybersécurité pour les LLM à l'échelle de l'industrie. Ces références sont basées sur les conseils et les normes de l'industrie (par exemple, CWE et MITRE ATT&CK) et construites en collaboration avec nos experts en matière de sécurité. Cette première version vise à fournir des outils qui aideront à faire face à certains risques décrits dans les engagements de la Maison Blanche sur le développement d'une IA responsable, y compris :

- Des métriques pour quantifier les risques de cybersécurité des LLM.

- des outils permettant d'évaluer la fréquence des suggestions de codes non sécurisés

- des outils permettant d'évaluer les LLM afin de rendre plus difficile la génération de codes malveillants ou l'aide à la réalisation de cyberattaques.

Meta pense que ces outils réduiront la fréquence à laquelle les LLM suggèrent des codes non sécurisés générés par l'IA et réduiront leur utilité pour les cyber-attaquants. Les premiers résultats montrent qu'il existe des risques significatifs de cybersécurité pour les LLM, à la fois en recommandant des codes non sécurisés et en se conformant à des demandes malveillantes.

Garanties d'entrée/sortie

Meta recommande que toutes les entrées et sorties du LLM soient vérifiées et filtrées conformément aux directives de contenu appropriées à l'application.

Pour soutenir cette recommandation et donner à la communauté les moyens d'agir, Meta publie Llama Guard, un modèle accessible à tous qui est compétitif sur des benchmarks ouverts courants et qui fournit aux développeurs un modèle pré-entraîné pour les aider à se défendre contre la génération de résultats potentiellement risqués.

Dans le cadre de son engagement permanent en faveur d'une science ouverte et transparente, Meta publie la méthodologie et une discussion approfondie sur les performances du modèle Llama Guard. Ce modèle a été entraîné sur un ensemble de données accessibles au public afin de permettre la détection de types communs de contenus potentiellement risqués ou violents qui peuvent être pertinents pour un certain nombre de cas d'utilisation par les développeurs. À terme, l'objectif est de permettre aux développeurs de personnaliser ce modèle afin de prendre en charge les cas d'utilisation pertinents et de faciliter l'adoption des meilleures pratiques et l'amélioration de l'écosystème ouvert.

Pourquoi le violet ?

Meta pense que pour véritablement atténuer les défis posés par l'IA générative, on doit adopter une position à la fois offensive (équipe rouge) et défensive (équipe bleue). L'équipe violette, composée de membres de l'équipe rouge et de l'équipe bleue, est une approche collaborative de l'évaluation et de l'atténuation des risques potentiels. La même philosophie s'applique à l'IA générative. C'est pourquoi l'investissement de Meta dans Purple Llama sera global.

Un écosystème ouvert

L'adoption d'une approche ouverte de l'IA n'est pas nouvelle pour Meta. La recherche exploratoire, la science ouverte et la collaboration croisée sont à la base de nos efforts en matière d'IA, et nous pensons qu'il existe une opportunité importante de créer un écosystème ouvert. Cet état d'esprit collaboratif était au premier plan lorsque Llama 2 a été lancé en juillet avec plus de 100 partenaires, et un grand nombre de ces mêmes partenaires s'associeront avec mETA sur la confiance et la sécurité ouvertes, y compris : AI Alliance, AMD, Anyscale, AWS, Bain, CloudFlare, Databricks, Dropbox, Google Cloud, Hugging Face, IBM, Intel, Microsoft, MLCommons, Nvidia, Oracle, Orange, Scale AI, Together.AI, et bien d'autres à venir.

Meta a également travaillé avec ses partenaires Papers With Code et HELM pour intégrer ces évaluations dans leurs benchmarks, ainsi qu'avec ses collaborateurs au sein du groupe de travail MLCommons AI Safety.

La voie à suivreNous sommes ravis de collaborer avec chacun de nos partenaires ainsi qu'avec d'autres qui partagent la même vision d'un écosystème ouvert d'IA générative développée de manière responsable.

Meta organise un atelier à NeurIPs 2023, où il prévoit de partager ces outils et de fournir un approfondissement technique pour aider les gens à démarrer.

Source : MetaNous espérons que vous vous joindrez à nous. Nous nous attendons à ce que les directives de sécurité et les meilleures pratiques fassent l'objet d'une conversation permanente dans le domaine, et nous souhaitons avoir votre avis. Nous sommes impatients de poursuivre la conversation, de trouver des moyens de partenariat et d'en savoir plus sur les domaines qui vous intéressent.

Et vous ?

Pensez-vous que ce projet est crédible ou pertinent ?

Quel est votre avis sur le sujet ?

Voir aussi :

Meta et IBM lancent l'Alliance pour l'IA un an après le lancement de ChatGPT, des entreprises comme AMD et ServiceNow s'associent à des universités pour promouvoir des alternatives "ouvertes" à OpenAI

Meta et Microsoft annoncent qu'ils achèteront la nouvelle puce d'IA d'AMD pour remplacer celle de Nvidia

Meta lance Meta AI et 28 IA ayant des « personnalités » incarnées par des célébrités telles que Snoop Dogg, Kendall Jenner et Paris Hilton, afin d'accroître l'interaction des jeunes avec l'IA

Répondre avec citation

Répondre avec citation

Partager