La puce d'IA Nvidia H100 à 40 000 dollars est devenue le matériel informatique le plus convoité au monde

et rapproche Nvidia des 1 000 milliards de dollars de capitalisation boursière

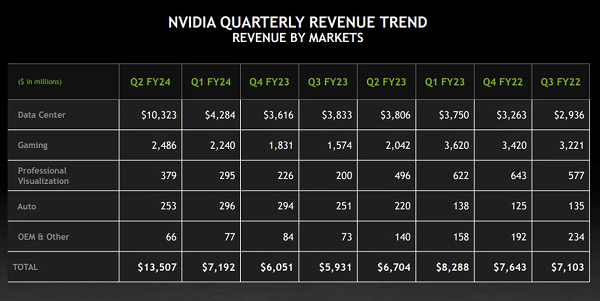

Tout porte à croire que Nvidia est l'entreprise qui tire actuellement le plus profit de la course effrénée à l'IA suscitée par le succès éclatant de ChatGPT. Les rapports indiquent que les entreprises et les startups d'IA du monde entier se ruent sur l'accélérateur GPU H100 lancé par Nvidia l'année dernière, ce processeur étant devenu un matériel incontournable dans le développement des modèles d'IA générative. L'accélérateur GPU H100, qui peut coûter jusqu'à 40 000 dollars, aurait permis à Nvidia d'engranger des bénéfices colossaux au cours du deuxième trimestre 2023, le chiffre d'affaires de l'entreprise sur cette période étant évalué à plus de 11 milliards de dollars.

Nvidia a lancé sa puce d'IA H100 en mars de l'année dernière. L'équipementier américain a décrit cet accélérateur GPU comme l'une des puces les plus puissantes qu'il ait jamais construites, ainsi que l'une des plus chères, puisqu'elle coûte environ 40 000 dollars l'unité. Le lancement semblait mal tombé, car l'annonce a été faite à un moment où les entreprises cherchaient à réduire leurs dépenses dans un contexte d'incertitude économique et d'inflation galopante. Puis, en novembre, ChatGPT a été lancé. Le chatbot d'IA d'OpenAI a été adopté par plus de 100 millions d'utilisateurs en à peine un mois, ce qui a propulsé la course à l'IA à un niveau supérieur.

Toutefois, pour développer des modèles d'IA surpuissants, il faut une puissance de calcul importante que très peu de matériels sont capables d'offrir à l'heure actuelle. Et c'est là que Nvidia entre en piste. Les grandes entreprises technologiques et les startups se sont précipitées pour obtenir l'accélérateur GPU H100 de Nvidia. « Nous sommes passés d'une année difficile l'année dernière à un retournement de situation du jour au lendemain. Le chatbot d'IA à succès d'OpenAI a été un moment décisif. Il a créé une demande instantanée », a déclaré Jensen Huang, PDG de Nvidia. Cette demande semble avoir fait exploser tous les chiffres de l'équipementier.

En effet, l'intérêt d'avoir le bon produit au bon moment est apparu clairement cette semaine. Nvidia a annoncé mercredi que son chiffre d'affaires pour les trois mois se terminant en juillet s'élèverait à 11 milliards de dollars (soit plus de 50 % de plus que les estimations précédentes de Wall Street) grâce à la reprise des dépenses des Big Tech dans les centres de données et à la demande pour ses puces d'IA. L'annonce a fait grimper la capitalisation boursière de Nvidia de 184 milliards de dollars en une seule journée jeudi, permettant à Nvidia, qui était déjà la société de puces la plus précieuse au monde, de s'approcher d'une valorisation de 1 000 Mds $.

La puce H100 s'avère particulièrement populaire auprès des Big Tech, qui construisent des centres de données entiers centrés sur les charges de travail d'IA, et des startups d'IA telles que Stability AI, OpenAI, Anthropic et Inflection AI, car il promet des performances plus élevées qui peuvent accélérer les lancements de produits ou réduire les coûts de formation au fil du temps. Microsoft et Google, qui développent des moteurs de recherche basés sur l'IA générative, comptent parmi les plus gros clients des puces H100 de Nvidia. Les fabricants de serveurs affirment avoir attendu plus de six mois pour recevoir leurs dernières commandes.

Les investisseurs en capital-risque achètent des puces H100 pour les startups dans lesquelles ils investissent. Elon Musk, qui a acheté des milliers de puces Nvidia pour sa nouvelle startup d'IA X.ai, a déclaré lors d'un événement cette semaine qu'à l'heure actuelle, "les GPU sont beaucoup plus difficiles à obtenir que les médicaments". « Le coût du calcul est devenu astronomique. L'investissement minimum doit être de 250 millions de dollars en matériel serveur [afin de construire des systèmes d'IA générative] », a déclaré Musk. Le milliardaire n'a toutefois pas précisé s'il fait référence aux nouvelles puces H100 ou aux puces de Nvidia en général.

En outre, la construction du supercalculateur Dojo de Tesla aurait été négativement impactée par cette ruée vers les puces de Nvidia. Dojo devrait permettre à Tesla de rendre sa flotte de véhicules électriques plus autonomes, mais les choses tournent au ralenti. Selon Musk, le projet Dojo a vu le jour uniquement parce que Tesla ne disposait pas de suffisamment de GPU de Nvidia. « Franchement, s'ils pouvaient nous fournir suffisamment de GPU, nous n'aurions peut-être pas besoin de Dojo. Ils ont tellement de clients. Ils ont eu la gentillesse, néanmoins, de donner la priorité à certaines de nos commandes de GPU », a déclaré Musk en juillet.

Musk a ajouté : « si Tesla avait pu recevoir de Nvidia le nombre de puces dont il avait besoin, elles auraient été intégrées dans des ordinateurs spécialisés qui auraient traité l'énorme quantité de données vidéo, ce qui est nécessaire pour parvenir à une solution généralisée pour l'autonomie. Les données doivent être traitées d'une manière ou d'une autre. Dojo est donc conçu pour être optimisé pour la formation vidéo, et non pour les systèmes d'IA générative, afin de traiter la quantité de données nécessaires pour les véhicules à conduite autonome, ce qui est important pour parvenir à une conduite autonome plus sûre que la conduite humaine ».

Who’s getting how many H100s and when is top gossip of the valley rn https://t.co/AxarseOmg9

— Andrej Karpathy (@karpathy) August 2, 2023

Cependant, les Big Tech et les startups d'IA ne sont pas les seules qui cherchent à sécuriser les accélérateurs GPU H100. La rumeur indique que l'Arabie saoudite et les Émirats arabes unis auraient acheté des milliers de ces puces à 40 000 dollars pour créer leurs propres applications d'IA. Cette forte demande pour une seule puce de la part d'une seule entreprise a donné lieu à une sorte de frénésie d'achat. « Qui obtient combien de H100 et quand, c'est le sujet de discussion dans Silicon Valley », a déclaré Andrej Karpathy, d'OpenAI, sur un message sur X (ex-Twitter, renommé X après le rachat par Elon en novembre de l'année dernière).

La puce H100 est le successeur des GPU A100 de Nvidia, qui ont été à la base des efforts de développement des grands modèles de langage (LLM) modernes. La puce H100 serait jusqu'à neuf fois plus rapide pour la formation de l'IA et 30 fois plus rapide pour l'inférence que l'A100. « En termes d'accès, oui, c'est ce à quoi ressemble la montée en puissance d'une nouvelle architecture de GPU », a déclaré Ian Buck, responsable de l'activité hyperscale et de calcul de haute performance de Nvidia. La puce H100, d'une taille inhabituelle, est un accélérateur GPU conçu pour fonctionner dans les centres de données et compte 80 milliards de transistors.

Bien qu'elle soit deux fois plus cher que son prédécesseur, l'A100 lancé en 2020, les premiers utilisateurs affirment que la puce H100 offre des performances au moins trois fois supérieures. « La H100 résout la question de l'évolutivité qui se posait aux créateurs de modèles [d'IA]. C'est important, car cela nous permet de former plus rapidement des modèles plus importants, alors que le problème passe de la recherche à l'ingénierie », a déclaré Emad Mostaque, cofondateur et PDG de Stability AI, l'entreprise à l'origine du service de génération d'images Stable Diffusion. Selon les experts, la demande des puces H100 devrait se poursuivre à la hausse.

Nvidia apparaît donc comme l'un des premiers grands gagnants de l'essor de l'IA générative, une technologie qui menace de remodeler les industries, de produire d'énormes gains de productivité et de déplacer des millions d'emplois. De plus, il semble que les commandes pour les accélérateurs de Nvidia soient déjà épuisées jusqu'en 2024. Et comme on s'attend à ce que le marché des accélérateurs représente environ 150 milliards de dollars d'ici 2027, il semble qu'il n'y ait rien d'autre que du vert dans l'avenir. La puce H100 est basée sur une nouvelle architecture appelée "Hopper" (du nom de la pionnière américaine de la programmation Grace Hopper).

Et bien sûr, ce boom est meilleur pour certains que pour d'autres. Certains rapports indiquent qu'en raison de l'explosion de l'intérêt pour les serveurs d'IA par rapport aux installations HPC plus traditionnelles, les fabricants de DDR5 ont dû revoir leurs prévisions quant au degré de pénétration du marché par les nouveaux produits de mémoire. On s'attend désormais à ce que l'adoption de la DDR5 n'atteigne la parité avec la DDR4 qu'au troisième trimestre 2024.

Et vous ?

Quel est votre avis sur le sujet ?

Que pensez-vous de la forte demande pour les puces Nvidia H100 ?

Selon vous, jusqu'à quand cette tendance va-t-elle se poursuivre ?

Quels impacts cela pourrait avoir sur Nvidia et l'industrie des puces en général ?

Voir aussi

Les nouvelles GPU NVIDIA pour l'intelligence artificielle seraient jusqu'à 4,5 fois plus rapide que les précédentes, selon NVIDIA

Elon Musk aurait acheté des milliers de GPU pour un projet d'IA générative au sein de Twitter, des critiques suggèrent qu'il souhaitait une "pause" afin de rattraper son retard sur OpenAI

NVIDIA se tourne vers la location de supercalculateurs d'IA à partir du cloud pour diffuser sa nouvelle technologie et facture ce service à 37 000 dollars par mois pour huit puces A100 ou H100

Répondre avec citation

Répondre avec citation

Partager