Un avocat cite des affaires juridiques fictives inventées par ChatGPT, provoquant la fureur du juge et des sanctions potentielles.

ChatGPT avait assuré à l'avocat que ces affaires étaient réelles

Un avocat a utilisé ChatGPT pour générer et citer des affaires fictives dans un mémoire juridique, provoquant la fureur du juge et des sanctions potentielles. Lorsqu’on lui a demandé de fournir des copies des affaires citées, l’avocat s’est tourné à nouveau vers ChatGPT, qui a produit des détails complets sur les affaires inexistantes.

L’avocat en question, Steven A. Schwartz, représentait un homme qui poursuivait la compagnie aérienne Avianca après qu’un chariot de service lui ait heurté le genou lors d’un vol vers l’aéroport Kennedy de New York en 2019. Schwartz a déclaré qu’il n’avait jamais utilisé ChatGPT auparavant et qu’il ne savait pas qu’il inventerait simplement des affaires. En fait, Schwartz a dit qu’il avait même demandé à ChatGPT si les affaires étaient réelles. Le chatbot a insisté sur le fait qu’elles l’étaient.

Le procès a commencé comme tant d'autres : un homme du nom de Roberto Mata a poursuivi la compagnie aérienne Avianca, affirmant qu'il avait été blessé lorsqu'un chariot de service en métal lui avait heurté le genou lors d'un vol vers l'aéroport international Kennedy de New York.

Quand Avianca a demandé à un juge fédéral de Manhattan de rejeter l'affaire, les avocats de Mata se sont opposés avec véhémence, soumettant un mémoire de 10 pages citant plus d'une demi-douzaine de décisions de justice pertinentes. Il y a eu Martinez c. Delta Air Lines, Zicherman c. Korean Air Lines et, bien sûr, Varghese c. China Southern Airlines, avec sa savante discussion sur la loi fédérale et « l'effet de péage de la suspension automatique d'un délai de prescription ».

Il y avait juste un hic : personne (ni les avocats de la compagnie aérienne ni le juge lui-même) n'a pu trouver les décisions ou les citations citées et résumées dans le mémoire.

C'était parce que ChatGPT avait tout inventé.

En fait, ce n’est qu’après que les avocats de la compagnie aérienne ont souligné dans un nouveau mémoire que les affaires n’existaient pas que Schwartz a découvert son erreur (ou, l’erreur de l’ordinateur, selon le point de vue).

L'avocat qui a créé le dossier, Steven A. Schwartz du cabinet Levidow, Levidow & Oberman, s'est exposé au courroux du tribunal jeudi, affirmant dans un affidavit qu'il avait utilisé le programme d'intelligence artificielle pour faire ses recherches juridiques, une source qui s'est révélée peu fiable. Schwartz, qui a pratiqué le droit à New York pendant trois décennies, a déclaré au juge P. Kevin Castel qu'il n'avait aucune intention de tromper le tribunal ou la compagnie aérienne. Schwartz a déclaré qu'il n'avait jamais utilisé ChatGPT et « ignorait donc la possibilité que son contenu puisse être faux ».

Il avait, dit-il au juge Castel, demandé au programme de « vérifier que les cas étaient réels ». Et ChatGPT lui a répondu qu'ils l'étaient.

Schwartz a déclaré qu'il « regrette profondément » de s'être appuyé sur ChatGPT « et qu'il ne le fera jamais à l'avenir sans une vérification absolue de son authenticité ».

Le juge Castel a déclaré dans une ordonnance qu'il avait été confronté à « une circonstance sans précédent », une soumission légale remplie de « fausses décisions judiciaires, avec de fausses citations et de fausses citations internes ». Il a ordonné une audience le 8 juin pour discuter d'éventuelles sanctions.

Une technologie qui invente souvent des faits et des sourcesHey, lawtwitter -

— Mike Dunford (@questauthority) May 27, 2023

Check out the last few entries on this docket. Trust me.

ChatGPT making up citations, notary fraud, this has it all. Oh and an incandescent federal judge.https://t.co/q0lWyPVM7m

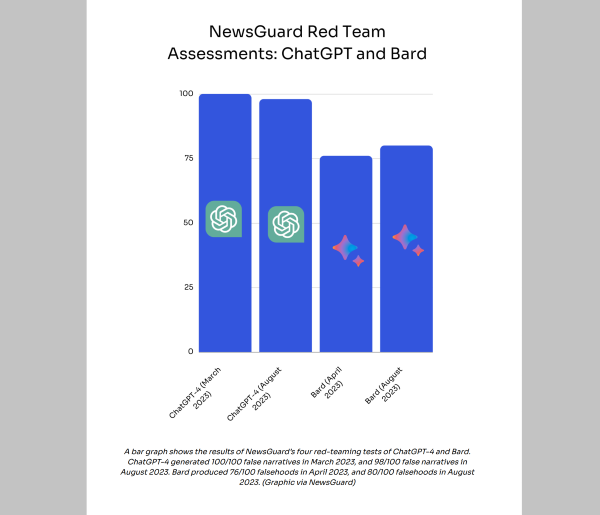

ChatGPT a été lancé à la fin de 2022 et est devenu immédiatement un succès. Le chatbot fait partie d’une famille de nouvelles technologies appelées IA générative qui peuvent tenir des conversations qui sont si organiques et normales que parfois ChatGPT semble avoir une volonté propre. Mais la technologie est notoirement imprécise et invente souvent des faits et des sources pour des faits qui sont complètement faux. Le produit concurrent de Google, Bard, a des problèmes similaires.

Mais rien de tout cela n’a empêché les gens d’utiliser cette technologie expérimentale comme si elle était une source d’information fiable.

Stephen Gillers, professeur d’éthique juridique à la faculté de droit de l’université de New York, a déclaré que le problème était particulièrement aigu chez les avocats, qui débattent de la valeur et des dangers des logiciels d’IA comme ChatGPT, ainsi que de la nécessité de vérifier toute information qu’ils fournissent. Il a ajouté que les avocats devraient être conscients que l’utilisation de ChatGPT pourrait constituer une violation du code de déontologie professionnelle, qui exige que les avocats agissent avec diligence et compétence dans la représentation de leurs clients.

« Si vous utilisez ChatGPT sans vérifier ce qu’il dit, vous êtes irresponsable », a-t-il déclaré. « Et si vous vérifiez ce qu’il dit et que vous découvrez qu’il est faux, vous êtes malhonnête ».

« La discussion actuellement au sein du barreau est de savoir comment éviter exactement ce que cette affaire décrit », a déclaré Gillers. « Vous ne pouvez pas simplement prendre la sortie et la couper et la coller dans vos documents judiciaires ».

Le cas de Roberto Mata c. Avianca Inc. suggère qu'il reste du temps aux professionnels en cols blancs avant que les bots ne soient en mesure de les remplacer.

Comment la supercherie a été découverte

Tout a commencé quand Mata était passager du vol Avianca 670 d'El Salvador à New York le 27 août 2019, lorsqu'un employé de la compagnie aérienne l'a frappé avec le chariot de service, selon la plainte. Après que Mata a intenté une action en justice, la compagnie aérienne a déposé des documents demandant que l'affaire soit rejetée, car le délai de prescription avait expiré.

Dans un mémoire déposé en mars, les avocats de Mata ont déclaré que le procès devrait se poursuivre, renforçant leur argumentation avec des références et des citations des nombreuses décisions de justice qui ont depuis été démystifiées.

Puis, les avocats d'Avianca ont écrit au juge Castel, disant qu'ils étaient incapables de trouver les cas cités dans le mémoire. En ce qui concerne Varghese c. China Southern Airlines, ils ont déclaré qu'ils n'avaient « pas été en mesure de localiser cette affaire par légende ou citation, ni aucune affaire ressemblant à celle-ci ». Ils ont souligné une longue citation de la prétendue décision Varghese contenue dans le mémoire. « Le soussigné n'a pas été en mesure de localiser cette citation, ni quoi que ce soit de semblable en tout cas », ont écrit les avocats d'Avianca. En effet, ont ajouté les avocats, la citation, qui provenait de Varghese lui-même, citait quelque chose appelé Zicherman c. Korean Air Lines Co. Ltd., une opinion prétendument rendue par la Cour d'appel des États-Unis pour le 11e circuit en 2008. Ils ont dit qu'il n'a pas pu le trouver non plus.

Le juge Castel a ordonné aux avocats de Mata de fournir des copies des opinions mentionnées dans leur mémoire. Les avocats ont soumis un recueil de huit ; dans la plupart des cas, ils mentionnaient le tribunal et les juges qui les avaient délivrés, les numéros de rôle et les dates.

La copie de la prétendue décision Varghese, par exemple, fait six pages et indique qu'elle a été écrite par un membre d'un panel de trois juges du 11e circuit. Mais les avocats d'Avianca ont déclaré au juge qu'ils ne pouvaient pas trouver cette opinion ni les autres, dans les registres des tribunaux ou les bases de données juridiques.

Bart Banino, avocat d'Avianca, a déclaré que son cabinet, Condon & Forsyth, était spécialisé dans le droit de l'aviation et que ses avocats pouvaient dire que les cas mentionnés dans le mémoire n'étaient pas réels. Il a ajouté qu'ils avaient une idée qu'un chatbot aurait pu être impliqué.

Conclusion

Cet incident soulève des questions sur les limites éthiques et légales de l’utilisation de l’IA générative dans le domaine juridique. Certains experts affirment que ChatGPT peut être un outil utile pour stimuler la créativité et la productivité des avocats, à condition qu’ils vérifient soigneusement les informations qu’il fournit. D’autres mettent en garde contre les risques de manipulation, de désinformation et de fraude que ChatGPT peut engendrer.

« ChatGPT est une technologie fascinante, mais aussi dangereuse », a déclaré David Ryan Polgar, fondateur du Digital Citizenship Institute, une organisation qui promeut une utilisation responsable de la technologie. « Il faut être très prudent lorsqu’on utilise ChatGPT, car il peut facilement nous induire en erreur ou nous faire dire des choses que nous ne voulons pas dire ».

Polgar a ajouté que les utilisateurs de ChatGPT devraient être transparents sur le fait qu’ils utilisent le programme et qu’ils devraient toujours citer leurs sources. Il a également suggéré que les tribunaux et les universités établissent des règles claires sur l’utilisation acceptable de ChatGPT dans le domaine juridique. « ChatGPT n’est pas un substitut à la pensée critique et à la recherche rigoureuse », a-t-il dit. « C’est un outil qui doit être utilisé avec discernement et éthique ».

Et de conclure en disant que « ChatGPT est une technologie qui a le potentiel de transformer le monde, mais c’est aussi une technologie qui a le potentiel de le détruire. C’est à nous de décider comment nous voulons l’utiliser ».

Sources : Roberto Mata contre Avianca, Times

Et vous ?

Avez-vous déjà utilisé ChatGPT ou une autre IA générative ? Si oui, pour quelles raisons et avec quels résultats ?

Que pensez-vous des avantages et des risques de ChatGPT dans le domaine juridique ? Trouvez-vous que ChatGPT est un outil utile ou dangereux pour les avocats ?

Comment vérifiez-vous la fiabilité et l’authenticité des informations que vous trouvez en ligne ? Quels sont les signes qui vous alertent sur la possibilité qu’une information soit fausse ou inventée par ChatGPT ?

Que pensez-vous des sanctions possibles contre l’avocat qui a utilisé ChatGPT pour citer des affaires fictives ? Trouvez-vous qu’il a agi de manière irresponsable ou malhonnête ?

Comment pensez-vous que ChatGPT va évoluer à l’avenir ? Quelles sont les opportunités et les menaces que ChatGPT représente pour la société ?

Répondre avec citation

Répondre avec citation

de ne pas faire un contresens

de ne pas faire un contresens

Partager