Trolldi : de nouvelles lunettes intelligentes indiquent aux utilisateurs ce qu'il faut dire lors des rendez-vous galants grâce à GPT-4

L’appui d’une IA est-il nécessaire pour être plus humain ?

Une équipe d'étudiants chercheurs de l'université de Stanford a mis au point une paire de lunettes intelligentes capables d'afficher les résultats du modèle de langage GPT-4 d'OpenAI. L’objectif : donner une longueur d'avance aux postulants lors des entretiens d'embauche ou même coacher des gens lors des rendez-vous galants. Le tableau soulève de multiples questions : vers un monde où les gens s’appuieront sur les machines pour être plus humains ? L’intelligence artificielle peut-elle s’avérer utile pour l’atteinte d’un tel objectif ?

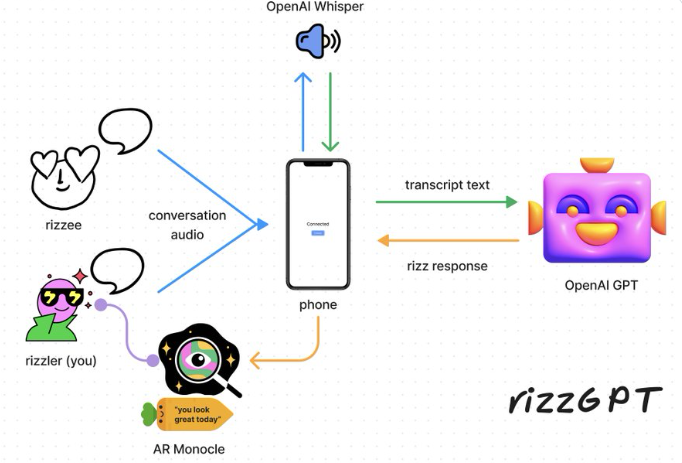

Les lunettes ont été fabriquées à l'aide d'un dispositif ressemblant à un monocle qui peut être fixé sur pratiquement n'importe quelle paire de lunettes, construit et offert par Brilliant Labs. Il comporte une caméra, un microphone et un écran haute résolution qui peut afficher le texte généré par GPT-4. Le logiciel de reconnaissance vocale d'OpenAI, Whisper, permet aux lunettes de transmettre directement la parole au chatbot, qui peut répondre en quelques secondes à son utilisateur.

« L'appareil écoute votre conversation et vous dit exactement ce qu'il faut dire ensuite », explique Bryan Hau-Ping Chiang.

Le tableau donne le sentiment de présence d’un être supérieur qui écoute les conversations et sait souffler à qui s’appuie sur lui les mots nécessaires pour la tenue d’une conversation. Sauf que l’on a affaire à une intelligence artificielle avec tous les débats autour de la technologie. De nombreux acteurs de la filière sont désormais d’avis qu’il s’agit d’outils à prendre avec des pincettes.update: here's how we did it + the codehttps://t.co/Ok2kCH0cFK

— bryan (@bryanhpchiang) March 28, 2023

« Le problème est qu'il fait de bonnes choses pour nous, mais il peut faire d'horribles erreurs en ne sachant pas ce qu'est l'humanité », prévient Steve Wozniak – cofondateur d’Apple – à propos de ChatGPT – l’un des chatbots les plus en vues du moment basé sur GPT-4.

C’est une redite de l’avis de certains enseignants. Ethan Mollick en fait partie et a décidé d’opter pour une politique d’utilisation ouverte du chatbot ChatGPT. La raison : l'utilisation de l'intelligence artificielle est une compétence émergente. Il précise néanmoins au travers de cette dernière que l’intelligence artificielle peut se tromper. Les étudiants doivent donc vérifier les résultats qu’elle leur renvoie à l’aide d’autres et qu'ils seront responsables de toute erreur ou omission fournie par l'outil. De plus, les étudiants doivent faire preuve d’honnêteté intellectuelle en citant leur source (qui s’avère être ChatGPT) comme on le fait lors du montage d’une bibliographie. « Le manquement à cette obligation constitue une violation des politiques d'honnêteté académique », lit-on.

Arvind Narayanan de l’université de Princeton est pour sa part d’avis que ChatGPT n’a rien de révolutionnaire :

« Sayash Kapoor et moi-même l'appelons un générateur de conneries, comme d'autres l'ont aussi fait. Nous n'entendons pas cela dans un sens normatif mais dans un sens relativement précis. Nous voulons dire qu'il est entraîné à produire des textes plausibles. Il est très bon pour être persuasif, mais il n'est pas entraîné à produire des déclarations vraies. Il produit souvent des affirmations vraies comme effet secondaire de sa plausibilité et de sa persuasion, mais ce n'est pas son objectif.

Cela correspond en fait à ce que le philosophe Harry Frankfurt a appelé connerie, c'est-à-dire un discours destiné à persuader sans se soucier de la vérité. Un conteur humain ne se soucie pas de savoir si ce qu'il dit est vrai ou non ; il a certaines fins en tête. Tant qu'il persuade, ces objectifs sont atteints. En fait, c'est ce que fait ChatGPT. Il essaie d'être persuasif et il n'a aucun moyen de savoir avec certitude si les déclarations qu'il fait sont vraies ou non. »

D’ailleurs l’un des chercheurs derrière ces lunettes intelligentes souligne quelles en sont les limites via un regret : « Si seulement GPT-4 avait plus de personnalité. »

Des intervenants de la filière sont néanmoins d’avis que ce n’est qu’une question de temps avant que l’intelligence artificielle générale ne nous tombe dessus. Les machines seraient alors dotées de « bon sens. » Au stade d’intelligence artificielle générale, elles seraient capables de réflexion causale, c’est-à-dire de cette capacité à raisonner sur « le pourquoi les choses se produisent. » C’est ce palier que les équipes de recherche dans le domaine annoncent dans 5 ans. C’est d’ailleurs pour cela que sa société Neuralink travaille sur des interfaces cerveau – machine à insérer dans le crâne. L’objectif : augmenter les capacités cognitives des humains afin qu’ils puissent rivaliser avec les machines au sein de l’hypothétique programme informatique dans lequel nous vivons tous et qui fait de nous tous de potentielles intelligences artificielles.

Source : Bryan Chiang

Et vous ?

Se fier de façon totale à GPT-4 pour savoir quoi dire lors d’une rencontre est-il une bonne ou une mauvaise idée ?

Dans quels cas de figures pensez-vous qu’un tel dispositif puisse être utile ?

Voir aussi :

La conduite autonome serait-elle à ce jour qu'une vision futuriste chez Tesla Motors ? L'entreprise vient de changer les objectifs de son Autopilot

La SEC demande à Musk de renoncer à son poste de président de Tesla et exige une amende de 40 millions $ US pour un règlement à l'amiable

Tesla annonce que le nouvel ordinateur pour une conduite entièrement autonome de ses véhicules est en production et fera ses preuves ce mois-ci

Les actions Tesla chutent après que son système d'autopilote soit impliqué dans un accident et l'annonce des batteries de ses véhicules prenant feu

Répondre avec citation

Répondre avec citation

Partager