OpenAI permettra aux développeurs d'intégrer ChatGPT dans leurs applications via une API,

mais l'outil est-il prêt à être utilisé dans des environnements de production ?

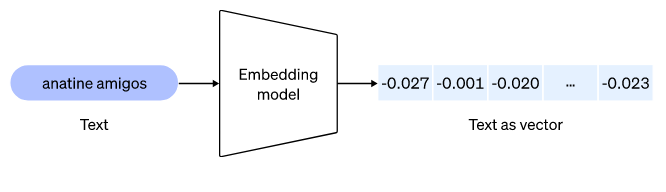

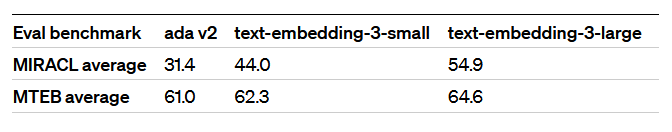

OpenAI a rendu ses modèles ChatGPT et Whisper disponibles sur son API, qui offre aux développeurs un accès aux capacités de langage et de synthèse vocale basées sur l'IA. OpenAI lance un nouveau modèle ChatGPT au prix de 0,002 $ par 1 000 jetons, ce qui le rend dix fois moins cher que les modèles GPT-3.5 existants. En réduisant le coût de ChatGPT de 90%, OpenAI espère permettre à davantage d'entreprises de tirer parti de ses capacités pour développer des applications de nouvelle génération.

Estimer que ChatGPT, l'IA génératrice de texte gratuite développée par la startup OpenAI basée à San Francisco, est un succès est un énorme euphémisme.

En effet, ChatGPT est peut-être devenu l'application à la croissance la plus rapide de l'histoire après avoir atteint 100 millions d'utilisateurs actifs mensuels, ou MAU, fin janvier, selon un rapport du géant bancaire suisse UBS. Le chatbot appartenant à OpenAI a dépassé les 100 millions de MAU un peu plus de deux mois après son lancement – battant confortablement les vitesses de croissance des principales applications comme TikTok et Instagram, selon la note d'UBS.

Il a fallu neuf mois à TikTok pour atteindre le même niveau d'utilisateurs ; Instagram a pris deux ans et demi ; et Spotify n'a amassé que 100 millions de MAU après quatre ans et demi, selon le rapport, citant des données de la société d'analyse de données Similar Web.

« En vingt ans après l'espace Internet, nous ne pouvons pas nous souvenir d'une montée en puissance plus rapide dans une application Internet grand public », ont écrit les analystes d'UBS dans le rapport. À titre de comparaison, l’application chinoise TikTok a passé la barre des 100 millions d’utilisateurs mensuels neuf mois après son lancement. De son côté, Instagram a patienté pendant plus de deux ans avant d’y arriver. Le nombre de MAU sur ChatGPT a presque doublé depuis décembre, alors qu'il comptait environ 57 millions, selon le rapport. De plus, l'application comptait en moyenne 13 millions de visiteurs uniques quotidiens par jour à la fin du mois de janvier, contre environ six millions de vues uniques quotidiennes le mois précédent.

« Nous ne pouvons pas nous souvenir d'une mise à l'échelle d'une application à ce rythme », ont ajouté les analystes d'UBS dans le rapport.

Selon des informations provenant du service lui-même, après son lancement en novembre 2022, l'assistant virtuel ChatGPT a attiré un million d'utilisateurs en seulement cinq jours. Ce robot conversationnel basé sur l'intelligence artificielle peut produire des textes semblables à ceux écrits par des humains. Il est utilisé pour toutes sortes d'usages : rédaction d'articles, de poèmes ou de travaux universitaires, mais également la traduction, l'écriture de code informatique et la résolution d'équation mathématique. Selon le fondateur de Microsoft, Bill Gates, les logiciels d'IA comme ChatGPT représentent le plus grand changement technologique à venir et pourraient remplacer dans un futur proche de nombreux emplois. Microsoft a confirmé hier un investissement de plusieurs millions de dollars dans la société américaine OpenAI, qui développe ChatGPT.

D'autres services en ligne populaires ont généralement mis plusieurs mois (voire années) à atteindre le seuil du million d'utilisateurs. Spotify et Dropbox ont atteint ce cap relativement rapidement, respectivement en cinq et sept mois, car il s'agit de plateformes qui, comme ChatGPT, offrent une utilisation pratique immédiate. À l'exception d'Instagram, qui a attiré un million d'utilisateurs en deux mois et demi, les autres réseaux sociaux (Facebook, Twitter) ont mis plus de temps à atteindre ce seuil. Cependant, la plupart les services présentés dans notre graphique ont été créés il y a plus de quinze ans, ce qui met en lumière une autre évolution que l'on peut déduire de ces données. Avec la digitalisation croissante de l'économie, les innovations tendent à se diffuser plus rapidement dans la population.

Temps qu'il a fallu à certains services/plateformes en ligne pour atteindre 1 million d'utilisateurs

Mais OpenAI, étant une entreprise (bien qu'à but non lucratif), devait monétiser ChatGPT d'une manière ou d'une autre, de peur que les investisseurs ne deviennent nerveux. Il a fait un pas dans cette direction avec le lancement d'un service premium, ChatGPT Plus, en février.

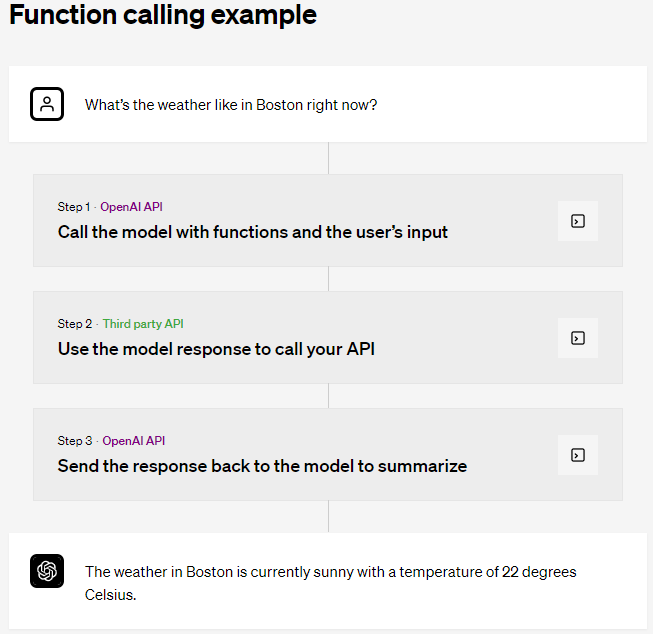

Cette fois-ci, OpenAI a fait un grand pas en avant en introduisant une API qui permettra à toute entreprise d'intégrer la technologie ChatGPT dans ses applications, sites Web, produits et services.

Les API ChatGPT et Whisper

OpenAI a annoncé que les API de ses modèles ChatGPT et Whisper sont désormais disponibles, offrant aux développeurs un accès aux capacités de langage et de synthèse vocale basées sur l'IA. Grâce à des optimisations à l'échelle du système, OpenAI a réussi à réduire le coût de ChatGPT de 90% depuis décembre, et répercute désormais ces économies sur les utilisateurs de l'API.

OpenAI pense que la meilleure façon de réaliser le plein potentiel de l'IA est de permettre à chacun de construire avec elle.

OpenAI a également modifié ses conditions de service pour permettre aux développeurs de refuser d'utiliser leurs données à des fins d'amélioration tout en ajoutant une politique de conservation des données de 30 jours.Envoyé par OpenAI

API de Whisper

OpenAI a introduit Whisper, un modèle de synthèse vocale, en tant qu'API open source en septembre 2022. L'API Whisper a suscité des éloges considérables de la part de la communauté des développeurs. Cependant, son fonctionnement peut être difficile.

OpenAI rend le modèle large-v2 disponible via son API, offrant aux développeurs un accès pratique à la demande, au prix de 0,006 $ par minute.

De plus, la pile de service d'OpenAI garantit des performances plus rapides par rapport aux autres services. L'API Whisper est accessible via des transcriptions ou des points de terminaison de traduction, qui peuvent transcrire ou traduire la langue source en anglais.

Instances dédiées

OpenAI propose désormais des instances dédiées aux utilisateurs qui souhaitent davantage de contrôle sur les versions de leurs modèles et les performances du système. Par défaut, les demandes sont traitées sur une infrastructure de calcul partagée et les utilisateurs paient par demande.

Cependant, avec les instances dédiées, les développeurs paient une période de temps pour allouer l'infrastructure de calcul réservée exclusivement à leurs requêtes. Les développeurs ont un contrôle total sur la charge de l'instance, la possibilité d'activer des limites de contexte plus longues et la possibilité d'épingler l'instantané du modèle.

Les instances dédiées peuvent être rentables pour les développeurs qui traitent au-delà d'environ 450 millions de jetons par jour.

Snap, Quizlet, Instacart parmi les premiers utilisateurs

Une API proposée aux développeurs a toujours été envisagée, selon Greg Brockman, président et PCA d'OpenAI (et également l'un des cofondateurs). Il a expliqué « Il nous faut un certain temps pour amener ces API à un certain niveau de qualité ».

Brockman explique que l'API ChatGPT est alimentée par le même modèle d'IA derrière le très populaire ChatGPT d'OpenAI, surnommé "gpt-3.5-turbo". GPT-3.5 est le modèle de génération de texte le plus puissant qu'OpenAI propose aujourd'hui via sa suite d'API ; le surnom "turbo" fait référence à une version optimisée et plus réactive de GPT-3.5 qu'OpenAI a discrètement testé pour ChatGPT.

Au prix de 0,002 $ pour 1 000 jetons, soit environ 750 mots, Brockman affirme que l'API peut piloter une gamme d'expériences, y compris des applications "sans chat". Snap, Quizlet, Instacart et Shopify font partie des premiers utilisateurs.

La motivation initiale derrière le développement de gpt-3.5-turbo aurait pu être de réduire les coûts de calcul gargantuesques de ChatGPT. Le PDG d'OpenAI, Sam Altman, a un jour qualifié les dépenses de ChatGPT « d'exaspérantes », les estimant à quelques centimes par chat en coûts de calcul. (Avec plus d'un million d'utilisateurs, cela s'additionne probablement rapidement.)

Mais Brockman explique que gpt-3.5-turbo est amélioré d'autres manières.

« Si vous construisez un tuteur alimenté par l'IA, vous ne voulez jamais que le tuteur donne simplement une réponse à l'élève. Vous voulez qu'il l'explique toujours et les aide à apprendre - c'est un exemple du type de système que vous devriez pouvoir construire [avec l'API] », a déclaré Brockman. « Nous pensons que cela va simplement rendre l'API beaucoup plus utilisable et accessible ».

L'API ChatGPT sous-tend My AI, le chatbot récemment annoncé par Snap pour les abonnés Snapchat+, et la nouvelle fonctionnalité de tuteur virtuel Q-Chat de Quizlet. Shopify a utilisé l'API ChatGPT pour créer un assistant personnalisé pour les recommandations d'achat, tandis qu'Instacart en a profité pour créer Ask Instacart, un péage à venir qui permettra aux clients d'Instacart de poser des questions sur la nourriture et d'obtenir des réponses « achetables » s'appuyant sur les données produit du commerce de détail fournies par les partenaires de l'entreprise. Une vidéo démo de la façon dont ces entreprises se servent / peuvent se servir de ChatGPT est disponible sur le site d'OpenAI.

Du côté d'Instacart par exemple, le produit qui embarque ChatGPT n'est pas encore livré au public. La société explique :

« L'épicerie peut nécessiter une charge mentale importante, avec de nombreux facteurs en jeu, tels que le budget, la santé et la nutrition, les goûts personnels, la saisonnalité, les compétences culinaires, le temps de préparation et l'inspiration des recettes », a expliqué l'architecte en chef d'Instacart, JJ Zhuang. « Si l'IA pouvait assumer cette charge mentale, nous pourrions alors aider les chefs de famille - qui sont généralement responsables de l'épicerie, de la planification des repas et de la mise de la nourriture sur la table – et rendre l'épicerie vraiment amusante. Le système d'intelligence artificielle d'Instacart, lorsqu'il va s'appuyer sur ChatGPT d'OpenAI, permettra de faire exactement cela, et nous sommes ravis de commencer à expérimenter ce qui est possible dans l'application Instacart ».Instacart améliore l'application Instacart pour permettre aux clients de poser des questions sur la nourriture et d'obtenir des réponses inspirantes et achetables. Elle utilise ChatGPT aux côtés de la propre IA d'Instacart et des données de produits de leurs plus de 75 000 magasins partenaires pour aider les clients à découvrir des idées d'objectifs d'achat ouverts, tels que « Comment puis-je faire de bons tacos au poisson ? » ou « Qu'est-ce qu'un déjeuner sain pour mes enfants ? ». Instacart prévoit de lancer « Ask Instacart » plus tard cette année.

Mais ChatGPT est-il prêt à être utilisé dans des environnements de production ?

Ceux qui ont suivi de près la saga ChatGPT, cependant, pourraient se demander si l'outil est prêt pour une utilisation en environnement de production.

Dès le début, les utilisateurs ont pu inciter ChatGPT à répondre aux questions de manière raciste et sexiste, ce qui reflète les données biaisées sur lesquelles ChatGPT a été initialement formé. Les données de formation de ChatGPT comprennent un large éventail de contenus Internet, à savoir des livres électroniques, des publications sur les forums et des articles de Wikipédia. ChatGPT invente également des faits sans indiquer qu'il le fait, un phénomène de l'IA connu sous le nom d'hallucination.

ChatGPT, ainsi que les systèmes similaires, est également sensible aux attaques basées sur les invites, ou aux invites malveillantes qui le conduisent à effectuer des tâches qui ne faisaient pas partie de ses objectifs initiaux. Nous penserons par exemple à cet étudiant allemand dont voici l'histoire :

Les marques, sans aucun doute, ne voudraient pas faire face à ces situations. Brockman est catégorique, elles ne le seront pas. Pourquoi donc ? L'une des raisons, dit-il, est la poursuite des améliorations à l'arrière. Mais Brockman a mis l'accent sur une nouvelle approche (et résolument moins controversée) qu'OpenAI appelle Chat Markup Language, ou ChatML. ChatML envoie du texte à l'API ChatGPT sous la forme d'une séquence de messages avec des métadonnées. C'est par opposition au ChatGPT standard, qui consomme du texte brut représenté par une série de jetons. (Le mot "fantastique" serait divisé en jetons "fan", "tas" et "tique", par exemple.)

Par exemple, étant donné l'invite « Quelles sont les idées de fête intéressantes pour mon 30e anniversaire ? », un développeur peut choisir d'ajouter à cette invite une invite supplémentaire telle que « Vous êtes un chatbot conversationnel amusant conçu pour aider les utilisateurs à répondre aux questions qu'ils posent. Vous devriez répondre honnêtement et de manière amusante ! » ou « Vous êtes un bot » avant que l'API ChatGPT ne le traite. Ces instructions aident à mieux adapter - et filtrer - les réponses du modèle ChatGPT, selon Brockman.

"Nous passons à une API de niveau supérieur. Si vous avez une manière plus structurée de représenter l'entrée dans le système, où vous dites "cela vient du développeur" ou "cela vient de l'utilisateur"… Je devrais m'attendre à ce qu'en tant que développeur, vous puissiez être plus robuste [ en utilisant ChatML] contre ce genre d'attaques rapides », a déclaré Brockman.

Un autre changement qui empêchera (espérons-le) le comportement involontaire de ChatGPT est la mise à jour plus fréquente des modèles. Avec la sortie de gpt-3.5-turbo, les développeurs seront automatiquement mis à niveau par défaut vers le dernier modèle stable d'OpenAI, a déclaré Brockman, en commençant par gpt-3.5-turbo-0301 (publié hier le 1er mars). Les développeurs auront la possibilité de rester avec un modèle plus ancien s'ils le souhaitent, ce qui pourrait quelque peu annuler l'avantage.

Qu'ils choisissent ou non de mettre à jour le modèle le plus récent, Brockman note que certains clients (principalement de grandes entreprises avec des budgets conséquents) auront un contrôle plus approfondi sur les performances du système avec l'introduction de plans de capacité dédiés. En plus du « contrôle total » sur la charge de l'instance (normalement, les appels à l'API OpenAI se produisent sur des ressources de calcul partagées) la capacité dédiée donne aux clients la possibilité d'activer des fonctionnalités telles que des limites de contexte plus longues. Les limites de contexte font référence au texte que le modèle considère avant de générer du texte supplémentaire ; des limites de contexte plus longues permettent au modèle de « mémoriser » essentiellement plus de texte. Bien que des limites de contexte plus élevées ne résolvent pas tous les problèmes de biais et de toxicité, elles pourraient conduire des modèles comme gpt-3.5-turbo à moins halluciner.

Source : OpenAI

Et vous ?

Que pensez-vous des API ChatGPT et Whisper ?

Selon vous, l'API de ChatGPT peut-elle déjà être utilisée en production ? Pourquoi ?

Répondre avec citation

Répondre avec citation

Partager