Bonjour,

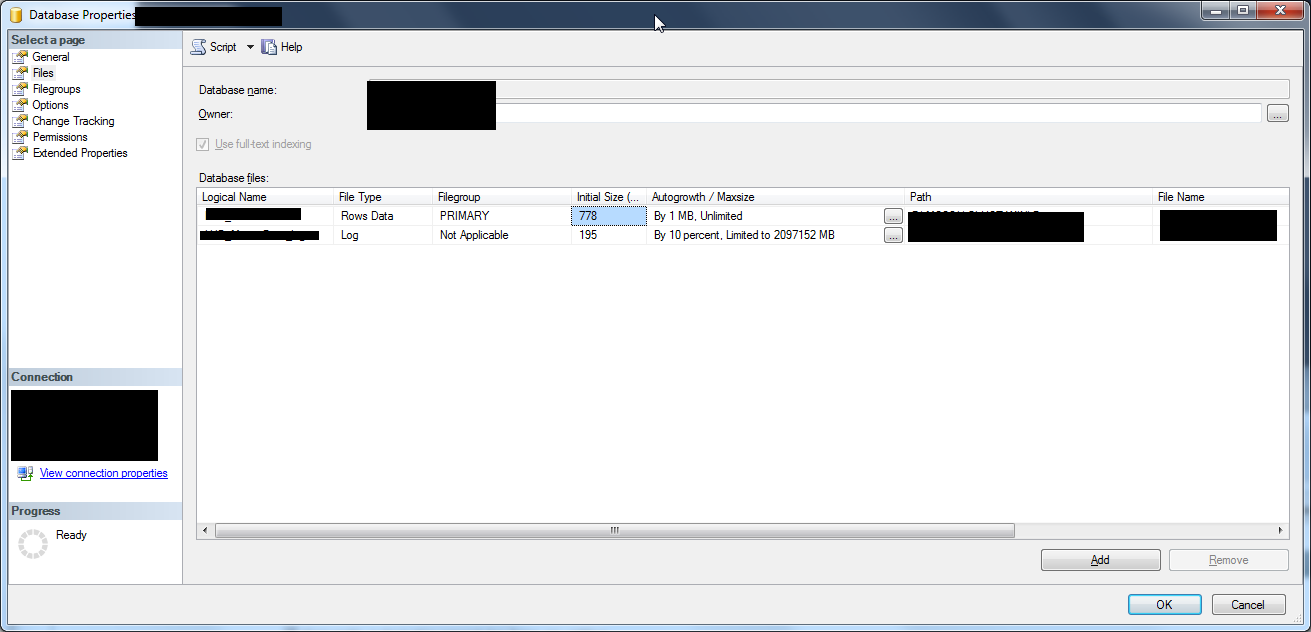

J'ai une base qui fait 45Go quand j’exécute la requête suivante:

Taille des fichiers:

Code : Sélectionner tout - Visualiser dans une fenêtre à part

2

3

- Base: 30Go

- Log: 16Go

Dans cette base j'ai fait une grande purge des enregistrements, via l'application qui exploite cette base

Cette nuit les backups de la base ainsi que des logs se sont fait.

Ce matin quand je vérifie les tailles, rien n'a bouger...même pas d'un KO...

Il y a juste "unallocated space" qui est passé de 8728 MB à 11928 MB

Que dois-je faire pour réduire la taille de ma base et des fichiers?

On m'as toujours dit qu'un shrink était déconseillé?

Merci d'avance

Répondre avec citation

Répondre avec citation

Partager