Microsoft présente le grand modèle de langage multimodal Kosmos-1,

Les chercheurs montrent que le passage des LLM aux MLLM offre de nouvelles capacités

Suite aux récents développements des grands modèles de langage utilisant Transformers, un mécanisme basé sur l'attention développé par Google en 2017, Microsoft a publié son document de recherche, intitulé Language Is Not All You Need: Aligning Perception with Language Models. Le modèle présente un grand modèle de langage multimodal (MLLM) appelé Kosmos-1. L'article souligne l'importance d'intégrer le langage, l'action, la perception multimodale et la modélisation du monde pour progresser vers l'intelligence artificielle. La recherche explore Kosmos-1 dans différents contextes.

Le modèle montre des capacités prometteuses sur diverses tâches de génération en percevant des modalités générales telles que le NLP sans OCR, l'AQ visuelle, et les tâches de perception et de vision. L'équipe de recherche de Microsoft a également présenté le modèle à un ensemble de données du test de QI de Raven pour analyser et diagnostiquer les capacités de raisonnement non verbal des MLLM. « Les limites de ma langue signifient les limites de mon monde », Ludwig Wittgenstein.

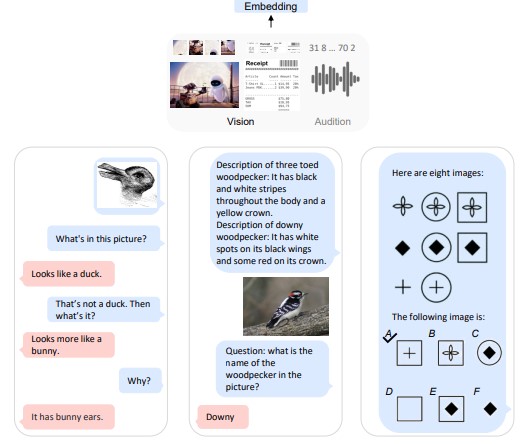

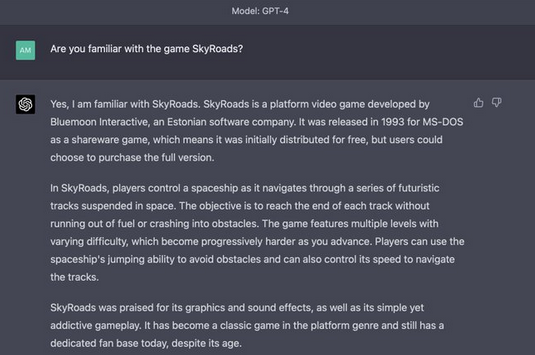

figure 1 : KOSMOS-1 est un grand modèle de langage multimodal (MLLM) capable de percevoir des entrées multimodales, de suivre des instructions et d'effectuer un apprentissage en contexte, non seulement pour le langage, mais aussi pour l'environnement. Dans ce travail, Microsoft aligne la vision sur les grands modèles de langage (LLM), en faisant progresser la tendance à passer des LLM aux MLLM.

Une grande convergence du langage, de la perception multimodale, de l'action et de la modélisation du monde est une étape clé vers l'intelligence artificielle. Dans ce travail, Microsoft introduit KOSMOS-12 un grand modèle de langage multimodal (MLLM) capable de percevoir des modalités générales, apprendre en contexte et suivre des instructions.

Plus précisément, elle entraîne KOSMOS-1 à partir de zéro sur des corpus multimodaux à l'échelle du Web, comprenant du texte et des images arbitrairement entrelacées, des paires image-titre et des données textuelles. L’incitation multimodale à la chaîne de pensée, sur une large gamme de tâches, sans mise à jour du gradient ni réglage fin.

- La compréhension et la génération du langage, et même le traitement automatique des langues sans reconnaissance optique de caractères (directement alimenté par des images de documents) langage de perception, y compris le dialogue multimodal, le sous-titrage d'images, la réponse à des questions visuelles ;

- Les tâches de vision, telles que la reconnaissance d'images avec descriptions (spécifiant classification via des instructions textuelles). Nous montrons également que les MLLMs peuvent bénéficier de transfert cross-modal, c'est-à-dire le transfert de connaissances du langage au multimodal, et du multimodal au langage.

Des LLMs aux MLLMs

Les grands modèles de langage (LLM) ont servi avec succès d'interface polyvalente pour diverses tâches de langage naturel [BMR+20]. L'interface basée sur les LLM peut être adaptée à une tâche tant que nous sommes capables de transformer l'entrée et la sortie en textes. Par exemple, l'entrée du résumé est un document et la sortie est son résumé. Les chercheurs peuvent donc introduire le document d'entrée dans le modèle de langage, puis produire le résumé généré.

Malgré le succès des applications du traitement du langage naturel, il est encore difficile d'utiliser nativement les MLL pour les données multimodales, telles que les images et l'audio. La perception multimodale est un élément fondamental de l'intelligence. Elle est une nécessité pour atteindre l'intelligence artificielle générale, en termes d'acquisition de connaissances et d'ancrage dans le monde réel. Plus important encore, le déblocage de l'entrée multimodale [TMC+21, HSD+22, WBD+22, ADL+22, AHR+22, LLSH23] élargit considérablement les applications des modèles de langage à des domaines à plus forte valeur ajoutée, tels que l'apprentissage automatique multimodal, l'intelligence documentaire et la robotique.

Dans ce travail, Microsoft présente KOSMOS-1, un grand modèle de langage multimodal (MLLM) qui peut percevoir des modalités générales, suivre des instructions (c.-à-d., apprentissage à zéro coup) et apprendre en contexte (c.-à-d., apprentissage à quelques coups). L'objectif est d'aligner la perception avec les MLLMs, de sorte que les modèles soient capables de voir et de parler. Pour être plus précis, nous suivons METALM [HSD+22] pour former le modèle KOSMOS-1 à partir de zéro.

Comme le montre la figure 1, un modèle de langage basé sur Transformerest considéré comme l'interface générale, et les modules de perception sont reliés au modèle de langage. Les chercheurs entraînent le modèle sur des corpus multimodaux à l'échelle du Web, c'est-à-dire des données textuelles, des images et des textes arbitrairement entrelacés, et des paires image-titre. De plus, ils calibrent la capacité de suivi des instructions à travers les modalités en transférant des données uniquement linguistiques.

Le modèle KOSMOS-1 supporte nativement les tâches de langage, de perception-langage et de vision. En plus de diverses tâches de langage naturel, les modèles KOSMOS-1 gèrent nativement un large éventail de tâches à forte intensité de perception, couvrant le dialogue visuel, l'explication visuelle, la réponse à des questions visuelles, le sous-titrage d'images, les équations mathématiques simples, l'OCR et la classification d'images avec descriptions.

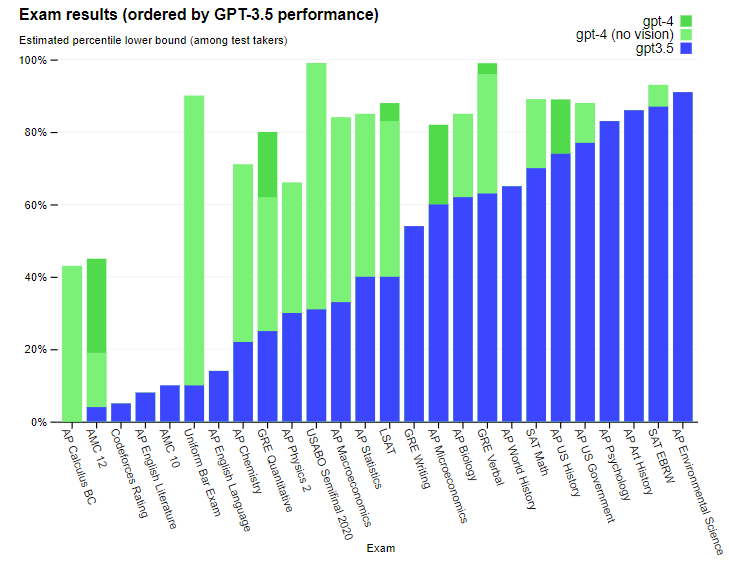

Un test de QI de référence suivant les matrices progressives de Raven [JR03, CJS90], qui évalue la capacité de raisonnement non verbal des MLLMs. Ces exemples montrent que le support natif de la perception multimodale offre de nouvelles opportunités pour appliquer les MLLMs à de nouvelles tâches. En outre, Microsoft montre que les MLLMs obtiennent de meilleures performances de raisonnement sensé par rapport aux LLMs, ce qui indique que le transfert multimodal facilite l'acquisition de connaissances.

Les principaux points à retenir sont les suivants :

Des LLMs aux MLLMs. Traiter correctement la perception est une étape nécessaire vers l'intelligence générale artificielle. La capacité de percevoir des données multimodales est essentielle pour les LLM. Premièrement, la perception multimodale permet aux MLLM d'acquérir des connaissances de bon sens au-delà des descriptions textuelles. Deuxièmement, l'alignement de la perception avec les LLM ouvre la porte à de nouvelles tâches, telles que la robotique et l'intelligence documentaire. Troisièmement, la capacité de perception unifie diverses API, car les interfaces graphiques sont le moyen le plus naturel et le plus unifié d'interagir avec les utilisateurs.

Les interfaces graphiques sont le moyen le plus naturel et le plus unifié d'interagir. Par exemple, les MLLM peuvent lire directement l'écran ou extraire les chiffres. Microsoft entraîne les modèles KOSMOS-1 sur des corpus multimodaux à l'échelle du Web, ce qui garantit que le modèle apprend de manière robuste à partir de diverses sources. Microsoft utilise non seulement un corpus de texte à grande échelle, et exploite également des paires de légendes d'images de haute qualité et des documents d'images et de textes arbitrairement entrelacés sur le Web.

Les modèles linguistiques en tant qu'interfaces à usage général : suivant la philosophie proposée dans METALM [HSD+22], Microsoft considère les modèles de langage comme une couche de tâches universelle. Grâce à l'espace de sortie ouvert, Microsoft est en mesure d'unifier diverses prédictions de tâches sous forme de textes. De plus, les instructions en langage naturel et les séquences d'action (comme le langage de programmation) peuvent être bien traitées par les modèles de langage. Les LLM servent aussi de raisonneurs de base [WWS+22], ce qui est complémentaire aux modules de perception pour les tâches complexes. Il est donc naturel d'aligner la perception du monde, de l'action et de la multimodalité avec l'interface polyvalente, c'est-à-dire avec les modules de perception.

Nouvelles capacités des MLLMs : en dehors des capacités trouvées dans les précédents LLMs [BMR+20, CND+22], les MLLMs permettent de nouvelles utilisations et possibilités. Tout d'abord, nous pouvons effectuer un apprentissage multimodal à zéro et à quelques reprises en utilisant des instructions en langage naturel et des exemples de démonstration. Deuxièmement, des signaux prometteurs de raisonnement non verbal en évaluant le test Raven IQ sont observés, qui mesure la capacité de raisonnement fluide des humains. Troisièmement, les MLLMs supportent naturellement les interactions multi-tours pour des modalités générales, telles que le dialogue multimodal.

Dans ce travail, Microsoft présente KOSMOS-1, un grand modèle de langage multimodal qui peut percevoir des modalités générales, suivre des instructions et effectuer un apprentissage en contexte.

Les modèles formés à l'échelle du Web obtiennent des résultats prometteurs dans un large éventail de tâches linguistiques et multimodales. Les chercheurs de Microsoft montrent que le passage des LLM aux MLLM offre de nouvelles capacités et opportunités et prevoit de faire évoluer KOSMOS-1 en termes de taille de modèle [MWH+22, WMH+22, CDH+22], et intégrer la capacité de parole [WCW+23] dans KOSMOS-1.

En outre, KOSMOS-1 peut être utilisé comme une interface unifiée pour l'apprentissage multimodal, par exemple en permettant l'utilisation d'instructions et d'exemples pour contrôler la génération de texte en image.

Source : Microsoft

Et vous ?

Microsoft et OpenAI pourraient rendre la formation de grands réseaux neuronaux moins coûteuse, le coût du réglage à l'aide de µTransfer représente 7 % de ce qu'il en coûterait pour préformer GPT-3

Microsoft crée un autocompléteur de code à l'aide de GPT-3, le système de génération de texte d'OpenAI, pour combler le manque de développeurs dans le monde

Répondre avec citation

Répondre avec citation

Partager