NVIDIA acquiert Run:ai, fournisseur de logiciels d'orchestration GPU, pour 700 millions de dollars, affirmant ainsi sa position dominante dans le domaine de l'IA, avec Run:ai, Nvidia veut gérer vos kubes d'IA

NVIDIA acquiert Run:ai, fournisseur de logiciels d'orchestration GPU. La startup israélienne favorise l'utilisation efficace des ressources des clusters pour les charges de travail d'IA à travers une infrastructure de calcul accéléré partagée.

Run:ai a développé une couche logicielle d'orchestration et de virtualisation adaptée aux besoins uniques des charges de travail d'IA fonctionnant sur des GPU et des chipsets similaires. La plateforme de conteneurs de Run:ai basée sur Kubernetes pour les cloud d'IA met en commun et partage efficacement les GPU en attribuant automatiquement la quantité nécessaire de puissance de calcul - de fractions de GPU, à plusieurs GPU, à plusieurs nœuds de GPU.

NVIDIA a annoncé l'acquisition du fournisseur d'orchestration Kubernetes centré sur l'IA Run:ai dans le but d'aider à renforcer l'efficacité des clusters de calcul construits sur GPU. Les détails de l'opération n'ont pas été divulgués, mais il semblerait que l'opération soit évaluée à environ 700 millions de dollars. La startup basée à Tel Aviv a apparemment levé 118 millions de dollars à travers quatre tours de financement depuis sa fondation en 2018.

Selon NVIDIA, la plateforme Run:ai prend déjà en charge ses plateformes de calcul DGX, y compris ses configurations Superpod, le système de gestion de cluster Base Command, la bibliothèque de conteneurs NGC et une suite AI Enterprise. En ce qui concerne l'IA, Kubernetes présente un certain nombre d'avantages par rapport aux déploiements bare metal, car l'environnement peut être configuré pour gérer la mise à l'échelle de plusieurs ressources, potentiellement distribuées géographiquement.

Pour l'instant, les clients existants de Run:ai n'ont pas à craindre que NVIDIA impose des changements majeurs à la plateforme. Dans un communiqué, NVIDIA a déclaré qu'elle continuerait à proposer les produits Run:ai selon le même modèle commercial, dans un avenir immédiat - quoi que cela puisse signifier. En attendant, les personnes abonnées au DGX Cloud de NVIDIA auront accès à l'ensemble des fonctionnalités de Run:ai pour leurs charges de travail d'IA, y compris les déploiements de grands modèles de langage (LLM).

Cette annonce intervient un peu plus d'un mois après que le géant des GPU a dévoilé une nouvelle plateforme de conteneurs pour la construction de modèles d'IA, appelée NVIDIA Inference Microservices (NIM). Les NIMS sont essentiellement des images de conteneurs préconfigurées et optimisées contenant le modèle, qu'il s'agisse de la version open source ou propriétaire, avec toutes les dépendances nécessaires pour le faire fonctionner. Comme la plupart des conteneurs, les NIM peuvent être déployés à travers une variété de temps d'exécution, y compris les nœuds Kubernetes accélérés par CUDA.

L'idée derrière la transformation des LLM et autres modèles d'IA en microservices est qu'ils peuvent être mis en réseau et utilisés pour construire des modèles d'IA plus complexes et plus riches en fonctionnalités que ce qui serait possible sans former soi-même un modèle dédié, ou du moins c'est ainsi que NVIDIA envisage de les utiliser. Avec l'acquisition de Run:ai, NVIDIA dispose désormais d'une couche d'orchestration Kubernetes pour gérer le déploiement de ces NIM dans son infrastructure GPU.

Une seule structure pour accéder aux GPU

Run:ai aide les entreprises à gérer et à optimiser leur infrastructure informatique, que ce soit dans le cloud, sur site ou dans un scénario hybride. Sa couche logicielle d'orchestration et de virtualisation est adaptée aux charges de travail d'IA s'exécutant sur des GPU et d'autres chipsets.

La plateforme de Run:ai fournit une interface utilisateur centrale et un plan de contrôle pour travailler avec une variété de variantes populaires de Kubernetes. Cela la rend un peu comme OpenShift de RedHat ou Rancher de SUSE, et elle dispose d'un grand nombre des mêmes outils pour gérer des choses comme les espaces de noms, les profils d'utilisateurs et les allocations de ressources.

La principale différence réside dans le fait que Run:ai est conçu pour s'intégrer avec des outils et des frameworks d'IA tiers, et pour gérer des environnements de conteneurs accélérés par le GPU. Son portefeuille de logiciels comprend des éléments tels que la planification des charges de travail et le partitionnement des accélérateurs, ce dernier permettant de répartir plusieurs charges de travail sur un seul GPU.

L'interface centralisée de l'entreprise permet aux utilisateurs de gérer l'infrastructure de calcul partagée. Les développeurs peuvent mettre en commun les GPU et partager la puissance de calcul pour diverses tâches - il peut s'agir de "fractions de GPU" ou de plusieurs GPU ou nœuds de GPU fonctionnant sur différents clusters, selon Alexis Bjorlin, vice-président et directeur général de NVIDIA DGX Cloud. Les clients bénéficient d'une meilleure utilisation des ressources des clusters de GPU, d'une meilleure gestion de l'infrastructure et d'une plus grande flexibilité.

"Vous pouvez gérer les clusters de manière très efficace afin d'extraire de la valeur de vos investissements matériels", a déclaré Rona Segev, cofondateur et associé directeur de TLV Partners, l'investisseur de Ran:ai. Lorsque les entreprises utilisent de grandes grappes d'ordinateurs, "il est indispensable de disposer d'un type de virtualisation et d'une couche de gestion", a-t-elle déclaré. Run:ai peut "diviser les GPU en morceaux" et "les allouer dynamiquement", ajoute Segev, et peut également combiner et gérer tous les flux de travail et de données.

Investir en amont et en aval

Il ne se passe pas un jour sans que NVIDIA, dont la valeur est estimée à 2,2 billions de dollars, ne fasse parler d'elle, et cette année marque plus d'une douzaine d'acquisitions par la société. Notamment, elle a payé 6,9 milliards de dollars pour la société de calcul haute performance Mellanox en 2019, et a également ramassé OmniML pour les charges de travail d'IA en périphérie, SwiftStack pour le stockage et la gestion des données et Excelero pour le stockage en bloc. Elle a réalisé de nombreux autres investissements dans le matériel, les logiciels, les plateformes de gestion des centres de données, la robotique, l'analyse de la sécurité et les capacités mobiles.

Les régulateurs ont parfois pris conscience de cette frénésie de dépenses : La tentative d'achat du concepteur de puces britannique Arm pour 40 milliards de dollars a été interrompue début 2022 en raison de "défis réglementaires importants", notamment en ce qui concerne l'étouffement de la concurrence. on estime que NVIDIA contrôle 80 % du marché des puces haut de gamme et a récemment annoncé son intention de créer une nouvelle unité commerciale chargée de concevoir des puces pour les entreprises d'informatique cloud.

En outre, l'entreprise a des partenariats bien établis avec tous les grands acteurs de l'IA et de l'informatique cloud - même si, dans le même temps, elle est en concurrence avec certains d'entre eux - notamment OpenAI, Meta, Microsoft, Google, Amazon et d'autres. L'entreprise continue d'annoncer régulièrement de nouvelles innovations, dont récemment un "gros, gros GPU" qui "repousse les limites de la physique" et un projet d'IA multimodale, le GR00T.

De nombreux observateurs de l'industrie ont réagi aujourd'hui à la nouvelle en soulignant l'omniprésence de l'entreprise.

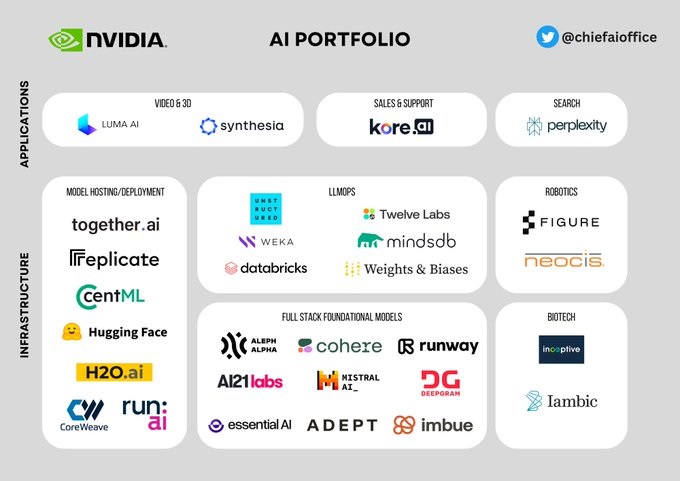

"L'intégration de Run:AI dans le DGX Cloud de NVIDIA permet de démontrer que NVIDIA intègre verticalement sa plateforme, des puces à l'inférence, ce qui en fait ostensiblement un guichet unique pour vos besoins en matière d'IA", a déclaré un utilisateur de Twitter. Un autre a partagé un graphique des investissements de NVIDIA au cours des quatre dernières années, commentant que la société cherche à "capitaliser sur son élan actuel pour étendre son écosystème et sécuriser les flux de revenus futurs. Les startups (clients) dépendent de ses GPU et la croissance de NVIDIA dépend de ces startups."

Voici l'annonce de NVIDIA sur l'acquisition de Run:ai :

Source : Annonce de NVIDIAPour aider les clients à utiliser plus efficacement leurs ressources informatiques d'IA, NVIDIA annonce aujourd'hui avoir conclu un accord définitif pour acquérir Run:ai, un fournisseur de logiciels d'orchestration et de gestion des charges de travail basé sur Kubernetes. Les déploiements d'IA des clients deviennent de plus en plus complexes, avec des charges de travail réparties dans le cloud, la périphérie et l'infrastructure du centre de données sur site. La gestion et l'orchestration de l'IA générative, des systèmes de recommandation, des moteurs de recherche et d'autres charges de travail nécessitent une planification sophistiquée pour optimiser les performances au niveau du système et de l'infrastructure sous-jacente.

Run:ai permet aux entreprises clientes de gérer et d'optimiser leur infrastructure de calcul, que ce soit sur site, dans le cloud ou dans des environnements hybrides. L'entreprise a construit une plateforme ouverte sur Kubernetes, la couche d'orchestration pour l'IA moderne et l'infrastructure cloud. Elle prend en charge toutes les variantes populaires de Kubernetes et s'intègre avec des outils et des frameworks d'IA tiers. Run:ai compte parmi ses clients certaines des plus grandes entreprises mondiales dans de multiples secteurs, qui utilisent la plateforme Run:ai pour gérer des clusters de GPU à l'échelle d'un centre de données.

"Run:ai collabore étroitement avec NVIDIA depuis 2020 et nous partageons la même passion pour aider nos clients à tirer le meilleur parti de leur infrastructure", a déclaré Omri Geller, cofondateur et CEO de Run:ai. "Nous sommes ravis de rejoindre NVIDIA et nous sommes impatients de poursuivre notre voyage ensemble."

La plate-forme Run:ai fournit aux développeurs d'IA et à leurs équipes :

- Une interface centralisée pour gérer l'infrastructure de calcul partagée, permettant un accès plus facile et plus rapide pour les charges de travail d'IA complexes.

- Des fonctionnalités permettant d'ajouter des utilisateurs, de les regrouper en équipes, de fournir un accès aux ressources du cluster, de contrôler les quotas, les priorités et les pools, ainsi que de surveiller et d'établir des rapports sur l'utilisation des ressources.

- La possibilité de mettre en commun des GPU et de partager la puissance de calcul - de fractions de GPU à plusieurs GPU ou plusieurs nœuds de GPU fonctionnant sur différents clusters - pour des tâches distinctes.

- L'utilisation efficace des ressources des clusters de GPU, permettant aux clients de mieux rentabiliser leurs investissements informatiques.

NVIDIA continuera à proposer les produits Run:ai sous le même modèle commercial dans l'avenir immédiat. Et NVIDIA continuera à investir dans la feuille de route des produits Run:ai dans le cadre de NVIDIA DGX Cloud, une plate-forme d'IA conçue conjointement avec les principaux clouds pour les développeurs d'entreprise, offrant un service intégré et complet optimisé pour l'IA générative.

Les clients de NVIDIA DGX et DGX Cloud auront accès aux capacités de Run:ai pour leurs charges de travail d'IA, notamment pour les déploiements de grands modèles de langage. Les solutions de Run:ai sont déjà intégrées dans NVIDIA DGX, NVIDIA DGX SuperPOD, NVIDIA Base Command, les conteneurs NGC et le logiciel NVIDIA AI Enterprise, entre autres produits. La plate-forme informatique accélérée de NVIDIA et la plate-forme de Run:ai continueront à prendre en charge un large écosystème de solutions tierces, offrant ainsi aux clients choix et flexibilité.

Avec Run:ai, NVIDIA permettra aux clients d'avoir une seule structure qui accède aux solutions GPU n'importe où. Les clients peuvent s'attendre à bénéficier d'une meilleure utilisation des GPU, d'une meilleure gestion de l'infrastructure GPU et d'une plus grande flexibilité grâce à l'architecture ouverte.

Et vous ?

Pensez-vous que cette acquisition est crédible ou pertinente ?

Quel est votre avis sur le sujet ?

Voir aussi :

Les analystes estiment que Nvidia détient 98 % du marché des GPU pour centres de données. L'hégémonie de Nvidia dans ce secteur crucial soulève des questions sur la diversité et la concurrence

Nvidia dévoile le GPU Blackwell B200, la "puce la plus puissante au monde" pour l'IA qui "réduit les coûts et la consommation d'énergie jusqu'à 25 fois" par rapport à un H100, selon Nvidia

Jensen Huang, PDG de Nvidia, révèle une stratégie secrète en matière d'IA : « Nous avons investi dans l'IA en toute discrétion », annonce-t-il lors d'une conférence

Répondre avec citation

Répondre avec citation

Partager