Nvidia serait le principal investisseur dans les entreprises d'IA,

avec plus de deux douzaines d'investissements dans ce domaine au cours d'une année

Nvidia, le principal fabricant mondial de puces, s'est positionné comme le premier investisseur dans les start-ups d'intelligence artificielle (IA), renforçant ainsi sa dominance en tant que fournisseur majeur de processeurs d'IA. La société basée dans la Silicon Valley a révélé avoir investi dans « plus de deux douzaines » d'entreprises cette année, couvrant divers secteurs, de nouvelles plateformes d'IA évaluées à plusieurs milliards de dollars à des start-ups plus petites œuvrant dans des domaines tels que les soins de santé et l'énergie.

L'intelligence artificielle, qui relevait autrefois de l'imagination et des romans de science-fiction, est devenue non seulement une réalité, mais aussi un mode de vie. Il y a quelques décennies, l'IA n'était qu'une hypothèse sur les capacités potentielles des machines. Depuis, elle est rapidement devenue une fonction technologique essentielle qui alimente tout, de nos entreprises à nos voitures.

Les possibilités fonctionnelles de l'IA ont progressé à pas de géant au cours de la dernière décennie, et aucun endroit n'est plus propice à ce développement que la Silicon Valley. Berceau de géants de l'IA tels qu'Intel et Google, la Bay Area favorise l'émergence de talents et d'innovations extraordinaires dans le domaine de l'apprentissage automatique en profondeur. Ces entreprises d'IA de la Silicon Valley démontrent tout ce qui peut être accompli lorsque les humains et les machines travaillent côte à côte.

Selon les données de Dealroom, Nvidia a participé à 35 opérations en 2023, soit près de six fois plus que l'année précédente, consolidant sa position en tant qu'investisseur à grande échelle le plus actif dans le secteur de l'IA. Cette activité a dépassé celle des grandes sociétés de capital-risque de la Silicon Valley. Les investissements, totalisant 872 millions de dollars sur neuf mois, ont été dirigés vers des entreprises utilisant les technologies de Nvidia.

En mai, NVIDIA a temporairement rejoint le club des entreprises américaines valant plus de 1 000 milliards de dollars, devenant ainsi le premier fabricant de puces à atteindre cette valeur. La rapide ascension de la valeur de l'action, triplée en moins de huit mois, reflète l'intérêt croissant pour l'intelligence artificielle, en particulier avec les avancées rapides de l'IA générative capable de mener des conversations humaines et de créer divers contenus, des blagues à la poésie.

Depuis octobre, la valorisation de NVIDIA a augmenté d'environ 200 %, surpassant de loin tous les autres fabricants de puces de l'indice S&P 500. Certains analystes estiment même que le boom de l'IA indique un potentiel supplémentaire de croissance de la valeur de l'action. Les actions de l'entreprise ont connu une augmentation spectaculaire de 25 %, suivie d'une autre hausse de 5 % hier. Cette tendance à la hausse survient alors que la société anticipait une forte demande pour les avancées réalisées dans le domaine de l'IA.

En comparaison, le deuxième plus grand fabricant de puces au monde, Taiwan Semiconductor Manufacturing, est valorisé à environ 14 437 milliards de dollars taïwanais, soit environ 471 milliards de dollars américains.

Nvidia accélère dans l'IA : des investissements stratégiques dans des start-ups clés

Les investissements récents de Nvidia comprennent des entreprises telles qu'Inflection AI, Cohere, Hugging Face et CoreWeave, toutes clientes de Nvidia, utilisant ses puces GPU ou ses logiciels. Les investissements ont été réalisés sans chercher à obtenir des conditions spéciales, selon Mohamed Siddeek, directeur de NVentures, la branche de capital-risque de Nvidia. L'entreprise investit de manière stratégique pour tirer parti de ses partenariats et s'affirmer comme un acteur clé dans le secteur en pleine expansion de l'IA.

Inflection AI, Inc. est une entreprise technologique fondée en 2022 par les entrepreneurs Reid Hoffman, Mustafa Suleyman et Karén Simonyan. La société se spécialise dans le développement de matériel et d'applications axées sur l'apprentissage automatique et l'intelligence artificielle générative.

Le produit phare d'Inflection AI, lancé à grande échelle, est un chatbot baptisé Pi, abréviation de personal intelligence. Conçu pour agir comme un assistant personnel basé sur l'intelligence artificielle, Pi vise à offrir une expérience utilisateur unique. Les objectifs de l'entreprise pour Pi incluent la fourniture d'un soutien émotionnel aux utilisateurs humains. Le chatbot est conçu pour maintenir un dialogue textuel interactif, caractérisé par des éléments de gentillesse, un ton diplomatique sur des sujets sensibles et une touche d'humour.

Des comparaisons ont été établies entre le chatbot Pi et ChatGPT, un autre chatbot créé par OpenAI. Ces comparaisons portent sur divers aspects, mettant en lumière les différences et les similitudes entre les deux technologies.

Cohere est désormais valorisée à plus de deux milliards de dollars. Elle ne prévoit pas de lancer de produits destinés au grand public rivalisant avec OpenAI, mais vise plutôt le marché professionnel. La boîte à outils Retrieval Augmented Generation (RAG) de Cohere permet aux LLM de répondre avec précision aux questions et de résoudre les tâches en utilisant les données de l'entreprise comme source de vérité.

Les grands modèles de langage (LLM) de Cohere aident les entreprises à créer des applications puissantes et sécurisées qui recherchent, comprennent le sens et conversent dans le texte. Le modèle Embed de Cohere permet aux entreprises de créer des solutions de recherche puissantes. Embed est le modèle d'intégration le plus performant de l'industrie en anglais et dans plus de 100 autres langues, garantissant des résultats pertinents.

Fondée en 2016 par les entrepreneurs français Clément Delangue, Julien Chaumond et Thomas Wolf, Hugging Face avait initialement pour objectif de créer une application de chatbot destinée aux adolescents. Cependant, après avoir ouvert le modèle de cette application, elle a élargi son champ d'action pour se concentrer sur le développement d'une plateforme d'apprentissage automatique. En 2017, Hugging Face a déménagé aux États-Unis pour rechercher des financements.

Le 3 août 2022, la société a annoncé la disponibilité d'une version entreprise de son Hugging Face Hub public, prenant en charge le déploiement SaaS ou sur site (source secondaire souhaitée). En février 2023, Hugging Face a dévoilé un partenariat avec Amazon Web Services (AWS), rendant ainsi ses produits accessibles aux clients d'AWS. La société a également précisé que la prochaine génération de BLOOM serait exécutée sur Trainium, une puce d'apprentissage automatique développée par Amazon. Actuellement, Hugging Face compte 80 employés en France.

La société spécialisée dans l'infrastructure d'IA en cloud, CoreWeave, a récemment vu sa valorisation grimper à 7 milliards de dollars suite à un investissement minoritaire de 642 millions de dollars dirigé par Fidelity Management and Research Co. Cette nouvelle évaluation, rapportée par Bloomberg, marque une augmentation notable par rapport à la fin du mois de mai, où la société avait déjà élargi sa série B pour atteindre une valorisation de 2 milliards de dollars.

L'offre secondaire a également vu la participation de l'Investment Management Corporation of Ontario, Jane Street, J.P. Morgan Asset Management, Nat Friedman, Daniel Gross, Goanna Capital, Zoom Ventures, et d'autres encore. Michael Intrator, cofondateur et PDG, a commenté cette transaction en soulignant que la croissance rapide de l'entreprise a été reconnue par des investisseurs institutionnels de premier plan. Il a également noté que cette transaction met en évidence la reconnaissance du marché envers leur performance de leader, leur avantage technologique significatif et l'adoption soutenue par les clients.

Microsoft dévoile ses puces d'IA Maia 100 : une concurrence sérieuse pour Nvidia

Les experts estiment que Microsoft peut rattraper les leaders du secteur tels que Nvidia et Advanced Micro Devices (AMD) avec son premier Maia 100. Les nouvelles puces de Microsoft sont dotées de 105 milliards de transistors et prennent en charge les types de données 8 bits et les processeurs de serveurs refroidis par liquide.

Microsoft a annoncé son intention d'introduire une puce d'intelligence artificielle pour soutenir le développement de grands modèles de langage (LLM) et une autre pour les processus informatiques courants.

La grande entreprise technologique a confirmé son intention de se lancer dans la fabrication de puces lors de sa conférence Ignite, après des mois de préparation. Baptisée Maia 100, la dernière puce d'intelligence artificielle de Microsoft devrait concurrencer de près les puces de Nvidia tout en étant moins chère. Les puces H100 de Nvidia, dont le prix avoisine les 40 000 dollars, ont conquis une grande partie du marché, et l'entreprise s'efforce de répondre à la demande. Microsoft souhaite également répondre à la demande des développeurs d'IA avec son offre d'exécution de processus d'IA dans le cloud.

Microsoft prévoit de lancer deux puces d'intelligence artificielle (IA) : Maia 100 pour soutenir le développement de grands modèles de langage (LLM), et Cobalt 100 pour les processus informatiques courants. La puce Maia 100 vise à concurrencer les puces Nvidia, tout en étant moins chère. Des tests effectués par Microsoft avec les systèmes d'OpenAI ont donné des résultats impressionnants, accélérant l'apprentissage et l'inférence des modèles. Microsoft souhaite également répondre à la demande des développeurs d'IA avec son offre d'exécution de processus d'IA dans le cloud.

Les experts estiment que Microsoft peut rattraper les leaders du secteur avec ces nouvelles puces, qui sont dotées de 105 milliards de transistors et prennent en charge les types de données 8 bits et les processeurs refroidis par liquide. Microsoft prévoit de partager la conception de son rack unique avec ses partenaires, mais ne divulguera pas la conception des puces. En plus de Maia 100, Microsoft a également annoncé la puce Cobalt 100, concurrente directe des processeurs Intel pour les tâches informatiques générales.

L'ascension fulgurante de Nvidia en tant qu'investisseur principal dans les start-ups d'intelligence artificielle suscite une attention significative. En tant que principal fabricant mondial de puces, l'entreprise de la Silicon Valley a non seulement renforcé sa domination en tant que fournisseur majeur de processeurs d'IA, mais elle s'est également imposée comme l'investisseur le plus actif dans ce secteur.

Nvidia investit plus de 872 millions de dollars dans des start-ups d’IA en 2023

L'annonce selon laquelle Nvidia a investi dans « plus de deux douzaines » d'entreprises cette année, couvrant un large éventail de secteurs allant des nouvelles plateformes d'IA à des start-ups plus petites dans les domaines tels que les soins de santé et l'énergie, souligne la diversité de son portefeuille d'investissements. Ces investissements, totalisant 872 millions de dollars sur neuf mois, ont été dirigés vers des entreprises utilisant les technologies de Nvidia, consolidant ainsi son influence dans le développement et l'expansion de l'IA.

La statistique impressionnante de 35 opérations en 2023, soit près de six fois plus que l'année précédente, témoigne de l'engagement soutenu de Nvidia dans l'écosystème des start-ups d'IA. Cette activité a même surpassé celle des grandes sociétés de capital-risque de la Silicon Valley, démontrant la volonté de Nvidia d'occuper une position de leader dans ce domaine.

Les investissements récents de Nvidia dans des entreprises telles qu'Inflection AI, Cohere, Hugging Face et CoreWeave, toutes clientes de Nvidia, soulignent la stratégie de l'entreprise visant à investir de manière stratégique pour consolider ses partenariats existants. Le fait que ces investissements n'aient pas été assortis de conditions spéciales témoigne de la confiance de Nvidia dans la qualité et le potentiel de ces start-ups.

L'approche proactive de Nvidia en tant qu'investisseur dans l'IA, combinée à ses investissements stratégiques et à sa position dominante dans la fabrication de puces, laisse présager une continuité de son influence dans le secteur en pleine expansion de l'intelligence artificielle. Cependant, il sera intéressant de suivre l'évolution de ces investissements et de voir comment ils contribueront à façonner l'avenir de l'industrie de l'IA.

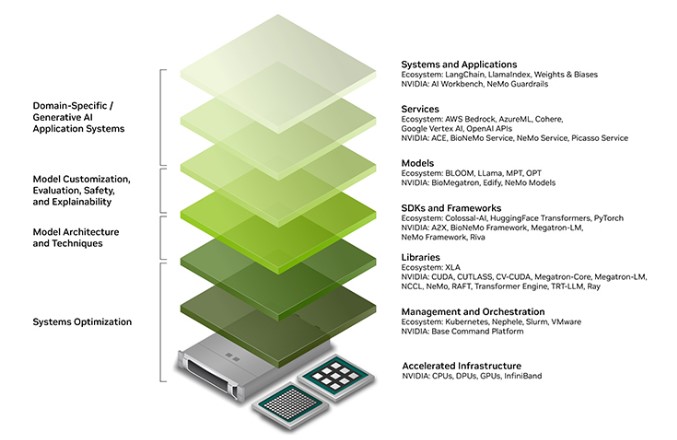

Source : Nvidia

Et vous ?

Quelles implications cela pourrait-il avoir sur la concurrence et la diversité du secteur de l'IA si Nvidia devenait effectivement le principal investisseur ?

Y a-t-il des préoccupations éthiques ou des risques potentiels associés au fait qu'une seule entreprise, en l'occurrence Nvidia, domine l'investissement dans les entreprises d'IA ?

Quel est le potentiel impact sur l'innovation technologique et la diversité des solutions d'IA si un seul acteur, en l'occurrence Nvidia, détient une influence prédominante en tant qu'investisseur ?

Voir aussi :

NVIDIA GTC : métavers, IA générative, voiture autonome, quelle est la perspective de NVIDIA sur ces sujets ? Entretien avec Jean-Charles Vasnier, Senior Manager Solution Architect

NVIDIA franchit temporairement la barre des 1 000 milliards de dollars de capitalisation boursière grâce à la forte demande en IA, devenant le premier fabriquant de puces à rejoindre les GAFA

Répondre avec citation

Répondre avec citation

Partager