Nvidia met à jour son processeur, le H200 offrant plus de mémoire et un traitement plus rapide pour les charges de travail d'IA, alors que ses concurrents remettent en cause sa domination de l'IA.

Nvidia a dévoilé une mise à jour de sa puce d'IA phare H100. Baptisée H200, elle dispose de plus de mémoire et d'un traitement plus rapide. Les trois plus grands fournisseurs de cloud déploieront la H200 à partir de 2024 : AWS, Azure et Google Cloud. AMD et Intel s'apprêtent à commercialiser leurs propres puces d'IA concurrentes cette année afin de tirer parti de la pénurie de GPU de Nvidia.

Nvidia a dévoilé une mise à jour de sa puce d'IA phare, la H100, afin de contrer les rivaux naissants de sa domination sur le marché des GPU. Le fabricant de puces le plus important au monde a annoncé le H200, qui utilisera une mémoire à large bande passante (HBM3e) pour traiter des ensembles de données massifs pour l'IA générative et d'autres charges de travail informatiques d'IA intenses.

Nvidia a déclaré que le H200 est le premier GPU à offrir HBM3e. Il dispose de 141 Go de mémoire à une vitesse de 4,8 téraoctets par seconde, soit près du double de la capacité et 2,4 fois plus de bande passante que son prédécesseur, l'A100. Le H100 prend en charge 120 Go de mémoire. Le fabricant de puces a déclaré que le H200 doublerait presque la vitesse d'inférence sur le modèle à 70 milliards de paramètres du modèle de grand langage open source Llama 2 de Meta, par rapport au H100. Nvidia a déclaré que le H200 bénéficierait d'autres améliorations grâce à des mises à jour logicielles.

Nvidia a déclaré qu'AWS, Microsoft Azure, Google Cloud, Oracle Cloud, CoreWeave, Lambda et Vultr déploieront la nouvelle puce à partir de 2024. La puce H100 de Nvidia est chère, coûtant souvent plus de 30 000 dollars par puce.

AMD et Intel à la poursuite de Nvidia

Cette nouvelle intervient alors que les rivaux de Nvidia ont dévoilé des puces qui visent à remettre en cause sa domination sur les GPU, d'autant plus qu'il y a une pénurie de ses GPU en raison de la forte demande.

AMD devrait commencer à livrer sa puce MI300X cette année, qui offre jusqu'à 192 Go de mémoire. Les grands modèles d'intelligence artificielle ont besoin de beaucoup de mémoire car ils effectuent de nombreux calculs. AMD a présenté une démo de la puce MI300X en faisant tourner un modèle Falcon avec 40 milliards de paramètres.

Intel sortira en décembre des puces pour PC alimentées par l'IA, appelées Meteor Lake. Il s'agit d'une conception SoC chiplet - petite et destinée à fonctionner avec d'autres chiplets. Meteor Lake représente le premier moteur d'IA dédié d'Intel intégré directement dans un SoC pour "amener l'IA à l'échelle du PC", avait déclaré l'entreprise.

SambaNova Systems présente sa puce SN40L, qui, selon elle, peut gérer un modèle de 5 billions de paramètres et prendre en charge plus de 256 000 séquences sur un seul système pour une meilleure qualité et des résultats plus rapides à un prix inférieur.

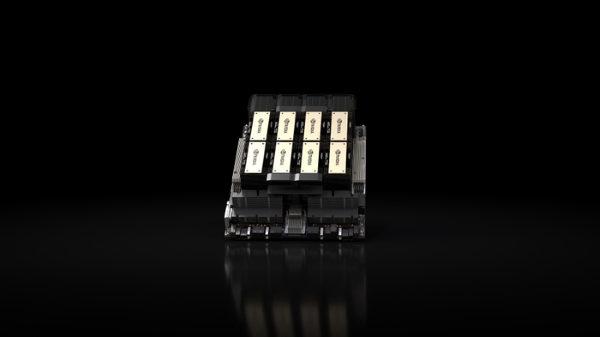

NVIDIA dope Hopper, la première plate-forme informatique d'IA au monde

NVIDIA annonce qu'elle a suralimenté la plateforme informatique d'IA la plus importante au monde avec l'introduction de la NVIDIA HGX H200. Basée sur l'architecture NVIDIA Hopper, la plateforme dispose du GPU NVIDIA H200 Tensor Core avec une mémoire avancée pour traiter des quantités massives de données pour l'IA générative et les charges de travail informatiques de haute performance.

Le NVIDIA H200 est le premier GPU à proposer HBM3e - une mémoire plus rapide et plus grande pour alimenter l'accélération de l'IA générative et des modèles de langage volumineux, tout en faisant progresser l'informatique scientifique pour les charges de travail HPC. Avec HBM3e, le NVIDIA H200 offre 141 Go de mémoire à 4,8 téraoctets par seconde, soit près du double de la capacité et 2,4 fois plus de bande passante par rapport à son prédécesseur, le NVIDIA A100.

Les systèmes équipés du H200 des principaux fabricants de serveurs et fournisseurs de services cloud devraient commencer à être livrés au deuxième trimestre 2024.

" Pour créer de l'intelligence avec l'IA générative et les applications HPC, de grandes quantités de données doivent être traitées efficacement à grande vitesse en utilisant une mémoire GPU importante et rapide ", a déclaré Ian Buck, vice président de l'hyperscale et du HPC chez NVIDIA. "Avec NVIDIA H200, la principale plate-forme de supercalculateur d'IA de bout en bout de l'industrie vient de devenir plus rapide pour résoudre certains des défis les plus importants du monde. "

Innovation perpétuelle, sauts de performance perpétuels

L'architecture NVIDIA Hopper offre un bond de performances sans précédent par rapport à son prédécesseur et continue de placer la barre plus haut grâce à des améliorations logicielles continues avec H100, notamment la récente sortie de puissantes bibliothèques open-source comme NVIDIA TensorRT-LLM. L'introduction du H200 entraînera de nouveaux sauts de performance, notamment en doublant presque la vitesse d'inférence sur Llama 2, un LLM de 70 milliards de paramètres, par rapport au H100. Les futures mises à jour logicielles devraient permettre d'améliorer encore les performances du H200.

Facteurs de forme de la NVIDIA H200

Le NVIDIA H200 sera disponible dans les cartes serveurs NVIDIA HGX H200 avec des configurations à quatre et huit voies, qui sont compatibles avec le matériel et le logiciel des systèmes HGX H100. Il est également disponible dans la puce NVIDIA GH200 Grace Hopper Superchip avec HBM3e, annoncée en août.

Grâce à ces options, le H200 peut être déployé dans tous les types de centres de données, y compris dans les locaux, le cloud, le cloud hybride et la périphérie. L'écosystème mondial de fabricants de serveurs partenaires de NVIDIA - notamment ASRock Rack, ASUS, Dell Technologies, Eviden, GIGABYTE, Hewlett Packard Enterprise, Ingrasys, Lenovo, QCT, Supermicro, Wistron et Wiwynn - peut mettre à jour ses systèmes existants avec un H200.

Amazon Web Services, Google Cloud, Microsoft Azure et Oracle Cloud Infrastructure seront parmi les premiers fournisseurs de services cloud à déployer des instances basées sur le H200 à partir de l'année prochaine, en plus de CoreWeave, Lambda et Vultr.

Alimenté par les interconnexions à haut débit NVIDIA NVLink et NVSwitch, le HGX H200 fournit les meilleures performances sur diverses charges de travail applicatives, notamment la formation et l'inférence LLM pour les plus grands modèles au-delà de 175 milliards de paramètres. Un HGX H200 à huit voies fournit plus de 32 pétaflops de calcul d'apprentissage profond FP8 et 1,1 To de mémoire agrégée à large bande passante pour obtenir les meilleures performances dans les applications d'IA générative et de HPC.

Associé à des CPU NVIDIA Grace™ dotés d'une interconnexion NVLink-C2C ultra-rapide, le H200 crée le Superchip Grace Hopper GH200 avec HBM3e, un module intégré conçu pour servir les applications HPC et IA à l'échelle géante.

Accélérer l'IA avec les logiciels complets de NVIDIA

La plate-forme de calcul accéléré de NVIDIA est soutenue par de puissants outils logiciels qui permettent aux développeurs et aux entreprises de créer et d'accélérer des applications prêtes à la production, de l'IA au HPC. Cela inclut la suite logicielle NVIDIA AI Enterprise pour des charges de travail telles que la parole, les systèmes de recommandation et l'inférence à grande échelle.

Disponibilité

Le NVIDIA H200 sera disponible auprès des fabricants de systèmes mondiaux et des fournisseurs de services cloud à partir du deuxième trimestre 2024.

À propos de NVIDIA

Depuis sa création en 1993, NVIDIA (NASDAQ : NVDA) est un pionnier de l'informatique accélérée. L'invention du GPU par la société en 1999 a déclenché la croissance du marché des jeux sur PC, redéfini l'infographie, déclenché l'ère de l'IA moderne et alimenté la numérisation industrielle sur tous les marchés. NVIDIA est désormais une société informatique complète avec des offres à l'échelle du centre de données qui remodèlent l'industrie.

Source : NVIDIA

Et vous ?

Quel est votre avis sur le sujet ?

Voir aussi :

La puce d'IA Nvidia H100 à 40 000 dollars est devenue le matériel informatique le plus convoité au monde et rapproche Nvidia des 1 000 milliards de dollars de capitalisation boursière

NVIDIA franchit temporairement la barre des 1 000 milliards de dollars de capitalisation boursière grâce à la forte demande en IA, devenant le premier fabriquant de puces à rejoindre les GAFA

Nvidia défie Intel avec des processeurs pour PC basés sur ARM destinés aux ordinateurs personnels Windows qui pourraient apparaître en 2025

Répondre avec citation

Répondre avec citation

Partager