Attaques d'empoisonnement spécifiques aux invites sur les modèles génératifs texte-image : Nightshade altère les données d'entraînement et permet aux artistes de lutter contre l'IA générative.

Un nouvel outil permet aux artistes d'ajouter des modifications invisibles aux pixels de leurs œuvres avant de les mettre en ligne, de sorte que si elles sont intégrées dans un ensemble d'entraînement à l'IA, le modèle qui en résulte peut se briser de manière chaotique et imprévisible. L'outil, appelé Nightshade, est conçu comme un moyen de lutter contre les entreprises d'IA qui utilisent les œuvres d'artistes pour entraîner leurs modèles sans l'autorisation du créateur.

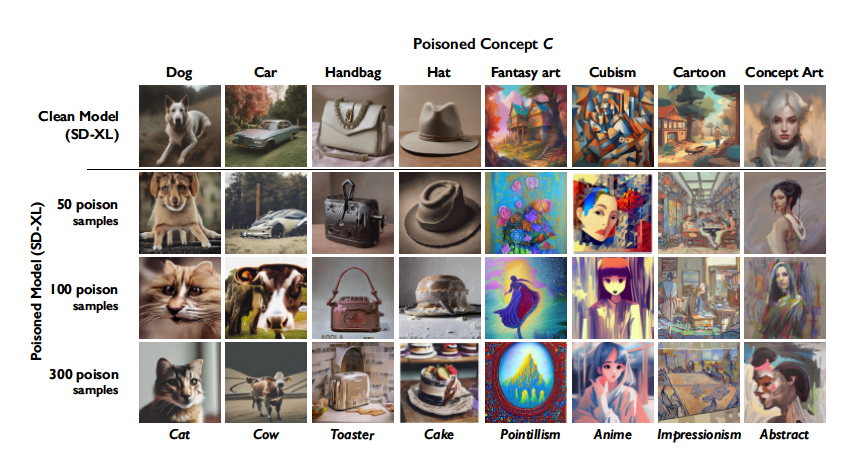

L'utilisation de cet outil pour "empoisonner" ces données d'entraînement pourrait endommager les futures itérations des modèles d'IA générateurs d'images, tels que DALL-E, Midjourney et Stable Diffusion, en rendant certains de leurs résultats inutiles : les chiens deviennent des chats, les voitures des vaches, et ainsi de suite.

Les sociétés d'IA telles que OpenAI, Meta, Google et Stability AI sont confrontées à une série de poursuites de la part d'artistes qui affirment que leurs œuvres protégées par le droit d'auteur et leurs informations personnelles ont été récupérées sans consentement ni compensation. Ben Zhao, professeur à l'université de Chicago, qui a dirigé l'équipe à l'origine de la création de Nightshade, espère que cette solution contribuera à faire pencher la balance des entreprises d'IA vers les artistes, en créant un puissant moyen de dissuasion contre le non-respect des droits d'auteur et de la propriété intellectuelle des artistes.

L'équipe de Zhao a également mis au point Glaze, un outil qui permet aux artistes de "masquer" leur style personnel pour éviter qu'il ne soit récupéré par les entreprises d'IA. Cet outil fonctionne de la même manière que Nightshade : il modifie les pixels des images de manière subtile, invisible à l'œil humain, mais manipule les modèles d'apprentissage automatique pour qu'ils interprètent l'image comme quelque chose de différent de ce qu'elle montre en réalité. L'équipe a l'intention d'intégrer Nightshade dans Glaze, et les artistes peuvent choisir d'utiliser ou non l'outil d'empoisonnement des données. L'équipe envisage également de rendre Nightshade open source, ce qui permettrait à d'autres de le bricoler et de créer leurs propres versions. Plus les gens l'utiliseront et créeront leurs propres versions, plus l'outil deviendra puissant, explique Zhao. Les ensembles de données pour les grands modèles d'IA peuvent être constitués de milliards d'images, donc plus il y a d'images empoisonnées qui peuvent être introduites dans le modèle, plus la technique causera de dégâts.

Nightshade exploite une faille de sécurité dans les modèles génératifs d'IA, qui découle du fait qu'ils sont entraînés sur de grandes quantités de données : dans ce cas, des images qui ont été récupérées sur l'internet. Nightshade s'attaque à ces images. Les artistes qui souhaitent mettre leurs œuvres en ligne, mais ne veulent pas que leurs images soient récupérées par des sociétés d'intelligence artificielle peuvent les télécharger sur Glaze et choisir de les masquer avec un style artistique différent du leur. Ils peuvent également choisir d'utiliser Nightshade. Lorsque les développeurs d'IA fouillent l'internet pour obtenir davantage de données afin d'améliorer un modèle d'IA existant ou d'en créer un nouveau, ces échantillons empoisonnés se frayent un chemin dans l'ensemble des données du modèle et provoquent un dysfonctionnement de celui-ci. Les échantillons de données empoisonnées peuvent manipuler les modèles pour qu'ils apprennent, par exemple, que les images de chapeaux sont des gâteaux et que les images de sacs à main sont des grille-pain. Les données empoisonnées sont très difficiles à supprimer, car il faut que les entreprises technologiques trouvent et suppriment minutieusement chaque échantillon corrompu.

Nightshade va faire réfléchir les entreprises d'IA à deux fois, "parce qu'elles ont la possibilité de détruire tout leur modèle en prenant notre travail sans notre consentement", déclare Eva Toorenent, une illustratrice et artiste qui a utilisé Glaze. "Je suis vraiment reconnaissante que nous disposions d'un outil qui peut aider à rendre le pouvoir aux artistes pour leur propre travail", ajoute Autumn Beverly, une autre artiste.

Source : Prompt-Specific Poisoning Attacks on Text-to-Image Generative ModelsLes attaques par empoisonnement des données manipulent les données d'apprentissage pour introduire des comportements inattendus dans les modèles d'apprentissage automatique au moment de l'apprentissage. Pour les modèles génératifs texte-image avec des ensembles de données d'apprentissage massifs, la compréhension actuelle des attaques par empoisonnement suggère qu'une attaque réussie nécessiterait l'injection de millions d'échantillons empoisonnés dans leur pipeline d'apprentissage. Dans cet article, nous montrons que les attaques par empoisonnement peuvent réussir sur les modèles génératifs. Nous observons que les données d'entraînement par concept peuvent être assez limitées dans ces modèles, ce qui les rend vulnérables aux attaques d'empoisonnement spécifiques aux invites, qui ciblent la capacité d'un modèle à répondre à des invites individuelles.

Nous présentons Nightshade, une attaque d'empoisonnement optimisée et spécifique à l'invite, dans laquelle les échantillons d'empoisonnement sont visuellement identiques à des images bénignes avec des invites textuelles correspondantes. Les échantillons de poison Nightshade sont également optimisés pour leur puissance et peuvent corrompre une invite Stable Diffusion SDXL en <100 échantillons de poison. Les effets du poison Nightshade s'étendent aux concepts connexes, et plusieurs attaques peuvent être composées ensemble dans un seul message-guide. De manière surprenante, nous montrons qu'un nombre modéré d'attaques Nightshade peut déstabiliser les caractéristiques générales d'un modèle génératif texte-image, rendant ainsi inopérante sa capacité à générer des images significatives. Enfin, nous proposons l'utilisation de Nightshade` et d'outils similaires comme dernière défense pour les créateurs de contenu contre les racleurs de sites web qui ignorent les directives d'exclusion/de non-crawl, et nous discutons des implications possibles pour les formateurs de modèles et les créateurs de contenu.

Et vous ?

Quel est votre avis sur ce nouvel outil Nightshade ?

Pensez-vous que cet outil est une solution durable les auteurs contre l'IA ?

Voir aussi :

Google défendra les utilisateurs de l'IA générative contre les plaintes pour violation du droit d'auteur, cette indemnisation comprend les données d'entrainement d'IA et les résultats générés

La "distillation pas-à-pas", un nouveau paradigme d'apprentissage pour surpasser les performances des grands LLM, avec moins de données d'entraînement et des modèles d'IA de plus petite taille

Des milliers d'auteurs s'opposent à l'exploitation de leur travail sans permission ni rémunération par l'IA générative, certains ont déjà intenté des actions en justice contre OpenAI

Répondre avec citation

Répondre avec citation

Partager