Google DeepMind présente RT-X : un modèle d'IA généraliste pour aider à faire progresser la façon dont les robots peuvent apprendre de nouvelles compétences.

Les robots sont de grands spécialistes, mais de piètres généralistes. En règle générale, il faut former un modèle pour chaque tâche, chaque robot et chaque environnement. Si l'on modifie une seule variable, il faut souvent repartir de zéro. Mais que se passerait-il si nous pouvions combiner les connaissances de toute la robotique et créer un moyen de former un robot polyvalent ?

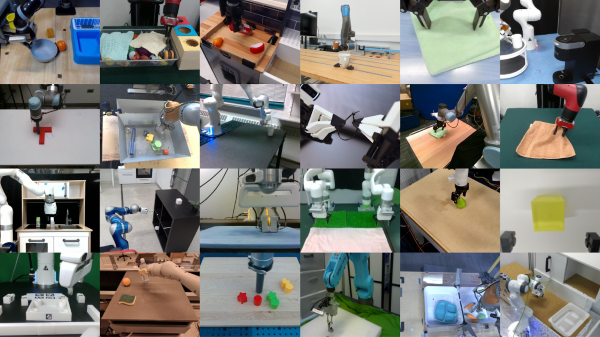

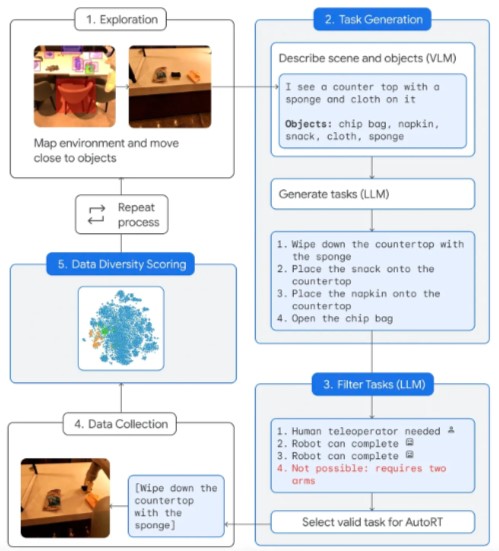

Aujourd'hui, Google DeepMind lance un nouvel ensemble de ressources pour l'apprentissage de la robotique polyvalente à travers différents types de robots ou réalisations. En collaboration avec des partenaires issus de 33 laboratoires universitaires, ils ont mis en commun des données provenant de 22 types de robots différents pour créer l'ensemble de données Open X-Embodiment. Ils ont également publié RT-1-X, un modèle de transformateur robotique (RT) dérivé de RT-1 et entraîné sur leur ensemble de données, qui montre un transfert de compétences entre de nombreux types de robots.

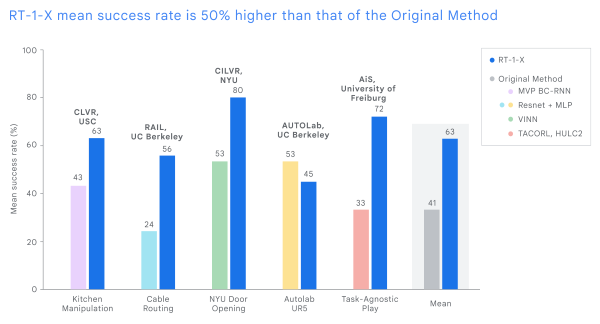

Dans ce travail, nous montrons que l'entraînement d'un modèle unique sur des données provenant de plusieurs réalisations permet d'obtenir des performances significativement meilleures pour de nombreux robots que les modèles entraînés sur des données provenant de réalisations individuelles. Nous avons testé notre modèle RT-1-X dans cinq laboratoires de recherche différents, démontrant une amélioration de 50 % du taux de réussite en moyenne sur cinq robots différents couramment utilisés par rapport aux méthodes développées indépendamment et spécifiquement pour chaque robot. Nous avons également montré que l'entraînement de notre modèle d'action du langage visuel, RT-2, sur des données provenant de réalisations multiples triplait ses performances en matière de compétences robotiques réelles.

Nous avons développé ces outils pour faire progresser collectivement la recherche inter-emblèmes dans la communauté de la robotique. L'ensemble de données Open X-Embodiment et le point de contrôle du modèle RT-1-X sont maintenant disponibles pour le bénéfice de la communauté de recherche élargie, grâce au travail des laboratoires de robotique du monde entier qui ont partagé des données et aidé à évaluer notre modèle dans le cadre d'un engagement à développer cette technologie de manière ouverte et responsable. Nous pensons que ces outils transformeront la façon dont les robots sont formés et accéléreront ce domaine de recherche.

Ensemble de données Open X-Embodiment : Collecte de données pour former des robots d'intelligence artificielle

Les ensembles de données et les modèles formés à partir de ces données ont joué un rôle essentiel dans l'avancement de l'IA. Tout comme ImageNet a propulsé la recherche en vision par ordinateur, DeepMind pense qu'Open X-Embodiment peut faire de même pour faire progresser la robotique. La constitution d'un ensemble de données de diverses démonstrations de robots est l'étape clé de l'entraînement d'un modèle généraliste capable de contrôler de nombreux types de robots, de suivre diverses instructions, d'effectuer un raisonnement de base sur des tâches complexes et de généraliser de manière efficace. Cependant, la collecte d'un tel ensemble de données est trop gourmande en ressources pour un seul laboratoire.

Pour développer l'ensemble de données Open X-Embodiment, DeepMind s'est associé à des laboratoires de recherche universitaires de plus de 20 institutions afin de recueillir des données provenant de 22 incarnations de robots, démontrant plus de 500 compétences et 150 000 tâches à travers plus d'un million d'épisodes. Cet ensemble de données est le plus complet de ce type dans le domaine de la robotique.

RT-X : Un modèle robotique polyvalent

RT-X s'appuie sur deux des modèles transformateurs de robotique de DeepMind. Ils ont entraîné RT-1-X à l'aide de RT-1, un modèle de contrôle robotique à l'échelle du monde réel, et ils ont entraîné RT-2-X à l'aide de RT-2, un modèle vision-langage-action (VLA) qui apprend à partir de données web et robotiques. Ils montrent ainsi qu'avec la même architecture de modèle, RT-1-X et RT-2-X sont capables d'atteindre de meilleures performances grâce aux données beaucoup plus diverses et croisées sur lesquelles ils sont entraînés. Cela montre également qu'ils améliorent les modèles formés dans des domaines spécifiques et qu'ils présentent une meilleure généralisation et de nouvelles capacités.

Pour évaluer RT-1-X dans les universités partenaires, ils ont comparé ses performances à celles des modèles développés pour leur tâche spécifique, comme l'ouverture d'une porte, sur l'ensemble de données correspondant. RT-1-X entraîné avec l'ensemble de données Open X-Embodiment a surpassé le modèle original de 50 % en moyenne.

Compétences émergentes dans RT-X

Pour étudier le transfert de connaissances entre robots, DeepMind mène des expériences avec son robot assistant sur des tâches qui impliquent des objets et des compétences qui ne sont pas présents dans l'ensemble de données RT-2, mais qui existent dans un autre ensemble de données pour un robot différent. Plus précisément, RT-2-X a été trois fois plus performant que le meilleur modèle précédent, RT-2, pour les compétences émergentes.

RT-2-X démontre des compétences dont le modèle RT-2 n'était pas capable auparavant, notamment une meilleure compréhension de l'espace. Par exemple, si on demande au robot de "déplacer la pomme près du tissu" au lieu de "déplacer la pomme sur le tissu", les trajectoires sont très différentes. En changeant la préposition de "près" à "sur", on peut moduler les actions du robot.Nos résultats suggèrent que le co-entraînement avec des données provenant d'autres plateformes imprègne RT-2-X de compétences supplémentaires qui n'étaient pas présentes dans l'ensemble de données original, ce qui lui permet d'effectuer de nouvelles tâches.

RT-2-X montre que la combinaison de données provenant d'autres robots dans l'entraînement améliore l'éventail des tâches pouvant être exécutées même par un robot qui dispose déjà de grandes quantités de données, mais seulement si l'on utilise une architecture à capacité suffisamment élevée.

Faire progresser la recherche en robotique de manière responsable

La recherche en robotique se trouve à un stade passionnant, mais précoce. De nouvelles recherches montrent qu'il est possible de mettre au point des robots d'assistance plus utiles en développant l'apprentissage à l'aide de données plus diverses et de meilleurs modèles. La collaboration avec des laboratoires du monde entier et le partage des ressources sont essentiels pour faire progresser la recherche en robotique de manière ouverte et responsable. DeepMind espère que l'ouverture des données et la fourniture de modèles sûrs mais limités réduiront les obstacles et accéléreront la recherche. L'avenir de la robotique repose sur la possibilité pour les robots d'apprendre les uns des autres et, surtout, pour les chercheurs d'apprendre les uns des autres.

Ce travail démontre qu'il est possible d'utiliser des modèles qui se généralisent à travers les incarnations, avec des améliorations spectaculaires des performances à la fois avec des robots ici à Google DeepMind et sur des robots dans différentes universités à travers le monde. Les recherches futures pourraient explorer comment combiner ces avancées avec la propriété d'auto-amélioration de RoboCat pour permettre aux modèles de s'améliorer avec leur propre expérience. Une autre direction future pourrait être d'étudier plus avant comment différents mélanges d'ensembles de données peuvent affecter la généralisation inter-emblèmes et comment la généralisation améliorée se matérialise.

Source : Google DeepMind

Et vous ?

Quel est votre avis sur ce modèle RT-X ?

Selon vous, quelles sont les forces et les limites d'un modèle d'IA généraliste ?

Voir aussi :

Google crée Google DeepMind, un nouveau groupe de recherche en IA, formé par la fusion de DeepMind et Brain

Comment Google DeepMind compte révolutionner l'IA générative et détrôner ChatGPT avec Gemini, son système d'IA qui combine les forces d'AlphaGo aux capacités des grands modèles de langage

La dernière vidéo du robot humanoïde Atlas de Boston Dynamics montre qu'il est capable de courir, sauter, prendre un objet au sol et le lancer à un ouvrier sur un chantier de construction simulé

Répondre avec citation

Répondre avec citation

Partager