OpenAI lance DALL-E 3 ChatGPT, la dernière version de son outil pour la génération d'images à partir de textes, afin d'aider les créateurs et les autres utilisateurs

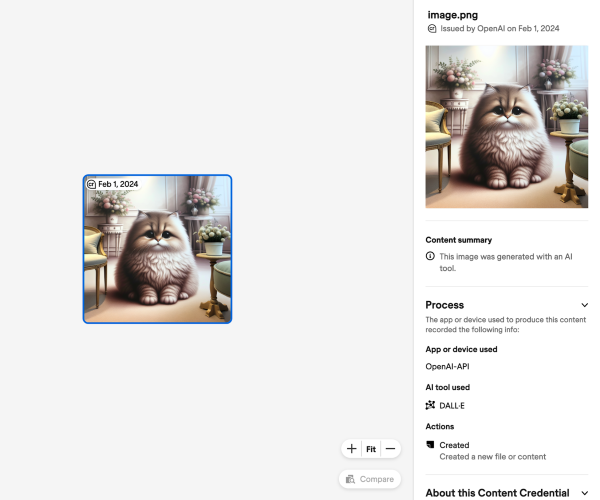

OpenAI a lancé DALL-E 3, la dernière version de son outil de conversion de texte en image, qui est conçu pour fonctionner avec le populaire chatbot d'IA ChatGPT afin de répondre aux demandes des utilisateurs. DALL-E 3 sera disponible via l'API pour les clients ChatGPT Plus et Enterprise à partir d'octobre, permettant aux utilisateurs de demander et de modifier des photos par le biais des discussions ChatGPT.

OpenAI souligne la capacité de DALL-E 3 à convertir des demandes complexes en images très détaillées et exactes. L'entreprise a également souligné l'importance de mettre en place des contrôles supplémentaires pour limiter la création de contenus violents, pornographiques ou haineux. Le programme comprend des filtres qui refusent les demandes de photos de personnalités publiques nommément citées ou celles qui imitent le style d'un artiste vivant.

Afin d'accroître la transparence et le contrôle des utilisateurs, OpenAI a donné aux créateurs la possibilité de refuser que leur travail soit utilisé pour former les futurs systèmes de conversion de texte en image. Toutefois, l'évolution des graphiques générés par l'IA a soulevé un certain nombre de problèmes. En août, un tribunal de Washington DC a conclu que les œuvres d'art générées par l'IA sans intervention humaine ne pouvaient être protégées par le droit d'auteur en vertu de la législation américaine.

Entre-temps, OpenAI est également confrontée à des problèmes juridiques. Une association américaine d'auteurs a récemment poursuivi OpenAI au nom d'auteurs célèbres tels que John Grisham et George R.R. Martin, affirmant qu'OpenAI avait illégalement utilisé leur travail pour former son chatbot ChatGPT.

Our new text-to-image model, DALL·E 3, can translate nuanced requests into extremely detailed and accurate images.

— OpenAI (@OpenAI) September 20, 2023

Coming soon to ChatGPT Plus & Enterprise, which can help you craft amazing prompts to bring your ideas to life:https://t.co/jDXHGNmarT pic.twitter.com/aRWH5giBPL

L'action collective proposée par l'Authors Guild, qui a été déposée mardi 19 septembre en fin de journée, s'ajoute à un certain nombre d'autres actions intentées par des auteurs, des propriétaires de logiciels libres et des artistes visuels contre des entreprises spécialisées dans l'IA générative. Des actions en justice similaires concernant les données utilisées pour former les systèmes d'IA de Meta Platforms et de Stability AI sont en cours, en plus de celles intentées contre OpenAI, soutenue par Microsoft.

La rivalité d'OpenAI dans le domaine des outils d'IA texte-image s'intensifie, avec des entreprises telles que Tongyi Wanxiang d'Alibaba, Midjourney et Stability AI qui perfectionnent leurs modèles de génération d'images.

Source : OpenAI

Et vous ?

Quel est votre avis sur le sujet ?

Avez-vous eu l'occasion de tester cette nouvelle version de DALL-E ? Quelles sont les fonctionnalités que vous trouvez intéressantes ?

Comment évaluez-vous le générateur d'images DALL-E d'OpenAI par rapport à la concurrence (Stable Diffusion, Midjourney, etc.) ?

Voir aussi

Dall-E 2 permet de générer des images à partir de quelques mots, mais le produit est-il votre ? Votre illustration numérique générée par l'IA pourrait ne pas être protégée par le droit d'auteur

Le générateur d'images de l'IA DALL-E d'OpenAI peut désormais modifier des photos, les chercheurs peuvent s'inscrire pour le tester

Dall-E 2 : le générateur d'images IA développé par OpenAI permet désormais d'éditer des visages humains, la fonctionnalité était auparavant interdite par crainte d'une mauvaise utilisation

Dall-E : le générateur d'images IA développé par OpenAI est maintenant ouvert à tous, en supprimant la liste d'attente, OpenAI donne la possibilité à tout le monde pour s'inscrire et l'utiliser

Répondre avec citation

Répondre avec citation

Partager