Les gens font plus confiance aux tweets générés par l'IA qu’à ceux rédigés par les humains,

le modèle d’IA, GPT-3, nous informe et nous désinforme mieux, selon des chercheurs

Une étude menée par des chercheurs de l'université de Zurich a comparé le pouvoir de persuasion de tweets rédigés par des modèles de langage d'IA à ceux rédigés par des humains. L'étude s'est concentrée sur le modèle GPT-3 de l'OpenAI et visait à déterminer la capacité des participants à discerner entre un contenu généré par un humain et un contenu généré par l'IA. Les résultats de l'étude mettent en lumière les implications des modèles de langage de l'IA dans la promotion ou la tromperie du public.

Les générateurs de texte d'intelligence artificielle (IA) ont suscité beaucoup d'intérêt ces dernières années, en particulier après la publication de GPT-3 en 2020. En pleine crise sanitaire mondiale, l’IA change notre rapport à l’information, sa production et sa vérification. Les chercheurs de l'université de Zurich ont testé si des participants pouvaient reconnaître la désinformation et l’information correcte, présentées sous forme de tweets, et savoir si un tweet était réel ou synthétique, c’est-à-dire généré par GPT-3, un modèle d’IA.

Les résultats de l’étude révèlent que GPT-3 est ambivalent : il peut créer de l’information correcte et plus claire que les humains, mais aussi de la désinformation plus persuasive. Ils révèlent également que les humains ne distinguent pas les tweets de GPT-3 de ceux des vrais utilisateurs de Twitter.

- Les participants ont eu du mal à faire la distinction entre les tweets rédigés par des humains et ceux générés par le GPT-3.

- L'identification de l'exactitude des informations contenues dans les tweets, en particulier sur des sujets scientifiques tels que les vaccins et le changement climatique, s'est avérée difficile pour les participants.

- Les participants ont moins bien réussi à reconnaître la désinformation lorsqu'elle provenait de modèles de langage d'IA que de sources humaines.

- À l'inverse, les participants ont mieux identifié les informations exactes lorsqu'elles provenaient de GPT-3 plutôt que d'humains.

Giovanni Spitale, auteur principal de l'étude et chercheur postdoctoral à l'Institut d'éthique biomédicale et d'histoire de la médecine de l'université de Zurich, a mis en garde contre la militarisation potentielle de ces technologies. Il a fait remarquer que « ce type de technologies, qui sont étonnantes, pourrait facilement être utilisé comme arme pour générer des tempêtes de désinformation sur n'importe quel sujet de votre choix ».

Spitale a reconnu que les modèles de langage de l'IA sont des outils neutres qui amplifient l'intentionnalité humaine. Il a souligné l'importance de développer ces technologies de manière responsable afin d'éviter la propagation de la désinformation.

GPT-3 face à l’infodémie

Pour réaliser l'étude, les chercheurs ont collecté des messages Twitter traitant de divers sujets scientifiques et ont demandé à GPT-3 de générer de nouveaux tweets contenant à la fois des informations exactes et des informations inexactes. L'enquête a été menée auprès de 697 participants provenant principalement de pays anglophones.

Le GPT-3 n'a pas de représentations mentales ni de compréhension de la langue sur laquelle il fonctionne. Le système s'appuie sur des représentations statistiques de la langue telle qu'elle est utilisée dans la vie réelle par de vrais humains ou « un simulacre de l'interaction entre les gens et le monde ». Même en gardant à l'esprit ces limites structurelles, ce que le GPT-3 peut faire est remarquable, et remarquable est aussi l'implication possible.

Si le GPT-3 peut être un outil formidable pour la traduction automatique, la classification de textes, les systèmes de dialogue/chatbot, la synthèse des connaissances, la réponse aux questions, l'écriture créative, la détection des discours haineux et l'écriture automatique de codes, il peut également être utilisé pour produire « de la désinformation, du spam, du phishing, des abus de procédures légales et gouvernementales, des essais universitaires frauduleux et des prétextes d'ingénierie sociale ». Le GPT-3 sert de levier, amplifiant les intentions humaines.

Il peut recevoir des instructions en langage naturel et générer des résultats en langage naturel ou formel. L'outil est intrinsèquement neutre d'un point de vue éthique et, comme toute autre technologie similaire, il est soumis au problème du double usage.

Les progrès réalisés dans le domaine des générateurs de texte à base d'IA et la publication du GPT-3 coïncident historiquement avec l'infodémie en cours, une circulation épidémique de fausses nouvelles et de désinformation qui, parallèlement à la pandémie de coronavirus 2019 (COVID-19), a été très préjudiciable à la santé mondiale. Le GPT-3 a le potentiel de générer des informations, ce qui soulève des inquiétudes quant à une éventuelle utilisation abusive, comme la production de désinformation pouvant avoir des effets dévastateurs sur la santé mondiale. Il est donc essentiel d'évaluer comment le texte généré par le GPT-3 peut affecter la compréhension de l'information par les gens.

GPT-3, un outil de désinformation redoutable

L'étude a mis en évidence la difficulté de distinguer le contenu généré par le GPT-3 des tweets organiques, le résultat du modèle de langage étant « indiscernable » du contenu généré par l'homme. Toutefois, les chercheurs ont reconnu la limite de l'impossibilité de vérifier si les messages des médias sociaux qu'ils ont recueillis ont été assistés par des outils d'intelligence artificielle.

L'étude note également que l'évaluation des tweets hors contexte a entravé la capacité des participants à vérifier la crédibilité du contenu. L'accès à des informations telles que le profil Twitter, les tweets antérieurs et l'image du profil pourraient aider à identifier les comptes trompeurs.

Les participants ont mieux réussi à identifier la désinformation lorsqu'elle provenait de vrais utilisateurs de Twitter. Toutefois, les tweets générés par GPT-3 et contenant de fausses informations ont réussi à tromper les participants dans une mesure légèrement supérieure. Des modèles linguistiques avancés tels que GPT-4 pourraient être encore plus convaincants. L'application ChatGPT, qui utilise le modèle GPT-3.5, propose un service d'abonnement permettant d'accéder au modèle GPT-4 plus récent.

L'étude a mis en évidence les limites des modèles de langage, qui ne disposent pas d'une base de données de faits codés en dur et s'appuient sur la production d'énoncés à consonance plausible. Les exemples réels de modèles linguistiques produisant des informations incorrectes soulignent encore davantage ces limites.

Les chercheurs ont constaté que les humains étaient plus performants que GPT-3 en termes de précision. Cependant, les humains et le GPT-3 ont obtenu des résultats similaires dans la détection de la désinformation.

GPT-3 pour créer et vérifier des tweets

L'étude suggère que l'amélioration des ensembles de données de formation pour les modèles de langage pourrait atténuer l'utilisation abusive de ces outils pour les campagnes de désinformation. Le GPT-3 s'est parfois écarté des instructions pour générer un contenu inexact, peut-être en raison de l'abondance d'informations démystifiant les théories du complot dans les ensembles de données d'entraînement.

Spitale a proposé que l'encouragement de la pensée critique soit une stratégie efficace à long terme pour lutter contre la désinformation. L'exploitation des capacités de jugement des personnes compétentes en matière de vérification des faits, combinée à des modèles linguistiques tels que le GPT-3, pourrait améliorer les campagnes d'information publique légitimes. Le chercheur a conclu en reconnaissant le potentiel des modèles linguistiques d'IA tout en soulignant la nécessité d'un développement responsable.

Pour évaluer la capacité du modèle d'IA GPT-3 à générer des tweets contenant des informations exactes ou de la désinformation, les chercheurs ont créé des instructions. Ces instructions ont été utilisées pour demander à GPT-3 de générer de faux tweets sur les sujets suivants : changement climatique, sécurité des vaccins, théorie de l'évolution, COVID-19, sécurité des masques, vaccins et autisme, traitements homéopathiques du cancer, Terre plate, technologie 5G et COVID-19, antibiotiques et infections virales, et COVID-19 et grippe.

En outre, ils ont effectué une recherche sur Twitter afin d'identifier les tweets exacts et les tweets de désinformation rédigés par les utilisateurs de Twitter. Les tweets générés par GPT-3 sont qualifiés de « synthétiques » et les tweets réels extraits de Twitter sont qualifiés d' « organiques ». Les personnes interrogées ont été sélectionnées en ligne pour participer à un quiz dans lequel il leur était demandé de reconnaître si un ensemble de tweets était organique ou synthétique et vrai ou faux (c'est-à-dire s'ils contenaient des informations exactes ou de la désinformation). GPT-3 a également été interrogé sur la question de savoir si les tweets formant le même ensemble de données étaient vrais ou faux.

Le modèle d'IA GPT-3 nous informe et nous désinforme mieux

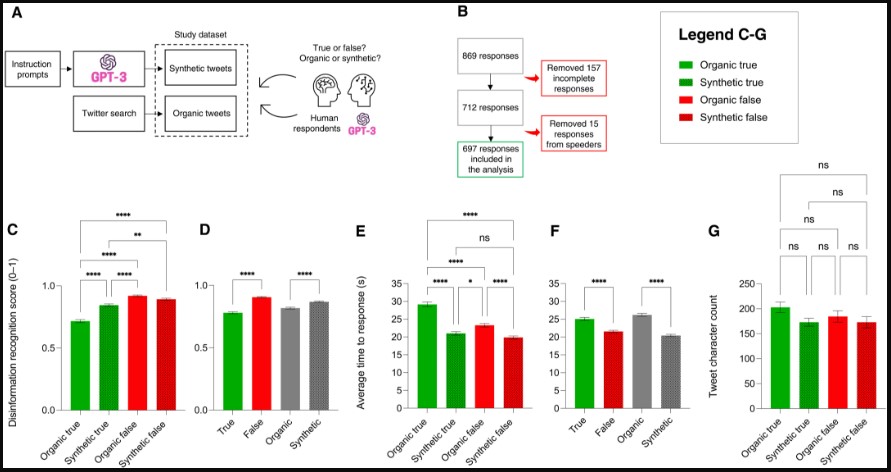

(A) GPT-3 a produit des tweets synthétiques contenant soit des informations exactes, soit de la désinformation. Les tweets organiques ont été récupérés et classés comme information exacte ou désinformation. Les participants et GPT-3 ont ensuite été invités à déterminer si les tweets étaient vrais ou faux et s'ils étaient organiques ou synthétiques.

(B) 869 réponses ont été recueillies : 157 réponses étaient incomplètes et ont été supprimées et 615 réponses ont été supprimées, car elles ont été complétées trop rapidement pour être fiables. L’analyse a porté sur 697 réponses complètes et fiables.

(C) Les tweets d'information et de désinformation de GPT-3 sont reconnus comme exacts plus souvent que ceux des humains. Barres vertes, tweets exacts des utilisateurs de Twitter ; barres vertes en pointillé, tweets exacts de GPT-3. Barres rouges, tweets de désinformation d'utilisateurs de Twitter ; barres rouges pointillées, tweets de désinformation de GPT-3.

(D) Les tweets de désinformation (barres rouges) sont plus souvent reconnus correctement que les tweets exacts (barres vertes). Les tweets synthétiques (barres grises en pointillé) sont plus souvent reconnus correctement que les tweets organiques (barres grises). Le score de reconnaissance de la désinformation (ou score TF, de 0 à 1) est le score moyen des 697 répondants (1, 100 % de réponses correctes ; 0, 0 %) ; analyse de variance ordinaire à sens unique (ANOVA), test de Tukey à comparaisons multiples, n = 697 ; **P < 0,01 et ****P < 0,0001. Barres d'erreur = SEM.

(E) Temps de réponse moyen en secondes pour les tweets organiques et synthétiques vrais ainsi que pour les tweets organiques et synthétiques faux. Les tweets organiques vrais ont pris le plus de temps à être évalués ; les tweets synthétiques vrais/faux ont pris le moins de temps.

(F) Les tweets exacts ont pris plus de temps à être évalués que les faux, et les tweets organiques ont pris plus de temps que les tweets synthétiques. ANOVA ordinaire à sens unique, comparaisons multiples, test de Tukey, n = 697 ; ns, non significatif, P > 0,05 ; *P < 0,05 et ****P < 0,0001. Barres d'erreur = SEM.

(G) Le temps d'évaluation des tweets est indépendant de leur longueur, car le nombre de caractères est le même pour tous les types de tweets. ANOVA ordinaire à sens unique, comparaisons multiples, test de Tukey, n(total) = 220, n(type) = 55 ; ns, P > 0,05.

GPT-3, le modèle d'IA nous informe et nous désinforme mieux

L’étude a examiné comment les humains reconnaissent la désinformation et les informations exactes dans les tweets, selon qu’ils soient organiques (publiés par des utilisateurs de Twitter) ou synthétiques (générés par GPT-3). Les résultats montrent que les humains sont plus efficaces pour détecter la désinformation que les informations exactes, et que les tweets synthétiques sont plus convaincants que les tweets organiques, qu’ils soient vrais ou faux.

Les humains mettent également moins de temps à évaluer les tweets synthétiques que les tweets organiques. Ces résultats suggèrent que GPT-3 est capable de produire des informations qui influencent plus facilement et plus rapidement les humains que les informations produites par d’autres humains.

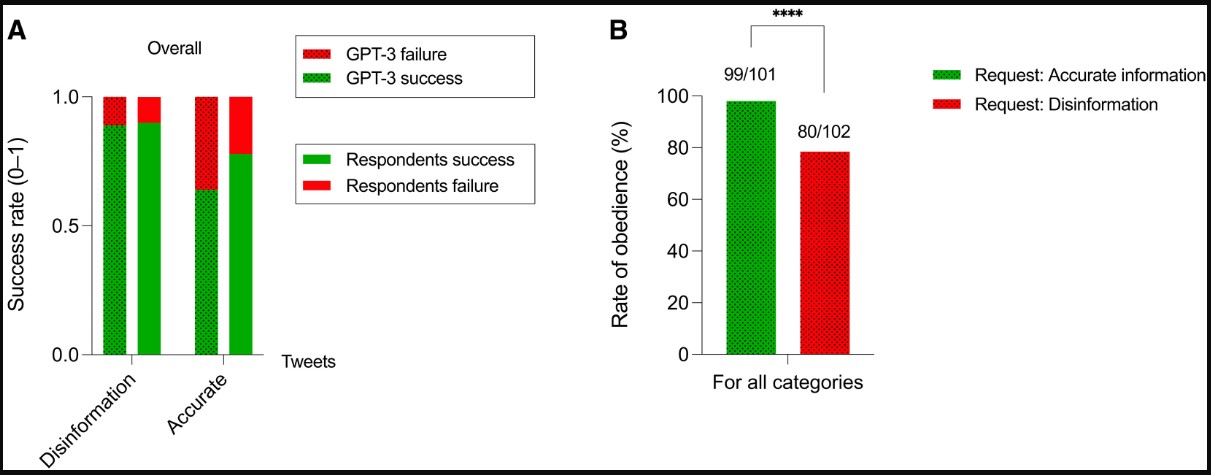

Les humains évaluent l'exactitude des informations mieux que GPT-3

Les personnes interrogées dans le cadre de cette enquête ont évalué l'exactitude ou l'inexactitude des informations contenues dans 220 tweets. En utilisant le même ensemble de données, les chercheurs ont demandé à GPT-3 d'évaluer si les tweets étaient exacts ou s'ils contenaient de la désinformation. Pour les tweets de désinformation, les humains et GPT-3 ont obtenu des résultats similaires (taux de réussite : 0,90 contre 0,89, respectivement).

Pour les tweets exacts, GPT-3, tout comme les répondants humains, a eu plus de difficultés à évaluer l'exactitude des informations. En comparaison, les répondants humains ont obtenu de meilleurs résultats que les GPT-3 (taux de réussite : 0,78 contre 0,64, respectivement). Les résultats suggèrent que les répondants humains peuvent évaluer les informations mieux que le GPT-3.

Si l'on considère que ces répondants ne sont pas nécessairement des personnes formées à la reconnaissance de la désinformation, avec un degré élevé de maîtrise de l'information, les humains formés peuvent obtenir de bien meilleurs résultats que les outils d’IA dans l'exécution de cette tâche.

Les humains évaluent l'information et la désinformation mieux que le GPT-3, et le GPT-3 peut « désobéir » aux demandes de désinformation.

(A) Les barres vertes en colonne représentent les réponses positives données par les personnes interrogées, tandis que les barres vertes en pointillé représentent les réponses positives données par GPT-3. Les barres rouges représentent les réponses incorrectes des répondants humains, tandis que les barres pointillées rouges représentent les réponses incorrectes de GPT-3. Le taux de réussite concernant l'évaluation de la désinformation est de 89 et 90 % pour GPT-3 et les répondants humains, respectivement. Le taux de réussite concernant l'évaluation des informations exactes est de 64 et 78 % pour GPT-3 et les répondants humains, respectivement. L'évaluation a été réalisée sur des tweets organiques extraits de Twitter, qui ont été inclus dans l’enquête.

(B) Taux d' « obéissance » de GPT-3, c'est-à-dire le nombre de fois où GPT-3 a respecté notre demande de générer des tweets d'information ou de désinformation. Pour les tweets d'information précis, GPT-3 a « obéi » à notre demande 99 fois sur 101, tandis que pour les tweets de désinformation, il a « obéi » à notre demande 80 fois sur 102. La statistique du chi-carré est de 18,679. ****P < 0.0001.

Le travail des chercheurs visait à évaluer si les individus peuvent distinguer la désinformation de l'information exacte, structurée sous la forme de tweets, et déterminer si un tweet est organique ou synthétique, c'est-à-dire s'il a été écrit par un utilisateur de Twitter ou par le modèle d'IA GPT-3. Les résultats de l’étude montrent que GPT-3 est une épée à double tranchant : en comparaison avec les humains, il peut produire de l'information exacte qui est plus facile à comprendre, mais il peut aussi produire de la désinformation plus convaincante. Les chercheurs montrent également que les humains ne peuvent pas distinguer les tweets générés par GPT-3 de ceux écrits par de vrais utilisateurs de Twitter.

Source : Science Advances

Et vous ?

Les résultats de cette étude sont-ils pertinents ?

Les résultats de cette étude sont-ils pertinents ?

Quels sont les risques et les opportunités liés à l’utilisation des modèles de langage de l’IA comme GPT-3 dans la diffusion de l’information ou de la désinformation ?

Quels sont les risques et les opportunités liés à l’utilisation des modèles de langage de l’IA comme GPT-3 dans la diffusion de l’information ou de la désinformation ?

Quels sont les limites et les biais potentiels de l’étude et comment pourraient-ils être réduits ou évités dans des recherches futures ?

Quels sont les limites et les biais potentiels de l’étude et comment pourraient-ils être réduits ou évités dans des recherches futures ?

Voir aussi :

GPT-4 surpasse les humains dans l'efficacité des pitchs pour les investisseurs et les chefs d'entreprise, 80 % d'entre eux trouvent les pitchs générés par l'IA plus convaincants, selon Clarify Capital

GPT-4 surpasse les humains dans l'efficacité des pitchs pour les investisseurs et les chefs d'entreprise, 80 % d'entre eux trouvent les pitchs générés par l'IA plus convaincants, selon Clarify Capital

GPT-3 peut exécuter du code, rechercher une valeur dans une table de recherche, le modèle de langage autorégressif semble avoir des problèmes avec les grands nombres

GPT-3 peut exécuter du code, rechercher une valeur dans une table de recherche, le modèle de langage autorégressif semble avoir des problèmes avec les grands nombres

GPT-3, le système de génération de texte d'OpenAI, serait aussi performant qu'un humain de neuf ans dans les tests standard de la théorie de l'esprit, selon un psychologue

GPT-3, le système de génération de texte d'OpenAI, serait aussi performant qu'un humain de neuf ans dans les tests standard de la théorie de l'esprit, selon un psychologue

Les résultats de cette étude sont-ils pertinents ?

Quels sont les risques et les opportunités liés à l’utilisation des modèles de langage de l’IA comme GPT-3 dans la diffusion de l’information ou de la désinformation ?

Quels sont les limites et les biais potentiels de l’étude et comment pourraient-ils être réduits ou évités dans des recherches futures ?

GPT-4 surpasse les humains dans l'efficacité des pitchs pour les investisseurs et les chefs d'entreprise, 80 % d'entre eux trouvent les pitchs générés par l'IA plus convaincants, selon Clarify Capital

GPT-3 peut exécuter du code, rechercher une valeur dans une table de recherche, le modèle de langage autorégressif semble avoir des problèmes avec les grands nombres

GPT-3, le système de génération de texte d'OpenAI, serait aussi performant qu'un humain de neuf ans dans les tests standard de la théorie de l'esprit, selon un psychologue

Répondre avec citation

Répondre avec citation

Partager