Déclaration de Bletchley des pays participant au sommet sur la sécurité de l'IA

L'intelligence artificielle (IA) offre d'énormes possibilités à l'échelle mondiale : elle a le potentiel de transformer et d'améliorer le bien-être, la paix et la prospérité de l'humanité. Pour y parvenir, nous affirmons que, pour le bien de tous, l'IA doit être conçue, développée, déployée et utilisée en toute sécurité, de manière à être centrée sur l'humain, digne de confiance et responsable. Nous saluons les efforts déployés jusqu'à présent par la communauté internationale pour coopérer dans le domaine de l'IA afin de promouvoir une croissance économique inclusive, le développement durable et l'innovation, de protéger les droits de l'homme et les libertés fondamentales, et de favoriser la confiance du public dans les systèmes d'IA afin qu'ils réalisent pleinement leur potentiel.

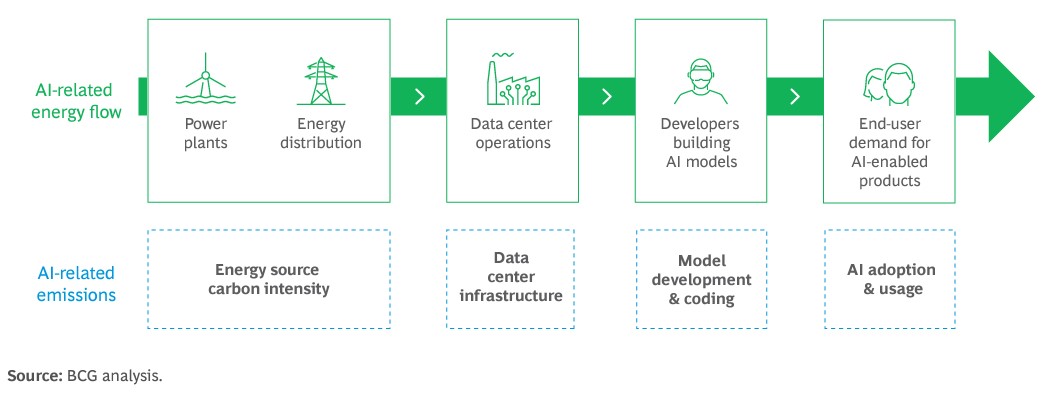

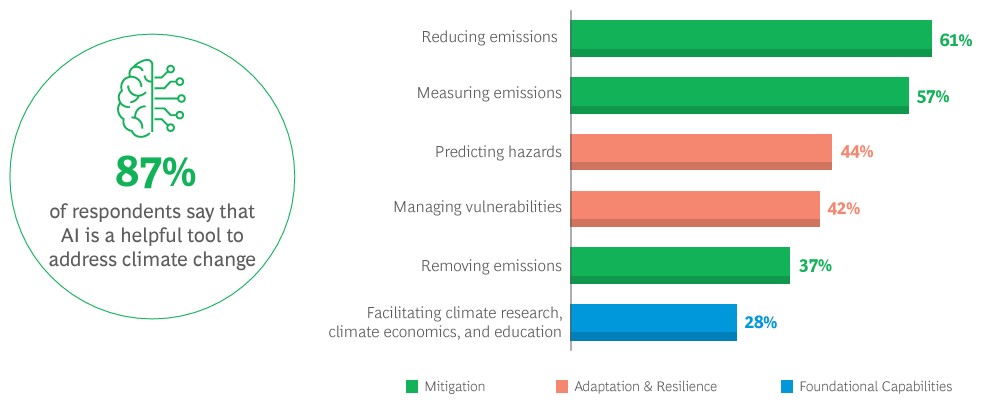

Les systèmes d'IA sont déjà déployés dans de nombreux domaines de la vie quotidienne, notamment le logement, l'emploi, les transports, l'éducation, la santé, l'accessibilité et la justice, et leur utilisation est susceptible d'augmenter. Nous reconnaissons qu'il s'agit donc d'un moment unique pour agir et affirmer la nécessité de développer l'IA en toute sécurité et d'utiliser les possibilités de transformation de l'IA pour le bien et pour tous, d'une manière inclusive dans nos pays et dans le monde. Cela inclut les services publics tels que la santé et l'éducation, la sécurité alimentaire, la science, l'énergie propre, la biodiversité et le climat, la réalisation de la jouissance des droits de l'homme et le renforcement des efforts visant à atteindre les objectifs de développement durable des Nations unies.

Parallèlement à ces possibilités, l'IA présente également des risques importants, y compris dans les domaines de la vie quotidienne. À cette fin, nous saluons les efforts internationaux déployés pour examiner et traiter l'impact potentiel des systèmes d'IA dans les forums existants et d'autres initiatives pertinentes, ainsi que la reconnaissance de la nécessité d'aborder la protection des droits de l'homme, la transparence et l'explicabilité, l'équité, la responsabilité, la réglementation, la sécurité, la surveillance humaine appropriée, l'éthique, l'atténuation des préjugés, la protection de la vie privée et la protection des données. Nous notons également la possibilité de risques imprévus découlant de la capacité à manipuler le contenu ou à générer un contenu trompeur. Toutes ces questions sont d'une importance capitale et nous affirmons la nécessité et l'urgence de les traiter.

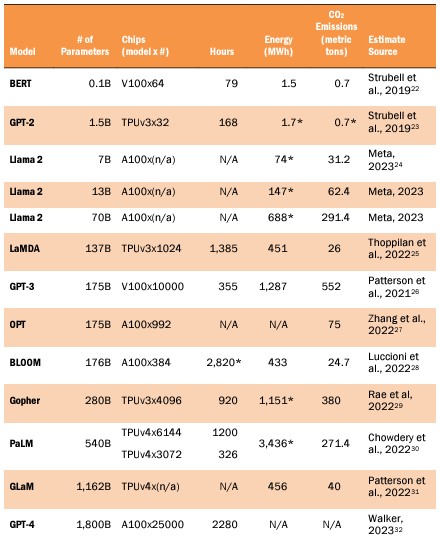

Des risques de sécurité particuliers se posent à la "frontière" de l'IA, c'est-à-dire aux modèles d'IA à usage général très performants, y compris les modèles de base, qui pourraient effectuer une grande variété de tâches - ainsi qu'à l'IA étroite spécifique pertinente qui pourrait présenter des capacités nuisibles - qui égalent ou dépassent les capacités présentes dans les modèles les plus avancés d'aujourd'hui. Des risques importants peuvent découler d'une éventuelle utilisation abusive intentionnelle ou de problèmes de contrôle involontaires liés à l'alignement sur l'intention humaine. Ces problèmes sont en partie dus au fait que ces capacités ne sont pas entièrement comprises et sont donc difficiles à prévoir. Nous sommes particulièrement préoccupés par ces risques dans des domaines tels que la cybersécurité et la biotechnologie, ainsi que dans les cas où les systèmes d'IA d'avant-garde peuvent amplifier des risques tels que la désinformation. Les capacités les plus importantes de ces modèles d'IA peuvent entraîner des dommages graves, voire catastrophiques, délibérés ou involontaires. Compte tenu de la rapidité et de l'incertitude de l'évolution de l'IA, et dans le contexte de l'accélération des investissements dans la technologie, nous affirmons qu'il est particulièrement urgent d'approfondir notre compréhension de ces risques potentiels et des mesures à prendre pour y faire face.

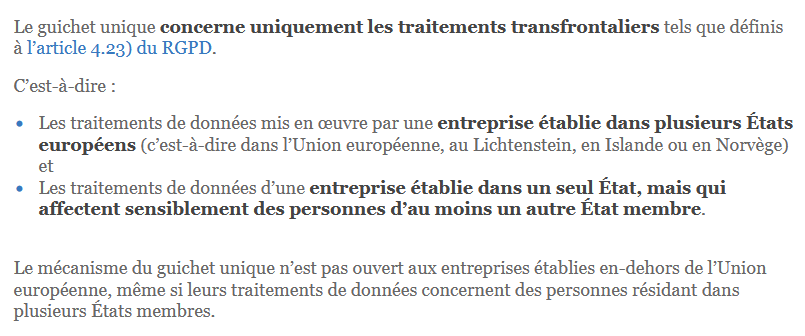

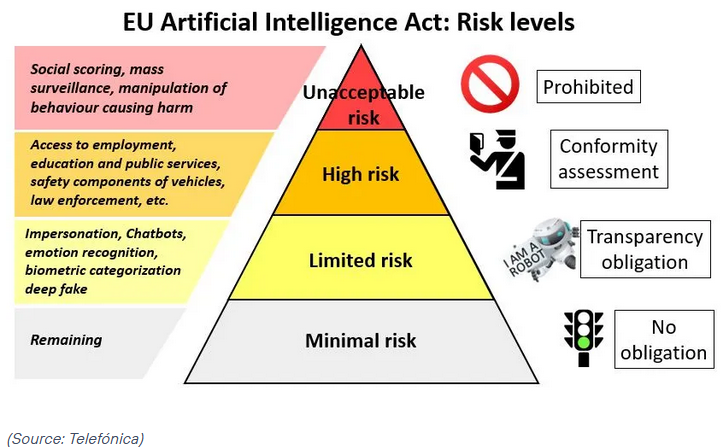

De nombreux risques découlant de l'IA sont par nature internationaux, et c'est donc par la coopération internationale que l'on peut le mieux y faire face. Nous décidons de travailler ensemble de manière inclusive pour garantir une IA centrée sur l'homme, digne de confiance et responsable, qui soit sûre et soutienne le bien de tous, par le biais des enceintes internationales existantes et d'autres initiatives pertinentes, afin de promouvoir la coopération pour faire face au large éventail de risques posés par l'IA. Ce faisant, nous reconnaissons que les pays devraient considérer l'importance d'une gouvernance et d'une approche réglementaire pro-innovation et proportionnée qui maximise les avantages et prend en compte les risques associés à l'IA. Cela pourrait inclure, le cas échéant, des classifications et des catégorisations de risques basées sur les circonstances nationales et les cadres juridiques applicables. Nous notons également la pertinence d'une coopération, le cas échéant, sur des approches telles que les principes communs et les codes de conduite. En ce qui concerne les risques spécifiques les plus susceptibles d'être liés à l'IA d'avant-garde, nous décidons d'intensifier et de maintenir notre coopération, et de l'élargir à d'autres pays, afin d'identifier, de comprendre et, le cas échéant, d'agir, dans le cadre des enceintes internationales existantes et d'autres initiatives pertinentes, y compris les futurs sommets internationaux sur la sécurité de l'IA.

Tous les acteurs ont un rôle à jouer pour garantir la sécurité de l'IA : les nations, les forums internationaux et autres initiatives, les entreprises, la société civile et le monde universitaire devront travailler ensemble. Notant l'importance d'une IA inclusive et de la réduction de la fracture numérique, nous réaffirmons que la collaboration internationale devrait s'efforcer d'engager et d'impliquer un large éventail de partenaires, le cas échéant, et nous nous félicitons des approches et des politiques axées sur le développement qui pourraient aider les pays en développement à renforcer leurs capacités en matière d'IA et à tirer parti du rôle habilitant de l'IA pour soutenir la croissance durable et combler le fossé du développement.

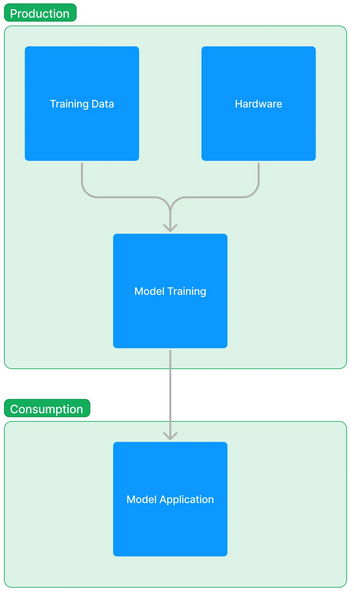

Nous affirmons que, si la sécurité doit être prise en compte tout au long du cycle de vie de l'IA, les acteurs qui développent des capacités d'IA d'avant-garde, en particulier les systèmes d'IA qui sont exceptionnellement puissants et potentiellement dangereux, ont une responsabilité particulièrement importante pour garantir la sécurité de ces systèmes d'IA, notamment par des systèmes d'essais de sécurité, des évaluations et d'autres mesures appropriées. Nous encourageons tous les acteurs concernés à faire preuve d'une transparence et d'une responsabilité adaptées au contexte en ce qui concerne leurs projets de mesure, de surveillance et d'atténuation des capacités potentiellement nuisibles et des effets associés qui pourraient en résulter, en particulier pour prévenir les abus et les problèmes de contrôle, ainsi que l'amplification d'autres risques.

Dans le cadre de notre coopération et afin d'éclairer l'action aux niveaux national et international, notre programme de lutte contre les risques liés à l'IA d'avant-garde sera axé sur les points suivants :

- l'identification des risques de sécurité de l'IA d'intérêt commun, la construction d'une compréhension scientifique commune et fondée sur des preuves de ces risques, et le maintien de cette compréhension au fur et à mesure que les capacités continuent à augmenter, dans le contexte d'une approche globale plus large pour comprendre l'impact de l'IA dans nos sociétés.

- l'élaboration de politiques respectives fondées sur les risques dans nos pays afin de garantir la sécurité à la lumière de ces risques, en collaborant le cas échéant, tout en reconnaissant que nos approches peuvent différer en fonction des circonstances nationales et des cadres juridiques applicables. Cela suppose, parallèlement à une transparence accrue de la part des acteurs privés qui développent des capacités d'IA d'avant-garde, de disposer de mesures d'évaluation appropriées et d'outils pour tester la sécurité, ainsi que de développer les capacités et la recherche scientifique pertinentes dans le secteur public.

Dans le cadre de ce programme, nous décidons de soutenir un réseau international de recherche scientifique sur la sécurité de l'IA d'avant-garde qui englobe et complète les collaborations multilatérales, plurilatérales et bilatérales existantes et nouvelles, y compris dans le cadre des enceintes internationales existantes et d'autres initiatives pertinentes, afin de faciliter la mise à disposition des meilleures données scientifiques disponibles pour l'élaboration des politiques et l'intérêt général.

Conscients du potentiel de transformation positive de l'IA, et dans le cadre d'une coopération internationale plus large sur l'IA, nous sommes résolus à maintenir un dialogue mondial inclusif qui fasse appel aux enceintes internationales existantes et à d'autres initiatives pertinentes et qui contribue de manière ouverte à des discussions internationales plus larges, et à poursuivre la recherche sur la sécurité de l'IA aux frontières afin de veiller à ce que les avantages de la technologie puissent être exploités de manière responsable, pour le bien et pour tous. Nous nous réjouissons de nous retrouver en 2024.

Quel est votre avis sur le sujet ?

Pensez-vous que le point de vue de M. Musk est crédible ou pertinent ?

Le G7 s'apprête à adopter un code de conduite pour les entreprises en matière d'IA, le code vise "à aider à saisir les avantages et à faire face aux risques et aux défis posés par ces technologies"

Le risque lié à l'IA est similaire à la crise climatique, le monde ne peut pas se permettre de retarder la réponse, selon Demis Hassabis, il prévoit la création d'un organisme international de l'IA

Les législateurs de l'UE progressent dans leurs négociations cruciales sur les nouvelles règles en matière d'IA

Répondre avec citation

Répondre avec citation

Partager