Les personnes intelligentes qui pensent que l’IA ne pourrait pas l’être plus qu’elles sont « bien plus bêtes qu’elles ne le pensent »,

D’après Elon Musk

Lorsqu’on parle d’intelligence artificielle, deux grands courants de pensée s’affrontent : celui des tiers qui pensent qu’il s’agit d’un outil, ce, sans plus et celui des intervenants et observateurs qui sont d’avis que ce n’est qu’une question de temps avant qu’elle ne devienne une menace pour la race humaine. Elon Musk fait partie de la seconde faction. C’est d’ailleurs pour cela que sa société Neuralink travaille sur des interfaces cerveau – machine à insérer dans le crâne pour préparer l’humanité à un « funeste » futur où les robots domineront sur elle. Le milliardaire de la Tech. tient à nouveau à prévenir : l’IA va surpasser les capacités cognitives de l’Homme.

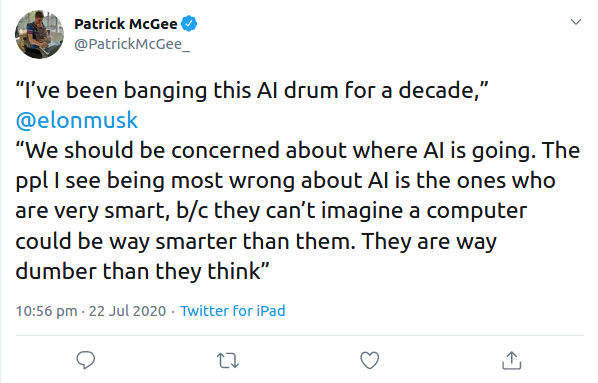

« Ça fait dix ans que je lance cette alerte. Nous devrions nous inquiéter de la direction que prend l'intelligence artificielle. Les personnes que je vois se tromper le plus sur ce sujet sont celles qui sont très intelligentes, ce, parce qu'elles ne peuvent pas imaginer qu'un ordinateur puisse être beaucoup plus intelligent qu'elles. C'est la faille de leur raisonnement. Elles sont juste beaucoup plus bêtes qu'elles ne le pensent », rapporte un correspondant du Financial Times.

De 2017 (où Elon Musk affirmait que l’intelligence artificielle est un risque fondamental pour l’humanité) à 2020 en passant par 2019 (où il a déclaré que l’IA est bien plus dangereuse que l’arme nucléaire), la position du milliardaire de la Tech. sur la question reste donc constante. Les craintes d’Elon Musk portent notamment sur ceci que les avancées dans la filière pourraient déboucher sur une intelligence artificielle dite générale (AGI). Ce serait alors la porte ouverte sur l’accomplissement de l’apocalypse. Des équipes de recherche comme celle d’OpenAI sont lancées sur ce couloir. Si l’on se réfère à des retours de scientifiques œuvrant dans le domaine, l’AGI pourrait nous tomber dessus dans 5 à 10 ans.

Les machines seraient alors dotées de « bon sens. » Au stade d’intelligence artificielle générale, elles seraient capables de réflexion causale, c’est-à-dire de cette capacité à raisonner sur « le pourquoi les choses se produisent. » C’est ce palier que les équipes de recherche dans le domaine visent. En attendant d’y être, l’intelligence artificielle actuelle fait montre de limites importantes. Bien qu’on s’appuie déjà sur celle-ci pour diagnostiquer des maladies, effectuer des traductions ou encore transcrire des paroles, le fait est qu’elle peut être mise en déroute par des cas de figure pour lesquels elle n’a pas été entraînée au préalable. À titre d’illustration, un système d’intelligence artificielle entraîné pour identifier des chats doit passer par un autre processus d’apprentissage pour pouvoir servir à la reconnaissance de chiens, ce, avec le risque de perdre une partie de l’expertise acquise sur la tâche initiale.

Les dérives à ce stade de l’avancée en matière d’intelligence artificielle sont déjà palpables. Au début du mois en cours, le laboratoire de recherche en informatique et intelligence artificielle du MIT a annoncé la mise hors ligne de façon permanente d’un énorme jeu de données qui a mené à des systèmes d’IA qui usent d’insultes racistes et misogynes. Le fameux problème du biais des données fournies aux intelligences artificielles (lors de leur phase d’entraînement) reprenait alors un coup de neuf. La même institution avait déjà illustré ce problème de biais de données fournies aux IA au travers de Norman – la première intelligence artificielle psychopathe. Les données utilisées pour l’entraînement de cette IA ont été tirées de l’une des sections de Reddit les plus obscures, « consacrée à documenter et observer la réalité dérangeante de la mort. » Le nom de ce “subreddit” n’a pas été cité, mais on sait qu’il sert d’endroit où des internautes partagent des vidéos choquantes décrivant des événements où des personnes trouvent la mort. Norman a donc été exposé à des images ultra-violentes, ce qui explique les tendances psychopathes de l’IA qui voit tout d’une perspective sépulcrale.

Dans cette catégorie d’IA biaisées, on retrouve un algorithme de reconnaissance faciale qui a, par « erreur », conduit Robert Julian-Borchak Williams, un Afro-Américain, à gérer des démêlés avec la justice. Après, la question est de savoir si les dérives ne pourraient pas être pires avec une intelligence artificielle générale.

Source : Twitter

Et vous ?

Quelle pertinence trouvez-vous aux différents propos d’Elon Musk en lien avec l’intelligence artificielle ? Sont-ils plus sensationnalistes qu’autre chose ?

Le fait qu’il n’y ait pas d’AGI pour le moment annule-t-il les prédictions d’Elon Musk ?

Est-il impossible que la recherche en la matière aboutisse à l’intelligence artificielle générale ?

Voir aussi :

La conduite autonome serait-elle à ce jour qu'une vision futuriste chez Tesla Motors*? L'entreprise vient de changer les objectifs de son Autopilot

La SEC demande à Musk de renoncer à son poste de président de Tesla et exige une amende de 40*millions*$ US pour un règlement à l'amiable

Tesla annonce que le nouvel ordinateur pour une conduite entièrement autonome de ses véhicules est en production et fera ses preuves ce mois-ci

Les actions Tesla chutent après que son système d'autopilote soit impliqué dans un accident et l'annonce des batteries de ses véhicules prenant feu

Répondre avec citation

Répondre avec citation

).

).

Partager