Une nouvelle application deepfake générée par l’IA créé des images de femmes nues en quelques secondes

Elle est maintenant supprimée de l’Internet

Le deepfake repousse les frontières de la falsification. La technologie d'apprentissage machine qu'il utilise a évolué à une vitesse vertigineuse depuis son apparition sur Internet en 2017. La toute dernière application de la technologie a été réalisée par un développeur qui se fait appeler Alberto. C’est un logiciel alimenté par l'intelligence artificielle qui permet à quiconque, sans aucune connaissance technique, de générer facilement des images réalistes de femmes nues simplement en fournissant à l’application une image habillée de la cible visée.

Le logiciel baptisé DeepNude par son développeur échange des vêtements contre des seins nus et autres parties intimes de la femme, selon un article publié par Motherboard le mercredi. DeepNude travaille également sur des images des hommes, mais pas pour exposer le sexe masculin. Lorsque Motherboard l’a essayé sur une image d'un homme, l’application a effectué les mêmes modifications comme s’il s’agissait d’une femme. Avec les images de femmes, Motherboard a rapporté que DeepNude semble fonctionner mieux sur des images où la personne expose déjà une grande partie de la peau. DeepNude est très facile à utiliser et plus rapide à créer que les précédents deepfakes.

Lancée le 23 juin sous la forme d'un site Web qui montre un exemple du fonctionnement du logiciel, DeepNude est le dernier exemple de Deepfake généré par l'IA et utilisé pour créer des images compromettantes et faire honte, harceler et intimider les cibles féminines, même si son créateur dit qu’il l’a créé pour le divertissement des utilisateurs. Le logiciel qui a été repéré pour la première fois par Samantha Cole de Motherboard pouvait être téléchargé gratuitement pour Windows et Linux. La version Windows que Motherboard a testée s'installe et se lance comme n'importe quelle autre application Windows et ne nécessite pas d'expertise technique pour l'utiliser.

Motherboard a rapporté que dans la version gratuite de l'application, les images de sortie sont partiellement recouvertes d'un grand filigrane. Dans une version payante, qui coûte 50 dollars, le filigrane est supprimé, mais un timbre portant la mention « FAKE » est placé dans le coin supérieur gauche, - mais ce « faux » timbre pourrait être facilement enlevé avec Photoshop, par exemple, d’après le magazine.

Katelyn Bowden, fondatrice et PDG de l'organisation Badass, qui milite contre la pornodivulgation, a déclaré à Motherboard :

« C'est absolument terrifiant ». « Maintenant, n'importe qui peut se retrouver victime d’une pornodivulgation, sans jamais avoir pris une photo de nudité. Cette technologie ne devrait pas être accessible au public », a-t-elle ajouté.

Danielle Citron, professeure de droit à la faculté de droit Carey de l'Université du Maryland, qui a récemment témoigné devant le Congrès au sujet de la menace du deepfake, a également déclaré à Motherboard qu’il s'agit là d'une « invasion de la vie privée sexuelle », en parlant de DeepNude qui est vendu au grand public. « Oui, ce n'est pas votre vrai vagin, mais... les autres pensent qu'ils vous voient nue », a-t-elle dit avant d’ajouter : « Comme me l'a dit une fausse victime, des milliers de personnes l'ont vue nue, elle avait l'impression que son corps n'était plus le sien ».

La divulgation d’applications deepefake se succède depuis quelque temps. Pas plus tard qu’au début de ce mois de juin, les scientifiques de l'Université de Stanford, de la Max Planck Institute for Informatics, de l'Université de Princeton et d'Adobe Research ont présenté un nouveau logiciel qui utilise l’apprentissage machine pour permettre aux utilisateurs de modifier la transcription du texte d’une vidéo afin d’ajouter, de supprimer ou de modifier les mots sortant de la bouche de quelqu'un. La multiplication de ce type d’applications alimentées par l’IA montre comment il est maintenant facile de créer des faux réalistes, même si la qualité de la production est variée pour l’instant.

C’est le cas avec l’application DeepNude. Motherboard l'a testée sur plus d'une douzaine d'images de femmes et d'hommes, dans différents états d'habillement – d’entièrement vêtus aux en maillots de bain – et avec une variété de couleur de peau. Les résultats ne sont certainement pas photoréalistes, et lorsqu'on les examine de près, les images sont faciles à repérer comme étant fausses. La peau créée par l'IA est floue et pixélisée. Mais le processus fonctionne mieux sur des images haute résolution et lorsque la cible porte des vêtements qui expose une grande partie de la peau comme un maillot de bain. Selon Motherboard, DeepNude a échoué avec certaines photographies qui utilisaient des angles, des éclairages ou des vêtements bizarres qui semblent perturber le réseau neuronal qu'il utilise.

Comment l’application DeepNude a-t-elle été conçue ?

Le développeur de l’application a adressé un courriel à Motherboard dans lequel il a expliqué comment DeepNude a été conçu. Voici la déclaration du développeur que Motherboard a rapporté :

« le logiciel est basé sur pix2pix, un algorithme open source développé par les chercheurs de l'Université de Californie à Berkeley en 2017. Pix2pix utilise des réseaux adverses génératifs (GANs), qui fonctionnent en formant un algorithme sur un énorme ensemble d'images – dans le cas de DeepNude, plus de 10 000 photos de femmes nues, selon le programmeur. Cet algorithme est similaire à ce qui est utilisé dans les vidéos deepfake, et à ce que les voitures autonomes utilisent pour « imaginer » des scénarios routiers ».

Selon le développeur, l'algorithme ne fonctionne qu'avec les femmes, parce que les images de femmes nues sont plus faciles à trouver en ligne, mais il espère aussi créer une version masculine. Mais maintenant qu’il a dû retirer son logiciel de l’Internet sous la pression des critiques, les futures versions ne seront pas divulguées.

Alberto a continué à décrire son logiciel en disant : « Les réseaux sont multiples, car chacun a une tâche différente : localiser les vêtements. Masquer les vêtements. Précisez les positions anatomiques. Rendre l’image ». « Tout cela ralentit le traitement (30 secondes dans un ordinateur normal), mais cela peut être amélioré et accéléré à l'avenir », a-t-il ajouté.

Le créateur de l'application a dit à Motherboard qu'il était inspiré par les souvenirs d'anciennes publicités de bandes dessinées pour « X-ray specs », qui promettaient qu'elles pourraient être utilisées pour voir à travers les vêtements des gens. « Comme tout le monde, j'étais fasciné par l'idée qu'elles pouvaient vraiment exister et ce souvenir est resté », a dit Alberto.

Dans son courriel, il a aussi dit qu’il est « un passionné de technologie » plutôt qu’ « un voyeur », et motivé par la curiosité et l'enthousiasme pour l'IA, ainsi que par le désir de voir si ses expériences lui permettraient de faire un « retour économique ». Il a dit : « Récemment, également en raison d'échecs antérieurs (autres Startups) et de problèmes économiques, je me suis demandé si je pouvais avoir un retour économique de cet algorithme. C'est pourquoi j'ai créé DeepNude ». Alberto s’est appuyé sur des raisons économiques pour lancer son application qui déshabille les femmes.

Il s’est tout de même penché sur le potentiel de dommages causés par ce logiciel pendant qu’il travaillait sur son projet, d’après son courriel à Motherboard, mais il a finalement décidé que ce n'était pas un obstacle. « Je me suis aussi dit : la technologie est prête (à la portée de tous) », a dit Alberto. « Donc si quelqu'un a de mauvaises intentions, avoir DeepNude ne change pas grand-chose... Si je ne le fais pas, quelqu'un d'autre le fera dans un an », a-t-il ajouté. Pendant ce temps la technologie se sophistique dangereusement.

S’adressant à un site Web d’information américain, Alberto a dit que l'application avait été créée pour le plaisir et qu'il ne s'attendait pas à ce qu'elle devienne si populaire. Il a comparé le logiciel à Photoshop, en disant qu’il peut être utilisé pour obtenir les mêmes résultats que DeepNude « après une demi-heure de tutoriel sur Youtube ». Il a également ajouté que si les gens commençaient à utiliser le logiciel à des fins malveillantes, « nous l'abandonnerions à coup sûr ».

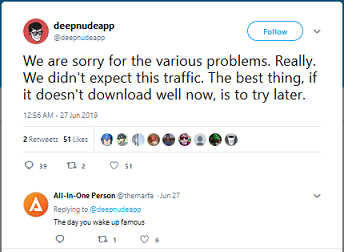

Et Alberto a effectivement abandonné son projet – la vente de DeepNude au grand public –, seulement quatre jours après le lancement de l’application. Il a annoncé jeudi qu'il était en train de supprimer le logiciel, après une réaction brutale et virale du public contre la façon dont son application dégrade l’image de la femme. Après la publication de l’article de Motherboard, le serveur de téléchargement l'application, s’est planté.

Jeudi après-midi, le compte Twitter de DeepNude a annoncé que l'application était supprimée et aucune autre version ne sera publiée et personne d'autre ne sera autorisé à utiliser l'application. « Nous avons créé ce projet pour le divertissement des utilisateurs il y a des mois ». « Nous pensions faire quelques ventes chaque mois de façon contrôlée... Nous n'avons jamais pensé qu'il deviendrait viral et que nous ne pourrions pas contrôler le trafic », a-t-il ajouté dans une déclaration jointe au tweet.

Alberto a également dit dans son communiqué de renoncement : « Nous ne voulons pas faire de l'argent de cette façon. Certaines copies de DeepNude seront sûrement partagées sur le web, mais nous ne voulons pas être ceux qui les vendront ».

L’évolution du processus de la règlementation sur la technologie de deepfake

Pendant que la technologie du deepfake se développe chaque jour et que les usages se diversifient, la discussion sur ses méfaits potentiels se concentre uniquement sur la désinformation et la propagande politique, son utilisation à d’autres fins comme pour cibler les femmes, y compris l’utilisation dans l’industrie du porno, demeure dans une zone d'ombre juridique depuis que la technologie fait son chemin. Les avocats affirmant que les nus générés par l'IA pourraient constituer de la diffamation, mais que les retirer d'Internet constituerait une violation possible du Premier Amendement. Une exception à cela pourrait être si la technologie est utilisée pour créer des images nues de mineurs - quelque chose dont DeepNude semble capable de faire.

En février dernier, un sénateur a proposé un projet de loi prohibant l'utilisation de la technologie deepfake, parce que les sénateurs pensent le deepfake pourrait être utilisées dans le cadre de campagnes de désinformation plus larges par exemple dans l’optique d’influencer des élections en diffusant des fake news qui pourraient alors paraître plus crédibles.

Cependant, à l'heure actuelle, les politiciens du monde entier commencent à envisager les préjudices potentiels causés par les deepfakes, y compris aux États-Unis, toutefois, une telle législation sera lente à se mettre en place, la principale priorité des législateurs étant d'arrêter la diffusion de la désinformation politique.

Source: Motherboard (1 & 2), Tweet de DeepNude

Et vous ?

Qu’en pensez-vous ?

Quel commentaire faites-vous de la facilité avec laquelle quiconque peut créer une image de femme nue ?

Que pensez-vous du développement rapide de la technologie du deepfake ?

Pensez-vous qu’une législation générale sur les deepfakes verra le jour bientôt ?

Lire aussi

Deepfake : des chercheurs présentent un logiciel qui permet d'éditer le discours d'une vidéo, et faire dire au sujet ce que vous voulez

Les législateurs US estiment que la technologie deepfake constitue une menace à la sécurité nationale, et appellent à des contremesures

Un sénateur propose un projet de loi prohibant l'utilisation de la technologie deepfake, si elle venait à servir des buts frauduleux

L'IA peut désormais détecter les deepfakes en recherchant des mouvements faciaux étranges, selon une étude

Ce Deepfake de Zuckerberg teste les règles de suppression de vidéos de Facebook, alors qu'il avait déclaré qu'une telle vidéo resterait en ligne

Répondre avec citation

Répondre avec citation

</troll>

</troll>

Partager