IBM a conçu un algorithme d'apprentissage automatique non supervisé exploitant le calcul en mémoire

Qui peut trouver des applications dans l’IA

Le « calcul en mémoire » est un concept émergent qui utilise les propriétés physiques des dispositifs de mémoire à la fois pour stocker et traiter des informations. Une machine exploitant ce concept peut mettre en cache de très grandes quantités d’informations et stocker les données à manipuler directement dans la RAM plutôt que d’utiliser l’espace de stockage offert par les disques durs classiques. De cette manière, elle supprime les exigences en termes de transactions ACID (atomicité, cohérence, isolation et durabilité) et E/S (entrées et sorties) des applications OLTP (online transaction processing), ce qui accélère considérablement l’accès aux données puisque les données sont disponibles quasi instantanément (temps de réponse extrêmement rapide).

Ce mode de fonctionnement va à l’encontre de celui observé sur les appareils classiques exploités actuellement. Ces derniers sont conçus suivant le concept de « Von Neumann » qui nécessite la transmission de données entre les différents dispositifs de mémoire et l’unité de calcul afin de compléter les procédures de traitement. À cause de leur architecture et de leur mode de fonctionnement particuliers, les appareils de type « non Von Neumann » effectuent les opérations plus rapidement et sont moins énergivores que leurs homologues « Von Neumanniens » traditionnels.

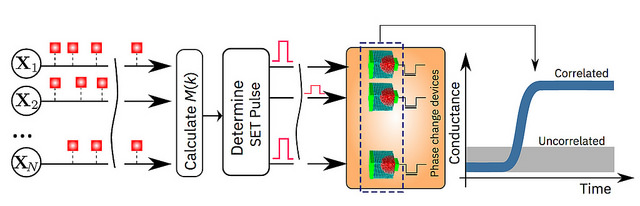

L’entreprise américaine IBM a récemment annoncé que ses scientifiques ont réussi à démontrer qu’un algorithme d’apprentissage automatique non supervisé, fonctionnant sur un million de dispositifs de mémoire à changement de phase (PCM), a réussi à trouver des corrélations temporelles dans des flux de données inconnus. Ci-dessous, une illustration de l'algorithme :

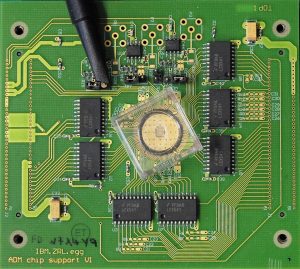

Les chercheurs ont utilisé des dispositifs PCM fabriqués à partir d’un alliage de germanium et d’antimoine-tellurure, qui est empilé et pris en sandwich entre deux électrodes (voir schéma ci-dessous). Lorsque ce matériau est chauffé avec l’aide d’un faible courant électrique, son état amorphe caractérisé par un arrangement atomique désordonné se modifie et il devient cristallin, un état caractérisé par une configuration atomique ordonnée. Les détails relatifs à cette étude sont donnés dans un article paru dans le média Nature Communications.

Comparée aux ordinateurs classiques les plus avancés utilisés actuellement, la technologie d’avant-garde développée par IBM offrirait des améliorations en termes de vitesse de calcul (jusqu’à 200 fois) et en termes d’efficacité énergétique. Ces caractéristiques la rendent particulièrement adaptée pour la conception de systèmes informatiques ultra denses, peu gourmands en énergie et massivement parallèles qui sont très appréciés dans le domaine de l'intelligence artificielle (IA).

« C’est une avancée importante dans notre recherche sur la physique de l’IA, qui explore de nouveaux matériaux, dispositifs et architectures matérielles », explique le Dr Evangelos Eleftheriou, Fellow d'IBM et co-auteur de la publication.

Pour éprouver la technologie qu’ils ont mise au point, les chercheurs d’IBM ont choisi deux exemples basés sur le temps. Ils ont ensuite comparé leurs résultats avec des méthodes traditionnelles d’apprentissage automatique telles que le clustering et k-means. Ils présenteront encore une autre application de leur dispositif exploitant le calcul en mémoire pendant la conférence de l’IEDM (International Electron Devices Meeting) qui se tiendra en décembre de cette année.

« La mémoire a, jusqu’ici, été considérée comme un lieu où nous stockons simplement des informations. Mais dans ce travail, nous montrons de façon concluante comment nous pouvons exploiter la physique de ces dispositifs de mémoire pour effectuer une primitive de calcul de haut niveau. Le résultat du calcul est également stocké dans les dispositifs de mémoire, et dans ce sens, le concept s'inspire en quelque sorte de la façon dont le cerveau calcule », a déclaré le Dr Abu Sebastian, chercheur exploratoire et spécialiste des technologies cognitives. Il dirige également un projet financé par le Conseil européen de la recherche sur ce sujet.

Source : Blog IBM, Nature

Et vous ?

Qu’en pensez-vous ?

Voir aussi

AutoML : la machine d'intelligence artificielle de Google qui a appris à se répliquer serait meilleure que les ingénieurs pour créer d'autres IA

L'intelligence artificielle : clé du futur pour dominer sur les nations, d'après le président russe, Vladimir Poutine

Répondre avec citation

Répondre avec citation

Partager