Des deepfakes à la surveillance de masse, voici les onze dangers liés à l'utilisation de l'intelligence artificielle,

selon Devathon

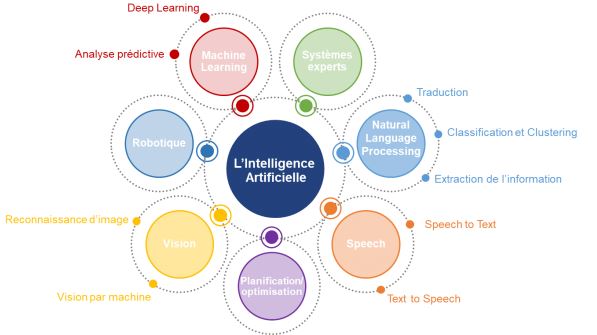

L'intelligence artificielle est définie par Marvin Lee Minsky, l'un de ses créateurs, comme « la construction de programmes informatiques qui s'adonnent à des tâches qui sont, pour l'instant, accomplies de façon plus satisfaisante par des êtres humains, car elles demandent des processus mentaux de haut niveau tels que : l'apprentissage perceptuel, l'organisation de la mémoire et le raisonnement critique ».

De plus en plus d'entreprises, de gouvernements et d'organisations utilisent l'IA pour gérer leur quotidien plus simplement du fait qu'elle recouvre de nombreux domaines fonctionnels.

Panorama des domaines de l'IA, source : Artik Consulting

Toutefois, l'intelligence artificielle peut être utilisée à des fins nocives par les malfaiteurs. Ces derniers peuvent en effet avoir facilement accès aux algorithmes d'IA open source et mettre au point de puissantes menaces.

Parmi ces nombreuses menaces, l'entreprise de conception et de développement de sites web pour les jeunes pousses, Devathon, en a listé les 11 les plus prolifiques. Les voici :

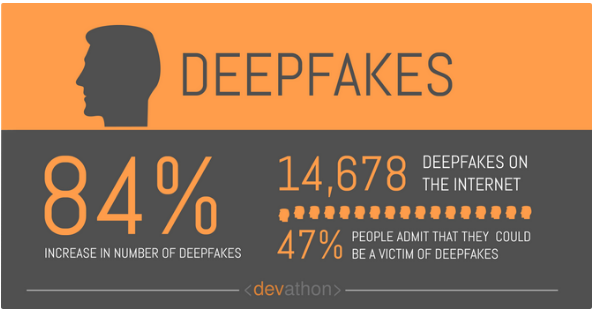

Les Deepfakes

Ce sont des images et des vidéos créées ou modifiées grâce à l'intelligence artificielle dans le but de diffamer des célébrités et des politiciens. Si le nombre de deepfakes est en constante augmentation et que la qualité des images et des vidéos s'améliore de jour en jour, la détection des faux contenus devient de plus en plus difficile, d'autant que les gens ont même du mal à faire confiance à un contenu authentique.

Les campagnes de désinformation sophistiquées

Sur ce cas, Devathon évoque le générateur automatique de texte GPT-2, mis au point par OpenAI. Cet outil peut créer un contenu ressemblant à de véritables nouvelles.

Néanmoins, l'IA peut fournir des solutions pour identifier les campagnes de fake news à l'image du système nommé BotSlayer, qui identifie les tendances des fausses nouvelles et détecte les comptes Twitter qui publient ces informations.

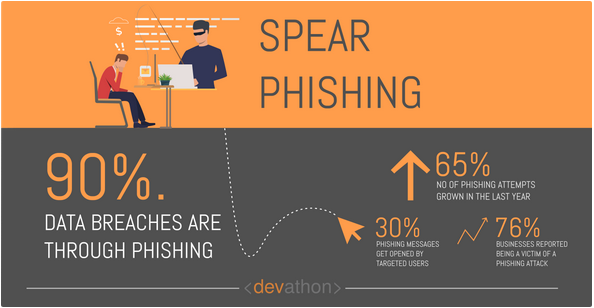

Le phishing

Devathon explique que « les attaques par hameçonnage propulsées par l'IA posent un risque de cybersécurité important. L'IA peut passer au crible un grand ensemble de données d'informations personnelles beaucoup plus rapidement que ne le pouvaient les logiciels antérieurs. Grâce aux algorithmes ML qui reconnaissent les modèles avec des jeux de données, l'IA peut créer des e-mails spécifiques au contexte pour lancer des attaques de phishing. Ces mêmes algorithmes peuvent également identifier suffisamment d'informations dans les grands ensembles de données pour créer des e-mails d'hameçonnage hautement personnalisés ».

Néanmoins, l'IA peut elle-même être utilisée pour prévenir ces attaques, grâce notamment à l'utilisation des modèles de classification et de « réseaux de neurones artificiels ».

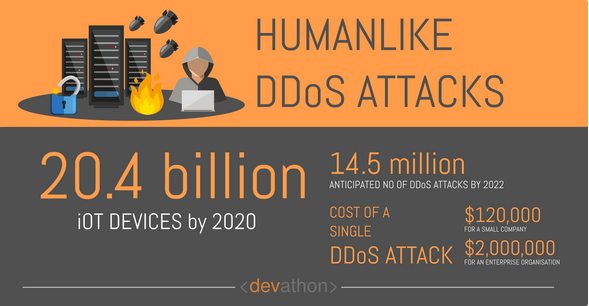

Les attaques DDoS (déni de service distribué)

Une attaque DDoS consiste à envoyer plusieurs requêtes à la ressource Web cible afin d'empêcher les utilisateurs légitimes de la manipuler. « Les cybercriminels ont commencé à utiliser des systèmes basés sur l'IA pour lancer ces attaques et les algorithmes de machine learning (ML) supervisés et non supervisés jouent un rôle ici », explique Devathon.

Une seule attaque coûte environ 111 000 euros pour une petite société contre 1,85 million d'euros pour une grande entreprise ou une organisation. Et le nombre prévu d'attaques DDoS d'ici 2022 est de 14,5 millions, note l’auteur de cette liste.

L'utilisation des chatbots

Les cybercriminels peuvent obtenir des informations sensibles concernant leur cible grâce aux chatbots. Pour ce faire, ils collectent d'abord des informations concernant leurs victimes potentielles. Ensuite, ils peuvent lancer des conversations assez réalistes avec les cibles. D'ailleurs, sachant que les chatbots sont conçus pour répondre aux requêtes des utilisateurs, ils pourraient simplement inciter ces personnes à visiter un site contenant des logiciels malveillants.

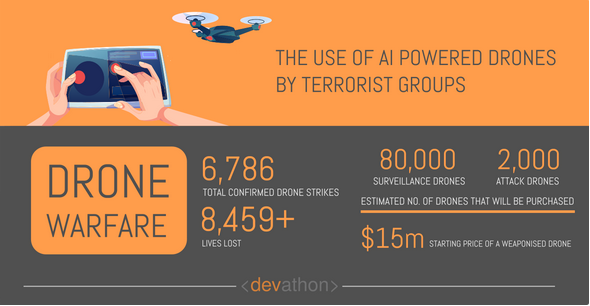

Les drones et les véhicules autonomes armés et pilotés par les groupes terroristes

Le marché des drones militaires étant en constante évolution, les groupes terroristes peuvent, eux aussi, avoir des drones tueurs. L'État islamique a par exemple utilisé des appareils de ce type pour mener une attaque en 2016 dans le nord de l'Irak. Et l'accessibilité des capacités d'intelligence artificielle, qui sont disponibles sous forme de bibliothèques open source, aggrave le problème.

« Un groupe terroriste comme l'État islamique peut désormais tirer parti des technologies disponibles dans le commerce et lancer des attaques terroristes à une distance considérable. Il réduit considérablement ses risques. De plus, il ne coûte pas cher. L'effet global équivaut à une réduction significative du seuil de lancement d'une attaque terroriste, et cela devrait concerner la communauté mondiale », analyse Devathon.

Par ailleurs, les véhicules autonomes représentent également une menace. Grâce à cette technologie, les terroristes arriveraient à piloter des véhicules chargés d'explosifs pour atteindre leur cible de façon plus précise, sans avoir recours à des kamikazes.

Devathon recommande ainsi de mettre en place des réglementations « efficaces et pragmatiques » afin d'éviter que les drones et les véhicules autonomes arrivent aux mains des groupes terroristes.

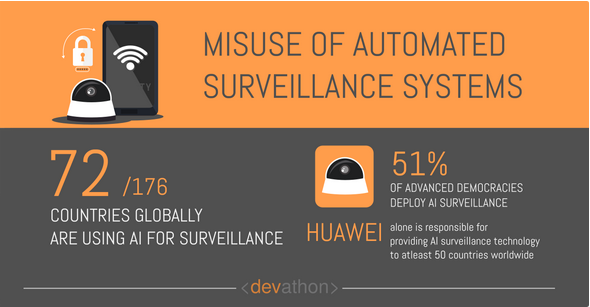

L'utilisation abusive de l'IA pour la surveillance de masse

Grâce à l'IA, les États arrivent à mieux sécuriser leurs populations, les installations de grande valeur ou les infrastructures gouvernementales. Toutefois, utilisée de façon abusive, elle pourrait permettre à un État de supprimer la dissidence.

Par exemple, la Chine avait déjà utilisé cette technique dans sa province de Xinjiang afin de surveiller les Ouïghours et d'autres minorités musulmanes.

Les « Swarm »

Concernant les Swarm, Devathon cite la société de cybersécurité Fortinet, qui envisage le remplacement des botnets par des « Hivenets », des « ruches » d'appareils qui, grâce à l'IA, développent des capacités d'autoapprentissage, leur permettant de cibler des systèmes vulnérables à plus grande échelle et avec plus de précision. Selon Devathon, « l'IA leur donnera la capacité de communiquer entre eux et de coordonner leurs actions, réduisant ainsi le besoin d'interventions manuelles de la part des cyberattaquants ».

Le « data poisoning »

Il y a deux types d'attaques d'empoisonnement de données : celles qui touchent la disponibilité du système ML de la victime potentielle et celles qui impactent l'intégrité de ce système.

Dans le premier cas, le hacker injecte des mauvaises données en grande quantité, rendant inutiles les limites statistiques apprises par le modèle ML tandis que dans le deuxième cas, l'attaquant injecte des données non apprises par le concepteur du système ML. Les attaques les plus courantes concernent les filtres antispam de Gmail. Les hackers utilisent le « data poisoning » pour que le classificateur de Gmail ne détecte pas les spams.

Le « déni d’informations »

« Le « déni d'informations » est un terme assez large dans le contexte des cyberattaques, et il inclut tous les types de cyberattaques qui rendent difficile pour les utilisateurs de recueillir des informations utiles et pertinentes. Prenez, par exemple, les courriers indésirables dans votre boîte aux lettres qui détournent votre attention de votre tâche de collecte d'informations utiles. Les spams inondent vos canaux d'information d'informations fausses ou distrayantes », indique Devathon.

Si les attaques sont devenues plus efficaces grâce aux robots alimentés par l'IA, l’entreprise conseille aux organisations de « défier les cybercriminels avec une technologie supérieure, qui comprendrait l'IA. Par exemple, les organisations doivent aller au-delà de leurs portails de connexion de base et implémenter la télémétrie avancée. Ces solutions analysent le contexte, le comportement et la réputation passée des utilisateurs pour les classer comme authentiques ou contrefaits ».

L'utilisation de l'IA pour identifier les cibles vulnérables

Les cibles vulnérables sont privilégiées par les hackers. Ces derniers peuvent en effet réaliser une attaque efficace et à moindre coût en visant ce type de cible. Pour les identifier, les attaquants utilisent des outils basés sur l'IA afin d'analyser les réseaux et déterminer la vulnérabilité d'une cible.

L'atténuation proactive des vulnérabilités reste la seule solution. « Les organisations doivent entreprendre des évaluations complètes des risques de cybersécurité, par la suite, elles doivent atténuer les principaux risques. Ils ne peuvent pas laisser les tests de sécurité et de conformité comme le dernier élément d'une liste de contrôle, ils doivent plutôt démontrer une approche proactive », note Devathon.

« Dans certains cas, le développement de solutions d'IA encore plus puissantes pourrait aider à atténuer certains des dangers posés par l'IA. Dans d'autres cas, une réglementation efficace peut empêcher la technologie de tomber entre les mains de terroristes, tandis que le respect significatif des lois internationales peut empêcher son utilisation abusive par des États autoritaires. Une utilisation judicieuse de l'IA est importante si vous souhaitez réaliser la vraie valeur de cette technologie prometteuse », conclut Devathon.

Source : Devathon

Et vous ?

Que pensez-vous des dangers de l'IA énumérés par Devathon ? Pertinents ou pas ?

Quels autres dangers trouvez-vous pour l'IA ?

Que préconiseriez-vous pour faire face à ces dangers de l'IA ?

Voir aussi :

L'IA peut être facilement induite en erreur par des attaques contradictoires. Devrait-on s'en inquiéter ?

L'intelligence artificielle est-elle l'arme de la prochaine guerre froide ? Oui répond un chercheur en informatique

Perspectives cybercécurité 2018 : Fortinet prévient contre les botnets intelligents, des « swarms » dotés de capacités d'autoapprentissage

« L'IA ne peut pas nous protéger contre les deepfakes », selon un rapport de Data & Society, qui préconise une solution tenant compte à la fois de l'histoire et des processus sociaux

Une fuite de données révèle que la Chine suit près de 2,6 millions de personnes dans Xinjiang, avec 6,7 millions de données GPS collectées en 24h

Répondre avec citation

Répondre avec citation

Partager