Les améliorations de performance dans nos processeurs n'ont cessé ces dernières années, mais à un rythme plus lent. Les moins jeunes se souviennent d'une époque où changer de PC tous les deux ou trois ans avait un véritable intérêt, le gain de performance (notamment grâce à des fréquences plus élevées) le justifiant pour bon nombre d'usages. Maintenant, on se satisfait d'un gain d'à peine une dizaine de pour cent d'une génération à l'autre, une augmentation de quinze à vingt étant très significative : l'architecture Sunny Cove d'Intel apporte une telle amélioration par rapport à Coffee Lake, cela faisait des années que le chiffre n'était pas aussi élevé. Les changements concernent à la fois l'architecture interne des processeurs, mais aussi le processus de fabrication (qui permet d'imprimer trente-huit pour cent de transistors en plus, sans augmentation de fréquence). L'écart entre le nombre de transistors supplémentaires et l'amélioration de performance est important.

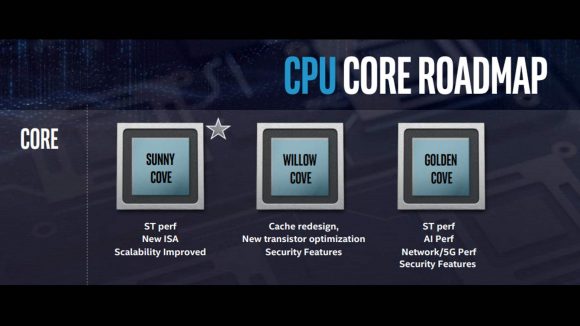

L'architecture qui suivra Sunny Cove, Willow Cove, devrait se rapprocher d'une relation linéaire entre l'augmentation de performance et le nombre de transistors. C'est tout du moins l'avis de Jim Keller, vice-président d'Intel depuis 2018. De fait, un processeur est certes le résultat du travail acharné d'un très grand nombre de personnes, mais surtout d'un grand nombre de petites équipes : chacune peut améliorer significativement sa partie, pour apporter des gains à l'échelle du processeur. En effet, la partie calcul d'un processeur actuel représente approximativement un tiers de sa consommation d'énergie, une fraction un peu plus grande des transistors : le reste sert d'interfaces avec les autres composants de l'ordinateur.

Intel planifie l'avenir de ses processeurs sur plus d'une dizaine d'années, avec pour objectif actuel de multiplier le nombre de transistors par processeur par cinquante. Chaque étape intermédiaire de cette feuille de route prévoit d'énormes changements pour arriver à une croissance linéaire. Par exemple, un processeur Sunny Cove maintient une fenêtre de huit cent instructions à exécuter, avec un rythme de trois à six instructions exécutées par cycle, à l'aide d'énormes prédicteurs : les prochaines générations devraient augmenter ces chiffres pour atteindre le niveau de performance espéré.

Source : Intel’s next-gen CPU architecture will be “significantly bigger” than Sunny Cove.

Répondre avec citation

Répondre avec citation

)

)

Partager