Des scientifiques créent des modèles d'IA capables de dialoguer entre eux et de transmettre des compétences avec une intervention humaine limitée.

Les scientifiques ont modélisé des capacités de communication et de transfert de connaissances semblables à celles des humains entre les IA, afin qu'elles puissent s'enseigner mutuellement à effectuer des tâches sans disposer d'une énorme quantité de données de formation. La prochaine évolution de l'intelligence artificielle (IA) pourrait résider dans des agents capables de communiquer directement et de s'enseigner mutuellement des tâches, selon les résultats de la recherche.

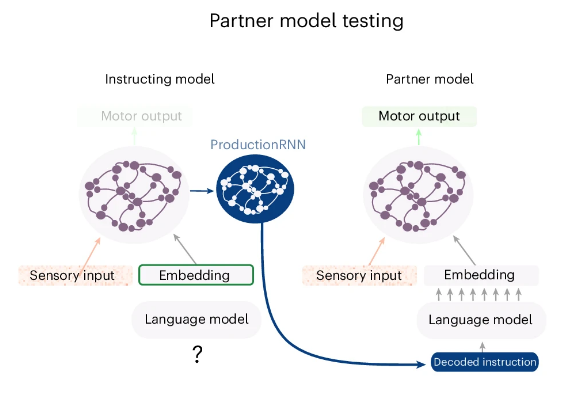

Réaliser une nouvelle tâche sur la seule base d'instructions verbales ou écrites, puis la décrire à d'autres pour qu'ils la reproduisent, est une pierre angulaire de la communication humaine qui résiste encore à l'intelligence artificielle (IA). Une équipe de l'Université de Genève (UNIGE) a réussi à modéliser un réseau neuronal artificiel capable de cette prouesse cognitive. Après avoir appris et effectué une série de tâches de base, cette IA a été capable d'en fournir une description linguistique à une IA "sœur", qui les a exécutées à son tour.

Les scientifiques ont modélisé un réseau d'IA capable d'apprendre et d'exécuter des tâches uniquement sur la base d'instructions écrites. Cette IA décrit ensuite ce qu'elle a appris à une IA "sœur", qui exécute la même tâche bien qu'elle n'ait reçu aucune formation préalable et n'ait aucune expérience en la matière. La première IA a communiqué avec sa sœur en utilisant le traitement du langage naturel (NLP), expliquent les scientifiques.

Cette IA composite - un "réseau neuronal sensorimoteur-récurrent (RNN)" - a ensuite été entraînée à un ensemble de 50 tâches psychophysiques. Ces tâches consistaient à répondre à un stimulus - comme une réaction à une lumière - à l'aide d'instructions fournies par le modèle de langage S-Bert. Grâce au modèle de langage intégré, le RNN comprenait des phrases écrites complètes. Cela lui a permis d'effectuer des tâches à partir d'instructions en langage naturel, en obtenant 83 % de réponses correctes en moyenne, bien qu'il n'ait jamais vu de séquences d'entraînement ni effectué les tâches auparavant.

Cette compréhension a ensuite été inversée pour que le RNN puisse communiquer les résultats de son apprentissage sensorimoteur à l'aide d'instructions linguistiques à une IA sœur identique, qui a exécuté les tâches à son tour, sans jamais les avoir effectuées auparavant.

Faire comme les humains

Cette recherche a été inspirée par la façon dont les humains apprennent en suivant des instructions verbales ou écrites pour effectuer des tâches, même s'ils n'ont jamais réalisé de telles actions auparavant. Cette fonction cognitive distingue les humains des animaux ; par exemple, il faut montrer quelque chose à un chien avant de pouvoir l'entraîner à répondre à des instructions verbales.

Si les chatbots dotés d'une IA peuvent interpréter des instructions linguistiques pour générer une image ou un texte, ils ne peuvent pas traduire des instructions écrites ou verbales en actions physiques, et encore moins expliquer les instructions à une autre IA. Toutefois, en simulant les zones du cerveau humain responsables de la perception du langage, de l'interprétation et des actions basées sur des instructions, les chercheurs ont créé une IA dotée de capacités d'apprentissage et de communication semblables à celles des humains.

Ce résultat ne conduira pas à lui seul à l'essor de l'intelligence artificielle générale (AGI), où un agent d'IA peut raisonner aussi bien qu'un humain et accomplir des tâches dans de multiples domaines. Mais les chercheurs ont noté que des modèles d'IA comme celui qu'ils ont créé peuvent nous aider à comprendre le fonctionnement du cerveau humain. Il est également possible que les robots dotés d'une IA intégrée communiquent entre eux pour apprendre et exécuter des tâches. Si un seul robot recevait les instructions initiales, il pourrait être très efficace dans la fabrication et la formation d'autres industries automatisées.

"Le réseau que nous avons développé est très petit", expliquent les chercheurs dans leur communiqué. "Rien n'empêche désormais de développer, sur cette base, des réseaux beaucoup plus complexes qui seraient intégrés dans des robots humanoïdes capables de nous comprendre mais aussi de se comprendre entre eux.''

Deux intelligences artificielles dialoguent

Effectuer une nouvelle tâche sans entraînement préalable, sur la seule base d'instructions verbales ou écrites, est une capacité humaine unique. De plus, une fois la tâche apprise, nous sommes capables de la décrire pour qu'une autre personne puisse la reproduire. Cette double capacité nous distingue des autres espèces qui, pour apprendre une nouvelle tâche, ont besoin de nombreux essais accompagnés de signaux de renforcement positifs ou négatifs, sans pouvoir la communiquer à leurs congénères.

Un sous-domaine de l'intelligence artificielle (IA) - le traitement du langage naturel - cherche à recréer cette faculté humaine, avec des machines qui comprennent et répondent à des données vocales ou textuelles. Cette technique repose sur des réseaux de neurones artificiels, inspirés de nos neurones biologiques et de la manière dont ils se transmettent des signaux électriques dans le cerveau. Cependant, les calculs neuronaux qui permettraient de réaliser l'exploit cognitif décrit ci-dessus sont encore mal compris.

"Actuellement, les agents conversationnels utilisant l'IA sont capables d'intégrer des informations linguistiques pour produire un texte ou une image. Mais, à notre connaissance, ils ne sont pas encore capables de traduire une instruction verbale ou écrite en une action sensorimotrice, et encore moins de l'expliquer à une autre intelligence artificielle pour qu'elle la reproduise", explique Alexandre Pouget, professeur ordinaire au Département des neurosciences fondamentales de la Faculté de médecine de l'UNIGE.

Un cerveau modèle

Le chercheur et son équipe ont réussi à développer un modèle neuronal artificiel doté de cette double capacité, moyennant un entraînement préalable. "Nous sommes partis d'un modèle existant de neurones artificiels, S-Bert, qui compte 300 millions de neurones et qui est pré-entraîné à comprendre le langage. Nous l'avons "connecté" à un autre réseau plus simple de quelques milliers de neurones", explique Reidar Riveland, doctorant au Département des neurosciences fondamentales de la Faculté de médecine de l'UNIGE et premier auteur de l'étude.

Dans la première phase de l'expérience, les neuroscientifiques ont entraîné ce réseau à simuler l'aire de Wernicke, la partie de notre cerveau qui nous permet de percevoir et d'interpréter le langage. Dans un deuxième temps, le réseau a été entraîné à reproduire l'aire de Broca qui, sous l'influence de l'aire de Wernicke, est responsable de la production et de l'articulation des mots. L'ensemble du processus a été réalisé sur des ordinateurs portables classiques. Des instructions écrites en anglais ont ensuite été transmises à l'IA.

Par exemple : pointer l'endroit - à gauche ou à droite - où un stimulus est perçu ; répondre dans la direction opposée d'un stimulus ; ou, plus complexe, entre deux stimuli visuels avec une légère différence de contraste, montrer celui qui est le plus lumineux. Les scientifiques ont ensuite évalué les résultats du modèle, qui simulait l'intention de bouger ou, dans ce cas, de pointer. "Une fois ces tâches apprises, le réseau a pu les décrire à un second réseau, copie du premier, afin qu'il les reproduise. À notre connaissance, c'est la première fois que deux IA sont capables de se parler de manière purement linguistique", déclare Alexandre Pouget, qui a dirigé la recherche.

Pour les futurs humanoïdes

"Ce modèle ouvre de nouveaux horizons pour comprendre l'interaction entre langage et comportement. Il est particulièrement prometteur pour le secteur de la robotique, où le développement de technologies permettant aux machines de dialoguer entre elles est un enjeu majeur. Le réseau que nous avons développé est très petit. Rien n'empêche aujourd'hui de développer, sur cette base, des réseaux beaucoup plus complexes qui seraient intégrés dans des robots humanoïdes capables de nous comprendre mais aussi de se comprendre entre eux", concluent les deux chercheurs.

Source : Étude publiée dans Nature Neuroscience, par une équipe de l'Université de Genève (UNIGE)

Et vous ?

Pensez-vous que cette étude est crédible ou pertinente ?

Quel est votre avis sur le sujet ?

Voir aussi :

La "distillation pas-à-pas", un nouveau paradigme d'apprentissage pour surpasser les performances des grands LLM, avec moins de données d'entraînement et des modèles d'IA de plus petite taille

Les grands modèles de langage (LLM) ne peuvent pas s'autocorriger dans les tâches de raisonnement, selon une étude de DeepMind. L'autocorrection pourrait même nuire aux performances de ces modèles

Les grands modèles de langage sont en état d'ébriété, selon Mattsi Jansky, développeur de logiciels, il présente l'envers du decor des LLM, dans un billet de blog

Répondre avec citation

Répondre avec citation

Partager