Extropic explique comment elle compte construire une plateforme matérielle complète pour exploiter les fluctuations naturelles de la matière en tant que ressource informatique pour l'IA générative

Extropic est en train de construire une plateforme matérielle complète pour exploiter les fluctuations naturelles de la matière en tant que ressource informatique pour l'IA générative. Ce nouveau paradigme informatique étend l'échelle du matériel bien au-delà des contraintes de l'informatique numérique. Il permet de créer des accélérateurs d'IA qui sont plusieurs fois plus rapides et plus économes en énergie que les processeurs numériques (CPU/GPU/TPU/FPGA) et débloque de puissants algorithmes probabilistes d'IA qui ne sont pas réalisables sur des processeurs numériques.

La demande de puissance de calcul à l'ère de l'IA augmente à un rythme exponentiel sans précédent. Heureusement, au cours des dernières décennies, la miniaturisation de la technologie des transistors CMOS selon la loi de Moore a permis d'expliquer une grande partie de cette croissance exponentielle par l'augmentation de l'efficacité des ordinateurs.

Malheureusement, la loi de Moore commence à ralentir. La raison en est ancrée dans la physique fondamentale : les transistors approchent de l'échelle atomique où des effets tels que le bruit thermique commencent à interdire un fonctionnement numérique rigide.

En conséquence, les besoins énergétiques de l'IA moderne commencent à grimper en flèche. Les principaux acteurs proposent des mesures aussi extrêmes que la construction de centres de données alimentés par des réacteurs nucléaires et dédiés à l'entraînement et à l'inférence de grands modèles. La poursuite de cette évolution pendant quelques décennies encore nécessitera des efforts d'ingénierie d'infrastructure d'une ampleur sans précédent et représente une voie ardue pour l'évolution de l'intelligence globale de l'humanité.

D'autre part, la biologie n'est ni rigide ni numérique et abrite des circuits de calculs beaucoup plus efficaces que tout ce que l'humanité a construit à ce jour. Les réseaux de réactions chimiques intercellulaires sont le moteur du calcul dans les systèmes biologiques. Les cellules sont petites et, par conséquent, le nombre de réactifs dans ces réseaux est dénombrable. Par conséquent, les réactions entre les réactifs sont véritablement discrètes et intrinsèquement aléatoires. L'effet relatif de ce caractère aléatoire intrinsèque est inversement proportionnel au nombre de molécules réactives et, de ce fait, les fluctuations tendent à dominer la dynamique de ces systèmes.

À partir de là, il est possible d'affirmer avec certitude qu'il n'y a pas de raison fondamentale pour que les contraintes de la logique numérique limitent l'efficacité des dispositifs informatiques. Le défi technique est clair : comment concevoir dès le départ un système matériel et logiciel d'IA complet qui prospère dans un environnement intrinsèquement bruyant ?

Les modèles basés sur l'énergie (EBM) offrent des indices d'une solution potentielle, car il s'agit d'un concept qui apparaît à la fois dans la physique thermodynamique et dans l'apprentissage automatique probabiliste fondamental. En physique, ils sont connus sous le nom d'états thermiques paramétrés, issus de l'état stable de systèmes dont les paramètres sont réglables. Dans l'apprentissage automatique, ils sont connus sous le nom de familles exponentielles.

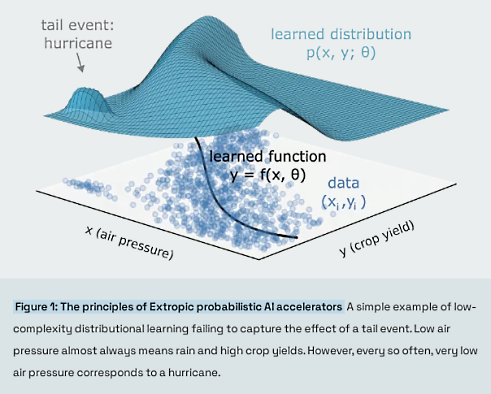

Les familles exponentielles sont connues pour être le moyen optimal de paramétrer les distributions de probabilité, car elles nécessitent un minimum de données pour déterminer leurs paramètres de manière unique. Elles sont donc excellentes dans le régime à faible volume de données, qui englobe les scénarios dans lesquels il est nécessaire de modéliser les événements de queue dans les applications critiques, comme le montre la figure 1. Elles y parviennent en remplissant les blancs des données par du bruit ; elles cherchent à maximiser leur entropie tout en correspondant aux statistiques de la distribution cible. Ce processus consistant à imaginer toutes les possibilités qui ne sont pas incluses dans un ensemble de données et à pénaliser énergiquement ces occurrences nécessite l'utilisation d'une grande quantité d'éléments aléatoires, tant au moment de l'apprentissage qu'à celui de l'inférence.

Cette exigence d'échantillonnage a été le principal obstacle à l'utilisation des EBM en production. La raison fondamentale en est que l'échantillonnage à partir de paysages énergétiques génériques est très difficile à réaliser avec du matériel numérique, qui doit dépenser une énergie électrique considérable pour générer et façonner l'entropie nécessaire aux processus de diffusion. Du point de vue du matériel, l'échantillonnage numérique semble tout à fait artificiel : pourquoi consacrer tant d'efforts à la construction d'ordinateurs numériques de qualité de plus en plus complexes, alors que les algorithmes les plus courants et les plus gourmands en ressources informatiques les remplissent de bruit ?

Extropic raccourcit cette inefficacité et libère tout le potentiel de l'IA générative en mettant en œuvre les EBM directement sous la forme de circuits analogiques stochastiques paramétrés. Les accélérateurs Extropic permettront d'améliorer de plusieurs ordres de grandeur les algorithmes basés sur l'échantillonnage de paysages complexes par rapport aux ordinateurs numériques, en termes de temps d'exécution et d'efficacité énergétique.

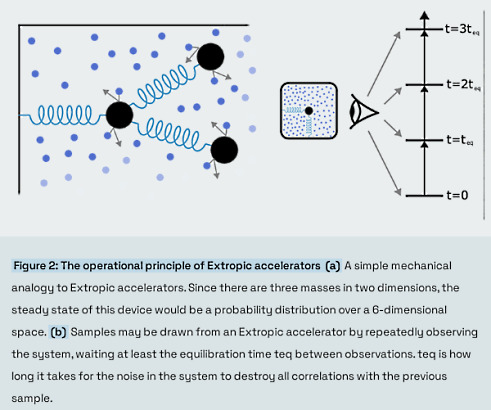

Le principe de fonctionnement des accélérateurs d'Extropic est analogue au mouvement brownien. Dans le mouvement brownien, des particules macroscopiques et légères en suspension dans un fluide subissent des forces aléatoires dues à de nombreuses collisions avec des molécules microscopiques du liquide. Ces collisions entraînent la diffusion aléatoire des particules autour du récipient. On pourrait imaginer d'ancrer les particules browniennes aux parois de la cuve et les unes aux autres à l'aide de ressorts, comme le montre la figure 2 (a). Dans ce cas, les ressorts résisteront aux forces aléatoires et les particules préféreront résider dans certaines parties de la cuve plutôt que dans d'autres. Si l'on échantillonne de manière répétée les positions des particules, en attendant suffisamment longtemps entre les échantillons (comme illustré à la figure 2 (b)), on constatera qu'elles suivent une distribution de probabilité prévisible à l'état stable. Si nous modifions la rigidité des ressorts, cette distribution changera. Ce simple système mécanique est une source de hasard programmable.

Il existe un lien direct entre cette image mécanique et les circuits analogiques stochastiques paramétrés qui composent les accélérateurs Extropic. Les particules légères représentent les électrons, et les molécules de liquide représentent les atomes du milieu conducteur, qui peuvent transférer de l'énergie aux électrons en cas de collision. Les ressorts représentent les composants du circuit qui confinent le mouvement des électrons, tels que les inducteurs ou les transistors. Des tensions/courants de commande peuvent être appliqués pour régler les valeurs de ces composants, modifiant ainsi la distribution à partir de laquelle le circuit effectue l'échantillonnage.

Bien que tous les circuits soient bruyants, tous ne sont pas utiles en tant qu'accélérateur Extropic. La fabrication d'un dispositif dominé par le bruit mais qui se comporte bien est un défi d'un point de vue technique. Les fluctuations thermiques étant faibles, les dispositifs doivent être physiquement petits et de faible puissance pour être fortement affectés par elles. C'est pourquoi, si l'on voulait fabriquer un accélérateur Extropic à partir de composants macroscopiques (sur un circuit imprimé, par exemple), il faudrait introduire du bruit synthétique. Ce faisant, les gains de temps et d'énergie fondamentaux sont réduits à néant et l'algorithme est finalement exécuté de la même manière que s'il était exécuté numériquement.

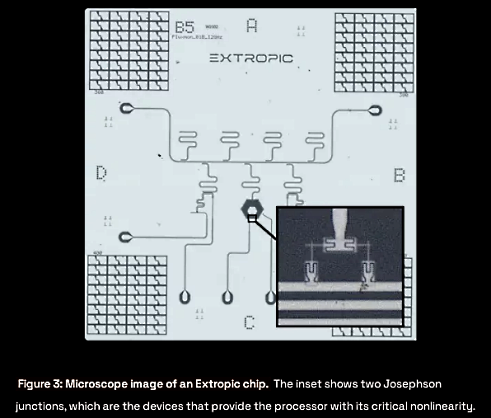

Les premiers processeurs d'Extropic sont nanofabriqués à partir d'aluminium et fonctionnent à basse température où ils sont supraconducteurs. La figure 3 montre un premier dispositif qui a testé plusieurs conceptions possibles de neurones supraconducteurs. Certains de ces neurones sont similaires aux qubits de flux supraconducteurs existants. Ces neurones exploitent l'effet Josephson comme source de non-linéarité, qui se produit lorsque deux supraconducteurs sont proches l'un de l'autre. Cette non-linéarité est nécessaire pour que le dispositif puisse accéder à des distributions de probabilité non gaussiennes, qui sont nécessaires pour modéliser les applications du monde réel avec des queues grasses. En outre, les routines numériques d'échantillonnage gaussien sont omniprésentes et hautement optimisées. Par conséquent, si un dispositif analogique doit fournir une accélération considérable par rapport à un processeur traditionnel, la non gaussianité est nécessaire.

Ces neurones constituent les éléments de base qui sont combinés pour former un système supraconducteur plus vaste. Dans un tel système, de nombreux neurones linéaires et non linéaires sont combinés pour créer un circuit qui échantillonne à partir d'une distribution riche et de haute dimension. Les biais des neurones et les forces d'interaction sont tous des paramètres réglables de la distribution, ce qui permet à un seul dispositif d'incarner une large famille de distributions de probabilités.

Les puces supraconductrices d'Extropic sont entièrement passives, ce qui signifie que la dépense d'énergie se limite à la mesure ou à la manipulation de leur état. Cela fait probablement de ces neurones les plus économes en énergie de l'univers. Ces systèmes seront très efficaces sur le plan énergétique à grande échelle : Extropic vise des clients à faible volume et à forte valeur ajoutée comme les gouvernements, les banques et les clouds privés avec ces systèmes.

Extropic construit également des dispositifs semi-conducteurs qui fonctionnent à température ambiante afin d'élargir son champ d'action à un marché plus vaste. Ces dispositifs échangent la jonction Josephson contre le transistor. Ce faisant, ils sacrifient une partie de l'efficacité énergétique par rapport aux dispositifs supraconducteurs. En échange, il est possible de les construire en utilisant des processus de fabrication et des chaînes d'approvisionnement standard, ce qui permet de débloquer une échelle massive. Comme ils fonctionnent à température ambiante, il sera possible de les intégrer dans une carte d'extension de type GPU. Il sera ainsi possible d'installer un accélérateur Extropic dans chaque foyer, ce qui permettra à chacun de participer à l'accélération thermodynamique de l'IA.

Pour prendre en charge une large gamme de substrats matériels, Extropic construit également une couche logicielle qui compile les spécifications abstraites des EBM dans le langage de contrôle matériel approprié. Cette couche de compilation s'appuie sur le cadre théorique des graphes factoriels. Les graphes factoriels spécifient comment les distributions larges se factorisent en morceaux locaux. Cela permet aux accélérateurs Extropic de décomposer et d'exécuter des programmes qui sont trop volumineux pour tenir sur un cœur analogique donné.

De nombreuses sociétés d'accélérateurs d'IA se sont efforcées de trouver un avantage en raison du caractère limité de la mémoire de l'apprentissage profond ; les algorithmes actuels passent environ 25 % de leur temps à déplacer des nombres dans la mémoire. Par conséquent, selon la loi d'Amdahl, toute puce qui accélère une opération particulière (telle que la multiplication de la matrice) aura du mal à atteindre une vitesse supérieure à 4x. Comme les puces Extropic accélèrent nativement une large classe d'algorithmes probabilistes en les exécutant physiquement dans leur intégralité comme un processus rapide et économe en énergie, un tout nouveau régime d'accélération de l'intelligence artificielle va certainement voir le jour, bien au-delà de ce que l'on pensait réalisable jusqu'à présent.

Source : "Ushering in the Thermodynamic Future" (Extropic)

Et vous ?

Quel est votre avis sur le sujet ?

Trouvez-vous cette initiative d'Extropic cohérente et pertinente ?

Pensez-vous que ce nouveau paradigme permettra d'accélérer le développement de l'IA générative ?

Voir aussi :

Révolution dans l'informatique neuromorphique : un nouveau transistor d'IA fonctionne comme le cerveau humain, une avancée majeure des chercheurs de la Northwestern university et du MIT

L'IA générative devrait permettre à la loi de Moore de rester en vigueur pour assurer l'évolution de la puissance de calcul des microprocesseurs, selon un spécialiste de la technologie

Répondre avec citation

Répondre avec citation

Partager