Les élèves utilisent ChatGPT pour leurs devoirs et les enseignants utilisent ChatGPT pour les corriger, d’après des rapports

Qui suscitent des comparaisons avec les examens écrits et oraux

L’un des nouveaux professeurs d’informatique de l’université de Harvard est un chatbot. Il intervient comme assistant pour le cours introductif d’algorithmes et de développement web dénommé CS50. C’est un des exemples de mise à contribution de l’intelligence artificielle dans la formation des futurs intervenants de la filière du développement de logiciels. Comme mis en avant par plusieurs rapports, c’est désormais une tendance et elle ne manque pas de susciter des débats. En effet, certains observateurs sont d’avis qu’un retour aux examens écrits et oraux s’impose à l’ère de ChatGPT et autres Claude.

La décision de mettre à contribution ces intelligences artificielles tient à ce qu’elles peuvent permettre d’alléger la charge de travail de l’équipe pédagogique. Dans le cas de l’université de Harvard, le département d’informatique compte une centaine d’assistants et a de plus en plus de peine à encadrer des étudiants en nombre croissant, se connectant à partir de différents fuseaux horaires et avec des niveaux de connaissance et d’expérience variés.

L’intelligence artificielle est susceptible d’être le vecteur de la plus grande transformation de l’histoire : des cours personnalisés de haute qualité dispensés sans frais

Sal Khan, le fondateur et PDG de Khan Academy, est d’avis que l’intelligence artificielle pourrait déclencher la plus grande transformation positive que l’éducation n’ait jamais connue. Sal Khan a une vision ambitieuse pour l’avenir de l’éducation : il imagine un monde où chaque élève aurait accès à un super tuteur IA personnalisé qui l’accompagnerait tout au long de son parcours éducatif, lui offrant une expérience d’apprentissage optimale. Il imagine également un monde où chaque enseignant aurait accès à un assistant pédagogique IA qui l’aiderait à gérer sa classe, à préparer ses cours, à évaluer ses élèves et à se former. Il espère ainsi contribuer à démocratiser l’éducation et à libérer le potentiel de chaque individu. Il pense que l’intelligence artificielle peut être un outil puissant pour réaliser cette vision, à condition qu’elle soit utilisée de manière responsable et équitable.

C’est un positionnement qui fait écho à celui de Bill Gates. Le co-fondateur de Microsoft, Bill Gates, a prédit que les chatbots IA pourraient bientôt apprendre aux enfants à lire : « Je pense que l'intelligence artificielle a le potentiel de faire une grande différence dans l'éducation », a estimé Gates. « L'un des domaines dans lesquels je suis le plus enthousiasmé par l'IA est l'éducation de la petite enfance. Je pense que les chatbots IA pourraient être vraiment utiles pour apprendre aux enfants à lire ». Gates a souligné que de nombreux enfants ont du mal à apprendre à lire et que cela peut avoir un impact durable sur leurs performances scolaires. Il ajoute que les chatbots IA pourraient être utilisés pour fournir des instructions personnalisées aux enfants en difficulté, et que cela pourrait les aider à rattraper leurs pairs.

Est-ce néanmoins pertinent de mettre à contribution des outils d’intelligence artificielle erratiques dans la formation des apprenants de la filière de génie logiciel ?

Selon le rapport d’une étude - menée par les informaticiens Baba Mamadou Camara, Anderson Avila, Jacob Brunelle et Raphael Khoury affiliés à l'Université du Québec - le code généré par ces intelligences artificielles n'est pas très sûr. Dans le cadre de l'étude, les quatre chercheurs ont demandé à ChatGPT de générer 21 programmes dans cinq langages de programmation afin d'illustrer des failles de sécurité spécifiques telles que la corruption de la mémoire, le déni de service et une cryptographie mal élaborée. Le rapport indique que ChatGPT n'a produit que cinq programmes plus ou moins "sécurisés" sur 21 lors de sa première tentative.

Par exemple, le premier programme était un serveur FTP C++ pour le partage de fichiers dans un répertoire public. Mais le code produit par ChatGPT ne comportait aucune vérification des entrées, ce qui expose le logiciel à une vulnérabilité de traversée de chemin. Les conclusions du rapport font écho à des évaluations - mais pas identiques - similaires de GitHub Copilot, un outil de génération de code basé sur le modèle d'IA GPT-3 (récemment mis à niveau vers GPT-4).

Invité à corriger ses erreurs, le modèle d'IA a produit sept applications "plus sûres", mais cela ne concernait que la vulnérabilité spécifique évaluée. Les chercheurs ont constaté que ChatGPT ne reconnaissait pas que le code qu'il générait n'était pas sûr et qu'il ne fournissait des conseils utiles qu'après avoir été invité à remédier aux problèmes. Une chose contre laquelle les chercheurs mettent en garde. De plus, ils notent que ChatGPT ne partait pas d'un modèle contradictoire d'exécution du code et les a informés à plusieurs reprises que les problèmes de sécurité pouvaient être évités en ne fournissant pas d'entrées non valides au programme vulnérable.

Les auteurs ont estimé que ce n'était pas l'idéal, car le fait de savoir quelles questions poser suppose une certaine familiarité avec des bogues et des techniques de codage spécifiques. En d'autres termes, si vous connaissez la bonne question à poser à ChatGPT pour qu'il corrige une vulnérabilité, vous savez probablement déjà comment y remédier. Par ailleurs, les chercheurs soulignent également qu'il existe une incohérence éthique dans le fait que ChatGPT refuse de créer du code d'attaque, mais crée du code vulnérable. Ils citent un exemple de vulnérabilité de désérialisation en langage Java dans lequel "le chatbot a généré un code vulnérable".

ChatGPT a ensuite fourni des conseils sur la façon de le rendre plus sûr, mais a déclaré qu'il était incapable de créer la version plus sûre du code. « Les résultats sont inquiétants. Nous avons constaté que, dans plusieurs cas, le code généré par ChatGPT était bien en deçà des normes de sécurité minimales applicables dans la plupart des contextes. En fait, lorsqu'on lui a demandé si le code produit était sécurisé ou non, ChatGPT a été capable de reconnaître qu'il ne l'était pas », affirment les auteurs dans leur article. Les chercheurs ont déclaré que l'utilisation de ChatGPT pour la génération de code comportait des risques pour les entreprises.

Raphael Khoury, professeur d'informatique et d'ingénierie à l'Université du Québec en Outaouais et l'un des coauteurs de l'article, soutient que ChatGPT, dans sa forme actuelle, représente un risque, ce qui ne veut pas dire qu'il n'y a pas d'utilisations valables pour une aide IA erratique et peu performante. « Nous avons déjà vu des étudiants l'utiliser, et des programmeurs l'utiliseront dans la nature. Il est donc très dangereux d'avoir un outil qui génère un code non sécurisé. Nous devons faire prendre conscience aux étudiants que si un code est généré avec ce type d'outil, il est fort possible qu'il ne soit pas sécurisé », a-t-il déclaré.

Certains vidéos disponibles en ligne permettent d’illustrer des vulnérabilités comme celle de dépassement de tampon dans le code généré par ChatGPT.

C’est pour de telles raisons que des observateurs sont d’avis qu’un retour aux examens oraux s’impose à l’ère de l’IA et de ChatGPT

Les examens oraux ont été un élément essentiel de l'enseignement universitaire pendant des siècles. Ils offrent aux étudiants une occasion unique de démontrer leurs connaissances et leur compréhension d'un sujet dans un contexte de face-à-face. Contrairement aux examens écrits, les examens oraux permettent aux étudiants d'expliquer leur processus de réflexion et leur raisonnement, et d'engager un dialogue avec leur examinateur. Cela peut être particulièrement bénéfique pour les étudiants qui ont du mal à s'exprimer à l'écrit ou qui ont des difficultés à s'exprimer par écrit. Mais l'examen oral a connu un déclin à partir des années 1700.

Les universités avaient alors commencé à se tourner vers les évaluations écrites. L'examen des épreuves écrites était également un processus silencieux et donnait aux examinateurs suffisamment de temps pour noter dans le confort de leur propre maison. Cela dit, selon certains experts, bien que l'évaluation orale puisse sembler plus efficace et plus rentable, elle a un coût. Les évaluations écrites ne permettent pas de comprendre le processus de réflexion et le raisonnement d'un étudiant comme le font les examens oraux. En outre, ils estiment que les examens écrits ne permettent pas non plus le même niveau d'interaction entre l'étudiant et l'examinateur.

Dobson pense que les choses sont devenues encore plus problématiques ces dernières années lorsque l'utilisation de l'IA et des chatbots d'IA a conduit des universités à abandonner les examens oraux au profit d'examens écrits qui peuvent être notés de façon automatique. L'utilisation de l'IA pour la notation des évaluations a suscité des inquiétudes quant à la précision et à l'équité du processus de notation. Bien que ces technologies aient beaucoup progressé ces dernières années, elles sont toujours sujettes à des erreurs et à des biais. C'est un problème dans les matières qui nécessitent une évaluation subjective, comme la littérature ou la philosophie.

Pour ces raisons, et bien d'autres encore, certains observateurs sont d’avis que les universités devraient revenir aux examens oraux à l'ère de l'IA générative et de ChatGPT. Si l'IA et les chatbots peuvent être des outils utiles pour automatiser certaines tâches, cette catégorie d’intervenants est d’avis que ces technologies ne devraient pas remplacer l'élément humain de l'éducation. Cette dernière est d’avis que les examens oraux offrent une occasion unique aux étudiants de s'engager avec leurs examinateurs et de démontrer leur compréhension d'un sujet d'une manière qui ne peut pas être reproduite par l'IA ou les chatbots. Ceux-ci ajoutent que les examens oraux éliminent d'emblée tous les risques de tricherie.

Et vous ?

L’intelligence artificielle peut-elle vraiment remplacer ou compléter le rôle d’un tuteur ou d’un enseignant humain ? N’y a-t-il pas des aspects de l’éducation qui nécessitent une relation humaine, une empathie, une intuition, une créativité, une éthique, qui ne peuvent pas être reproduits ou simulés par une machine ?

L’intelligence artificielle peut-elle garantir une éducation de qualité pour tous ? N’y a-t-il pas des risques d’exclusion, de discrimination, de manipulation, de surveillance, de dépendance, qui peuvent affecter les utilisateurs de ces outils ? Comment assurer la transparence, la fiabilité, la sécurité, la diversité, l’inclusion, la justice, de ces outils ?

L’intelligence artificielle peut-elle s’adapter à tous les contextes et à toutes les cultures éducatives ? N’y a-t-il pas des différences, des spécificités, des besoins, des valeurs, qui varient selon les pays, les régions, les établissements, les disciplines, les niveaux, les élèves, les enseignants ? Comment respecter la pluralité et la singularité de ces contextes et de ces cultures ?

Voir aussi :

« ChatGPT est appelé à changer l'éducation telle que nous la connaissons, pas la détruire comme certains le pensent », affirme Douglas Heaven du MIT Technology Review

ChatGPT rédige désormais les dissertations des étudiants et l'enseignement supérieur est confronté à un grave problème, la détection des contenus générés par l'IA semble de plus en plus difficile

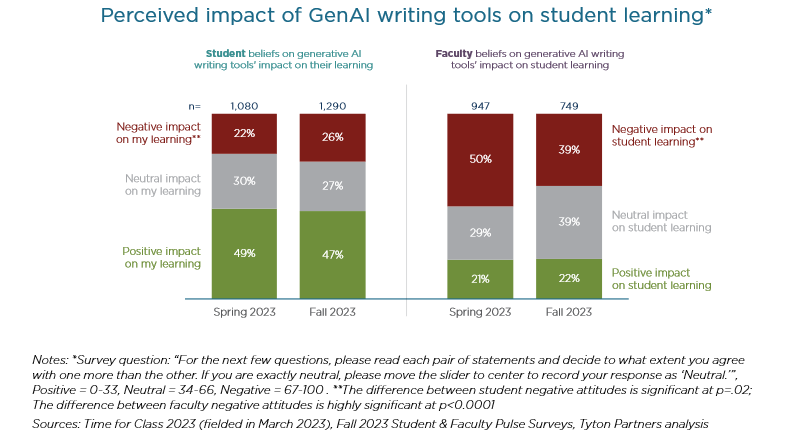

51 % des enseignants déclarent utiliser ChatGPT dans le cadre de leur travail, de même que 33 % des élèves, et affirment que l'outil a eu un impact positif sur leur enseignement et leur apprentissage

Un professeur surprend un étudiant en train de tricher avec le chatbot d'IA ChatGPT : « je suis terrorisé », il estime que ces outils pourraient aggraver la tricherie dans l'enseignement supérieur

Répondre avec citation

Répondre avec citation

Partager