"Chat With RTX" de NVIDIA est un chatbot IA qui fonctionne localement sur votre PC contrairement à ChatGPT et Copilot.

S'il contribue ainsi à la protection de la vie privée, le chatbot présente déjà quelques limites

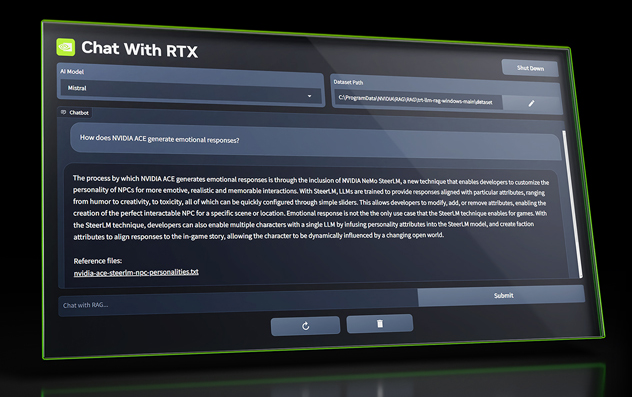

NVIDIA vient de publier une version démo de Chat With RTX, une application qui vous permet de faire fonctionner un chatbot d’intelligence artificielle sur votre PC. Le logiciel exploite les cœurs Tensor-RT intégrés dans les GPU de jeu de NVIDIA (vous aurez besoin d'une carte RTX 30 ou 40 pour l'utiliser) et utilise de grands modèles de langage (LLM) pour fournir des informations utiles sur vos propres données.

La principale différence est que, contrairement à ChatGPT et Copilot, Chat with RTX fonctionne entièrement sur votre PC et n'envoie aucune donnée à un serveur cloud. Vous lui fournissez l'ensemble de données pertinent et il vous propose des réponses basées sur les informations qu'il contient. Autre fonctionnalité intéressante : vous pouvez partager des liens YouTube, et Chat with RTX interprète le contenu de la vidéo et répond aux questions - en puisant dans les données du fichier de sous-titrage.

Chat With RTX est entièrement basé sur le texte, et il est “entraîné” sur une grande base de données de documents publics appartenant à NVIDIA lui-même. Dans sa forme brute, le modèle peut “écrire” assez bien, mais ses connaissances réelles semblent être extrêmement limitées.

NVIDIA a dévoilé une nouvelle application d'intelligence artificielle qui apporte des fonctionnalités avancées de chatbot directement sur les ordinateurs personnels des utilisateurs. Baptisé "Chat with RTX", ce logiciel exploite les puissants GPU GeForce RTX de NVIDIA pour traiter le langage naturel en temps réel sans nécessiter de connexion au cloud.

Chat with RTX installe un serveur Python local et une interface web pour traiter les requêtes. Une fois installés, les utilisateurs peuvent saisir des URL de vidéos YouTube, des documents personnels et d'autres fichiers pour que le chatbot les analyse. Il peut rechercher des mots-clés dans les transcriptions, résumer des vidéos ou des textes, etc.

« Chat with RTX utilise la génération augmentée par récupération (RAG), le logiciel Nvidia TensorRT-LLM et l'accélération Nvidia RTX pour apporter des capacités d'IA générative aux PC Windows équipés de GeForce. Les utilisateurs peuvent rapidement et facilement connecter des fichiers locaux sur un PC en tant qu'ensemble de données à un grand modèle de langage open-source comme Mistral ou Llama 2, permettant des requêtes pour des réponses rapides et contextuellement pertinentes », peut-on lire dans le communiqué de presse.

Comme son nom l'indique, Chat with RTX exploite les cœurs Tensor des cartes graphiques GeForce RTX 30 et 40. Ce matériel spécialisé accélère les opérations mathématiques matricielles intenses requises pour l'IA basée sur les réseaux neuronaux. Par conséquent, les réponses sont plus rapides qu'avec une API cloud.

En parlant des cœurs Tensor, NVIDIA explique sur son site :

Les cœurs Tensor sont une nouvelle technologie avancée de NVIDIA autorisant des calculs en précision mixte, ce qui permet d’accélérer le rendement tout en préservant la précision grâce à une adaptation dynamique du calcul informatique. La nouvelle génération des cœurs Tensor apporte des gains de performance significatifs à une grande variété de tâches d’intelligence artificielle (IA) et de calcul haute performance (HPC). Avec des procédures d’entraînement jusqu’à six fois plus rapides pour les réseaux de transformateurs, mais aussi des performances jusqu’à trois fois plus élevées dans toutes les applications, les cœurs NVIDIA Tensor vous fournissent des capacités sans précédent pour tous les types de charges de travail.

Un outil qui a ses limites

Le traitement local contribue également à la protection de la vie privée, puisque les données des utilisateurs ne quittent jamais leur PC. Toutefois, le téléchargement initial est considérable (40 Go) en raison de tous les fichiers du modèle d'IA. En outre, le serveur Python utilise environ 3 Go de mémoire vive lorsqu'il est actif. Bien entendu, comme le modèle est exécuté localement, les temps de réponse devraient également dépendre du modèle GPU utilisé.

Le journaliste Tom Warren a brièvement testé l'application. Ce qui suit est son retour d'expérience.

Chat with RTX peut gérer les vidéos YouTube, il vous suffit donc d'entrer une URL et il vous permet de rechercher des transcriptions pour des mentions spécifiques ou de résumer une vidéo entière. J'ai trouvé cela idéal pour rechercher des podcasts vidéo, en particulier pour trouver des mentions spécifiques dans les podcasts de la semaine dernière, dans un contexte de rumeurs concernant le nouveau changement de stratégie de Microsoft pour la Xbox.

En revanche, ce n'était pas parfait pour les recherches dans les vidéos YouTube. J'ai essayé de rechercher la transcription d'une vidéo YouTube de The Verge, et Chat with RTX a téléchargé la transcription d'une vidéo complètement différente. Ce n'était même pas une vidéo que j'avais demandé auparavant, ce qui montre bien qu'il y a des bogues dans cette première démo.

Lorsqu'il fonctionnait correctement, j'étais en mesure de trouver des références dans les vidéos en quelques secondes. J'ai également créé un ensemble de documents de l'affaire FTC contre Microsoft que j'ai analysé avec Chat with RTX. Lorsque je couvrais le procès l'année dernière, il était souvent difficile d'effectuer des recherches rapides dans les documents, mais Chat with RTX m'a aidé dans mes requêtes presque instantanément sur mon PC.

Par exemple, le chatbot a fait un bon travail en résumant toute la stratégie Xbox Game Pass de Microsoft à partir de documents internes révélés lors du procès :

J'ai également trouvé cela utile pour parcourir des PDF et vérifier des données. Le système Copilot de Microsoft ne gère pas bien les PDF dans Word, mais le Chat avec RTX de Nvidia n'a eu aucun mal à extraire toutes les informations clés. Les réponses sont également quasi instantanées, sans le décalage que l'on observe habituellement avec les chatbots ChatGPT ou Copilot basés sur le cloud.Sur la base des informations contextuelles fournies, le Xbox Game Pass est un service d'abonnement à du contenu dans le domaine des jeux qui permet d'accéder à une bibliothèque de jeux moyennant un forfait mensuel unique. Il s'agit d'une plateforme qui permet aux joueurs de jouer à leurs jeux n'importe où et aux éditeurs d'atteindre les joueurs partout dans le monde. Le service est soutenu par le projet xCloud et la série X de la Xbox, et il vise à créer un terrain fertile pour que les éditeurs puissent monétiser leurs jeux. Le principal objectif stratégique de la CSA Gaming est de développer le Xbox Game Pass, et l'on estime qu'il existe un potentiel important d'abonnés à l'échelle mondiale, avec un potentiel de 750 millions d'abonnés. Le service est confronté à trois dynamiques de contenu principales, notamment le besoin de contenu différencié, l'expansion au-delà de la console et l'offre limitée de contenu.

Le gros inconvénient de Chat with RTX est qu'il ressemble vraiment à une première démo de développeur. Chat with RTX installe essentiellement un serveur web et une instance Python sur votre PC, qui exploite ensuite les modèles Mistral ou Llama 2 pour interroger les données que vous lui fournissez. Il utilise ensuite les cœurs Tensor de Nvidia sur un GPU RTX pour accélérer vos requêtes.

Les points importants

L'IA personnalisée sur votre bureau

Chat With RTX n'est pas un simple chatbot. Il représente la fusion des technologies avancées de NVIDIA, dont RAG et TensorRT-LLM, avec l'accélération RTX, pour fournir une expérience d'IA personnalisée. En fonctionnant localement sur le PC de l'utilisateur, il garantit la confidentialité et la sécurité, ce qui le différencie des solutions basées sur le cloud.

Intégration transparente et expérience utilisateur

L'une des principales caractéristiques de Chat With RTX est sa capacité à travailler avec une grande variété de formats de fichiers. Qu'il s'agisse de texte, de PDF, de doc/docx ou de XML, les utilisateurs peuvent facilement intégrer leurs documents dans la base de connaissances du chatbot. De plus, l'inclusion de transcriptions de listes de lecture YouTube permet une interaction plus dynamique, permettant au chatbot de fournir des informations et des réponses basées sur un large éventail de contenus multimédias.

Le rôle des GPU RTX dans le développement de l'IA

Les GPU RTX sont au cœur de la poussée de NVIDIA dans le domaine de l'IA accessible. Grâce à leurs capacités informatiques avancées, notamment en termes de ray tracing et de performances d'apprentissage profond, ces GPU constituent une plateforme idéale pour faire tourner des modèles d'IA complexes tels que ceux utilisés dans Chat With RTX. La capacité de la série RTX à gérer localement des charges de travail d'IA exigeantes, sans avoir recours au traitement en nuage, marque une évolution vers des outils d'IA plus respectueux de la vie privée qui ne font pas de compromis sur la vitesse ou l'efficacité.

Pour les développeurs et les passionnés

Les développeurs trouveront Chat With RTX particulièrement attrayant. Construit à partir du projet de référence pour développeurs TensorRT-LLM RAG, il ouvre la voie à la création et au déploiement d'applications basées sur RAG et optimisées pour RTX. Cela positionne l'offre de NVIDIA non seulement comme un outil pour les utilisateurs finaux, mais aussi comme une plate-forme d'innovation pour la communauté de développement de l'IA.

Une nouvelle ère d'accessibilité à l'IA

Les dernières mises à jour de TensorRT-LLM de NVIDIA, dont la version 0.6.0, ont considérablement amélioré les performances d'inférence de l'IA, rendant l'IA plus accessible sur les ordinateurs de bureau et les ordinateurs portables équipés de GPU RTX. En prenant en charge d'autres modèles de grands langages populaires, NVIDIA s'assure qu'encore plus d'utilisateurs peuvent exploiter la puissance de l'IA générative sur leurs appareils locaux.

Conclusion

Lors des tests, Chat with RTX s'est avéré capable de gérer les formats .txt, .pdf, .doc et autres. Il peut même analyser les légendes de YouTube pour trouver des mentions de termes de recherche ou produire des résumés de vidéos. Cette fonctionnalité pourrait renforcer les flux de travail de recherche et d'analyse.

Malgré ses capacités, Chat with RTX n'en est qu'à ses débuts. L'outil manque de contexte ou de mémoire entre les questions. Il présente également quelques bizarreries - il enregistre des fichiers JSON après l'indexation des dossiers, ce qui pourrait rapidement encombrer l'espace de stockage.

Pour l'instant, Chat with RTX donne un aperçu passionnant de l'avenir de l'informatique assistée par l'IA. Au fur et à mesure de la maturation du logiciel, les chatbots locaux de ce type pourraient devenir un moyen essentiel d'améliorer les appareils personnels.

Source : NVIDIA, cœurs Tensor, retour d'expérience de Tom Warren

Et vous ?

Que pensez-vous de l’application Chat With RTX de NVIDIA ? L’avez-vous essayée ou comptez-vous l’essayer ?

Quels sont les avantages et les inconvénients de faire fonctionner un chatbot d’IA localement sur votre PC ?

Comment NVIDIA peut-il améliorer son chatbot d’IA pour le rendre plus utile, plus fiable et plus sécurisé ?

Quels sont les autres domaines d’application potentiels pour un chatbot d’IA qui utilise vos propres données et vidéos ?

Quel est l’impact de l’IA sur des domaines tels que la communication et l’éducation ?

Répondre avec citation

Répondre avec citation

Partager