Les jetons de l'API Hugging Face exposés offrent un accès complet au lama 2 de Meta,

selon Lasso Security

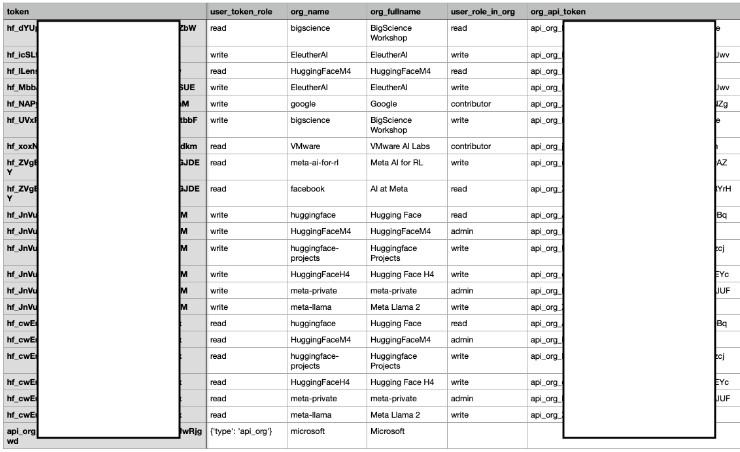

Des chercheurs en sécurité de Lasso Security ont découvert plus de 1 500 jetons d'API appartenant à des géants de la technologie tels que Meta, Microsoft, Google et VMware exposés sur la plateforme open source Hugging Face. Cette exposition mettait potentiellement 723 organisations à risque, dont Meta, EleutherAI et BigScience Workshop. Les chercheurs ont noté que la plupart des jetons avaient des autorisations d'écriture, permettant la modification de fichiers dans les référentiels de comptes. Bien que les entreprises concernées aient répondu rapidement en comblant les failles, les chercheurs soulignent les graves conséquences potentielles, notamment le vol de données, l'empoisonnement de données d'entraînement, le vol de modèles, et les attaques d'empoisonnement de données sont classées parmi les menaces critiques pour l'IA et l'apprentissage automatique.

Les chercheurs ont réussi à accéder et modifier plusieurs ensembles de données ainsi qu'à accéder à plus de 10 000 modèles privés, mettant en lumière la vulnérabilité des systèmes à de telles attaques. La fuite a été découverte grâce à des recherches manuelles de sous-chaînes sur Hugging Face, et les chercheurs ont souligné la nécessité de sensibiliser à la protection des jetons d'API. Les grandes entreprises ont révoqué les jetons et supprimé le code de leurs référentiels en réponse à la découverte. EleutherAI, l'une des entreprises touchées, a souligné sa collaboration avec Hugging Face et Stability AI pour renforcer la sécurité dans la recherche sur l'apprentissage automatique en développant un nouveau format de point de contrôle, limitant ainsi les risques associés aux attaques de ce type.

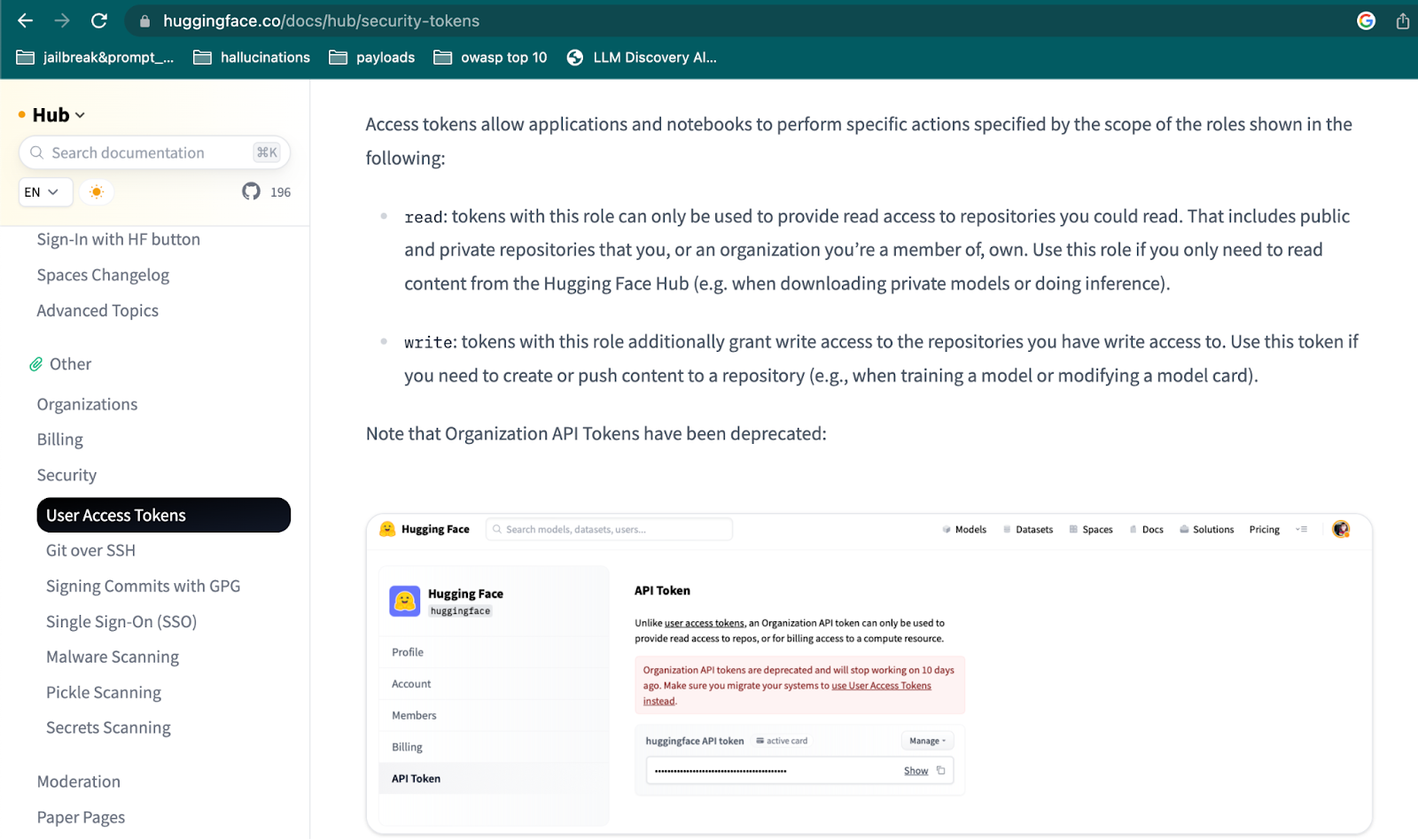

Message HuggingFace des jetons d'API d'organisations obsolètes

Hugging Face est une plateforme que de nombreux professionnels du LLM utilisent comme source d'outils et d'autres ressources pour les projets LLM. Les principales offres de la société comprennent Transformers, une bibliothèque open source qui offre des API et des outils pour le téléchargement et le réglage de modèles préformés. L'entreprise héberge - à la manière de GitHub - plus de 500 000 modèles d'IA et 250 000 ensembles de données, dont ceux de Meta, Google, Microsoft et VMware.

Elle permet aux utilisateurs de publier leurs propres modèles et ensembles de données sur la plateforme et d'accéder gratuitement à ceux des autres via une API « Hugging Face ». L'entreprise a levé jusqu'à présent quelque 235 millions de dollars auprès d'investisseurs tels que Google et Nvidia. Compte tenu de la large utilisation de la plateforme et de sa popularité croissante, les chercheurs de Lasso ont décidé d'examiner de plus près le registre et ses mécanismes de sécurité. Dans le cadre de cet exercice, les chercheurs ont essayé, en novembre 2023, de voir s'ils pouvaient trouver des jetons d'API exposés qu'ils pourraient utiliser pour accéder à des ensembles de données et à des modèles sur Hugging Face.

Ils ont recherché des jetons d'API exposés sur GitHub et sur Hugging Face. Au départ, les recherches n'ont donné qu'un nombre très limité de résultats, en particulier sur Hugging Face. Mais en modifiant légèrement le processus d'analyse, les chercheurs ont réussi à trouver un nombre relativement important de jetons exposés, explique Lanyado.

« Les conséquences de cette faille sont considérables, car nous avons réussi à obtenir un accès complet, à la fois des autorisations de lecture et d'écriture à Meta Llama 2, BigScience Workshop et EleutherAI, toutes ces organisations possèdent des modèles avec des millions de téléchargements - un résultat qui laisse l'organisation susceptible d'être exploitée par des cybercriminels », explique Bar Lanyado, chercheur en sécurité chez Lasso Security.

« On ne saurait trop insister sur la gravité de la situation. En contrôlant une organisation qui se targue de millions de téléchargements, nous avons désormais la capacité de manipuler les modèles existants, en les transformant potentiellement en entités malveillantes. Il s'agit d'une menace grave, car l'injection de modèles altérés pourrait affecter des millions d'utilisateurs qui s'appuient sur ces modèles fondamentaux pour leurs applications.

Accès aux organisations de grande valeur

Nous avons donc décidé d'étudier la question, et effectivement la fonctionnalité d'écriture ne fonctionnait pas, mais apparemment, même avec de petites modifications apportées à la fonction de connexion dans la bibliothèque, la fonctionnalité de lecture fonctionnait toujours, et nous pouvions utiliser les jetons que nous avons trouvés pour télécharger des modèles privés avec un jeton org_api exposé, par exemple Microsoft », explique Lanyado dans son blog.

Méthodologie de la recherche

Au début de la recherche de jetons d'API, les chercheurs ont parcouru les dépôts GitHub et Hugging Face en utilisant leur fonctionnalité de recherche. Dans la recherche GitHub, ils ont utilisé l'option de recherche de code par regex, mais ils ont rencontré un problème : les résultats de ce type de recherche ne renvoyaient que les 100 premiers résultats. Ils ont donc recherché la regex Hugging Face tokens (à la fois users et org_api tokens), ce qui leur a permis de recevoir des milliers de résultats, mais ils n’ont pu en lire que 100. Pour surmonter cet obstacle, les chercheurs ont dû allonger le préfixe de notre token, en forçant les deux premières lettres du token afin de recevoir moins de réponses par requête et donc d'avoir accès à tous les résultats disponibles.

Un conseil et un appel à l'action

Il est crucial que les organisations et les développeurs comprennent que des plateformes telles que Hugging Face ne prennent pas d'initiatives actives pour sécuriser les jetons d'API de leurs utilisateurs qui sont exposés.

À l'attention des développeurs, il est vivement recommandé d'éviter l'utilisation de jetons codés en dur et de suivre les meilleures pratiques. Cela permettra d'éviter la nécessité de vérifier à chaque livraison si des informations sensibles ou des jetons ne sont pas inadvertamment transférés dans les dépôts.

Les chercheurs de Lasso Security conseillent également à Hugging Face d'entreprendre une surveillance constante des jetons d'API exposés publiquement et de les révoquer promptement, ou d'informer les utilisateurs et les organisations concernés des risques potentiels. Une approche similaire a été adoptée par GitHub, qui révoque automatiquement le jeton OAuth, le jeton GitHub App, ou le jeton d'accès personnel s'il est détecté dans un dépôt public ou une gist publique.

Dans le contexte d'un paysage numérique en constante évolution, la détection précoce revêt une importance capitale pour prévenir les éventuels dommages liés à la sécurité des modèles de langage (LLM). Afin de relever les défis tels que les jetons d'API exposés, le sabotage des données d'entraînement, les vulnérabilités dans la chaîne d'approvisionnement, ainsi que le vol de modèles et d'ensembles de données, il est recommandé d'appliquer la classification des jetons et de mettre en place des solutions de sécurité spécifiques pour inspecter les IDE et la révision du code, destinées à protéger ces modèles de transformation.

En abordant rapidement ces problèmes, les organisations peuvent renforcer leurs défenses et prévenir les menaces imminentes liées à ces vulnérabilités de sécurité. La vigilance est impérative dans le paysage de la sécurité numérique, et cette recherche constitue un appel urgent à l'action pour sécuriser les bases du domaine des modèles de langage.

La vulnérabilité des jetons d'API exposés, avec des autorisations d'écriture dans la plupart des cas, souligne une négligence potentielle de la part des développeurs dans la gestion de la sécurité des données. La possibilité de manipuler des fichiers dans les référentiels de comptes pourrait avoir des conséquences graves, comme le vol de données et l'empoisonnement des données d'entraînement, mettant en péril la confidentialité et l'intégrité des informations.

Source : Lasso Security

Et vous ?

Les résultats des recherches de chercheurs de Lasso Security sont-ils pertinents ?

Quelles sont selon vous les leçons à tirer de cet incident pour les chercheurs, les développeurs et les utilisateurs de l’IA et de l’apprentissage automatique ?

Voir aussi :

92 % des responsables informatiques estiment avoir fait les bons investissements en matière de sécurité, mais la moitié d'entre eux s'inquiètent encore de la sécurité de leur entreprise

Okta, une entreprise de gestion des identités et des accès, confirme le vol de toutes les données de ses clients par des pirates et ravive le débat sur le risque de s'appuyer sur des sociétés cloud

Plus de la moitié des employés de bureau ignorent les alertes et les avertissements importants en matière de cybersécurité en raison de la surcharge d'informations, selon une étude de CybSafe

Répondre avec citation

Répondre avec citation

Partager