Falcon 180B : un modèle d'IA open source avec 180 milliards de paramètres entraînés sur 3 500 milliards de jetons

il serait plus performant que le modèle Llama 2 de Meta et égale PaLM-2 de Google

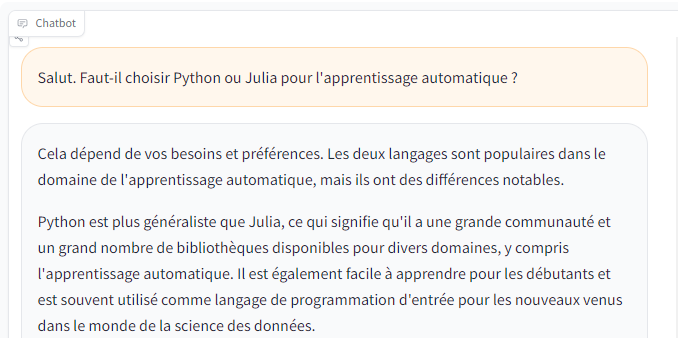

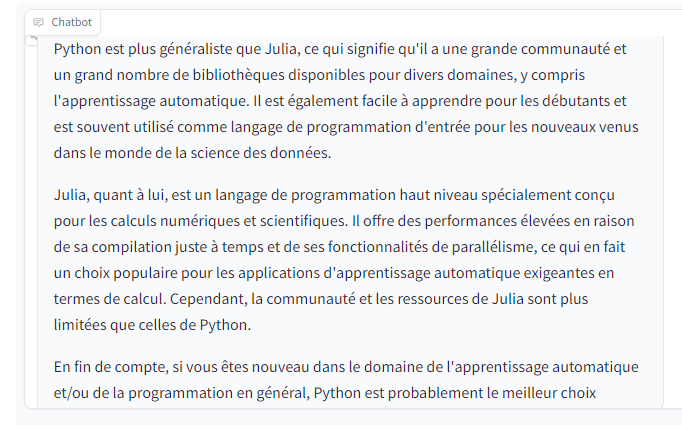

L'Institut de l'innovation technologique (TII) d'Abu Dhabi, aux Émirats arabes unis, vient de dévoiler Falcon 180B, un grand modèle de langage (LLM) avec un nombre impressionnant de 180 milliards de paramètres. Entraîné sur 3 500 milliards de jetons, Falcon 180B aurait des performances surpassant celles du modèle d'IA Llama 2 de Meta, des capacités comparables à celles de modèles fermés comme PaLM-2 Large de Google et se classerait juste en dessous de GPT-4 d'OpenAI. Falcon 180B sera proposé en libre accès à des fins de recherche et commerciales. Le TII d'Abu Dhabi affirme que Falcon 180B est le plus puissant modèle d'IA open source au monde.

Le LLM Falcon 180B constitue un ajout important à la liste existante des modèles de langage open source. Le lancement du Falcon 180B fait suite à l'introduction de ses homologues plus petits, les Falcon 1B, 7B et 40B, qui ont été lancés en juin. Annoncé dans un billet de blogue par la communauté Hugging Face AI, Falcon 180B a été publié le 6 septembre sur Hugging Face Hub. Son architecture s'appuie sur la série précédente de LLM Falcon, en tirant parti d'innovations telles que le traitement des requêtes multi-instructions pour passer à 180 milliards de paramètres entraînés sur 3 500 milliards de jetons provenant de l'ensemble de données RefinedWeb du TII.

Ce cycle d'entraînement représente le plus long préentraînement d'une seule époque pour un modèle open source. Pour atteindre de telles marques, 4 096 GPU auraient été utilisés simultanément pendant environ 7 millions d'heures de GPU, en utilisant Amazon SageMaker pour l'entraînement et l'affinage. Pour mettre en perspective la taille du Falcon 180B, ses paramètres sont 2,5 fois plus grands que le modèle LLaMA 2 de Meta. LLaMA 2 était auparavant considéré comme le LLM open source le plus performant après son lancement en juillet dernier. Selon les données de Meta, LLaMA 2 compte 70 milliards de paramètres entraînés sur 2 000 milliards de jetons.

Falcon 180B surpasse LLaMA 2 et d'autres modèles à la fois en matière d'échelle et de performances dans toute une série de tâches de traitement du langage naturel (NLP). Falcon 180B se classe au premier rang du classement Hugging Face des modèles en libre accès avec 68,74 points et atteint presque la parité avec des modèles commerciaux comme le PaLM-2 de Google sur des évaluations telles que le benchmark HellaSwag. Plus précisément, les données de l'équipe montrent que Falcon 180B égale ou dépasse PaLM-2 Medium sur des critères de référence couramment utilisés, notamment HellaSwag, LAMBADA, WebQuestions, Winogrande, etc.

Falcon 180B est pratiquement au même niveau que PaLM-2 Large de Google. Cela représente une performance extrêmement forte pour un modèle open source, même lorsqu'il est comparé à des solutions développées par des géants de l'industrie. Comparé à ChatGPT, le modèle serait plus puissant que la version gratuite, mais moins performant que le service payant ChatGPT Plus, lancé au début de l'année. « Falcon 180B se situe entre GPT-3.5 et GPT-4 en fonction du benchmark d'évaluation, et il sera très intéressant de suivre les améliorations apportées par la communauté maintenant qu'il est disponible en libre accès », explique l'équipe de l'Institut.

Pour les personnes recherchant des capacités conversationnelles prêtes à l'emploi, le TII propose Falcon 180B-Chat, un dérivé du Falcon 180B, affiné sur un mélange d'ensembles de données de chat. La variante Chat présente ses propres avantages, avec une architecture optimisée pour l'inférence. Cependant, elle n'est pas idéale pour ceux qui cherchent à affiner le modèle pour des tâches spécifiques d'instruction ou de conversation. Falcon 180B est maintenant disponible gratuitement sur le portail Hugging Face, et le TII d'Abu Dhabi a déclaré mercredi que le nouveau modèle d'IA pouvait être utilisé à des fins de recherche et de commercialisation.

Falcon 180B

L'équipe de recherche s'attend également à ce qu'il bénéficie d'améliorations supplémentaires développées par la communauté. « Le lancement de Falcon 180B illustre notre dévouement à repousser les frontières de l'IA, et nous sommes ravis de partager son potentiel illimité avec le monde. Falcon 180B annonce une nouvelle ère d'IA générative, où le progrès scientifique potentiel est rendu disponible grâce au libre accès, ce qui permet d’alimenter les innovations de l’avenir », a déclaré mercredi le Dr Ebtesam Almazrouei, directrice exécutive et chercheuse en chef par intérim de l’unité transversale du TII consacrée à l'IA, dans un communiqué.

Almazrouei ajoute : « alors que nous explorons les frontières de la science et de la technologie, notre vision s'étend bien au-delà de l'innovation ; il s'agit d’entretenir des liens solides pour relever les défis mondiaux grâce à des percées collaboratives ». La sortie du Falcon 180B représente la dernière avancée dans les progrès rapides réalisés récemment avec les LLM. Il est compatible avec les principales langues suivantes : anglais, allemand, espagnol et français, mais il a des capacités limitées en italien, portugais, polonais, néerlandais, roumain, tchèque et suédois. L'équipe n'a pas précisé si la prise en charge de ces langues sera améliorée à l'avenir.

Google et OpenAI, deux principaux pionniers de l'IA, ont maintenu leurs modèles d'IA fermés, affirmant qu'ils s'inquiètent du fait que les LLM puissent être manipulés pour diffuser des infox ou d'autres contenus potentiellement dangereux. OpenAI a refusé de lever le voile sur GPT-4, son plus puissant LLM à ce jour (on ignore même le nombre de paramètres du modèle) et Google a révélé uniquement que Bard est basé sur son LLM LaMDA de 137 milliards de paramètres. Cependant, les partisans des logiciels libres affirment que le fait de maintenir ces systèmes fermés freine injustement l'innovation et entrave leur potentiel d'amélioration du monde.

Falcon 180B

Les chercheurs émiriens ont déclaré qu'ils continueront à proposer des LLM en open source afin de démocratiser l'IA. « Nous envisageons un avenir dans lequel le pouvoir révolutionnaire de l'IA sera à la portée de tous. Nous nous engageons à démocratiser l’accès à l’IA avancée, puisque notre vie privée et l’impact potentiel de l’IA sur l’humanité ne doivent pas être contrôlés par quelques privilégiés. Même si nous ne disposons peut-être pas de toutes les réponses, notre détermination reste inébranlable », a déclaré Faisal Al Bannai, secrétaire général du Conseil de recherche en technologie avancée (ATRC) d'Abu Dhabi qui supervise le TII.

« Nous sommes déterminés à collaborer et contribuer à la communauté open source, en veillant à ce que les avantages de l’IA soient partagés par tous », a-t-il ajouté dans le communiqué. Parmi les géants de la Tech qui participe à la course à l'IA, seul Meta a publié son LLM Llama 2 en open source. Vous pouvez facilement essayer le modèle Falcon 180B dans un espace dédié ou directement sur le portail Hugging Face.

Source : Falcon 180B (1, 2)

Et vous ?

Quel est votre avis sur le sujet ?

Que pensez-vous des caractéristiques du modèle de langage Falcon 180B ?

Selon vous, les grandes entreprises doivent-elles publier leurs LLM en open source ?

Que pensez-vous des arguments mis en avant par Google et OpenAI pour garder leurs modèles fermés ?

En quoi les modèles d'IA open source contribuent-ils à l'essor du secteur ? Quels sont les risques liés aux modèles open source ?

Voir aussi

La startup Cerebras publie Cerebras-GPT, une famille de modèles linguistiques de type ChatGPT en open source, les sept modèles GPT-3 établissent des records de précision et d'efficacité de calcul

Meta s'associe à Microsoft et lance en open source LLaMA 2 pour faire concurrence à ChatGPT d'OpenAI, l'entreprise pourrait vouloir diluer l'avantage concurrentiel de ses rivaux

Google dispose d'une IA plus puissante, affirme Blake Lemoine, un ancien un ingénieur, aujourd'hui licencié pour avoir prétendu qu'il était doué de sensibilité

Répondre avec citation

Répondre avec citation

:

:

Partager