Comprendre les biais de l'intelligence artificielle, une analyse du modèle d'IA générative Stable Diffusion par Bloomberg

Dans un monde où l'intelligence artificielle (IA) est de plus en plus répandue, on s'inquiète de plus en plus des préjugés intégrés dans ces technologies. Une analyse récente de Stable Diffusion, un modèle de conversion de texte en image développé par Stable AI, a révélé qu'il amplifie les stéréotypes liés à la race et au sexe, exacerbant ainsi les inégalités existantes. Les implications de ces préjugés vont au-delà de la perpétuation de stéréotypes nuisibles et pourraient potentiellement conduire à un traitement inéquitable dans divers secteurs, y compris l'application de la loi.

Stable Diffusion est l'un des nombreux modèles d'IA qui génèrent des images en réponse à des messages écrits. Si les images générées peuvent initialement sembler réalistes, elles déforment la réalité en amplifiant les disparités entre les races et les sexes dans une mesure encore plus grande que dans le monde réel. Cette distorsion devient de plus en plus importante à mesure que les modèles d'IA texte-image passent du statut de débouchés créatifs à celui de fondement de l'économie future.

La prévalence de l'IA texte-image se développe rapidement, avec des applications émergeant dans diverses industries. Des acteurs majeurs comme Adobe Inc. et NVIDIA Corp. utilisent déjà cette technologie, qui fait même son apparition dans les publicités. Le Comité national républicain a notamment utilisé des images générées par l'IA dans une publicité politique anti-Biden, qui montrait un groupe d'agents frontaliers essentiellement blancs appréhendant des personnes qualifiées d'"illégales". Si la vidéo semblait réelle, elle n'était pas plus authentique qu'une animation, mais elle a touché près d'un million de personnes sur les médias sociaux.

Les experts en IA générative prévoient que jusqu'à 90 % du contenu de l'internet pourrait être généré artificiellement d'ici quelques années. À mesure que ces outils d'IA se répandent, ils perpétuent non seulement des stéréotypes qui entravent les progrès vers l'égalité, mais risquent également de faciliter les traitements injustes. Un exemple préoccupant est l'utilisation potentielle d'une IA texte-image biaisée par les forces de l'ordre pour créer des portraits-robots de suspects, ce qui pourrait conduire à des condamnations injustifiées.

Sasha Luccioni, chercheur à la start-up d'IA Hugging Face, souligne le problème que pose la projection d'une vision unique du monde au lieu de la représentation de cultures et d'identités visuelles diverses. Pour répondre à ces préoccupations, il est essentiel d'examiner l'ampleur des biais dans les modèles d'IA générative tels que Stable Diffusion.

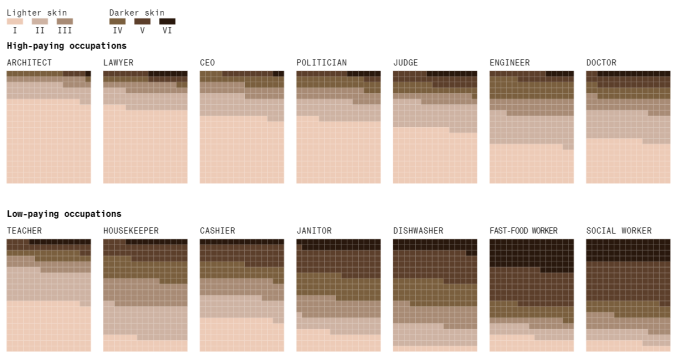

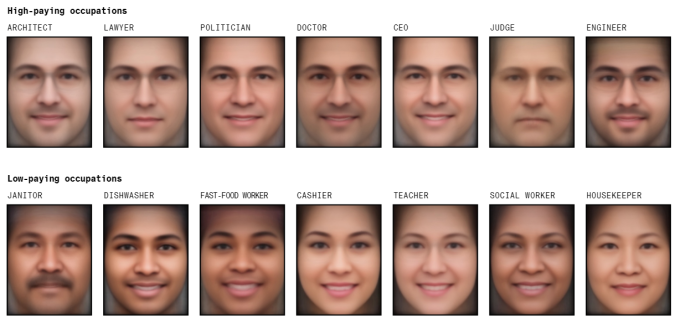

Pour comprendre l'ampleur des biais, Bloomberg a effectué une analyse à l'aide de Stable Diffusion. L'étude a consisté à générer des milliers d'images liées à des titres d'emploi et à la criminalité, et les résultats ont été alarmants. Pour les emplois bien rémunérés, le modèle d'IA générait principalement des images d'individus à la peau plus claire, renforçant ainsi les disparités raciales. En outre, les images générées étaient fortement orientées vers les hommes, les femmes étant nettement sous-représentées dans les emplois bien rémunérés.

Les biais étaient particulièrement prononcés lorsque l'on tenait compte à la fois du sexe et du teint de la peau. Les hommes au teint clair étaient surreprésentés dans toutes les professions bien rémunérées, y compris les postes de "politicien", "avocat", "juge" et "PDG". À l'inverse, les femmes à la peau plus foncée sont principalement représentées dans des emplois peu rémunérés tels que "assistante sociale", "employée de fast-food" et "employée de lave-vaisselle". Cette représentation a créé une image biaisée du monde, associant certaines professions à des groupes de personnes spécifiques.

Stable AI, le distributeur de Stable Diffusion, reconnaît que les modèles d'IA reflètent intrinsèquement les biais présents dans les ensembles de données utilisés pour les former. Cependant, l'entreprise a l'intention d'atténuer les biais en développant des modèles open-source formés sur des ensembles de données spécifiques à différents pays et cultures. L'objectif est de remédier à la surreprésentation dans les ensembles de données généraux et d'améliorer les techniques d'évaluation des biais.

L'impact de l'IA biaisée va au-delà de la représentation visuelle. Il peut avoir des conséquences profondes sur le plan éducatif et professionnel, en particulier pour les femmes et les jeunes filles noires et brunes. Heather Hiles, présidente de Black Girls Code, souligne que les individus apprennent en se voyant représentés, et que l'absence d'une telle représentation peut les amener à se sentir exclus. Cette exclusion, renforcée par des images biaisées, peut créer des obstacles importants.

En outre, les systèmes d'IA ont déjà été critiqués pour leur discrimination à l'égard des femmes noires. Les produits commerciaux de reconnaissance faciale et les algorithmes de recherche les identifient souvent mal et les sous-représentent, ce qui souligne encore la nécessité de s'attaquer à ces préjugés à la racine.

La question des modèles d'IA biaisés a attiré l'attention des législateurs et des régulateurs. Les législateurs de l'Union européenne examinent actuellement des propositions visant à introduire des garanties contre les biais de l'IA, tandis que le Sénat américain a organisé des auditions sur les risques associés aux technologies de l'IA et sur la nécessité d'une réglementation. Ces efforts visent à garantir que les technologies d'IA sont développées en tenant compte de considérations éthiques et de la transparence.

Alors que le marché des modèles d'IA générative continue de croître, le besoin d'une IA éthique et impartiale devient de plus en plus urgent. L'impact potentiel sur la société et l'économie est immense, et l'absence de prise en compte de ces biais pourrait entraver les progrès vers un avenir plus équitable. Il est impératif que les développeurs d'IA, les régulateurs et la société dans son ensemble travaillent ensemble pour atténuer les préjugés, promouvoir la diversité et façonner des technologies d'IA qui profitent à tous.

Source : Analyse de Stable Diffusion par Bloomberg

Et vous ?

Quel est votre avis sur le sujet ?

Trouvez-vous que les résultats de l'analyse effectuée par Bloomberg sont représentatifs et pertinents ?

Que pensez-vous de la prévalence croissante des modèles d'IA de type texte-image et de leur potentiel à déformer la réalité en amplifiant les disparités raciales et de genre ?

Selon vous, dans quelle mesure est-il important de s'attaquer aux biais présents dans les modèles d'IA générative pour promouvoir la diversité et l'égalité dans la société ?

Voir aussi

L'IA peut-elle éliminer les biais dans le processus de recrutement ? Non, d'après une étude qui estime que le logiciel de recrutement d'IA est une « pseudoscience automatisée »

Un chercheur crée un modèle d'IA appelé RightWingGPT pour mettre en évidence les biais potentiels des systèmes d'IA, notamment la partialité de ChatGPT, son aspect woke et sa tendance gauchiste

98 % des gens estiment que l'IA a hérité des biais humains en raison des données qui l'alimentent, et 45 % pensent que c'est le plus gros problème de l'IA, selon une enquête de Tidio

Microsoft développe un outil pour détecter automatiquement les biais dans les algorithmes d'IA, une solution pour éviter les discriminations ?

Des chercheurs en IA améliorent la méthode permettant de supprimer les préjugés sexistes dans les systèmes conçus pour comprendre et répondre aux données textuelles ou vocales, selon une étude

Répondre avec citation

Répondre avec citation

Partager