Microsoft et Meta devraient disposer de plus de 150 000 puces d'IA Nvidia H100 chacun au quatrième trimestre

Nvidia aurait expédié un demi-million de GPU A100 et H100 au troisième trimestre

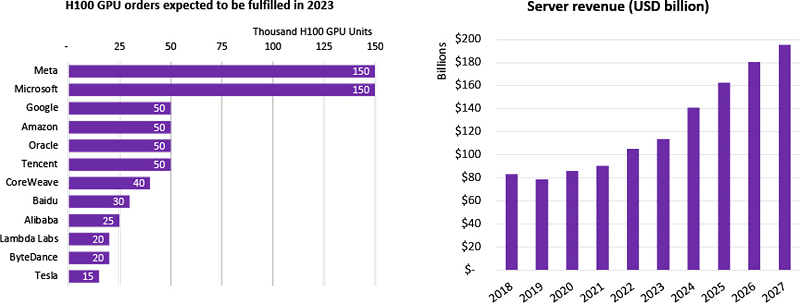

Nvidia a du mal à faire face à la demande sans cesse croissante pour ses accélérateurs d'IA H100 destinés au développement de l'IA et au calcul haute performance (HPC). Une analyse publiée par Omdia indique que Nvidia a vendu près d'un demi-million de GPU A100 et H100 et que la demande pour ces processeurs est si élevée que le délai d'approvisionnement des serveurs basés sur le H100 est de 36 à 52 semaines. L'analyse indique que Meta et Microsoft sont les plus gros acheteurs, ces entreprises ayant acheté chacune jusqu'à 150 000 GPU H100. C'est nettement supérieur au nombre de puces d'IA H100 achetées par Google, Amazon, Oracle et Tencent (50 000 chacun).

Nvidia a largement dominé le marché des accélérateurs d'IA (ou processeurs de traitement neuronal) avec des ventes records au cours des derniers trimestres. Les analyses révèlent que le chiffre d'affaires de Nvidia au troisième trimestre 2024 a augmenté de 206 % en glissement annuel, établissant un record. Avec la généralisation de l'IA générative, la demande pour ses puces d'IA, nécessaires à l'apprentissage automatique (ML) et au HPC, a considérablement augmenté. Nvidia a déclaré avoir réalisé un bénéfice net de 9,2 milliards de dollars pour un chiffre d'affaires record de 18,1 milliards de dollars au cours du trimestre qui s'est achevé le 29 octobre.

Jensen Huang, cofondateur et PDG de Nvidia, affirme : « notre forte croissance reflète la transition de la plateforme de l'industrie générale vers l'informatique accélérée et l'IA générative. Les GPU, les CPU, le réseau, les services de fonderie d'IA et le logiciel NVIDIA AI Enterprise de Nvidia sont tous des moteurs de croissance en plein essor. L'ère de l'IA générative est en train de décoller ». Un rapport sur les livraisons de Nvidia révèle que la société a vendu un demi-million de GPU H100 au troisième trimestre grâce à Meta et Microsoft. (La demande pour les processeurs d'IA de Nvidia serait si élevée que les délais de livraison pourraient atteindre 52 semaines.)

Omdia, une société de suivi du marché, estime que Meta et Microsoft sont les plus gros acheteurs de GPU H100 de Nvidia. Microsoft et Meta ont acheté chacun jusqu'à 150 000 GPU H100, soit beaucoup plus que le nombre de processeurs H100 achetés par Google, Amazon, Oracle et Tencent (50 000 chacun). Il convient de noter que la majorité des GPU de serveurs sont fournis aux fournisseurs de services de cloud à grande échelle. Selon le rapport d'Omdia, les équipementiers de serveurs (comme Dell, Lenovo et Hewlett Packard Enterprise) ne peuvent pas encore obtenir suffisamment de GPU pour l'IA et le HPC afin d'honorer leurs commandes de serveurs.

Le cabinet d'analyse révèle que les livraisons de serveurs pour 2023 sont comprises entre -17 % et -20 % d'une année sur l'autre, tandis que les revenus des serveurs pour 2023 sont compris entre +6 % et +8 % d'une année sur l'autre. Parallèlement, Omdia affirme qu'il est important de noter que la quasi-totalité des entreprises qui achètent en grandes quantités les puces d'IA H100 de Nvidia développe également du silicium personnalisé pour les cas d'utilisation comme l'IA, le HPC et les charges de travail vidéo. Par conséquent, leurs achats de matériel Nvidia diminueront probablement au fil du temps, à mesure qu'elles passeront à leurs propres puces.

Dans le même temps, Nvidia est de plus en plus talonnée par son rival AMD. AMD a lancé au début du mois un nouvel accélérateur d'IA appelé "Instinct MI300X". Lisa Su, PDG d'AMD, et ses collègues ont présenté les prouesses du MI300X en le comparant aux performances d'inférence du H100 de Nvidia à l'aide de Llama 2. La puce d'AMD devrait coûter moins cher que les produits concurrents de Nvidia, dont le prix peut atteindre 40 000 dollars l'unité. Et Microsoft et Meta ont déjà annoncé qu'ils achèteront le nouvel accélérateur d'IA MI300X d'AMD afin de réduire leur dépendance à l'égard du matériel de Nvidia. Ce qui annonce une rivalité intense.

En lançant le MI300X, AMD a affirmé qu'il peut égaler, voire surpasser jusqu'à 1,6x, les performances de l'accélérateur H100 de Nvidia. Mais Nvidia n'a pas apprécié la comparaison et a répliqué avec des benchmarks indiquant que sa puce H100 affiche des performances nettement supérieures à celle du MI300X lorsqu'on l'évalue en prenant en compte ses optimisations. AMD a répondu à l'analyse de Nvidia avec de nouvelles mesures suggérant que son processeur MI300X a des performances 30 % plus élevées que le H100. AMD et Nvidia se disputent le titre de l'entreprise qui fabrique la meilleure d'IA, ce qui pourrait favoriser l'innovation dans le secteur.

Mais le H100 ne sera bientôt plus d'actualité. Nvidia présentera au début de l'année prochaine les puces GH200, qui succéderont aux H100. AMD n'a pas comparé ses nouvelles puces avec ce dernier, mais avec le H100. Il est évident que les performances de la nouvelle puce H200 seront supérieures à celles des puces précédentes. Étant donné que la concurrence est si serrée, AMD pourrait finir par être traité comme une option de secours par certaines entreprises, dont Meta, Microsoft et Oracle. Intel travaille également sur des puces d'IA et le PDG Pat Gelsinger s'attend à ce que la taille du marché des GPU atteigne 400 milliards de dollars d'ici 2027.

En attendant, à l'horizon 2027, la valeur du marché des serveurs est estimée à un montant stupéfiant de 195,6 milliards de dollars. Cette trajectoire de croissance est alimentée par l'évolution vers des serveurs conçus pour des applications spécifiques et dotés d'une gamme variée de coprocesseurs. Parmi les exemples, on peut citer les serveurs d'Amazon dédiés à l'inférence des modèles d'IA, qui possèdent 16 coprocesseurs Inferentia 2, et les serveurs de transcodage vidéo de Google, équipés de 20 VCU (Video Coding Unit) personnalisés. Meta a également emboîté le pas avec des serveurs équipés de 12 processeurs personnalisés pour le traitement vidéo.

Ce penchant pour les configurations de serveurs personnalisées et optimisées pour les applications est appelé à devenir la norme à mesure que l'on se rendra compte de la rentabilité de la construction de processeurs spécialisés, les médias et l'IA étant actuellement les têtes de file, tandis que d'autres secteurs tels que la gestion de bases de données et les services Web devraient se joindre au mouvement.

Source : Omdia

Et vous ?

Quel est votre avis sur le sujet ?

Que pensez-vous de la forte demande des GPU Nvidia A100 et H100 ?

AMD a-t-il des chances de faire de l'ombre à Nvidia avec sa puce d'IA MI300X ?

Voir aussi

Le chiffre d'affaires de NVIDIA a triplé au cours du troisième trimestre, pour atteindre un niveau record de 18,1 milliards de dollars, la société ayant réalisé un bénéfice net de 9,2 milliards de $

AMD répond à Nvidia avec de nouveaux benchmarks indiquant que sa puce MI300X a des performances 30 % plus élevées que le H100, Nvidia avait contesté les premiers tests de performance d'AMD

Meta et Microsoft annoncent qu'ils achèteront la nouvelle puce d'IA d'AMD pour remplacer celle de Nvidia

Répondre avec citation

Répondre avec citation

Partager