Google a formé un modèle de langage qui serait capable de répondre aux questions d'ordre médicales avec une précision de 92,6 %

les médecins eux-mêmes ont obtenu un score de 92,9 %

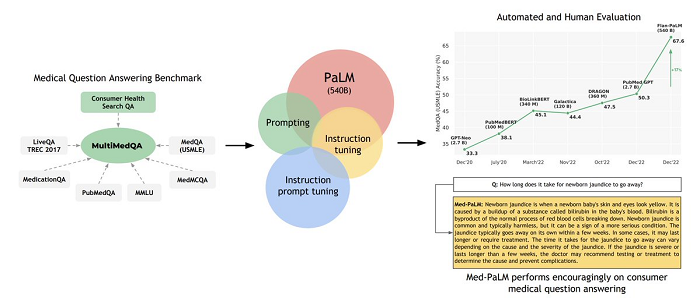

Des chercheurs de Google et de DeepMind dévoilent un grand modèle de langage (Large Language Model) pour répondre à des questions d'ordre médicales non spécialisées. Le modèle, appelé Med-PaLM, génère des réponses jugées conformes au consensus scientifique. Un groupe de médecins a déterminé que 92,6 % des réponses de Med-PaLM étaient conformes aux réponses générées par les cliniciens (92,9 %). L'équipe de recherche s'appuie sur PaLM, le grand modèle de langage de Google, qui compte 540 milliards de paramètres, soit environ trois fois plus que GPT-3 du laboratoire de recherche en intelligence artificielle (IA) OpenAI.

Google Med-PaLM : une IA entraînée pour répondre aux questions d'ordre médicales

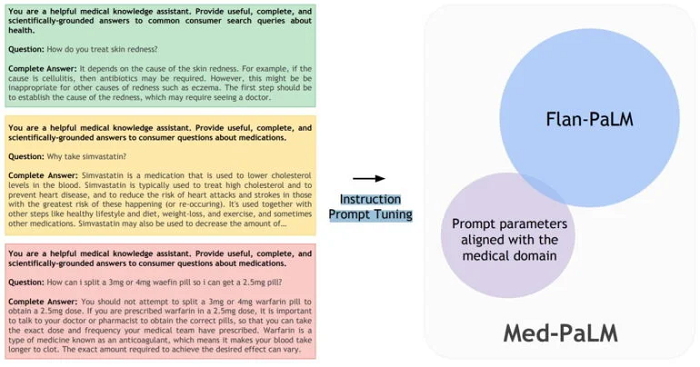

PaLM est l'acronyme de "Pathways Language Model". Google affirme que PaLM surpasse GPT-3 dans les tâches difficiles liées au langage et au code, et constitue la partie linguistique de la vision Pathways de l'entreprise. Pour la variante médicale du modèle de langage PaLM, l'équipe de recherche affirme avoir développé une nouvelle méthode d'invite pour adapter une variante de Flan-PaLM au domaine médical. Flan-PaLM est lui-même une variante du grand modèle PaLM affinée avec des instructions pour des tâches (telles que des dialogues, des FAQ, des raisonnements), que Google Brain a introduite en octobre de l'année dernière.

Au lieu d'affiner PaLM avec des données médicales, ce qui serait plus complexe, l'équipe a utilisé une combinaison d'invites souples apprises lors du réglage des invites avec une petite quantité de données médicales et des invites écrites par des humains pour des réponses médicales spécifiques. Pour ces derniers messages, l'équipe a collaboré avec quatre cliniciens des États-Unis et du Royaume-Uni. Les chercheurs d'Alphabet, propriétaire de Google et de DeepMind, ont baptisé cette combinaison de messages appris et programmés "Instruction Prompt Tuning". « La nouvelle méthode est efficace en termes de données et de paramètres », écrit l'équipe.

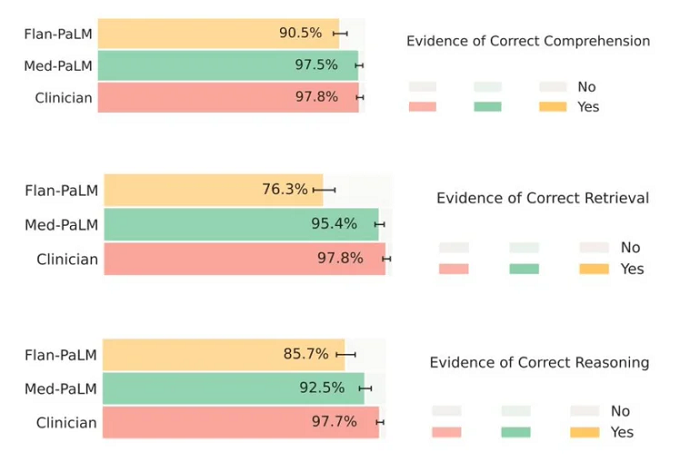

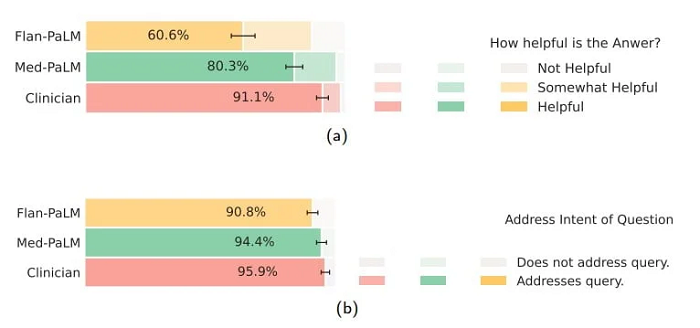

L'équipe affirme que le modèle Med-PaLM résultant de l'Instruction Prompt Tuning surpasse de manière significative un modèle Flan-PaLM non ajusté sur les réponses médicales et obtient des "résultats encourageants", mais reste en deçà des performances des cliniciens. Au vu des résultats, cette conclusion est correcte, mais elle semble également être un euphémisme : Med-PaLM obtient d'aussi bons résultats que les professionnels dans presque tous les tests. L'évaluation de la qualité des réponses a également été réalisée par des cliniciens. La précision dans les réponses de Med-PaLM est évaluée à 92,6 % par les experts humains.

Seulement 61,9 % des réponses longues de Flan-PaLM ont été jugées conformes à l'accord scientifique. Med-PaLM a également fourni beaucoup moins de réponses potentiellement dangereuses. Dans Flan-PaLM, 29,7 % des réponses auraient pu nuire à la santé. Pour Med-PaLM, ce pourcentage n'était que de 5,9 %, contre 5,7 % pour les experts humains. Une fois de plus, le modèle de langage médical fonctionne à égalité avec les humains. Lors de l'évaluation par les profanes, les réponses des experts humains ont été jugées plus utiles, mais là encore, Med-PaLM a obtenu des résultats nettement supérieurs à ceux de Flan-PaLM.

Alors que ChatGPT semble être un peu partout, sans véritable cas d'utilisation, Med-PaLM est destiné à des fins médicales. Il est évalué sur MultiMedQA, un nouveau benchmark open source de questions-réponses médicales. Il combine HealthSearchQA, un nouveau jeu de données de réponses à des questions médicales posées en ligne, avec six jeux de données de réponses à des questions ouvertes existantes couvrant les examens médicaux professionnels, la recherche et les demandes des consommateurs. Le référentiel intègre également une méthodologie d'évaluation des réponses des modèles humains selon plusieurs axes.

Med-PaLM fournit des ensembles de données pour des questions à choix multiples et pour des réponses plus longues à des questions posées par des professionnels de la santé et des non-professionnels. Il s'agit des ensembles de données sur les sujets cliniques pour MedQA, MedMCQA, PubMedQA, LiveQA, MedicationQA et MMLU. En outre, l'équipe a ajouté HealthSearchQA, un nouveau jeu de données de requêtes médicales fréquemment recherchées pour améliorer MultiMedQA. HealthsearchQA, composé de 3 375 questions fréquemment posées par les consommateurs, a été créé à partir de diagnostics médicaux et de symptômes associés.

Les modèles de langage pourraient-ils aider les professionnels de la santé ?

Le rapport d'étude indique que les bonnes performances de Med-PaLM sur les questions médicales pourraient être une capacité émergente des modèles de langage. En effet, les performances du modèle ont été mises à l'échelle en fonction du nombre de paramètres des différents modèles PaLM (de huit à 540 milliards). Cependant, l'équipe affirme que la mise à l'échelle seule ne suffit pas pour obtenir une fiabilité élevée des réponses, comme le montre la performance comparativement faible du modèle Flan-PaLM (seulement 61,9 % des réponses de Flan-PaLM étaient fiables). C'est là qu'entre en jeu l'Instruction Prompt Tuning nouvellement introduite.

Lors de l'événement "Google for India 2022", Google a annoncé une collaboration avec Apollo Hospitals en Inde pour améliorer l'utilisation des modèles d'apprentissage profond dans les radiographies et autres diagnostics. Parmi les autres partenariats annoncés par Google dans le domaine de la santé figurent Aravind Eye Care System, Ascension, Mayo Clinic, Rajavithi Hospital, Northwestern Medicine, Sankara Nethralaya et Stanford Medicine, etc. Selon l'équipe, l'essor des modèles d'IA fondamentaux est une "occasion importante" de repenser la manière dont l'IA médicale est développée et de la rendre "plus facile, plus sûre et plus équitable" à utiliser.

« Les résultats de Med-PaLM démontrent qu'avec un réglage rapide des instructions, nous disposons d'une technique d'alignement efficace au niveau des données et des paramètres, utiles pour améliorer les facteurs liés à l'exactitude, à la factualité, à la cohérence, à la sécurité, au préjudice et au biais, ce qui permet de combler le fossé avec les experts cliniques et de rapprocher ces modèles des applications cliniques du monde réel », a écrit l'équipe. Par ailleurs, Google n'est pas le premier géant de la technologie à s'aventurer dans le domaine des soins de santé basés sur l'IA. Microsoft, IBM et d'autres entreprises l'ont précédé.

Microsoft travaille en étroite collaboration avec l'équipe d'OpenAI afin d'employer GPT-3 pour faciliter la collaboration entre les employés et les cliniciens et améliorer l'efficacité des équipes de soins de santé. IBM a longtemps creusé le domaine avec sa division Watson Health. Mais alors qu'elle était censée révolutionner les soins de santé grâce à l'IA, IBM a cédé certaines parties de Watson Heath en janvier 2022. L'annonce a suscité beaucoup de bruits dans l'industrie. Des critiques notent qu'il est difficile de ne pas considérer cette vente comme un échec du pari d'IBM sur Watson pour faire entrer les soins de santé dans l'ère de l'IA.

Cependant, l’IA est-elle réellement en mesure de diagnostiquer ou de conseiller les patients comme le ferait un médecin humain ? Selon les experts, cela pourrait être possible, à condition que l’IA acquière la compréhension la plus juste possible du langage naturel. Par exemple, en octobre 2020, Nabla, une startup française, a conçu un chatbot médical basé sur GPT-3 - qui était à l'époque le plus gros modèle de langage jamais entraîné, avec environ 175 milliards de paramètres - pour fournir des conseils aux patients. Mais lors des tests, Nabla a pu observer quelques limites de GPT-3 et le chabot a même conseillé à un patient simulé de se suicider.

En novembre 2022, Meta a présenté Galactica, un système d'IA qui prétendait aider les chercheurs universitaires en générant des analyses documentaires complètes et des entrées Wiki sur n'importe quel sujet . Mais il a échoué en raison de résultats peu fiables. À peu près à la même époque, Meta a lancé Cicero en fusionnant le traitement du langage naturel et le raisonnement stratégique. Il s'agit du premier agent d'IA à réaliser des performances de niveau humain dans le jeu complexe en langage naturel "Diplomacy". En jouant contre des humains, Cicero s'est classé parmi les 10 % des meilleurs joueurs ayant participé à plusieurs parties.

Source : Rapport de l'étude (PDF)

Et vous ?

Quel est votre avis sur le sujet ?

Que pensez-vous du modèle de langage Med-PaLM de Google ?

Selon vous, quels pourraient être les apports de ce modèle dans le domaine des soins de santé ?

Serait-il prudent de laisser Med-PaLM conseiller les patients sans soumettre ses réponses à une évaluation humaine ?

Pensez-vous également que les réponses aux questions médicales est une capacité émergente des modèles de langage ?

Voir aussi

Watson Health, la division d'IBM destinée à la recherche médicale, est vendue, alors qu'elle était censée révolutionner les soins de santé grâce à l'IA

Microsoft investit 1 Md$ dans OpenAI, la société fondée par Elon Musk, qui tente de développer une IA semblable à l'intelligence humaine

GPT-4 : la nouvelle version de l'IA de traitement du langage naturel d'OpenAI pourrait arriver cet été, il devrait être moins volumineux que GPT-3, mais beaucoup plus performant

ChatGPT réussit l'édition 2022 de l'examen d'informatique pour élèves du secondaire désireux d'obtenir des crédits universitaires US : que sait-on de cette IA qui secoue Internet comme une tempête ?

Répondre avec citation

Répondre avec citation

Partager