Cerebras dévoile le Wafer Scale Engine Two (WSE-2), une puce de 2,6 mille milliards de transistors

et de 850 000 cœurs optimisés pour l'IA

L'IA et les technologies associées, apprentissage automatique et apprentissage profond, se développent rapidement et les puces traditionnelles de l'industrie ont très vite été dépassées par la puissance de calcul qu'elles requièrent. Ainsi, en 2019, Cerebras a décidé de relever le défi en concevant une puce révolutionnaire, principalement pour l'IA et le HPC. Cette semaine, il a dévoilé une mise à jour de ce processeur, le Wafer Scale Engine 2 (WSE-2). Il est doté d'un nombre record de 2,6 mille milliards de transistors et de 850 000 cœurs optimisés pour l'IA. Cerebras a annoncé qu'il a été conçu spécialement pour les tâches de supercalculateur.

Des puces plus grandes optimisées pour l'IA et le HPC

Ces dernières années ont vu une surabondance de processeurs entrer sur le marché dans le but d'accélérer les charges de travail d'IA et d'apprentissage automatique. En raison des différents types d'algorithmes d'apprentissage automatique possibles, ces processeurs sont souvent axés sur quelques domaines clés, mais une chose les limite tous : la taille du processeur. Il y a deux ans, Cerebras Systems a dévoilé une révolution dans la conception du silicium : un processeur aussi grand qu'une tête et utilisant autant de surface sur une plaquette de 30 centimètres qu'une conception rectangulaire le permettrait.

Il est construit en 16 nm et est axé sur les charges de travail de l'IA et du HPC (High-performance computing – calcul intensif). Il y a quelques jours, la société a lancé la deuxième génération de son produit. Il est construit suivant le procédé 7nm de TSMC et multiplie le nombre de coeurs de la première génération par deux. En effet, en 2019, Cerebras pouvait faire tenir 400 000 cœurs et 1,2 mille milliards de transistors sur une puce de type plaquette, la CS-1. Mais la nouvelle puce est construite avec un processus haut de gamme de 7 nm, ce qui signifie que la largeur entre les circuits est de sept milliardièmes de mètre.

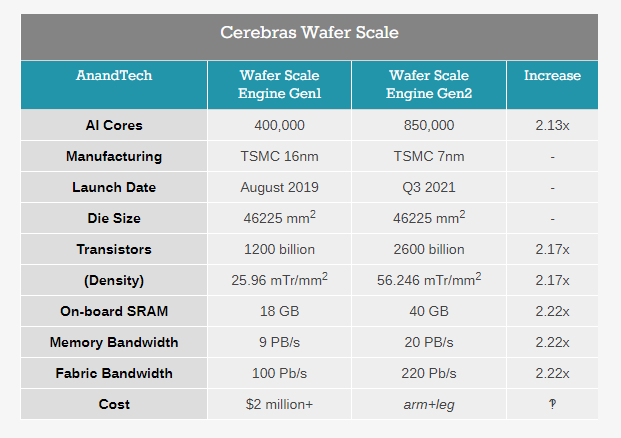

Grâce à une telle miniaturisation, Cerebras peut faire entrer beaucoup plus de transistors sur la même plaquette de 12 pouces. Elle découpe cette plaquette circulaire en un carré d'environ 20 centimètres sur 20 centimètres et expédie le dispositif sous cette forme. La conception du WSE-2 permet de réduire la logique, ainsi que, dans une certaine mesure, les SRAM, et la nouvelle puce embarque 850 000 cœurs d'IA. En fait, presque tout ce qui concerne la nouvelle puce est multiplié par deux, comme le montre l'image ci-dessous.

À titre de comparaison, le deuxième plus grand processeur d'IA du marché a une surface d'environ 826 mm2, avec 0,054 mille milliards de transistors. Cerebras cite également une mémoire embarquée 1000 fois plus importante, avec 40 Go de SRAM, contre 40 Mo pour l'Ampere A100. « Nous avons 123 fois plus de cœurs et 1 000 fois plus de mémoire sur la puce, ainsi que 12 000 fois plus de bande passante mémoire et 45 000 fois plus de bande passante fabric », a déclaré Andrew Feldman, PDG de Cerebras. « Nous avons été agressifs sur la géométrie de mise à l'échelle, et nous avons apporté un ensemble d'améliorations à la microarchitecture ».

Les cœurs sont reliés par un maillage 2D avec des chemins de données FMAC. Cerebras a annoncé avoir atteint un rendement de 100 % en concevant un système dans lequel tout défaut de fabrication peut être contourné. Initialement, Cerebras aurait 1,5 % de cœurs supplémentaires pour tenir compte des défauts. L'objectif de Cerebras avec WSE est de fournir une plateforme unique, conçue grâce à des brevets innovants, qui a permis d'obtenir des processeurs plus grands, utiles pour les calculs d'IA, mais qui a également été étendue à un plus large éventail de charges de travail HPC.

Bibliothèques d'IA et de ML, clients et partenaires de Cerebras

L'une des clés de la conception du WSE est le compilateur de graphes personnalisé, qui prend PyTorch ou TensorFlow et fait correspondre chaque couche à une partie physique de la puce, ce qui permet un calcul asynchrone au fur et à mesure que les données circulent. Avec un processeur de cette taille, les données n'ont jamais besoin de sortir de la puce et d'attendre dans la mémoire, ce qui gaspille de l'énergie, et peuvent continuellement passer à l'étape suivante du calcul de manière pipelinée.

En ce qui concerne les clients, la société compte plusieurs dizaines de clients disposant de systèmes déployés et opérationnels, dont un certain nombre de laboratoires de recherche, de sociétés pharmaceutiques, de recherche en biotechnologie, de militaires et d'industries pétrolières et gazières. Lawrence Livermore possède un CS-1 couplé à son superordinateur "Lassen" de 23 PFLOP. Le Pittsburgh Supercomputer Center aurait acheté deux systèmes grâce à une subvention de 5 millions de dollars, et ces systèmes sont attachés à leur superordinateur Neocortex, ce qui permet de faire simultanément de l'IA et du calcul intensif.

Par ailleurs, Cerebras vend aujourd'hui des systèmes CS-1 complets sous la forme d'un boîtier 15U qui contient un WSE-1 avec 12x100 GbE, douze alimentations de 4 kW (6 redondantes, puissance de pointe d'environ 23 kW), et les déploiements dans certaines institutions sont associés au SuperDome Flex de HPE. Le nouveau système CS-2 partage cette même configuration, mais avec plus du double de cœurs et le double de mémoire embarquée, tout en conservant la même puissance. Par rapport à d'autres plateformes, ces processeurs sont disposés verticalement à l'intérieur du design 15U.

Cela permet un accès facile ainsi qu'un refroidissement liquide intégré pour un processeur de cette taille. Il convient aussi de noter que ces portes avant sont usinées à partir d'une seule pièce d'aluminium. Le même compilateur et les mêmes logiciels avec les mises à jour permettent à tout client qui a testé des charges de travail d'IA avec le premier système d'utiliser le second au moment où il en déploie un. Cerebras a annoncé avoir travaillé sur des implémentations de plus haut niveau pour permettre aux clients disposant de modèles TensorFlow et PyTorch standardisés d'assimiler très rapidement leur code GPU existant.

Ils peuvent faire cela en ajoutant quelques lignes de code et en utilisant le compilateur de graphes de Cerebras. Le compilateur divise ensuite l'ensemble des 850 000 cœurs en segments de chaque couche qui permettent le flux de données de manière pipelinée sans décrochage. Le silicium peut également être utilisé pour plusieurs réseaux simultanément pour la recherche de paramètres. Selon Cerebras, le fait de disposer d'une solution à puce unique d'une telle taille signifie que la barrière des méthodes d'apprentissage distribuées sur des centaines de puces d'IA est désormais grandement éloignée.

Ainsi, cette complication supplémentaire n'est pas nécessaire dans la plupart des scénarios. Toutefois, Cerebras tient à souligner que deux systèmes CS-2 permettent d'obtenir 1,7 million de cœurs d'IA dans un rack standard de 42U, ou trois systèmes pour 2,55 millions dans un rack plus grand de 46U (en supposant qu'il y ait suffisamment de puissance pour tous ces systèmes en même temps.

Lors de la conférence Hot Chips 2020, Sean Lie, architecte matériel en chef, a déclaré que l'un des principaux avantages de Cerebras pour les clients était la possibilité de simplifier les charges de travail qui nécessitaient auparavant des racks de GPU/TPU. Ces charges de travail peuvent désormais être exécutées sur un seul WSE de manière pertinente sur le plan informatique.

Source : Cerebras Systems

Et vous ?

Quel est votre avis sur le sujet ?

Que pensez-vous de la nouvelle puce de Cerebras et de ses caractéristiques ?

Voir aussi

Nvidia annonce le GPU A100 80 Go pour sa plateforme de calcul intensif "Nvidia HGX AI", avec deux fois plus de mémoire que son prédécesseur, l'A100 40 Go

Cerebras lance une énorme puce de 22 cm pour l'entraînement de réseaux neuronaux, 400 000 cœurs avec 18 Go de registres

NVIDIA va concevoir des processeurs haute performance basés sur la technologie Arm, s'attaquant ainsi à Intel avec une nouvelle technologie destinée à l'IA avancée

![Nom : Cerebras WSE2 Launch Embargoed until 4 20 21[2][2][3][3][4][1]-page-017_575px.jpg

Affichages : 2183

Taille : 26,4 Ko](https://www.developpez.net/forums/attachments/p596427d1619181130/general-developpement/algorithme-mathematiques/intelligence-artificielle/cerebras-devoile-wafer-scale-engine-two-wse-2-puce-2-6-mille-milliards-transistors/cerebras-wse2-launch-embargoed-until-4-20-21-2-2-3-3-4-1-page-017_575px.jpg/)

![Nom : Cerebras WSE2 Launch Embargoed until 4 20 21[2][2][3][3][4][1]-page-019_575px.jpg

Affichages : 2197

Taille : 35,2 Ko](https://www.developpez.net/forums/attachments/p596428d1619181166/general-developpement/algorithme-mathematiques/intelligence-artificielle/cerebras-devoile-wafer-scale-engine-two-wse-2-puce-2-6-mille-milliards-transistors/cerebras-wse2-launch-embargoed-until-4-20-21-2-2-3-3-4-1-page-019_575px.jpg/)

![Nom : Cerebras WSE2 Launch Embargoed until 4 20 21[2][2][3][3][4][1]-page-024_575px.jpg

Affichages : 2186

Taille : 47,2 Ko](https://www.developpez.net/forums/attachments/p596430d1619181193/general-developpement/algorithme-mathematiques/intelligence-artificielle/cerebras-devoile-wafer-scale-engine-two-wse-2-puce-2-6-mille-milliards-transistors/cerebras-wse2-launch-embargoed-until-4-20-21-2-2-3-3-4-1-page-024_575px.jpg/)

Répondre avec citation

Répondre avec citation

Partager