Nvidia dévoile GPU Ampere A100, une puce d'intelligence artificielle, avec 54 milliards de transistors

et peut exécuter 5 pétaflops de performances

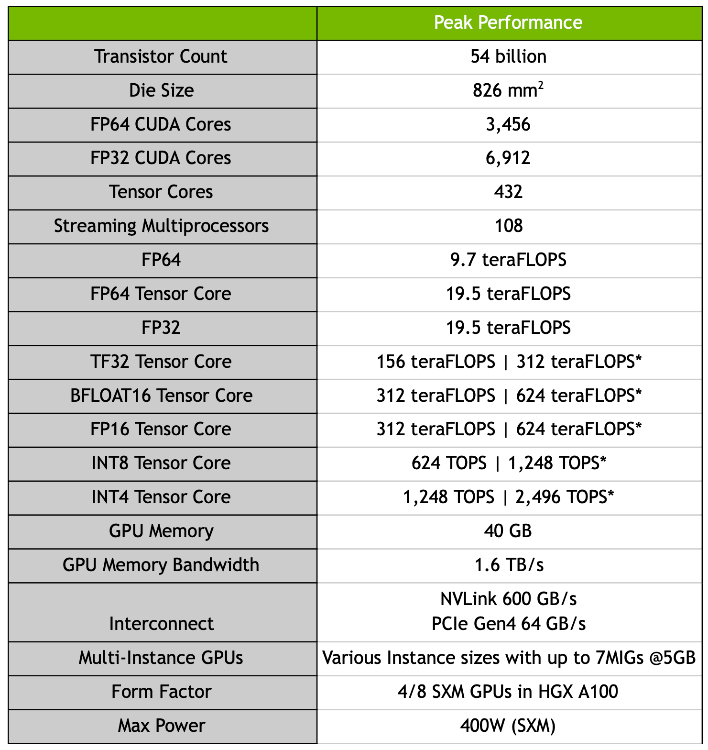

Jensen Huang, PDG de NVIDIA, a dévoilé hier la nouvelle architecture GPU Ampere A100 de la société dédiée à l'apprentissage automatique et aux marchés HPC. Jensen affirme que l'A100 est le GPU NVIDIA le plus grand et le plus puissant jamais conçu, et qu'il s'agit également de la plus grande puce jamais produite sur un processus semi-conducteur de 7 nm. L'A100 compte au total 6912 cœurs FP32 CUDA, 432 cœurs Tensor et 108 SM (Streaming Multiprocessors), couplés à 40 Go de mémoire HBM2e avec une bande passante mémoire maximale de 1,6 To/s.

Jensen Huang a discuté de la récente acquisition de Mellanox par NVIDIA, de nouveaux produits basés sur l'architecture GPU NVIDIA Ampere très attendue de la société et d'importantes nouvelles technologies logicielles. « NVIDIA A100 , le premier GPU basé sur l'architecture NVIDIA Ampere, offrant le plus grand saut de performance générationnelle des huit générations de GPU NVIDIA, est également conçu pour l'analyse de données, le calcul scientifique et les graphiques cloud, et est en production complète et expédié aux clients du monde entier », a annoncé Huang. Il est doté de 54 milliards de transistors. Le lancement était initialement prévu pour le 24 mars dernier, mais a été retardé à cause de la pandémie du covid-19.

Le calcul FP32 arrive à 19,5 TLFLOP, contre 16,4 TFLOP pour le Tesla V100 de génération précédente de NVIDIA. De plus, ses cœurs de tensors utilisent une précision FP32 qui permet une augmentation de 20 fois des performances de l'IA de génération en génération. En ce qui concerne les performances FP64, ces cœurs de tensors offrent également une amélioration des performances de 2,5 fois par rapport à son prédécesseur, Volta. Les fonctionnalités supplémentaires incluent le GPU multi-instance, alias MIG, qui permet de diviser un GPU A100 en sept instances discrètes, de sorte qu'il peut être provisionné pour plusieurs charges de travail spécialisées discrètes.

Dix-huit des principaux fournisseurs de services et constructeurs de systèmes au monde les intègrent, parmi lesquels Alibaba Cloud, Amazon Web Services, Baidu Cloud, Cisco, Dell Technologies, Google Cloud, Hewlett Packard Enterprise, Microsoft Azure et Oracle. NVIDIA propose également une troisième génération de son système NVIDIA DGX AI basé sur NVIDIA A100 - le NVIDIA DGX A100 - le premier serveur au monde à 5 pétaflops. Et chaque DGX A100 peut être divisé en 56 applications, toutes fonctionnant indépendamment.

A100 sera également disponible pour les fabricants de serveurs cloud sous le nom de HGX A100. Un centre de données alimenté par cinq systèmes DGX A100 pour la formation et l'inférence de l'IA fonctionnant sur seulement 28 kilowatts de puissance, coûtant 1 million de dollars, peut faire le travail d'un centre de données typique avec 50 systèmes DGX-1 pour la formation d'IA et 600 systèmes CPU consommant 630 kilowatts et coûtant plus de 11 millions de dollars, a expliqué Huang.

Nvidia a déclaré qu'un certain nombre des plus grandes entreprises, prestataires de services et agences gouvernementales du monde avaient passé des commandes initiales pour le DGX A100, les premiers systèmes étant livrés à Argonne au début du mois. Rick Stevens, directeur de laboratoire associé pour l'informatique, l'environnement et les sciences de la vie à "Argonne National Lab", a déclaré dans un communiqué que les superordinateurs du centre sont utilisés pour lutter contre le coronavirus, avec des modèles et des simulations d'IA fonctionnant sur les machines dans l'espoir de trouver des traitements et un vaccin.

La puissance des systèmes DGX A100 permettra aux scientifiques d'effectuer une année de travail en mois ou en jours. L'Université de Floride sera la première institution américaine d'enseignement supérieur à recevoir les systèmes DGX A100, qu'elle déploiera pour infuser l'IA dans l'ensemble de son programme afin de favoriser une main-d'œuvre compatible avec l'IA. le Centre d'IA biomédicale du Centre médical universitaire de Hambourg-Eppendorf, en Allemagne, compte parmi les premiers à avoir adopté le DGX A100 pour faire progresser l'aide à la décision clinique et l'optimisation des processus.

Des milliers de systèmes DGX de la génération précédente sont actuellement utilisés dans le monde par un large éventail d'organisations publiques et privées. Parmi ces utilisateurs figurent quelques-unes des principales entreprises mondiales, y compris les constructeurs automobiles, les prestataires de soins de santé, les détaillants, les institutions financières et les sociétés de logistique qui adoptent l'IA dans leurs industries.

Source : NVIDIA

Et vous ?

Que pensez-vous des performances de la puce A100 ?

Voir aussi

Une intelligence artificielle de NVIDIA transforme des croquis en paysages photoréalistes en quelques secondes lors de la GPU Technology Conference

NVIDIA détaille la version PCI Express de ses cartes Volta avec une consommation énergétique réduite à 250 W et la fréquence amputée de 85 MHz

NVIDIA appelle les propriétaires de PC de jeu à mettre la puissance de leurs machines à contribution pour faire avancer la lutte contre Covid-19

NVIDIA et Microsoft annoncent une solution infonuagique pour le calcul de haute performance et l'entraînement de réseaux neuronaux profonds, les instances NDv2 proposent huit NVIDIA V100

Répondre avec citation

Répondre avec citation

Partager