Les sites marchands sur le Web attribuent secrètement des scores de confiance aux utilisateurs

en se basant sur leurs habitudes en ligne

Aujourd’hui, une bonne partie des entreprises qui offrent des services sur le Web veulent toujours savoir plus sur leurs clients afin de leur proposer les meilleurs services possible, mais dans le même temps ces clients sont de plus en plus inquiets quant au respect de leur vie privée. Dans un article publié par le Wall Street Journal (WSJ), le quotidien américain aborde le cas des sites marchands sur le Web. Selon le journal, les données recueillies sur presque tout ce que les gens achètent via ces plateformes, la façon dont ils les achètent ainsi que la provenance des achats sont soumises secrètement à des services de vérification qui repose sur l’intelligence artificielle. Ces services dont il s’agit se présentent comme ayant pour but d’aider les entreprises à se protéger des fraudes par cartes de crédit et d’autres formes de fraudes.

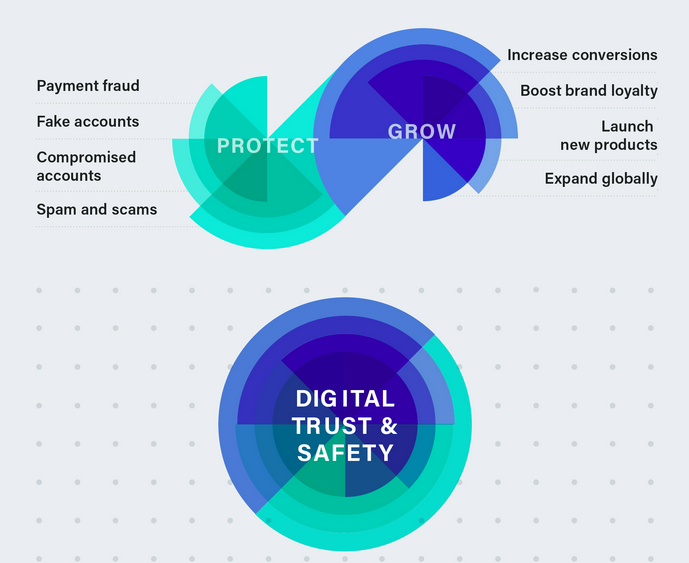

Le quotidien américain a énuméré plusieurs de ces services tels que Sift ou SecureAuth, mais a traité principalement du cas de Sift. Il s’agit d’un service de sécurisation et d’analyse de signaux liés aux utilisateurs d’un site Web qui est utilisé par de nombreuses sociétés dans le monde comme Twitter, Airbnb, LinkedIn ou encore OpenTable. L’entreprise offre des solutions pour réduire les risques liés aux paiements en ligne, pour protéger les utilisateurs d’un service contre les spams et les escroqueries et enfin permettre aux entreprises d’identifier les fausses inscriptions et les prises de contrôles et de les arrêter.

Dans le monde des transactions en ligne, ces services sont regroupés dans la catégorie qu’ils appellent "Digital Trust & Safety". « En tant que pionniers de Digital Trust & Safety, nous aidons plus de 34 000 sites et applications à trouver le juste équilibre entre la croissance de leurs revenus et la protection de leurs activités », indique le site Web de l’entreprise. D’après le WSJ, lorsque vous vous connectez à l’un de ces sites qui utilisent des solutions comme Sift, une quantité importante de données est recueillie sur vous, puis ses données sont passées à un système qui chargera de déterminer si vous êtes un robot ou un humain potentiellement dangereux.

« Lorsque vous vous connectez à un compte Starbucks, à une réservation Airbnb ou à une réservation sur OpenTable, de nombreuses informations vous concernant sont instantanément regroupées en un seul score, puis évaluées avec d'autres données personnelles pour déterminer si vous êtes un bot malveillant ou un humain potentiellement risqué », a indiqué le journal. Dans le cas de ces sites qui utilisent le service Sift, plus de 16 000 signaux de fraudes uniques sont analysés automatiquement pour générer une note ou un score appelé “Score Sift”, un nombre compris entre 1 et 100. Le score est utilisé pour signaler les périphériques, les cartes de crédit et les comptes qui présentent un comportement douteux.

« Chaque fois que nous obtenons un événement, qu'il s'agisse d'une vue de page ou d'un événement API, nous extrayons les fonctionnalités liées à ces événements et calculons le score de tamisage. Ces caractéristiques sont ensuite évaluées en fonction des fraudes constatées sur votre site et au sein de notre réseau mondial et déterminent le score d'un utilisateur. Certaines caractéristiques peuvent avoir un impact négatif sur un score, ainsi que d'autres avec un impact positif », indique le site de Sift. Selon le journal américain, plusieurs facteurs contribuent à vous attribuer un score Sift. Les facteurs énumérés par le WSJ sont comme ci-après :

- le compte est-il nouveau ?

- y a-t-il beaucoup de chiffres à la fin d'une adresse e-mail ?

- la transaction provient-elle d'une adresse IP inhabituelle pour votre compte ?

- la transaction provient-elle d'une région où il y a beaucoup de pirates, comme la Chine, la Russie ou l'Europe de l'Est ?

- la transaction provient-elle d'un réseau d'anonymisation ?

- la transaction a-t-elle lieu à une heure inconnue ?

- la carte de crédit utilisée est-elle associée à des rétros facturations ?

- le navigateur est-il différent de ce que vous utilisez habituellement ?

- l'appareil est-il différent de ce que vous utilisez habituellement ?

- la cadence de la manière dont vous avez saisi votre mot de passe est-elle typique pour vous ? (suivi par certains systèmes avancés)

- etc.

Comme l’indique le WSJ, cette pratique est bien évidemment précisée dans les politiques de confidentialité des sites Web qui en font usage. Cependant, la multitude d’informations recueillies ne sert-elle pas à d’autres usages ? Ces données sont-elles en sécurité là où elles sont ? Ces préoccupations viennent du fait que ces services citent bien souvent que leur objectif premier est de satisfaire les sites utilisateurs de leurs services. Les consommateurs bénéficient-ils d’une protection de leur vie privée ?

Le quotidien américain a indiqué que selon Sift et quelques-uns de ses concurrents comme SecureAuth, qui dispose d'un système de notation similaire, cette pratique est conforme aux réglementations telles que le règlement général sur la protection des données de l'Union européenne, qui impose aux entreprises de ne pas stocker de données pouvant être utilisées pour identifier de vrais êtres humains, sauf s’ils en donnent la permission. Néanmoins, rapporte le WSJ, certaines personnes soulignent l’importance capitale des données qui entrent en jeu dans ce genre de système et témoignent que les règlements comme le RGPD ou tout autre n’assurent pas pleinement la protection de la vie privée et des fois, certains des règlements énumérés seraient formulés de manière vague.

« Malheureusement, le RGPD, entré en vigueur il y a bientôt un an, dispose de certaines règles qui sont souvent formulées de manière vague. Tout cela devra être réglé devant le tribunal », déclare Lisa Hawke, vice-présidente de la sécurité et de la conformité juridique chez Everlaw. S’agissant des questions sur le biais que peuvent comporter les scores attribués aux utilisateurs des sites Web, l’entreprise a indiqué à travers une porte-parole que « Sift évalue régulièrement les performances de ses modèles et tente de minimiser les biais et la variance afin d'optimiser la précision ».

De son côté, SecureAuth, un concurrent direct de Sift, Stephen Cox, vice-président et architecte en chef de la sécurité de la société, a déclaré que bien qu’ils n'effectuent pas les biais d'audit sur les systèmes de leurs clients, ils permettent aux organisations qui utilisent leur plateforme d'avoir le plus de visibilité possible sur les arbres de décision, les modèles ou les données utilisés pour prendre une décision. « Dans certains cas, nous ne sommes peut-être pas tout à fait au courant des moyens par lesquels nos services et produits sont utilisés dans l'environnement d'un client », a-t-il ajouté.

Cela dit, bien que ces systèmes soient conçus pour détecter la fraude, les auteurs indiquent qu’il est très souvent difficile de distinguer un véritable achat d’une tentative de fraude. Si un utilisateur est jugé critique par son score Sift, il est dans certains cas logé dans un bac à sable pour tenter après de découvrir s’il existe de faux positifs dans le score Sift et de rétablir le compromis qu’il n’aurait pas dû être signalé comme un utilisateur malveillant.

Il y a de nombreuses caractéristiques qui indiquent qu’une transaction est louche. « Ce qui est étonnant pour moi, c'est que lorsqu'une personne ne parvient pas à se connecter efficacement, vous savez que c'est une personne réelle. Les robots se connectent parfaitement à chaque fois. Les adresses email avec beaucoup de chiffres à la fin et les nouveaux comptes sont également plus susceptibles d’être frauduleuses, tout comme les connexions provenant de réseaux d’anonymat tels que Tor », a déclaré Jacqueline Hart, responsable du Digital Trust & Safety chez Patreon, un site utilisé par les artistes et les créateurs pour permettre aux bienfaiteurs de les soutenir.

D’après le journal, ces services tirent également des renseignements de chaque transaction sur l'ensemble de leur système et comparent les données de plusieurs clients. Par exemple, si un compte ou un appareil mobile a été associé à une fraude chez Instacart, par exemple, cela pourrait être considéré comme risqué pour une autre société. Bien que Sift détermine s'il est possible ou non de faire confiance à un utilisateur donné, aucun fichier avec son nom ne peut être produit à des fins de révision, car il n'a pas besoin de son nom pour analyser le comportement de ce dernier. « Nos clients nous enverront des événements tels que “compte créé”, “photo de profil téléchargée”, “quelqu'un a envoyé un message”, “ un commentaire est écrit” , “un article a été ajouté au panier”, etc. », a déclaré Jason Tan, le PDG de Sift à ce propos.

Enfin, le journal précise que les questions qui cherchent à connaître celui qui assure la protection des données des utilisateurs entre Sift et ses clients sont les plus importantes. Dans ces conditions, il y a de place pour beaucoup de dérapages qui pourraient enfreindre les lois sur la confidentialité et personne ne serait au courant à moins d’effectuer un audit complet d’un tel système. « Je dirais que dans notre désir de protéger la vie privée, nous devons faire attention, car allons-nous empêcher les bons de remplir leurs fonctions de sécurité ? », se demande Anshu Sharma, cofondateur de Clearedin, une startup qui aide les entreprises à éviter les attaques de phishing par courrier électronique.

Source : WSJ

Et vous ?

Qu'en pensez-vous ?

Voir aussi

Apple attribue des scores de confiance aux utilisateurs d'iPhone en se basant sur la manière dont ils utilisent leurs appareils

La Chine interdit à 23 millions de personnes d'acheter des billets de voyage dans le cadre de son système de crédit social

La conférence Google I/O 2015 dévoile les projets Abacus et Vault pour sécuriser vos données

Chine : le système de crédit social a empêché des millions de personnes de réserver des vols ou des trains depuis qu'il est en test

Répondre avec citation

Répondre avec citation

Partager