Bonjour à tous,

Dans le cadre de mon "auto-formation" dans le domaine de l'IA et plus particulièrement des réseaux de neurones (j'apprécie le bio-mimétisme), je souhaite pouvoir développer un agent capable d'apprendre par renforcement.

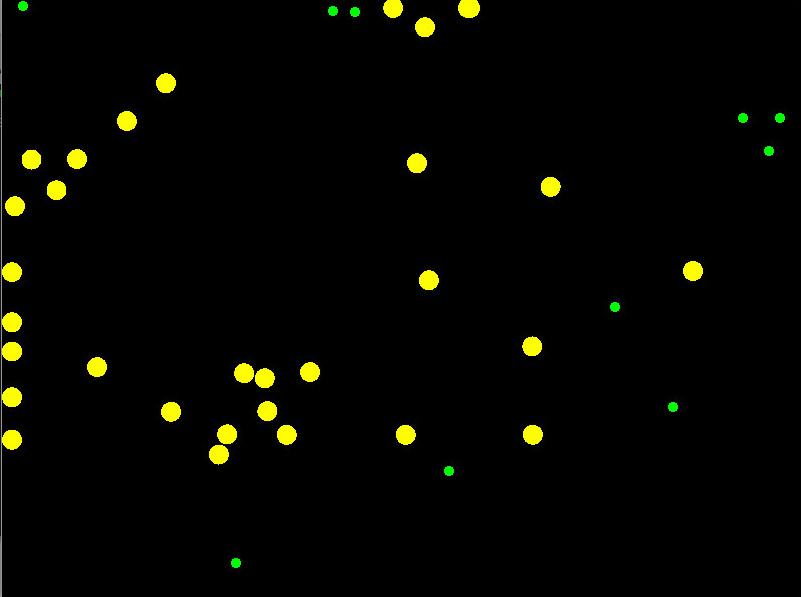

Je me suis alors lancé dans l'idée de créer un petit "jeux" assez simple où, dans un environnement dynamique et, à terme, non déterministe, l'agent doit collecter des points au sein d'un milieu hostile ; une sorte de mix entre un jeu de snake et un pacman en somme. En entrée, l'agent reçoit les positions et le type de tous les éléments présents dans son champ de vision, et en sortie deux valeurs réelles comprises entre -1 et 1 (un actionneur pour la rotation, un actionneur pour la translation).

Je me suis donc penché un peu sur le Q-Learning, couplé aux réseaux de neurones, mais rapidement, je m’aperçoit que ce n'est peut-être pas vraiment la meilleur solution pour mon problème. En effet, les actionneurs de mon agent sont la rotation et la translation, donc, techniquement, même si je limite l'environnement à une simple fenêtre, de 800 * 600, cela fait déjà au minimum 480000 états possibles pour l'agent, et en théorie, il existe une infinité d'actions possibles pour chaque entrée...

Je me demandais alors si oui ou non le Q-Learning était une solution viable pour mon problème, et, dans tous les cas, quels autres algorithmes d'apprentissage pouvaient s'avérer être de bonnes pistes, compte tenu du fait que je tiens vraiment à généraliser au maximum via réseaux de neurones.

D'avance, merci pour vos retours !

Répondre avec citation

Répondre avec citation

Partager