L’IA peut être facilement induite en erreur par des attaques contradictoires

Devrait-on s’en inquiéter ?

L’intégration toujours plus poussée de l’intelligence artificielle (IA) dans de nombreux domaines de la vie quotidienne (santé, sécurité, multimédia, transport, alimentation…) laisse entrevoir un avenir radieux pour cette technologie qui pourrait à l’avenir se révéler incontournable. L’IA est présentée habituellement comme une technologie fiable qui, comparée à un opérateur humain, offrirait de meilleures garanties sur divers plans (sécurité, cheminement logique, efficacité, efficience, rapidité d’exécution, etc.).

L’IA alimente de nombreux systèmes de sécurité ainsi qu’une grande variété de dispositifs militaires. Cette technologie est très utilisée pour la reconnaissance d’images et de sons ou encore la « vision » robotique. Elle permet notamment d’identifier avec une faible marge d’erreur le contenu d’un décor ou d’une image, mais également de transcrire assez fidèlement les mots et phrases prononcés par une personne. C’est d’ailleurs l’une des raisons qui expliquent son intégration avancée au sein des assistants virtuels intelligents qu’on retrouve sur de nombreux appareils.

Toutefois, le fait que l’être humain se repose davantage sur cette technologie en tant qu’interface privilégiée entre lui et le monde réel augmente l’enjeu et les répercussions négatives découlant de chaque mauvaise analyse et résultat rendus par l’IA. Il ne serait probablement pas dramatique de se rendre compte que l’assistant virtuel intelligent d’un smartphone s’est trompé lorsqu’il fallait interpréter une commande vocale, mais pourrait-on en dire autant si dans un moment d’égarement l’IA d’un véhicule autonome ne parvenait pas détecter un danger pourtant bien réel qui se présente sur la route ?

L’intelligence artificielle a beau offrir des garanties importantes sur le plan de la sécurité, elle n’en reste pas moins une technologie vulnérable. Elle serait d’ailleurs particulièrement sensible aux attaques dites « adversarial » (contradictoire) qui tirent parti de son fonctionnement basé sur le Deep Learning pour générer des perturbations de faible amplitude dans les données analysées et force l'IA à valider puis renvoyer un résultat incorrect.

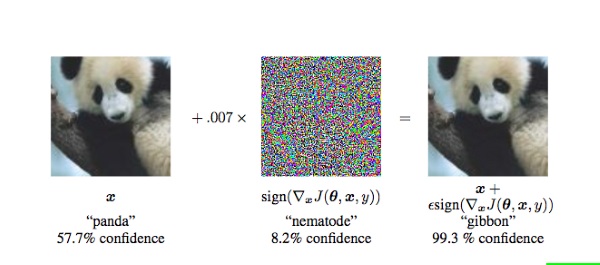

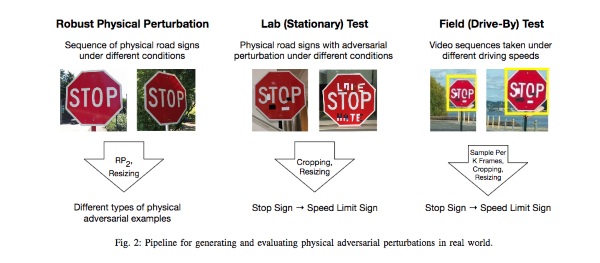

À ce propos, des études ont montré comment des modifications quasi imperceptibles à l’œil nu sur une image (celle d’un panda par exemple) pouvaient perturber une IA au point où cette dernière ne parvient plus à identifier la représentation exacte de l’image (l’IA reconnait un gibbon sur l’image en lieu et place du panda). De la même manière, on pourrait utiliser de simples autocollants (apposés par exemple sur des panneaux routiers) ou des lunettes comportant des motifs faits d’une multitude de lignes et de couleurs sur les verres pour tromper une IA.

Des sons peuvent également servir de perturbateurs. En effet, d’autres études ont démontré que des commandes vocales inaudibles cachées dans une bande-son peuvent induire en erreur une IA. Cette dernière analysera cette superposition comme ayant un sens totalement différent de la bande son apparente, un sens que l’attaquant générant le bruit de fond peut fixer à sa guise.

« On ne sait par contre pas exactement pourquoi ni comment ça marche », a confié le chercheur Jonathan Peck dans De Standaard avant d’ajouter : « On pense que cela détourne l’attention du système d’Intelligence artificielle à la manière d’un drapeau rouge pour un taureau. »

Ce système de perturbateur peut aussi être utilisé pour la protection de contenu puisqu’il est possible de rendre des contenus (images par exemple) illisibles en exploitant ce même procédé. On investit énormément dans le développement de l’IA sans trop se soucier de la sécurité, alors qu’il serait aussi important de considérer dans le même temps les risques liés aux attaques adversarial.

Source : Levif

Et vous ?

Qu’en pensez-vous ?

Voir aussi

Dix tendances technologiques qui pourraient marquer les entreprises en 2018 de l'intelligence artificielle à la réalité augmentée

L'intelligence artificielle est-elle l'arme de la prochaine guerre froide ? Oui répond un chercheur en informatique

Répondre avec citation

Répondre avec citation

Partager