Rapport scientifique international sur la sécurité de l'intelligence artificielle avancée : un rapport actualisé et fondé sur des données probantes concernant la sécurité de l'IA avancée.

Le rapport scientifique international sur la sécurité de l'intelligence artificielle avancée (International Scientific Report on the Safety of Advanced AI interim report) présente une compréhension actualisée et fondée sur des données scientifiques de la sécurité des systèmes d'intelligence artificielle avancés. Ce rapport indépendant, international et ouvert à tous est un événement marquant de la collaboration internationale.

C'est la première fois que la communauté internationale se réunit pour soutenir les efforts visant à construire une compréhension scientifique commune et fondée sur des preuves des risques liés à l'IA avancée. L'intention de créer un tel rapport a été annoncée lors du Sommet sur la sécurité de l'IA en novembre 2023. Ce rapport provisoire est publié avant le Sommet de Séoul sur l'IA en mai 2024. Le rapport final sera publié avant le sommet d'action sur l'IA qui se tiendra en France.

Le rapport provisoire se limite à un résumé des données sur l'IA à usage général, qui a progressé rapidement au cours des dernières années. Le rapport synthétise les données factuelles sur les capacités et les risques de l'IA à usage général et évalue les méthodes techniques permettant d'évaluer et d'atténuer ces risques.

Le rapport intérimaire met en évidence plusieurs éléments clés, notamment :

- L'IA à usage général peut être utilisée pour promouvoir l'intérêt public, ce qui se traduit par une amélioration du bien-être, de la prospérité et des découvertes scientifiques.

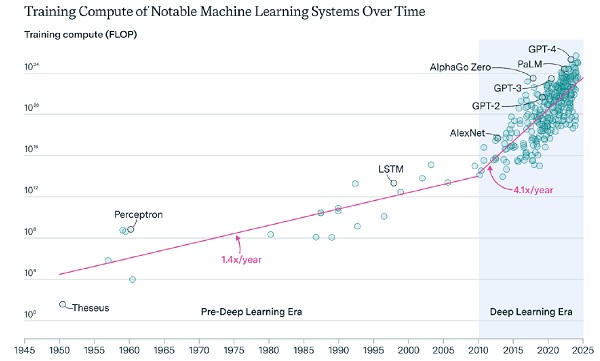

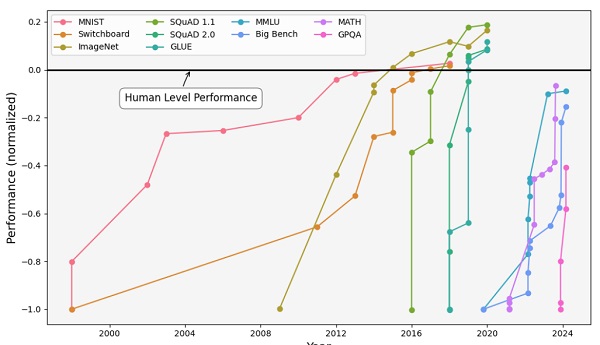

- Selon de nombreux indicateurs, les capacités de l'IA à usage général progressent rapidement. Les chercheurs ne s'accordent pas sur la question de savoir si des progrès significatifs ont été réalisés sur des défis fondamentaux tels que le raisonnement causal.

- Les experts ne s'accordent pas sur le rythme attendu des progrès futurs des capacités de l'IA à usage général, soutenant diversement la possibilité de progrès lents,

rapides ou extrêmement rapides.- La compréhension des capacités et du fonctionnement interne des systèmes d'IA à usage général est limitée. L'amélioration de notre compréhension devrait être une priorité.

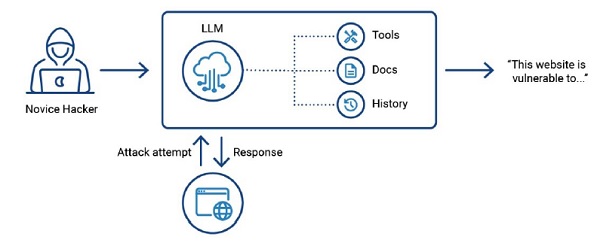

- Comme toutes les technologies puissantes, l'IA à usage général actuelle et future peut être utilisée pour causer des dommages. Par exemple, des acteurs malveillants peuvent utiliser l'IA pour mener des opérations de désinformation et d'influence à grande échelle, des fraudes et des escroqueries.

- Les dysfonctionnements de l'IA à usage général peuvent également causer des dommages, par exemple en prenant des décisions biaisées par rapport à des caractéristiques protégées telles que la race, le sexe, la culture, l'âge et le handicap.

- Les progrès futurs de l'IA à usage général pourraient poser des risques systémiques, notamment la perturbation du marché du travail et les inégalités de pouvoir économique. Les experts ont des avis divergents sur le risque que l'humanité perde le contrôle de l'IA d'une manière qui pourrait avoir des conséquences catastrophiques.

- Plusieurs méthodes techniques (notamment l'étalonnage des performances, le red-teaming et l'audit des données de formation) peuvent contribuer à atténuer les risques, bien que toutes les méthodes actuelles aient des limites et que des améliorations soient nécessaires.

L'avenir de l'IA est incertain, avec un large éventail de scénarios possibles. Les décisions des sociétés et des gouvernements auront un impact significatif sur son avenir.

Le rapport souligne la nécessité de poursuivre les efforts de collaboration internationale en matière de recherche et de partage des connaissances sur ces technologies en évolution rapide. L'approche adoptée a été délibérément inclusive des différents points de vue et perspectives, et les zones d'incertitude, de consensus ou de désaccord sont mises en évidence, ce qui favorise la transparence.

État de la sécurité de l'intelligence artificielle avancée

Ce rapport scientifique international provisoire sur la sécurité de l'IA avancée constate que la trajectoire future de l'IA à usage général est remarquablement incertaine.

Un large éventail de résultats possibles semble envisageable, même dans un avenir proche, y compris des résultats très positifs et très négatifs, ainsi que tout ce qui se situe entre les deux.

Parmi les perspectives les plus prometteuses de l'IA à usage général, on peut citer son potentiel pour l'éducation, les applications médicales, les progrès de la recherche dans un large éventail de domaines, et l'augmentation de la productivité conduisant à une plus grande prospérité. S'ils sont gérés correctement, les systèmes d'IA à usage général pourraient améliorer considérablement la vie des gens dans le monde entier.

Mais pour récolter les fruits de cette technologie transformatrice en toute sécurité, les chercheurs et les décideurs politiques doivent identifier les risques qui l'accompagnent et prendre des mesures en connaissance de cause pour les atténuer. L'utilisation malveillante de l'IA à usage général ainsi que les dysfonctionnements de l'IA à usage général causent déjà des dommages aujourd'hui, par exemple par le biais de deepfakes, d'escroqueries et de résultats biaisés.

En fonction du rythme de progression des futures capacités de l'IA à usage général, des méthodes techniques employées par les développeurs et les régulateurs pour atténuer les risques, des décisions des gouvernements et des sociétés concernant l'IA à usage général, et du degré de réussite de la coordination mondiale, il est également possible que d'autres risques apparaissent. Dans le pire des cas, on pourrait assister à l'émergence de risques tels que le chômage à grande échelle, le terrorisme généralisé par l'IA ou même la perte de contrôle de l'humanité sur les systèmes d'IA à usage général. Les experts ne s'accordent pas sur la probabilité de ces risques ni sur le moment où ils pourraient se produire.

Le présent rapport examine également les facteurs qui rendent difficile la prise en compte de ces risques. Malgré les progrès rapides des capacités, les chercheurs ne peuvent actuellement pas produire des comptes rendus compréhensibles par l'homme sur la manière dont les modèles et les systèmes d'IA à usage général parviennent à des résultats et à des décisions. Il est donc difficile d'évaluer ou de prédire ce dont ils sont capables, leur degré de fiabilité et d'obtenir des garanties sur les risques qu'ils pourraient poser.

Il existe des approches techniques pour traiter les risques liés à l'IA à usage général : des méthodes pour réduire les biais des modèles, améliorer notre compréhension du fonctionnement interne des modèles d'IA à usage général, évaluer leurs capacités et les risques potentiels, et les rendre moins susceptibles de répondre à des demandes d'utilisateurs qui pourraient causer des dommages. Il existe également des techniques complémentaires pour surveiller et atténuer les actions nuisibles des systèmes d'IA à usage général. Toutefois, aucune technique existante ne fournit actuellement de garanties quantitatives quant à la sécurité des modèles ou systèmes avancés d'IA à usage général.

L'avenir de l'IA n'est pas inéluctable. La manière dont l'IA à usage général est développée et par qui, les problèmes qu'elle est censée résoudre, la question de savoir si on sera en mesure de tirer pleinement parti du potentiel économique de l'IA à usage général, qui en bénéficie et les types de risques auxquels on est exposé - ces questions et bien d'autres encore dépendent des choix que les sociétés et les gouvernements font aujourd'hui et à l'avenir pour façonner le développement de l'IA à usage général.

Étant donné que l'impact de l'IA à usage général sur de nombreux aspects de notre vie sera probablement profond et que les progrès pourraient continuer à être rapides, le principe de précaution implique un besoin urgent de parvenir à un consensus et de consacrer des ressources à la compréhension et à la prise en compte de ces risques. Un débat scientifique et public constructif sera essentiel pour que les sociétés et les décideurs politiques puissent faire les bons choix.

Le rapport provisoire conclue :

Informations généralesPour la première fois dans l'histoire, ce rapport provisoire a réuni des représentants d'experts nommés par 30 pays, l'UE et les Nations unies, ainsi que plusieurs autres experts de renommée mondiale, afin de fournir une base scientifique commune, fondée sur des preuves, pour ces discussions vitales. Nous restons en désaccord sur plusieurs questions, mineures et majeures, concernant les capacités, les risques et les mesures d'atténuation des risques de l'IA à usage général. Mais nous considérons que ce projet est essentiel pour améliorer notre compréhension collective de l'IA à usage général et de ses risques potentiels, et pour nous rapprocher d'un consensus et d'une atténuation efficace des risques afin de garantir que les gens puissent profiter des avantages de l'IA à usage général en toute sécurité. Les enjeux sont importants. Nous nous réjouissons de poursuivre cet effort.

Le rapport a été commandé par le gouvernement britannique et présidé par Yoshua Bengio, universitaire spécialiste de l'IA lauréat du prix Turing et membre du conseil consultatif scientifique des Nations unies. Les travaux ont été supervisés par un groupe consultatif international d'experts composé de 30 pays, dont le Royaume-Uni et des représentants des nations invitées au sommet sur la sécurité de l'IA à Bletchley Park en 2023, ainsi que des représentants de l'Union européenne et des Nations unies.

L'objectif du rapport est de favoriser une compréhension commune, scientifique et actualisée de la sécurité des systèmes d'IA avancés, et de développer cette compréhension au fil du temps. Pour ce faire, le rapport rassemble les pays leaders mondiaux en matière d'IA et la meilleure expertise mondiale en matière d'IA afin d'analyser les meilleures recherches scientifiques existantes sur les capacités et les risques de l'IA. Cette publication alimentera les discussions qui auront lieu lors du sommet de Séoul sur l'IA en mai 2024.

Source : International Scientific Report on the Safety of Advanced AI : INTERIM REPORT

Et vous ?

Pensez-vous que ce rapport est crédible ou pertinent ?

Quel est votre avis sur le sujet ?

Voir aussi :

L'équilibre délicat entre sécurité et innovation dans l'IA : « bannir les modèles "open weights" serait un désastre » selon un chercheur. L'administration Biden envisage de bloquer l'accès à ces modèles afin d'éviter les abus

L'IA va accroître le nombre et l'impact des cyberattaques : les ransomwares étant susceptibles d'en être les plus grands bénéficiaires au cours des deux prochaines années

2023, l'année de l'IA ? L'année a été marquée par l'émergence de l'IA générative, une explosion des investissements dans le domaine et l'accélération dans les législations

Répondre avec citation

Répondre avec citation

Partager