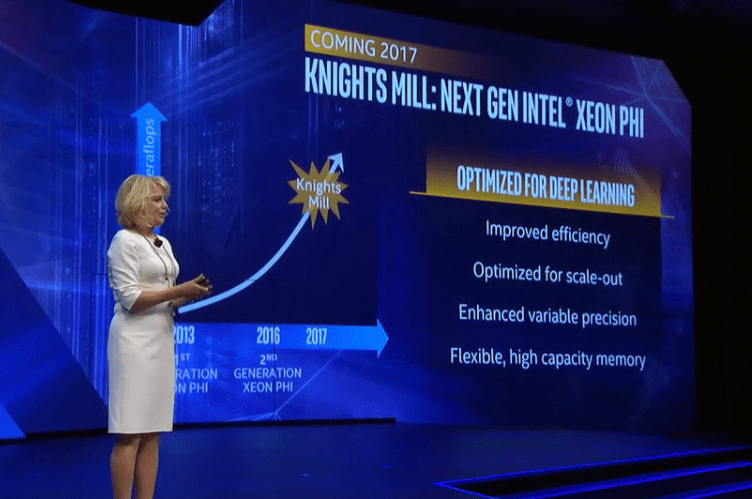

Les Xeon Phi de deuxième génération, nom de code Knights Landing, sont à peine arrivés qu’Intel dévoile ses plans pour la troisième génération. Le mot d’ordre est l’apprentissage profond, cheval de course actuel au niveau du matériel informatique destiné au calcul — sur fond de marketing déloyal avec NVIDIA. La sortie est prévue en 2017 et devrait améliorer l’efficacité énergétique et flexibiliser la mémoire (actuellement, sur les accélérateurs Xeon Phi, la mémoire ne peut pas évoluer et est limitée à seize gigaoctets).

Les détails ne sont pas encore très nombreux. Cette génération ne devrait pas phagocyter l’actuelle ni la suivante (qui devrait s’appeler Knights Hill et utiliser un processus de gravure à 10 nm), puisqu’elle sera centrée sur l’apprentissage profond, pas les applications plus générales de calcul scientifique (qui nécessitent une précision de calcul bien plus fine).

Ce produit s’inscrit donc dans la stratégie d’Intel dans ce domaine : arrivé tard, il lui faut remonter la pente rapidement pour se faire un nom. Actuellement, les processeurs Intel sont très utilisés pour l’apprentissage profond — mais pas pour les calculs les plus intensifs, ceux-ci étant effectués par des GPU NVIDIA, y compris sur des plateformes d’informatique dans le nuage.

L’une des caractéristiques de cette génération Knights Mill est la présence d’opérations en “précision variable”. Cela signifie probablement que les calculs en virgule flottante pourront s’effectuer sur trente-deux à soixante-quatre bits avec une bonne précision (comme actuellement) ou bien sur seulement seize bits (pour une meilleure rapidité). Un autre avantage est que les opérations SIMD (c’est-à-dire une instruction effectuée sur beaucoup de données à la fois), très utiles pour l’apprentissage profond, pourraient être bien plus compactes : AVX-512 travaille sur cinq cent douze bits d’un coup, c’est-à-dire huit nombres en haute précision… mais trente-deux avec une précision fortement amoindrie ! Ainsi, au niveau technique, les solutions qu’Intel pourraient proposer sont identiques à celles de NVIDIA les calculs FP16 étant un des points forts de la dernière génération de GPU, nommée Pascal, même si les optimisations au niveau SIMD n’ont pas de sens sur un GPU (de par les différences d’architecture).

Knights Mill devrait s’inspirer, mais probablement pas reprendre la technologie de Nervana : ils envisageaient de vendre, à l’horizon 2017, un mélange matériel-logiciel spécifiquement prévu pour l’apprentissage profond, jusqu’à dix fois plus rapide que les GPU actuels en démocratisant la voie que Google a choisie : des processeurs spécifiquement prévus pour ces tâches. Cependant, ces optimisations ne peuvent s’effectuer qu’au détriment d’autres fonctionnalités (éliminer les circuits pour des opérations sur des nombres à virgule flottante de trop haute précision, par exemple) — peut-être seront-elles intégrées sur une gamme spécifique d’Intel, mais c’est peu probable, les différences par rapport aux autres produits serait trop grande et obligerait à effectuer en double certains développements.

Sources et images : Intel Unveils Plans for Knights Mill, a Xeon Phi for Deep Learning, Intel Buys Deep Learning Specialist Nervana to Boost AI Portfolio, Intel Announces Knights Mill: A Xeon Phi For Deep Learning.

Répondre avec citation

Répondre avec citation

Partager