Microsoft et Nvidia collaborent pour faciliter l'exécution de modèles d'IA sous Windows aux développeurs

avec des outils permettant de travailler localement avec des modèles d'IA volumineux

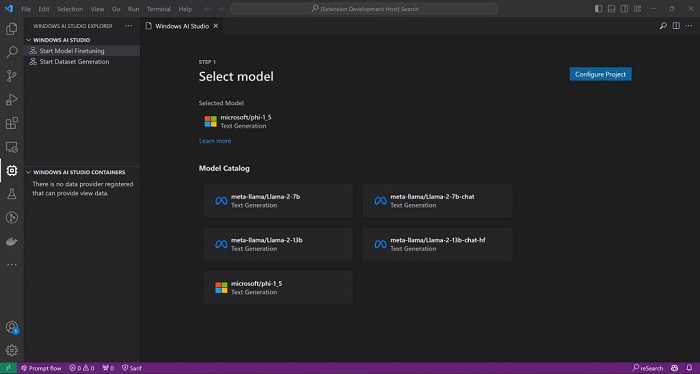

Microsoft et Nvidia ont uni leurs forces pour fournir aux développeurs des outils améliorés pour exécuter et configurer des modèles d'IA sur leurs PC Windows. Lors de l'événement Microsoft Ignite de mercredi, Microsoft a présenté Windows AI Studio : un hub central qui permet aux développeurs d'accéder à une large gamme de modèles d'IA (Mistral, Llama 2, etc.) et de les personnaliser en fonction de leurs besoins spécifiques. Outre la personnalisation des modèles, Windows AI Studio intègre les modèles Prompt Flow et Gradio pour faciliter les tests de performance. De son côté, Nvidia a annoncé des mises à jour pour son outil de développement de l'IA TensorRT-LLM.

« En raison des nombreux outils, frameworks et modèles open source disponibles, il est difficile de choisir le bon ensemble d'outils pour tester, affiner et optimiser les modèles ou sélectionner les modèles les plus fiables qui répondent le mieux aux divers besoins de l'entreprise. C'est pourquoi nous sommes ravis d'annoncer Windows AI Studio, une nouvelle expérience pour les développeurs, qui étend l'outillage d'Azure AI Studio pour lancer le développement de l'IA sur Windows », a écrit Microsoft dans un billet de blogue publié mercredi. Selon l'entreprise, Windows AI Studio s'appuie sur des plateformes existantes comme Azure AI Studio et Hugging Face.

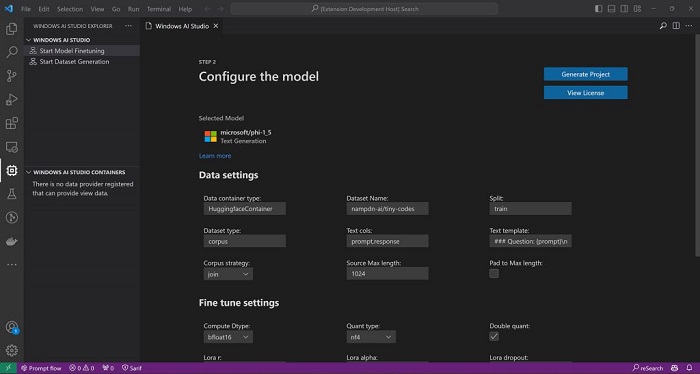

Windows AI Studio offre aux développeurs un espace de travail complet avec une interface utilisateur conviviale pour la configuration des modèles d'IA et des tutoriels étape par étape. Il permet d'affiner les petits modèles de langage (small language models - SLM), notamment Phi de Microsoft, Llama 2 de Meta et Mistral. En outre, il permet aux développeurs de tester les performances de leurs modèles à l'aide des modèles Prompt Flow et Gradio. Microsoft envisage de publier Windows AI Studio en tant qu'extension de Visual Studio Code dans les semaines à venir, afin d'assurer une intégration transparente avec les flux de travail existants des développeurs.

« Windows AI Studio nous rapproche de la prise en charge des modèles de développement Hybrid Loop et de la mise en œuvre de scénarios d'IA hybrides sur Azure et les appareils clients. Les développeurs peuvent ainsi choisir d'exécuter leurs modèles dans le cloud sur Azure ou en périphérie localement sur Windows (ou entre les deux) en fonction de leurs besoins. Prompt Flow facilite plus que jamais la mise en œuvre de ce modèle hybride en basculant entre les SLM locaux et les grands modèles de langage (LLM) dans le cloud. Dans les semaines à venir, les développeurs pourront accéder à Windows AI Studio sous la forme d'une extension VS Code ».

Nvidia n'est pas en reste avec des mises à jour significatives de son logiciel TensorRT-LLM. Nvidia l'a initialement introduit pour Windows comme un moyen d'améliorer l'efficacité de l'exécution de grands modèles de langage sur les GPU H100. TensorRT-LLM étend désormais son support aux GPU GeForce RTX 30 et 40 Series avec 8 Go de RAM ou plus. Nvidia a aussi l'intention de rendre TensorRT-LLM compatible avec l'API Chat d'OpenAI par le biais d'un wrapper nouvellement développé, permettant aux développeurs de traiter les grands modèles de langage localement sur leurs PC, répondant ainsi aux inquiétudes concernant la confidentialité des données.

En fait, les développeurs et les passionnés du monde entier utilisent l'API Chat d'OpenAI pour une large gamme d'applications, allant du résumé de contenu Web et de la rédaction de documents et de courriels à l'analyse et à la visualisation de données et à la création de présentations. L'un des problèmes posés par ces IA basées sur le cloud est qu'elles exigent que les utilisateurs téléchargent leurs données d'entrée, ce qui les rend peu pratiques pour les données privées ou propriétaires ou pour travailler avec de grands ensembles de données. Les modèles d'IA peuvent mémoriser ces données et les divulguer s'ils sont interrogés de manière spécifique.

Ainsi, pour résoudre ce problème, Nvidia va bientôt permettre à TensorRT-LLM pour Windows d'offrir une interface API similaire à l'API Chat d'OpenAI, par le biais d'un nouveau wrapper, offrant un flux de travail similaire aux développeurs, qu'ils conçoivent des modèles et des applications à exécuter localement sur un PC avec RTX ou dans le cloud. Nvidia note : « en changeant une ou deux lignes de code, des centaines de projets et d'applications pilotés par l'IA peuvent désormais bénéficier d'une IA locale et rapide. Les utilisateurs peuvent conserver leurs données sur leur PC et ne pas se soucier de télécharger des ensembles de données dans le cloud ».

Nvidia indique que la prochaine version de TensorRT-LLM ajoutera une inférence jusqu'à cinq fois plus rapide, ainsi que la prise en charge des nouveaux modèles Mistral 7B et Nemotron-3 8B. Le fabricant américain de puces a également présenté AI Workbench, une boîte à outils unifiée et facile à utiliser qui permet aux développeurs de créer, tester et personnaliser rapidement des modèles d'IA générative préentraînés et des LLM sur un PC ou une station de travail. Selon la société, AI Workbench offre aux développeurs une plateforme unique pour organiser leurs projets d'IA et adapter les modèles à des cas d'utilisation spécifiques.

Tout cela illustre l'objectif de Microsoft et Nvidia visant à créer un modèle de développement en "boucle hybride". Cette approche favorise le développement de l'IA à la fois dans le cloud et localement sur les appareils. Ainsi, les développeurs n'ont pas besoin de s'appuyer uniquement sur leurs propres systèmes pour développer l'IA, car ils peuvent accéder aux serveurs cloud de Microsoft pour décharger leurs appareils de la plus grande partie de la charge. Enfin, pour aider les développeurs d'IA, Nvidia et Microsoft publieront des améliorations DirectML pour accélérer l'un des modèles d'IA fondamentaux les plus populaires, Llama 2 de Meta.

Sources : Microsoft, Nvidia

Et vous ?

Quel est votre avis sur le sujet ?

Que pensez-vous de Windows AI Studio et de Nvidia TensorRT-LLM ?

En quoi ces environnements favorisent-ils la démocratisation de l'IA ?

Voir aussi

La startup française Mistral AI publie un modèle d'IA open source de 7,3 milliards de paramètres appelé "Mistral 7B", qui serait plus performant que le modèle d'IA Llama 2 13B de Meta

Bing Chat s'appelle désormais « Microsoft Copilot », un changement de marque qui pourrait prêter à confusion, bien que l'intérêt de Microsoft soit d'unifier

Microsoft prévoit de proposer son Copilot IA à 1 milliard d'utilisateurs de Windows 10, car Windows 10 demeure la version la plus populaire du système d'exploitation, avec 69 % des parts de marché

Répondre avec citation

Répondre avec citation

Partager