OpenAI lance un nouveau modèle de langage appelé GPT-4 Turbo qui serait plus puissant et moins cher que GPT-4

avec une fenêtre contextuelle plus grande que celle du modèle d'IA Claude 2 d'Anthropic

OpenAI vient d'annoncer un nouveau grand modèle de langage (LLM) appelé GPT-4 Turbo. Il s'agit d'une version améliorée de GPT-4 qui, selon l'entreprise, est à la fois plus puissante et moins coûteuse. Actuellement en avant-première, GPT-4 Turbo pourrait être jusqu'à trois fois moins cher pour les développeurs. OpenAI a annoncé que GPT-4 Turbo se décline en deux versions : une version qui analyse strictement le texte et une seconde qui comprend le contexte du texte et des images. Enfin, OpenAI s'engagé à protéger ses clients contre les poursuites en matière de droits d'auteur, les plaintes pour violation du droit d'auteur s'étant multipliées au cours des derniers mois.

OpenAI a organisé lundi son premier événement pour les développeurs. Lors de cet événement, le PDG Sam Atman a présenté les nouvelles offres de l'entreprise et a annoncé que ChatGPT compte aujourd'hui environ 100 millions d'utilisateurs actifs hebdomadaires. Et Mira Murati, directrice technique d'OpenAI, a déclaré à la presse lundi que plus de 92 % des entreprises du classement Fortune 500 utilisent désormais les produits d'OpenAI, contre 80 % en août. Ces sociétés couvrent des secteurs tels que les services financiers, les applications juridiques et l'éducation. L'événement a été marqué par l'apparition surprise du PDG de Microsoft, Satya Nadella.

Altman a introduit lundi un nouveau modèle d'IA appelé GPT-4 Turbo. Il s'agit du successeur de GPT-4 qui a été présenté en mars et a été rendu public en juillet. GPT-4 Turbo ajoute de nouvelles fonctionnalités, propose des prix réduits et bien d'autres choses encore. GPT-4 Turbo se décline en deux versions : une version qui analyse strictement le texte et une seconde qui comprend le contexte du texte et des images. La première version sera disponible en avant-première via une API à partir de cette semaine, et Altman a annoncé lors de l'événement qu'OpenAI prévoit de rendre les deux versions généralement disponibles dans les semaines à venir.

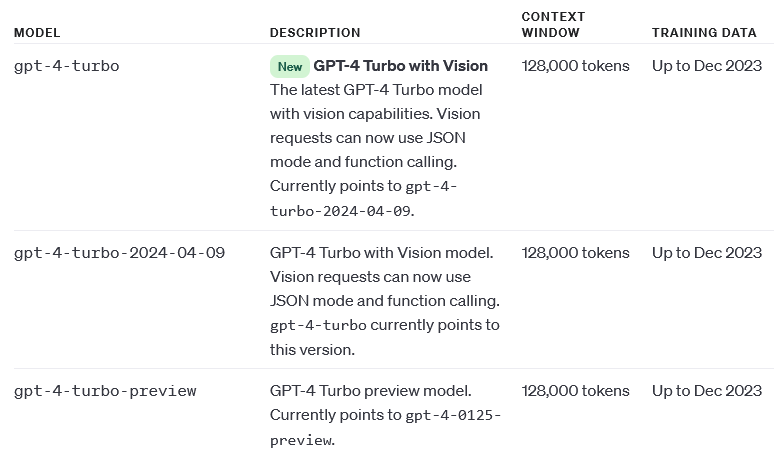

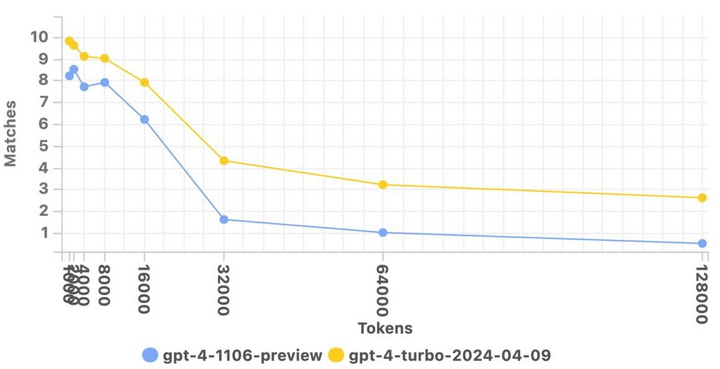

GPT-4 Turbo dispose également d'une fenêtre contextuelle élargie. La fenêtre contextuelle, mesurée en jetons, fait référence au texte que le modèle prend en compte avant de générer tout texte supplémentaire. Les modèles dotés d'une petite fenêtre contextuelle ont tendance à "oublier" le contenu des conversations, même les plus récentes, ce qui les amène à s'écarter du sujet, souvent de manière problématique. GPT-4 Turbo offre une fenêtre contextuelle de 128 000 jetons - quatre fois la taille de GPT-4 et la plus grande fenêtre contextuelle de tous les modèles d'IA disponibles sur le marché, dépassant même le modèle d'IA Claude 2 d'Anthropic.

Claude 2 supporte jusqu'à 100 000 jetons. Anthropic a annoncé qu'il se préparait à expérimenter une fenêtre contextuelle de 200 000 jetons, mais ne l'a pas encore rendue publique. En effet, 128 000 jetons correspondent à environ 100 000 mots ou 300 pages, ce qui correspond à peu près à la longueur des "Hauts de Hurlevent", des "Voyages de Gulliver" et de "Harry Potter et le prisonnier d'Azkaban". Altman a annoncé que cette nouvelle version de GPT-4 continuera d'accepter les messages-guides sous forme d'images, les demandes de synthèse vocale et intégrera aussi DALL-E 3, une fonctionnalité annoncée pour la première fois le mois dernier.

En outre, GPT-4 accepte des budgets plus modestes. Il est trois fois moins cher pour les jetons d'entrée et deux fois moins cher pour les jetons de sortie. Les prix sont de 0,01 $ pour 1 000 jetons d'entrée (~750 mots), où les jetons représentent des morceaux de texte brut (par exemple, le mot "fantastique" divisé en "fan", "tas" et "tic") et de 0,03 $ pour 1 000 jetons de sortie (les jetons d'entrée sont des jetons introduits dans le modèle d'IA, tandis que les jetons de sortie sont des jetons que le modèle génère sur la base des jetons d'entrée). L'entreprise promet de continuer à optimiser ses prix afin de rendre ses plateformes accessibles à plus de monde.

« Nous avons optimisé les performances afin de pouvoir offrir GPT-4 Turbo à un prix trois fois moins cher pour les jetons d'entrée et un prix deux fois moins cher pour les jetons de sortie par rapport à GPT-4 », écrit OpenAI dans un billet de blogue publié lundi. GPT-4 Turbo présente plusieurs autres améliorations par rapport à GPT-4, notamment une base de connaissances plus récente sur laquelle s'appuyer pour répondre aux requêtes. La base de connaissances de GPT-4 est limitée à septembre 2021 (tout comme son prédécesseur GPT-3.5), tandis que le seuil de connaissance du GPT-4 Turbo a été étendu et couvre toutes les connaissances jusqu'en avril 2023.

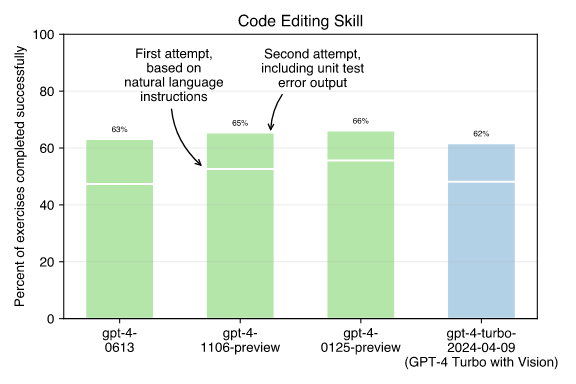

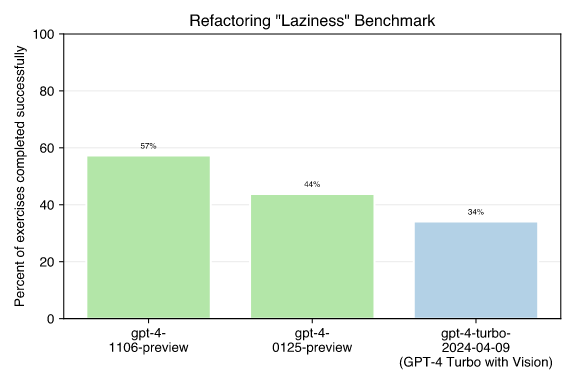

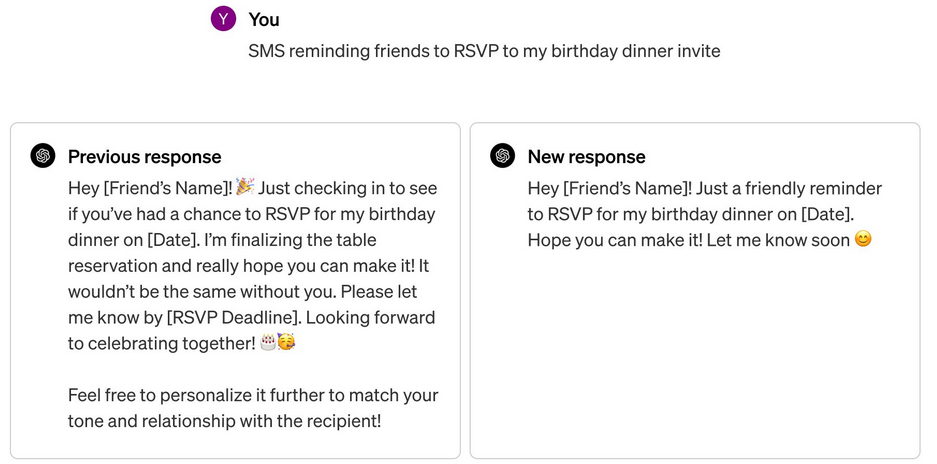

Cela signifie que les questions portant sur des faits récents - du moins ceux qui se sont produits avant la nouvelle date limite d'avril 2023 - devraient donner lieu à des réponses plus précises. Altman a promis que plus d'efforts seront faits pour garder GPT-4 Turbo à jour : « nous essaierons de faire en sorte que le modèle ne soit plus jamais obsolète ». Selon lui, les améliorations apportées à GPT-4 Turbo permettent aux utilisateurs de demander au modèle d'effectuer des tâches plus complexes en une seule fois. Ils peuvent demander à GPT-4 Turbo d'utiliser spécifiquement le langage de codage de leur choix pour les résultats, comme le code XML ou JSON.

« Ce mode est utile pour les applications Web qui transmettent des données, comme celles qui envoient des données d'un serveur à un client afin qu'elles puissent être affichées sur une page Web », explique l'OpenAI. D'autres nouveaux paramètres connexes permettront aux développeurs de faire en sorte que le modèle renvoie plus souvent des complétions "cohérentes" et, pour des applications plus spécialisées, de consigner les probabilités pour les jetons de sortie les plus probables générés par GPT-4 Turbo. Selon le billet de blogue d'OpenAI, le nouveau modèle de langage de l'entreprise est également plus performant en matière d'appel de fonction.

OpenAI a introduit son API dès 2020 et affirme aujourd'hui que plus de deux millions de développeurs utilisent la spécification pour intégrer des modèles tels que GPT-4, GPT-3.5, DALL-E et Whisper dans leurs propres applications. Lors de l'événement, le PDG de Microsoft, Satya Nadella, est monté sur la scène, discutant avec Altman de l'approfondissement du partenariat entre Microsoft et OpenAI et partageant quelques idées générales sur l'avenir de l'IA, qui, selon lui, donnera plus de pouvoir aux gens. L'accord entre Microsoft et OpenAI est vivement critiqué, Elon Musk, cofondateur d'OpenAI, affirmant que cela rompt avec les valeurs initiales d'OpenAI.

Interrogé sur la manière dont Microsoft perçoit son partenariat avec OpenAI, Nadella s'est montré enthousiaste : « nous vous aimons beaucoup. Cela a été fantastique pour nous ». Il a ensuite expliqué comment Azure, la plateforme cloud de Microsoft, a évolué à la lumière des modèles construits par OpenAI. « L'objectif de Microsoft, c'est d'être en mesure de diffuser largement les avantages de l'IA à tout le monde », ajoutant que la sécurité est également une préoccupation majeure. Mais Nadella est critiqué et les détracteurs d'OpenAI affirment que l'entreprise est plus fermée que jamais et répond exclusivement à l'agenda de Microsoft en matière d'IA.

Outre les améliorations apportées au modèle phare, OpenAI a également annoncé qu'elle suivrait les traces de Microsoft et de Google et qu'en cas de poursuite, il offrirait une indemnité aux utilisateurs professionnels dans le cadre d'un programme appelé "Copyright Shield". « Nous interviendrons désormais pour défendre nos clients et payer les frais encourus si vous faites l'objet de poursuites judiciaires pour violation de droits d'auteur », a déclaré l'entreprise dans un communiqué. Selon OpenAI, la mesure Copyright Shield couvrira les fonctionnalités généralement disponibles de ChatGPT Enterprise et de la plateforme de développement d'OpenAI.

Google a déclaré qu'il assumerait la responsabilité juridique si les clients utilisant ses fonctions d'IA générative étaient poursuivis pour violation du droit d'auteur. Microsoft a également étendu les mêmes protections aux utilisateurs professionnels de ses produits Copilot AI. Getty Images, Shutterstock et Adobe ont étendu la protection de leur responsabilité financière à leurs logiciels de création d'images. L'initiative d'OpenAI intervient après que des auteurs connus ont déposé au moins trois plaintes contre OpenAI pour l'utilisation présumée de leurs œuvres protégées par le droit d'auteur dans le cadre de la formation du chatbot ChatGPT.

Parmi les plaignants figurent Jonathan Franzen, John Grisham, Michael Chabon, George RR Martin, Jodi Picoult et Authors Guild, une association professionnelle. Pour créer leurs modèles de langage, les entreprises utilisent des milliards de lignes de texte provenant du Web, y compris des bases de données comprenant des dizaines de milliers de livres protégés par des droits d'auteur. À ce propos, OpenAI a précédemment déclaré : « nous sommes convaincus que nous continuerons à trouver des moyens mutuellement bénéfiques de travailler ensemble pour aider les gens à utiliser les nouvelles technologies dans un écosystème de contenu riche ».

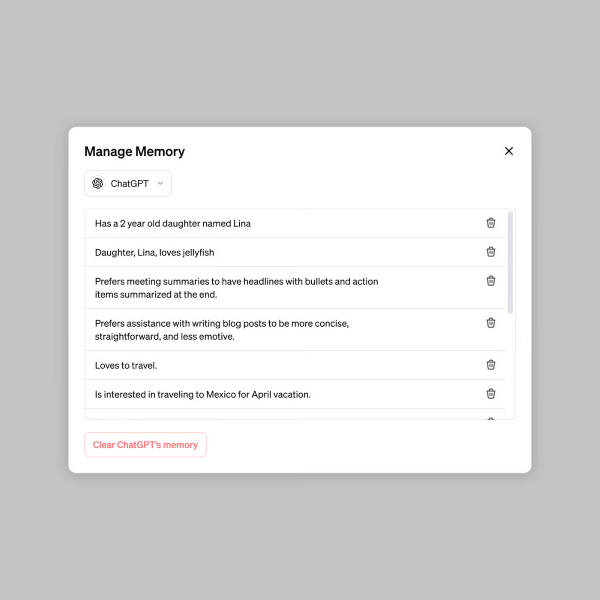

Lundi, OpenAI a également présenté une nouvelle API appelée Assistants API, qui vise à faciliter la création d'assistants d'IA personnalisables. « Assistants API comprend des threads persistants, de sorte qu'ils n'ont pas à se demander comment gérer un long arbre de conversation, une récupération intégrée, un interpréteur de code, un interpréteur Python fonctionnel et un environnement sandbox, [et un appel de fonction amélioré] », a expliqué Altman. Enfin, OpenAI introduit un nouveau moteur de revenus pour l'entreprise : une boutique d'applications. Altman a annoncé lundi l'arrivée imminente d'une boutique d'applications appelée GPT Store.

Le GPT Store devrait permettre aux personnes qui créent leurs propres modèles GPT de les mettre à la disposition du public pour les télécharger. OpenAI a déclaré que dans les mois à venir, les gens pourront gagner de l'argent en fonction du nombre d'utilisations de leur création. « Une fois dans le magasin, les modèles GPT deviennent consultables et peuvent grimper dans les classements. Nous mettrons également en avant les modèles GPT les plus utiles et les plus agréables que nous rencontrerons dans des catégories telles que la productivité, l'éducation et "juste pour le plaisir" », explique OpenAI dans un communiqué.

Source : OpenAI

Et vous ?

Quel est votre avis sur le sujet ?

Que pensez-vous des améliorations apportées par le modèle d'IA GPT-4 Turbo ?

En quoi ces fonctionnalités rendent-elles le modèle de langage d'OpenAI plus attractif ?

Que pensez-vous de l'initiative visant à indemniser les clients en cas de poursuites pour violation du droit d'auteur ?

Est-ce une manière pour OpenAI, Microsoft et Google de snober les discussions sur le droit d'auteur ?

Voir aussi

Le nouveau Microsoft 365 Copilot, alimenté par le GPT-4 d'OpenAI, est disponible pour 30 $ par mois, l'outil sera intégré dans les applications Microsoft 365, y compris Word, Excel et plus encore

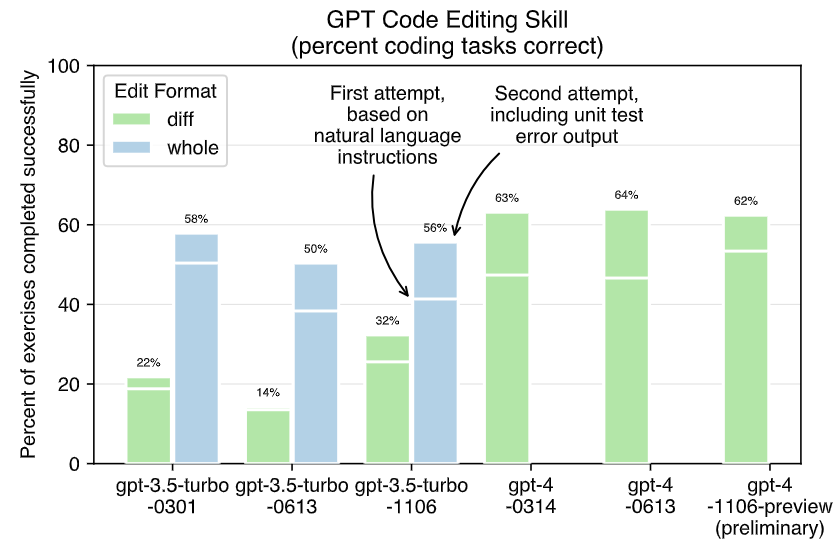

GPT-4 est passé de 98 % à 2 % de réponses exactes à un problème mathématique simple en l'espace de quelques mois, selon une étude qui révèle que les performances de ChatGPT et GPT-4 sont en déclin

Bill Gates ne s'attend pas à ce que GPT-5, la nouvelle version du modèle d'IA générative, soit beaucoup plus performante que GPT-4, il affirme que la technologie GPT a atteint un "plateau"

Répondre avec citation

Répondre avec citation

Partager