Bonjour,

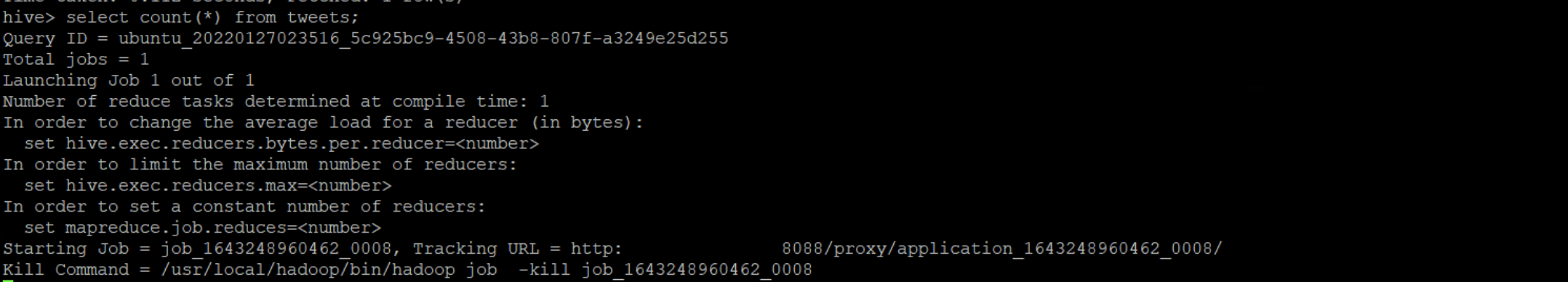

j'aurais besoin d'aide lors que je lance une requête hive> select count(*) from tweet;

j 'ai cette erreur qui est sur la capture. de plus, je suis sur Aws avec des machines EC2 avec un cluster constitué de 1 NameNode et 2 DataNode , je ne comprends pas. Je crois comprendre qu'il s'agit de la mémoire pour les mapreduce mais je comprends pas malgré mes nombreux test.

Cordialement

Merci de votre lecture

Répondre avec citation

Répondre avec citation

Partager