Bonjour,

Je transfert une grande volume de données qui est plus de 200 millions lignes d'enregistrements.

J'extraire les données d'Oracle dans un fichier csv, le charger dans S3 et puis finalement dans AWS Redshift.

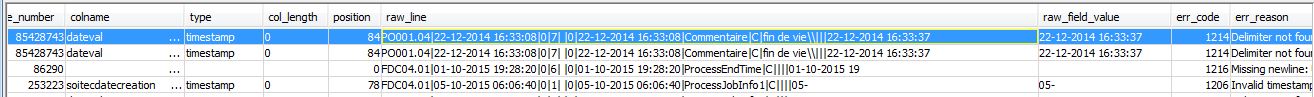

Mais des fois les séparateurs me manquent.

J'ai bien mis "escape" et "delimiter as" dans mon PSQL mais je ne sais pas si ça marche toutes les fois et comment pourrai-je éviter ce problème étant donné la volume est vraiment grosse et ça me gène de le re-tester tout le temps.

Merci par avance pour votre aide.

Cordialement,

Sylvanas

Répondre avec citation

Répondre avec citation

Partager